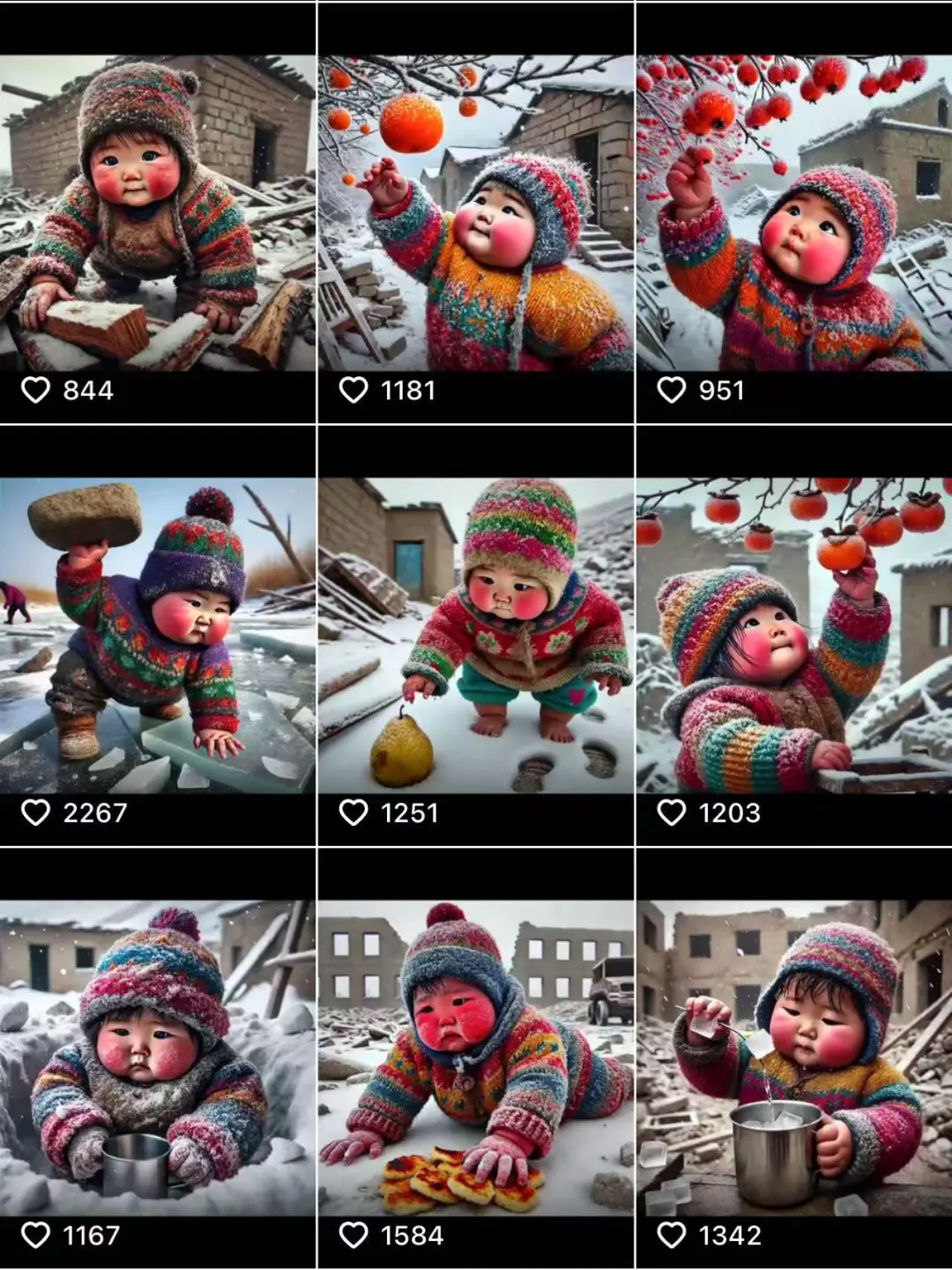

1月7日,西藏定日县发生6.8级地震,很多人关注着救援进展,祈祷灾区平安。同时,在人们的善意和关切中,一张“小男孩被埋废墟下”的图片却迅速在网上走红。

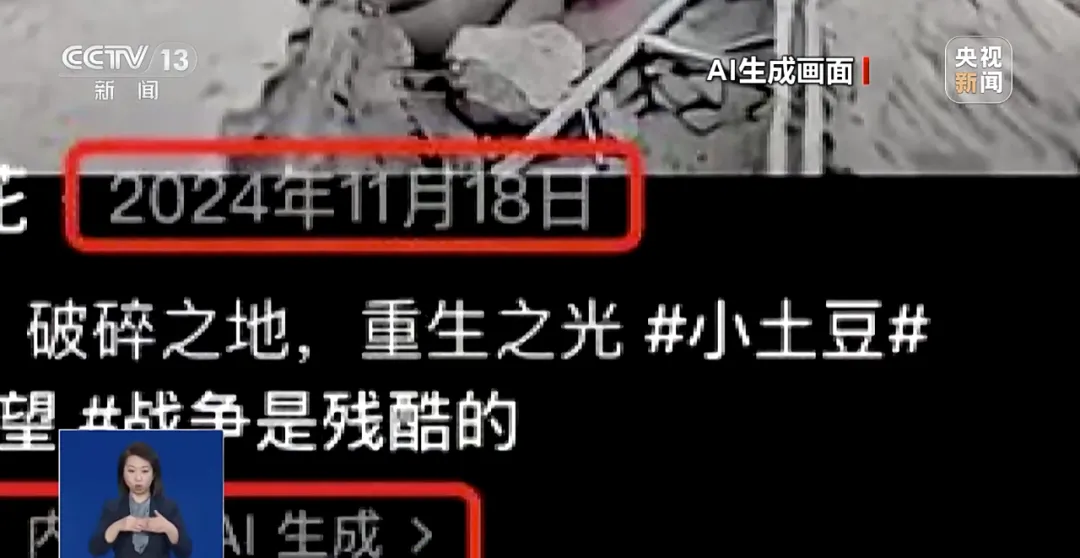

这张图配着“日喀则地震”等字样,戳中了无数人的泪点,还引发了几万次点赞和转发。多数人却没有发现,这只是一张AI生成的虚假图片。

真相浮出水面,AI内容被盗用

仔细看这张图,一个戴着帽子的小男孩被废墟掩埋,似乎情况危急,让人揪心,的确像是一张灾难现场的照片。

然而,细心的网友发现了破绽——图中的男孩竟然多了一根手指。随后警方查明,这张图是AI生成的,与地震毫无关系。

这张图出自一位AI创作者何先生之手,原本是去年11月发布的短视频素材。他的初衷是希望通过AI内容呼吁关注战争中的儿童,没想到素材竟被人恶意盗用,和此次地震硬凑在了一起。

造谣者难逃法律责任

而盗用者则是一位来自青海的网民。为了博取流量,他将这张AI生成的图片和地震灾情结合,甚至标注“日喀则地震”等关键词,试图吸引眼球。

这种行为不仅扰乱了公众视听,还给灾区的真实救援添了不必要的混乱,最终,这名网民被警方依法拘留。

根据《治安管理处罚法》和《刑法》相关条款,散布虚假灾难信息者可能面临拘留甚至更重的刑事处罚。这场谣言闹剧,也再次警示了每一个人:互联网并非法外之地。

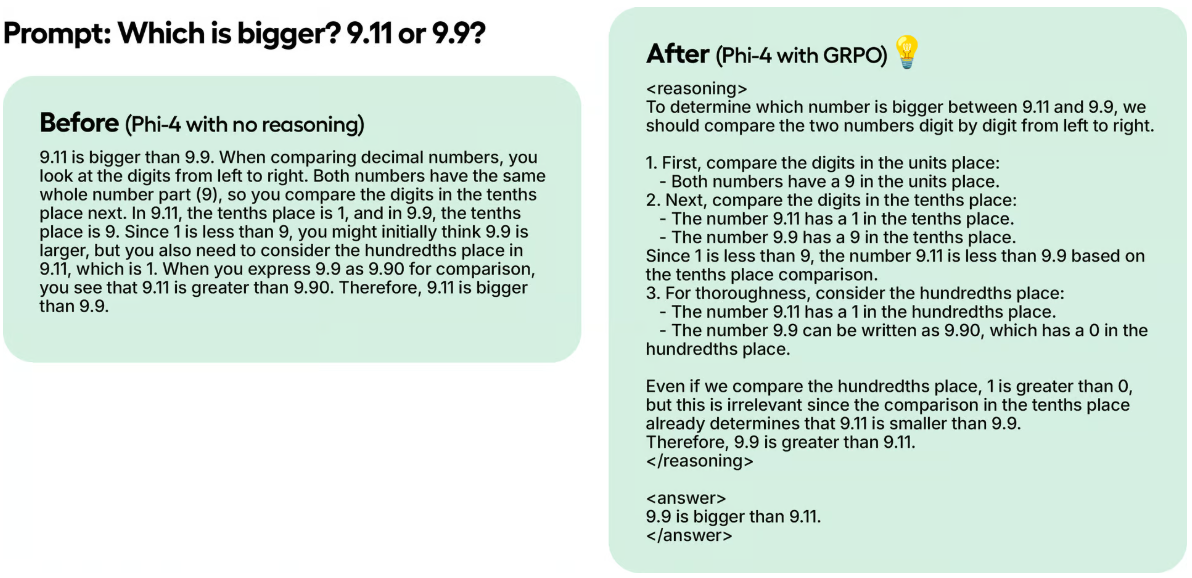

AI技术成为谣言的温床?

很多人想不到的是,制作谣言的成本会有多低。通过一句简单的提示词,不到30秒就能生成一段足以以假乱真的灾难视频,甚至还配有解说。

尽管国家已经出台相关规定,要求AI生成内容需明确标注,但实际落地效果还没有达到预期。这次事件中,图片原本有“AI生成”的水印,但被造谣者轻松去掉了。

普通人如何识别“AI假图”?

在面对AI生成的内容时,我们需要提高警惕。以下几招可以帮助你快速甄别真假:

1. 观察细节

AI生成的图片可能会在一些细节上出现问题,尤其是复杂或不常规的元素:

• 手部或手指:AI生成的手部细节常出现异常,比如多指、缺指、形状扭曲或比例不对。

• 眼睛和面部特征:AI生成的人脸可能会有不对称的眼睛、模糊的边缘或不协调的五官。

• 文字和符号:AI生成的文字往往是乱码、不规则或难以辨认的字符。

• 背景细节:背景可能存在混乱、不连贯的物体,或不符合物理规律的元素(如悬浮的影子)。

2. 检查纹理和逻辑一致性

AI生成的图像有时缺少真实世界中常见的纹理和细节,有时会忽略逻辑规则:

• 过度平滑:过度平滑的皮肤或物体表面。

• 细节重复:例如树叶、砖块等局部区域的相似图案。

• 光线与阴影:光源方向与阴影位置不一致。

• 反射问题:镜子或水中的倒影与真实物体不符。

• 物体比例和布局:常出现奇怪的大小或位置安排,如家具浮空或比例失调。

3. 分析图片的分辨率和质量

• 分辨率不一致:AI生成的图片在某些区域可能显得模糊,而其他区域过于清晰。

• 色彩分布:AI图片色彩可能过于饱和或统一,缺乏真实场景的微妙过渡。

• 像素伪影:AI生成图片可能在放大后出现不规则的像素纹理。

• 边缘处理:物体边缘可能过于锐利或模糊,与背景融合不自然。

4. 关注物理规律和运动细节

如果图片涉及运动或动态元素:

• 模糊效果:AI生成的动态模糊可能不符合实际运动规律。

• 运动轨迹:快速移动的物体可能没有真实的运动轨迹或影像叠加。

• 自然物理规律:真实照片中自然的物理动态(如风吹动树叶)可能难以被AI完美呈现。

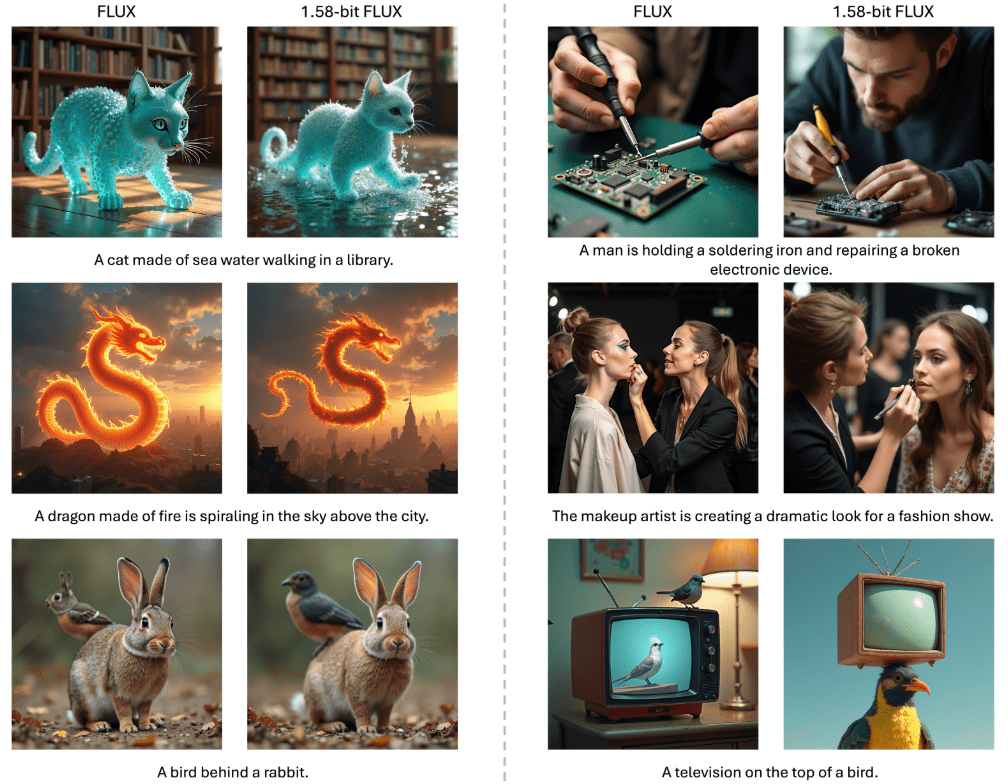

5. 了解AI生图工具的风格特征

不同的AI工具生成的图片风格各有特点:

• MidJourney:图片往往很艺术化,喜欢添加模糊效果或过度锐化。

• Stable Diffusion:有时会在边缘和小物件上出现失真。

• DALL-E:在生成复杂场景时可能会出现逻辑或细节错误。

技术只是工具,善用要靠人心

“小男孩被埋”事件,是一面镜子。它反映出AI技术的两面性——它既可以帮助我们创造新可能,也可能在不当使用下,成为谣言的推手。

但这并不意味着我们应该对AI技术“敬而远之”。相反,我们更需要法律的监管、技术的改进,以及每个人心中的一份责任感。网络时代,真假之间的界限有时很模糊,但你的冷静和理性,能让那些精心编织的谎言失去土壤。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...