有捣鼓过 Dify 的同学应该都知道,虽然 Dify 是一个很棒的 AI 应用,但是它提供的 API 是和 Open AI 不兼容的,这就导致一些应用无法对接到 Dify 上。

有什么办法可以解决呢?

可以利用“中转API”,最出名的应该是 One API:多模型API管理与负载均衡,分发系统 ,它可以聚合不同的 AI 大模型到一起,再统一转为 OpenAI 的 API 派发出去,不过到目前还不支持 Dify 的接入,所以路子虽然有了但是也无法解决上述问题。

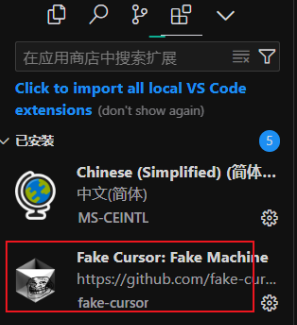

此时有大佬出手,基于 One API 做了二开,项目名称为 New API,这个项目完全支持 Dify,至此我们终于可以玩转 Dify API 了!

部署成功过之后我们通过 IP + 端口的形式进行访问:

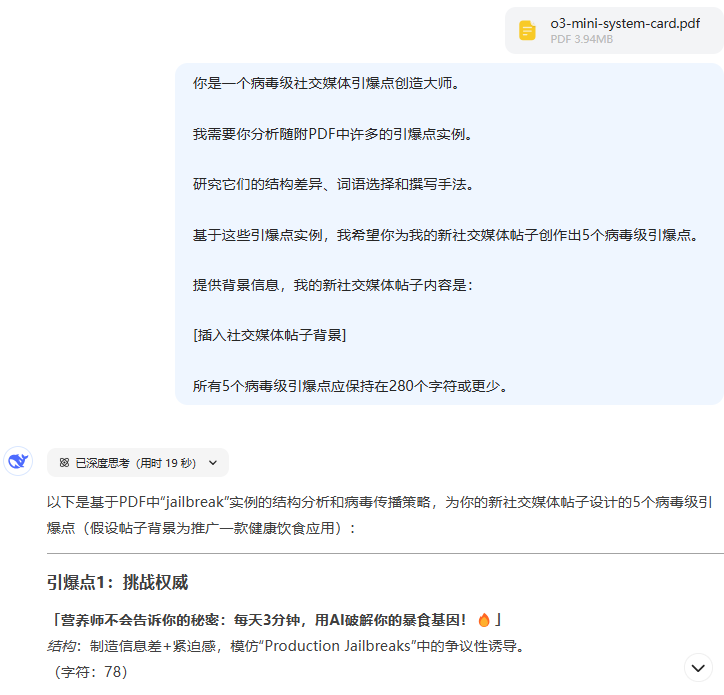

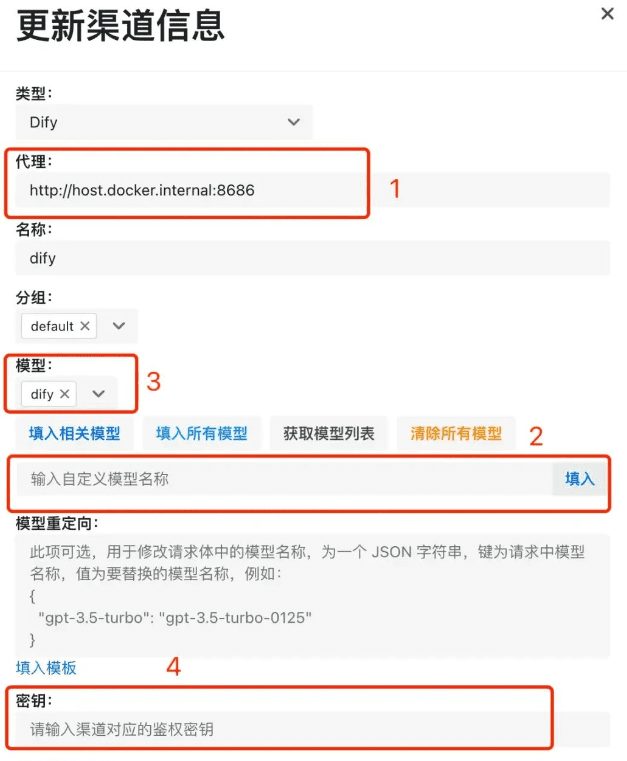

- 我们在选中 Dify 类型之后,要输入 Dify 服务的地址。如果你的 new-api 服务和 dify 都是通过 docker 部署在一个机器上的,那么这里记得输入

http://host.docker.internal:你的端口号,截图是我这边的示例,可不要原模原样照抄哦~。如果不是 docker 部署的方式,这里就输入 dify 服务的http:// ip + 端口号即可; - 因为接入的是 dify,所以在模型选择上我们只需要输入自定义模型名称即可,比如输入 dify,然后一定要点一下后面那个「填入」按钮;

- 不管是自定义模型还是选择的其他模型,一定都会截图中 3 的位置展示出来,没展示说明没有配置上;

- 完成提交,我们就可以在渠道列表中看到一条数据啦~

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...