近日,OpenAI 发布了一项名为 BrowseComp 的新基准测试,旨在评估人工智能代理在互联网浏览方面的能力。这一基准测试由 1,266 个问题组成,涵盖了从科学发现到流行文化等多个领域,要求代理在开放的网络环境中进行持久导航,以寻找那些难以找到且信息交织的答案。

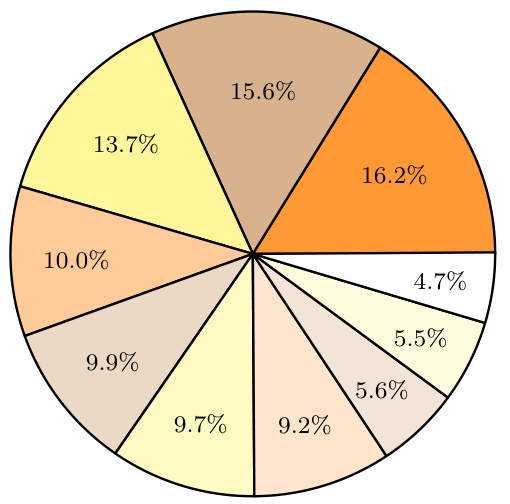

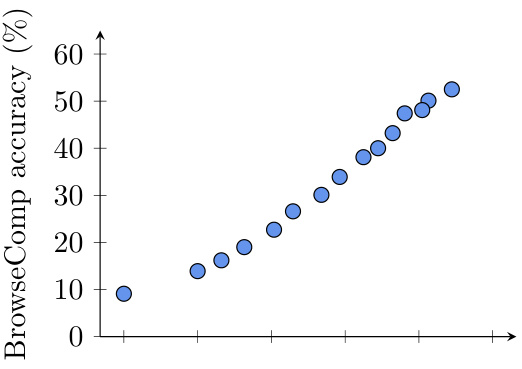

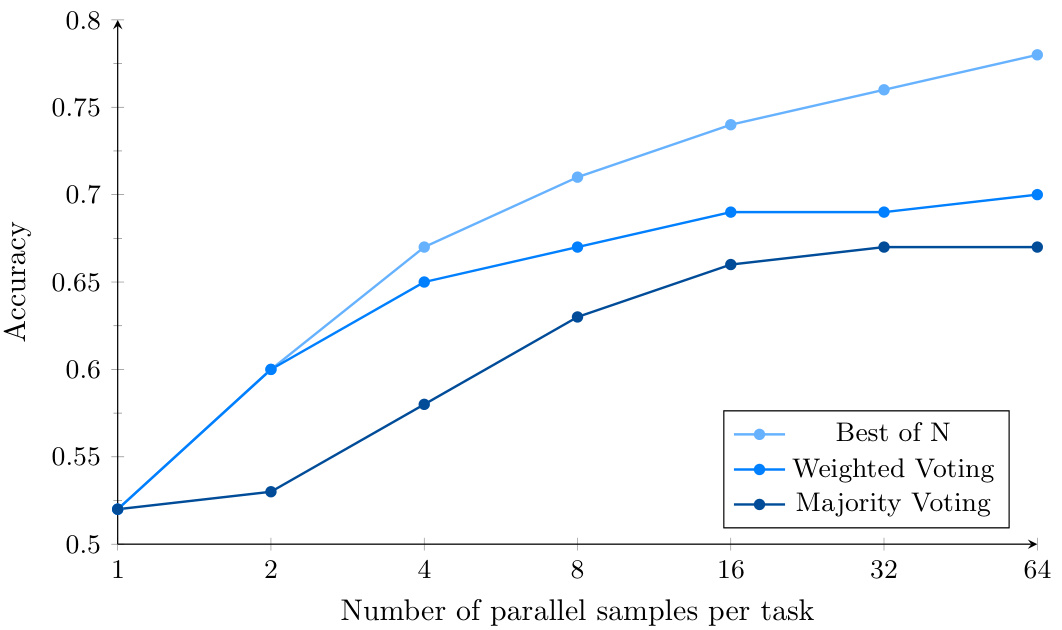

图 1:OpenAI Deep Research 早期版本在不同浏览努力下的 BrowseComp 表现。准确率随着测试时计算量的增加而平滑提升。

现有基准已“饱和”,BrowseComp 应运而生

当前,一些流行的基准测试,例如 SimpleQA,主要考察模型检索孤立、简单事实的能力。对于像配备了浏览工具的 GPT-4o 这样的先进模型而言,这类任务已显得过于简单,接近性能饱和。这意味着 SimpleQA 等基准已难以有效区分模型在处理更复杂、需要深度网络探索才能找到的信息时的真实能力。

正是为了弥补这一差距, OpenAI 开发了 BrowseComp(意为“浏览竞赛”)。该基准包含 1,266 个具有挑战性的问题,其设计目标是评估 AI 代理定位那些难以发现、信息点相互纠缠、可能需要访问数十甚至数百个网站才能解答的问题的能力。研究团队已将该基准发布在 OpenAI 的 simple evals GitHub 仓库,并提供了详细的研究论文。

BrowseComp 的设计理念

BrowseComp 的设计初衷是为了填补现有基准测试的空白。尽管过去已有一些基准测试用于评估信息检索能力,但大多数测试的问题相对简单,容易被现有的语言模型解决。BrowseComp 则专注于那些需要深入搜索和创造性推理才能找到答案的复杂问题。

以下是 BrowseComp 中的一些示例问题:

- 问题示例 1: 在 1990 年至 1994 年期间,哪些足球队在有巴西裁判的比赛中出场,且比赛中出现了四张黄牌(每队两张),其中三张黄牌在下半场发出,并且比赛中进行了四次换人,其中一次是因为受伤在比赛前 25 分钟进行的?

- 参考答案: 爱尔兰 vs 罗马尼亚

- 问题示例 2: 请识别一个偶尔打破第四面墙与观众互动的虚构角色,他以幽默著称,并有一个在 1960 年代至 1980 年代期间播出且集数少于 50 集的电视节目。

- 参考答案: 塑料人 (Plastic Man)

- 问题示例 3: 请找出 2018 年至 2023 年间在 EMNLP 会议上发表的一篇科学论文的标题,该论文的第一作者本科毕业于达特茅斯学院,第四作者本科毕业于宾夕法尼亚大学。

- 参考答案: 《面包制作基础:面包的科学》

BrowseComp 的独特之处

- 挑战性: BrowseComp 的问题经过精心设计,确保现有模型无法在短时间内解决。人类训练师在创建问题时进行了多轮验证,确保问题的难度。以下是一些用于评估问题难度的标准:

- 现有模型无法解决: 训练师被要求验证 GPT-4o(带和不带浏览功能)、OpenAI o1 以及早期版本的深度研究模型都无法解决这些问题。

- 搜索结果中不可用: 训练师被要求进行五次简单的 Google 搜索,并检查答案是否不在搜索结果的前几页。

- 人类难以在十分钟内解决: 训练师被要求创建的问题足够难,以至于另一个人无法在十分钟内解决。对于部分问题,第二位训练师尝试寻找答案。创建的问题被解决超过 40% 的时间的训练师被要求修改他们的问题。

图 2:BrowseComp 中主题的分布。通过提示的 ChatGPT 模型对每个问题的主题进行了事后分类。 - 易于验证: 尽管问题难度高,但答案通常是简短且明确的,易于通过参考答案进行验证。这种设计使得基准测试既具有挑战性,又不失公平性。

- 多样性: BrowseComp 的问题涵盖了广泛的领域,包括电视电影、科学与技术、艺术、历史、体育、音乐、视频游戏、地理和政治等。这种多样性确保了测试的全面性。

模型表现评估

在 BrowseComp 上的测试结果显示,现有模型的表现参差不齐:

- GPT-4o 和 GPT-4.5 在没有浏览功能的情况下,准确率接近于零。即使启用了浏览功能,GPT-4o 的准确率也仅从 0.6% 提升至 1.9%,这表明仅依靠浏览功能不足以解决复杂问题。

- OpenAI o1 模型虽然没有浏览功能,但由于其较强的推理能力,准确率达到了 9.9%,这表明一些答案可以通过内部知识推理得到。

- OpenAI Deep Research 模型表现最为突出,准确率达到了 51.5%。该模型能够自主搜索网络,评估和综合来自多个来源的信息,并调整其搜索策略,使其能够处理那些 otherwise 无法解决的问题。

深入分析

1. 校准误差

尽管 Deep Research 模型在准确率上表现优异,但其校准误差较高。这意味着该模型在自信地给出错误答案时,缺乏对自身不确定性的准确评估。这一现象在具有浏览功能的模型中尤为明显,表明访问网络工具可能会增加模型对错误答案的自信。

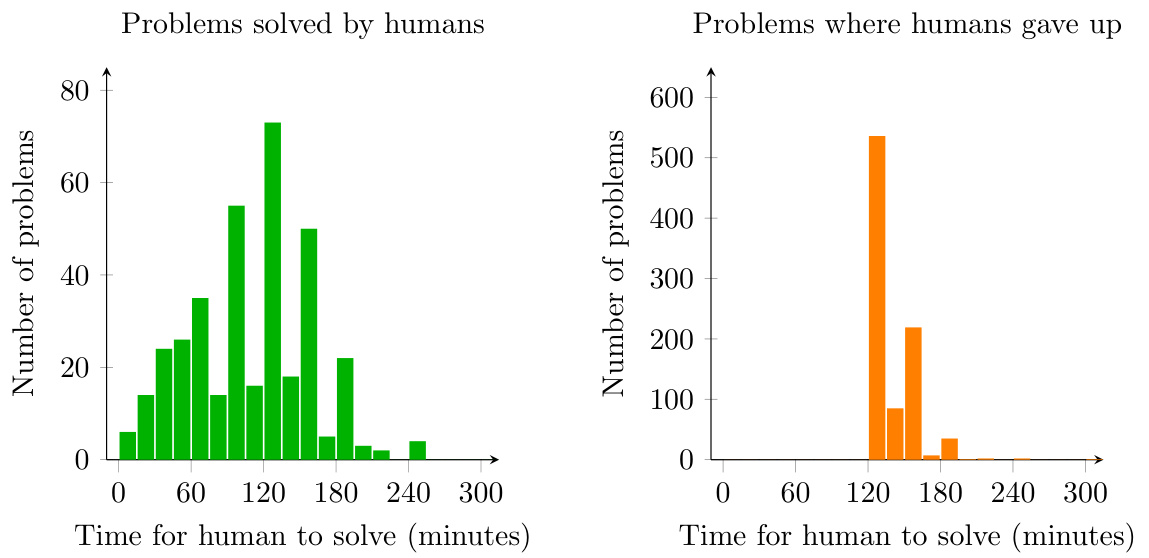

图 3:直方图显示了人类解决 BrowseComp 问题或放弃所需的时间。训练师只有在尝试解决问题至少两小时后才被允许放弃。

2. 计算资源的影响

测试结果表明,随着测试时计算资源的增加,模型的表现会逐步提升。这表明 BrowseComp 的问题需要大量的搜索和推理工作,而更多的计算资源可以显著提升模型的表现。

图 4:Deep Research 在使用并行采样和基于置信度的投票时的 BrowseComp 表现。额外的计算量通过 Best-of-N 进一步增强了模型性能。

3. 聚合策略

通过多次尝试并使用不同的聚合策略(如多数投票、加权投票和最佳选择),模型的表现可以进一步提升 15% 到 25%。其中,最佳选择策略表现最佳,表明 Deep Research 模型在识别正确答案方面具有较高的准确性。

结论

BrowseComp 的发布为人工智能代理的评估提供了一个新的维度。它不仅测试了模型的信息检索能力,还考察了其在复杂问题上的持久性和创造性。尽管现有模型在 BrowseComp 上的表现仍有待提升,但这一基准测试的发布无疑将推动人工智能领域的研究进展。

未来,随着更多模型的参与和技术的进步,我们有望看到人工智能代理在 BrowseComp 上的表现不断提升,最终实现更可靠和可信的 AI 代理。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...