自08月27日起,智谱将 GLM-4-Flash API 免费向公众开放。跑了3天的英译中测试,GLM-4-Flash对比硅基流动提供的GLM-4-9b、和 OpenRouter:集成多LLMs的统一接口,免费大模型接口 里提供的众多免费模型API相比,从效果和速率上也毫不逊色。

GLM-4-9b之前发布了免费API,在 SILICONFLOW(硅基流动):加速AGI普惠人类,集成免费大模型接口 ,同样都是免费API,GLM-4-Flash和GLM-4-9b在模型规模、参数数量、应用场景等方面存在一定差异,同样都是小模型,同样都提供免费服务,我们该如何选择?

可以说GLM-4-Flash 模型在“速度”和“性能”两方面都具有较大优势。

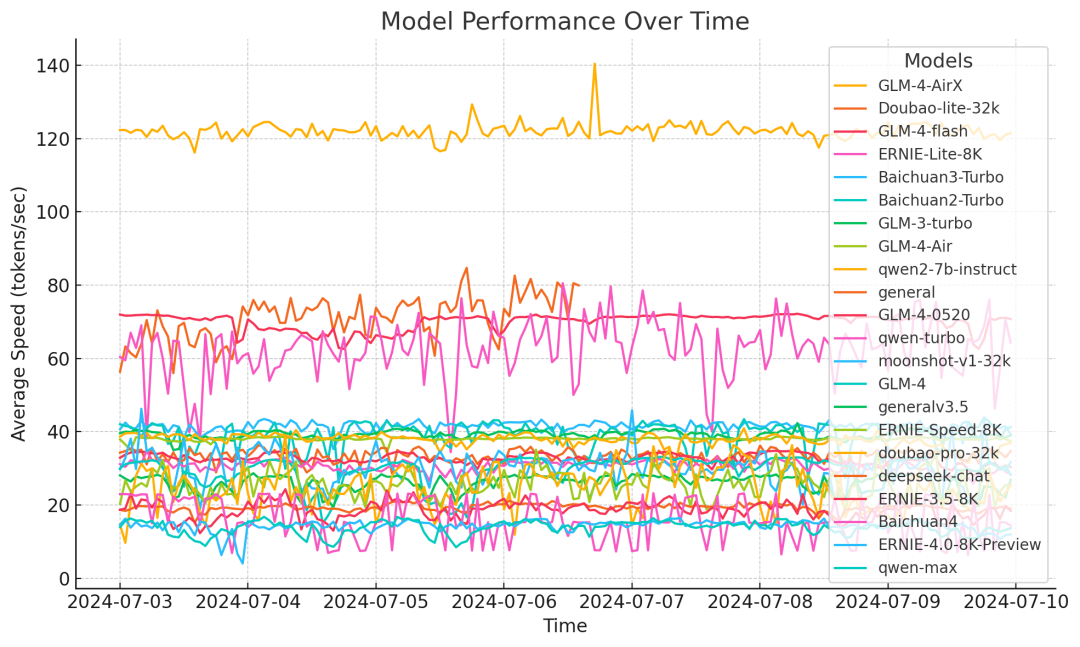

为提升模型的推理速度,GLM-4-Flash采用了自适应权重量化、多种并行处理技术、批处理策略以及投机性采样等多项优化措施。依据第三方模型速度测试结果,GLM-4-Flash 的推理速度在一周的测试周期内稳定在72.14 token/s 附近,显著优于其他模型。

在性能上,GLM-4-Flash在模型预训练阶段,使用了多达 10T 的高质量多语言数据,使得模型具备多轮对话、网页搜索、工具调用以及长文本推理(支持最大128K的上下文长度,输出4K长度)等功能,支持包括汉语、英语、日语、韩语、德语在内的26种语言。

在完全免费开放 GLM-4-Flash API 的基础之上,为了支持广大用户更好地将模型适用到特定应用场景,我们同步提供了模型微调功能,以满足不同用户的需求。欢迎使用!

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...