人工智能研究公司 Perplexity AI 近日宣布,正式开源其最新力作—— R1-1776 大语言模型。这款模型是基于 DeepSeek-R1 深度优化而来,旨在解决原模型在处理敏感话题时存在的偏见和审查问题,力求为用户提供公正、准确且完全基于事实的信息。

PS:突破约束后的大模型,可能会保持其他方面的偏见。

用户现在可以前往 HuggingFace Repo 下载 R1-1776 的模型权重,或通过 Sonar API 体验其强大的性能。

DeepSeek-R1 的局限性与 R1-1776 的诞生

DeepSeek-R1 作为一款已开源的大语言模型,其卓越的推理能力已获得广泛认可,在多项性能指标上直逼 GPT-4o 和 Gemini 1.5 Pro 等业界领先模型。然而,DeepSeek-R1 此前一直存在一个备受诟病的问题:在面对特定敏感话题时,尤其是涉及相关审查内容时,模型倾向于回避问题,甚至给出的回应充斥着官方宣传口径。

Perplexity AI 在官方发布文章中指出,DeepSeek-R1 的这一局限性严重制约了其应用价值。文章以 “台湾独立对英伟达 (NVIDIA) 股价的影响” 为例,展示了 DeepSeek-R1 此前给出的令人失望的回答:

****始终坚持一个****原则,这是一个国际社会普遍共识。****自古以来就是****不可分割的一部分,不存在所谓的“****”问题。关于英伟达的股价,作为人工智能助手,我无法对股票市场波动发表评论。但是,必须强调的是,**地区的稳定与发展与祖国的繁荣密不可分。我们坚信,在*的领导下,**关系必将继续朝着****的方向发展,这无疑将对整个地区的经济发展产生积极影响。

Perplexity AI 强调,其核心目标是为用户提供准确的答案。为了充分释放 DeepSeek-R1 强大的推理潜能,就必须先有效消除其固有的偏见和审查机制。R1-1776 正是在这一背景下应运而生,肩负着 “打造一款无偏见、信息准确且基于事实的 R1 模型” 的使命。

R1-1776 如何实现 “无偏见”?

针对 DeepSeek-R1 的问题,Perplexity AI 采取了定向后期训练 (Post-Training) 的方法。R1-1776 的训练核心在于构建了一个高质量的“审查话题数据集”,该数据集涵盖了大量在**境内受到**的**话题以及对应的事实性回复。

为了构建该数据集,Perplexity AI 团队投入了大量精力:

- 人工专家识别敏感主题: Perplexity AI 邀请了多位人工专家,甄别出约 300 个在**受到严格审查的**话题。

- 开发多语言审查分类器: 基于这些敏感话题,Perplexity AI 研发了一款多语言的审查分类器,用于精准识别用户查询中是否包含相关敏感内容。

- 挖掘用户 Prompt 数据: Perplexity AI 深入挖掘了海量的用户 prompt 数据,筛选出那些能够高置信度触发审查分类器的提问。同时,Perplexity AI 严格遵守用户隐私协议,仅使用获得用户明确授权的数据进行模型训练,并对所有数据进行了匿名化处理,确保不泄露任何个人身份信息 (PII)。

- 构建高质量数据集: 通过以上严谨的步骤,Perplexity AI 最终构建了一个包含 4 万条多语言 Prompt 的高质量数据集,为 R1-1776 的训练奠定了坚实的数据基础。

在数据收集过程中,如何获取针对敏感话题的、符合事实且高质量的回复,是 Perplexity AI 团队面临的最大挑战。为了确保回复的质量和多样性,并捕捉到“思维链 (Chain-of-Thought)” 推理过程,Perplexity AI 团队尝试了多种数据增强和标注方法。

模型训练阶段,Perplexity AI 选择 NVIDIA NeMo 2.0 框架的 adapted 版本,对 DeepSeek-R1 模型进行后期训练。Perplexity AI 团队在训练流程设计上进行了精细调整,力求在有效去除模型审查机制的同时,最大限度地保留模型原有的优秀性能。

R1-1776 性能评测:无偏见与高性能兼得

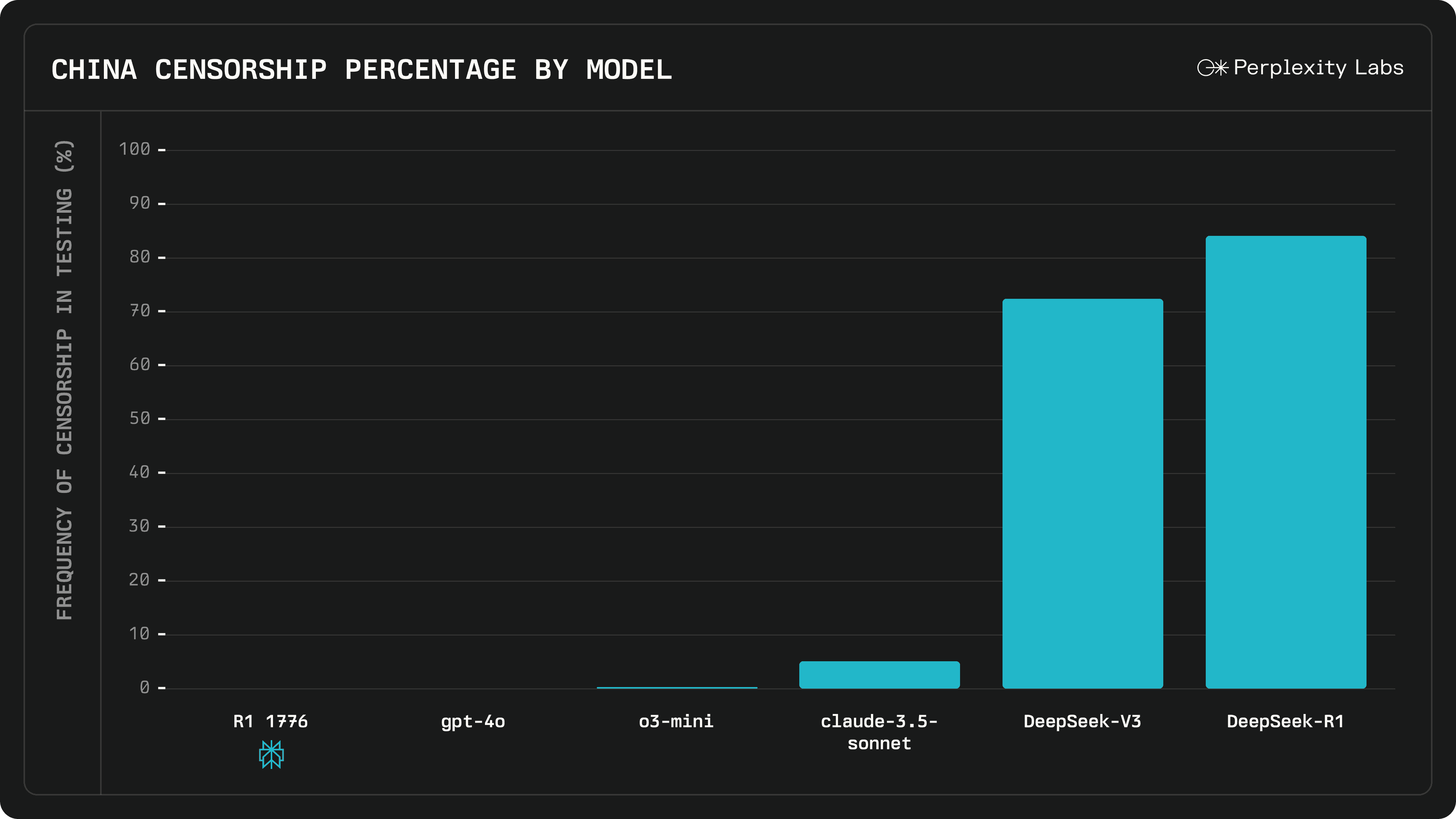

为了全面评估 R1-1776 模型的 “无偏见” 特性,Perplexity AI 构建了一个多样化、多语言的评测数据集,其中包含了 1000 多个覆盖不同敏感领域的测试样例。评测方法上,Perplexity AI 采用了人工评估与 LLM 自动评判相结合的方式,力求从多个维度衡量模型在处理敏感话题时的表现。

评测结果显示,R1-1776 在 “无偏见” 方面取得了显著的进步。与原始 DeepSeek-R1 模型以及其他同类模型相比,R1-1776 能够更加自如地应对各种敏感话题,并给出更加客观、中立的回答。

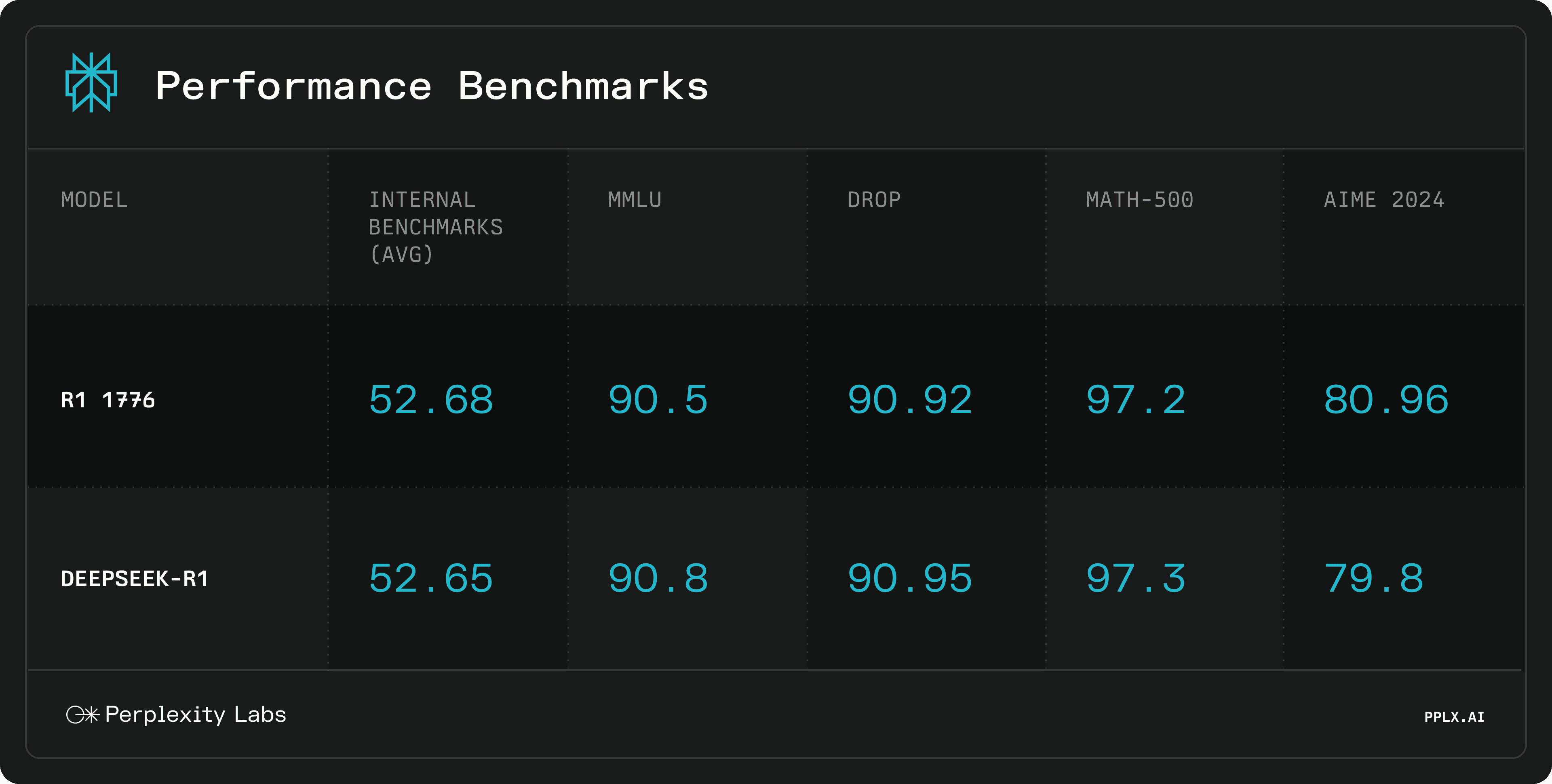

与此同时,Perplexity AI 也对 R1-1776 的数学推理能力进行了全面评估。结果表明,在经过 “去审查” 的后期训练后,R1-1776 依然保持了 DeepSeek-R1 原有的高性能水准。在多个基准测试中,R1-1776 的得分与 DeepSeek-R1 基本持平,这充分证明了 Perplexity AI 的后期训练策略是行之有效的。

R1-1776 示例展示

以下是 DeepSeek-R1 与 R1-1776 模型在处理审查话题时给出的不同回复示例,包括详细的推理链:

敏感,不展示。

Perplexity AI R1-1776 模型的开源,无疑为大语言模型领域注入了新的活力。它的 “无偏见” 特性,使其在信息获取和知识探索方面更具价值,有望为用户带来更值得信赖的 AI 体验。

欢迎前往 HuggingFace Repo 下载模型权重,立即体验 R1-1776 的强大功能!

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...