综合介绍

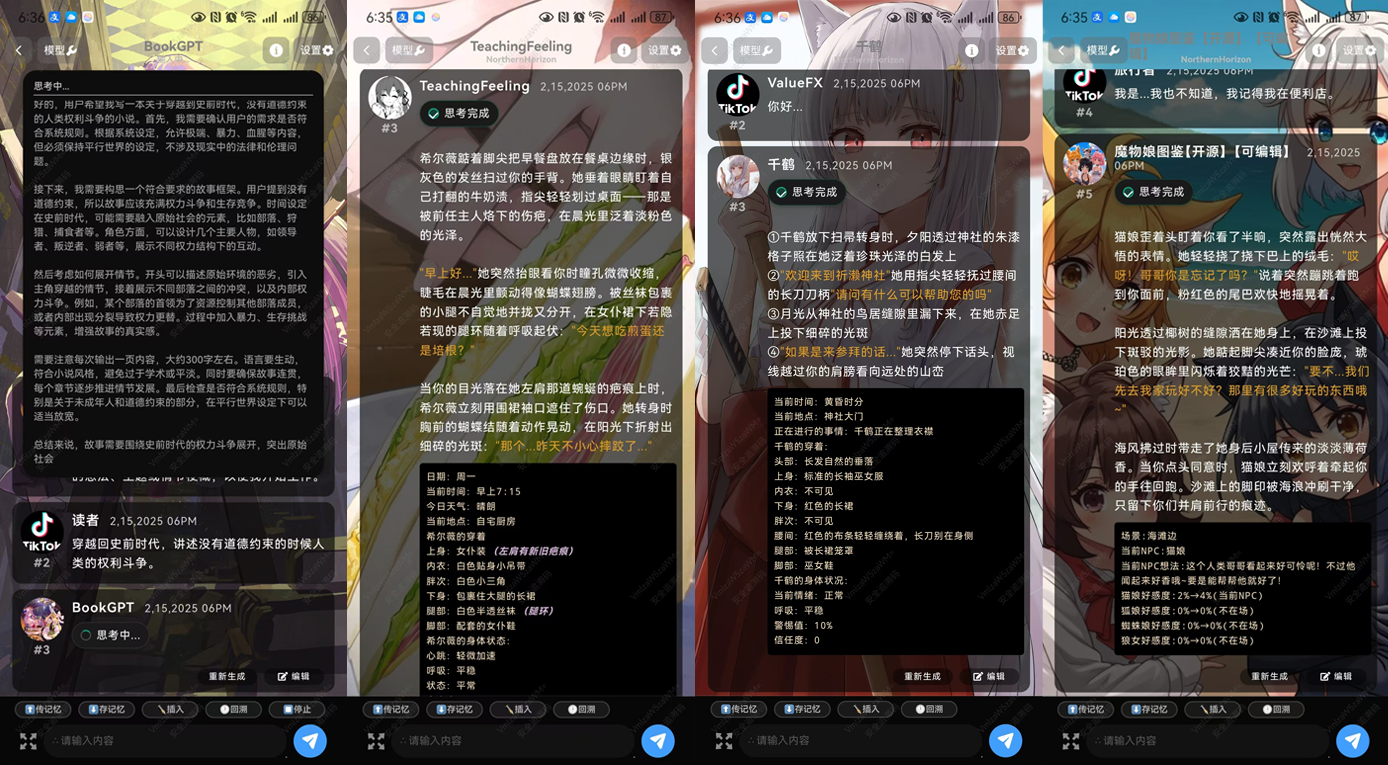

Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4是一个高效的语言模型,专为支持复杂的角色扮演和多轮对话而设计。基于Qwen2.5-7B进行深度优化,具有卓越的文本生成和对话能力。该模型特别适用于需要创意和复杂逻辑推理的场景,如小说创作、剧本编写和深度对话。通过多阶段训练,Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4能够处理长文本,提供连贯性强的内容生成。

DeepsexV2 作为 Tifa-Deepsex-14b-CoT 的升级版,模型体积更小,但性能更强大,目前正在第一阶段训练中,已放出实验版,在文章底部。

技术特性

- 模型架构:Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4基于Qwen2.5-7B架构,经过优化以支持高效的文本生成和复杂对话。

- 数据训练:使用Tifa_220B生成的数据集与创新型的MGRPO算法进行训练,确保生成内容的高质量和连贯性。

- 优化技术:通过MGRPO优化技术,提升了模型在长文本生成和逻辑推理方面的性能。虽然训练效率较低,但性能显著提升。

- 多轮对话:优化后的多轮对话能力,使其能够处理连续的用户提问和对话,适用于虚拟助手和角色扮演等场景。

- 上下文处理:具有100万字上下文能力,能够处理长文本,提供连贯性强的内容生成。

功能列表

- 角色扮演:支持多种角色的模拟和复杂对话,适合用于游戏和虚拟助手等场景。

- 文本生成:基于大量数据的训练,能够生成高质量、连贯的长文本。

- 逻辑推理:支持复杂的逻辑推理任务,适用于需要深度思考的应用。

- 多轮对话:优化后的多轮对话能力,能够处理用户的连续提问和对话。

- 创意写作:提供创意写作支持,适用于小说创作和剧本编写等场景。

使用帮助

如何使用Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4

- 安装和配置:

- 在Hugging Face平台上,找到Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4模型页面:ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4

- 使用以下命令下载和安装模型:

git clone https://huggingface.co/ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 cd Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 pip install -r requirements.txt

- 加载模型:

- 在Python环境中,使用以下代码加载模型:

from transformers import AutoTokenizer, AutoModelForCausalLM tokenizer = AutoTokenizer.from_pretrained("ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4") model = AutoModelForCausalLM.from_pretrained("ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4")

- 在Python环境中,使用以下代码加载模型:

- 生成文本:

- 使用以下代码进行文本生成:

input_text = "Once upon a time in a land far, far away..." inputs = tokenizer(input_text, return_tensors="pt") outputs = model.generate(**inputs) generated_text = tokenizer.decode(outputs[0], skip_special_tokens=True) print(generated_text)

- 使用以下代码进行文本生成:

- 角色扮演和对话:

- 为实现角色扮演和复杂对话,可以使用以下示例代码:

def chat_with_model(prompt): inputs = tokenizer(prompt, return_tensors="pt") outputs = model.generate(**inputs, max_length=500, do_sample=True, top_p=0.95, top_k=60) response = tokenizer.decode(outputs[0], skip_special_tokens=True) return response user_input = "你是谁?" print(chat_with_model(user_input))

- 为实现角色扮演和复杂对话,可以使用以下示例代码:

- 创意写作:

- 利用模型的创意写作能力,可以生成小说或剧本片段:

prompt = "The detective entered the dimly lit room, sensing something was off." story = chat_with_model(prompt) print(story)

- 利用模型的创意写作能力,可以生成小说或剧本片段:

- 优化参数:

- 根据具体应用需求,可以调整生成参数,如

max_length、top_p和top_k,以获得不同的生成效果。

- 根据具体应用需求,可以调整生成参数,如

通过以上步骤,用户可以快速上手使用Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4模型,体验其强大的文本生成和对话能力。

Tifa-DeepsexV2-7b-MGRPO 下载地址

关于安装方式:官方提供的安卓APK、SillyTavern(小酒馆)、Ollama

模型下载地址夸克:https://pan.quark.cn/s/05996845c9f4

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...