综合介绍

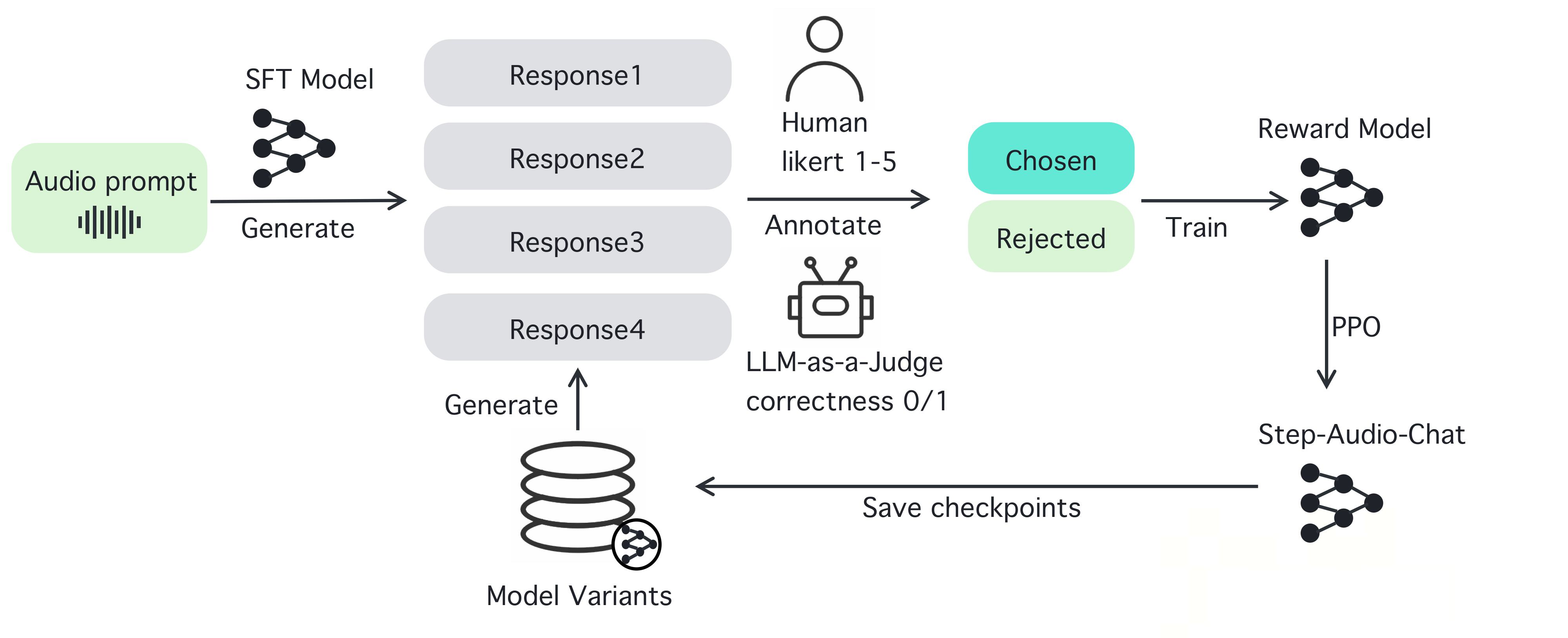

Step-Audio 是一个开源的智能语音交互框架,旨在提供生产环境开箱即用的语音理解和生成能力。该框架支持多语言对话(如中文、英文、日语)、情感语音(如快乐、悲伤)、区域方言(如粤语、四川话)、可调节的语速和韵律风格(如说唱)。Step-Audio 通过一个130B参数的多模态模型实现了语音识别、语义理解、对话、语音克隆和语音合成等功能。其生成数据引擎消除了传统TTS对手动数据收集的依赖,通过生成高质量音频来训练和发布资源高效的Step-Audio-TTS-3B模型。

功能列表

- 实时语音识别(ASR):将语音转换为文本,支持高精度识别。

- 文本到语音合成(TTS):将文本转换为自然语音,支持多种情感和语调。

- 多语言支持:处理中文、英文、日语等语言,以及粤语、四川话等方言。

- 情感与语调控制:调整语音输出情感(如开心、悲伤)和韵律风格(如 RAP、哼唱)。

- 语音克隆:基于输入语音生成相似的声音,支持个性化语音设计。

- 对话管理:通过上下文管理器保持对话连续性,提升用户体验。

- 开源工具链:提供完整代码和模型权重,开发者可直接使用或二次开发。

使用帮助

Step-Audio 是一个强大的开源多模态语音交互框架,适合开发者用于构建实时语音应用。以下是详细的安装、使用步骤以及功能操作指南,确保您能轻松上手并充分发挥其潜力。

安装流程

要使用 Step-Audio,您需要在具备 NVIDIA GPU 的环境中安装相关软件。以下是详细步骤:

- 环境准备:

- 确保您的系统安装了 Python 3.10。

- 安装 Anaconda 或 Miniconda 以管理虚拟环境。

- 确认安装了 NVIDIA GPU 驱动和 CUDA 支持,推荐使用 4xA800/H800 GPU(80GB 内存)以获得最佳生成质量。

- 克隆仓库:

- 打开终端,运行以下命令克隆 Step-Audio 仓库:

git clone https://github.com/stepfun-ai/Step-Audio.git cd Step-Audio

- 打开终端,运行以下命令克隆 Step-Audio 仓库:

- 创建虚拟环境:

- 创建并激活 Python 虚拟环境:

conda create -n stepaudio python=3.10 conda activate stepaudio

- 创建并激活 Python 虚拟环境:

- 安装依赖:

- 安装所需的库和工具:

pip install -r requirements.txt git lfs install - 克隆额外的模型权重:

git clone https://huggingface.co/stepfun-ai/Step-Audio-Tokenizer git clone https://huggingface.co/stepfun-ai/Step-Audio-Chat git clone https://huggingface.co/stepfun-ai/Step-Audio-TTS-3B

- 安装所需的库和工具:

- 验证安装:

- 运行简单测试脚本(如示例代码中的

run_example.py)以确保所有组件正常工作。

- 运行简单测试脚本(如示例代码中的

安装完成后,您可以开始使用 Step-Audio 的各种功能。以下是主要和特色功能的详细操作指南。

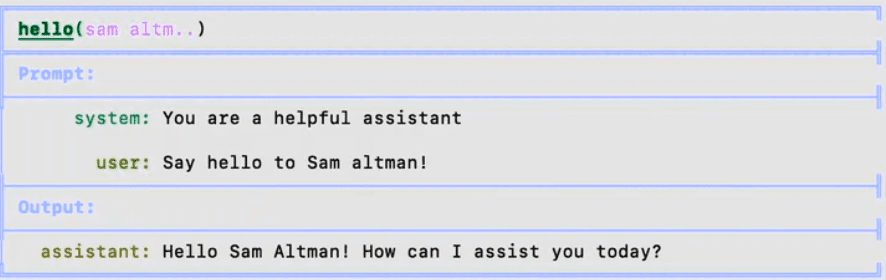

主要功能操作

1. 实时语音识别(ASR)

Step-Audio 的语音识别功能可以将用户的语音输入转换为文本,适合构建语音助手或实时转录系统。

- 操作步骤:

- 确保麦克风已连接并配置好。

- 使用提供的

stream_audio.py脚本启动实时音频流:python stream_audio.py --model Step-Audio-Chat - 说话时,系统会实时将语音转换为文本,并在终端输出结果。您可以查看日志确认识别精度。

- 特色功能:支持多语言和方言识别,如中文和英文混合输入,或粤语、四川话等本地化语音。

2. 文本到语音合成(TTS)

通过 TTS 功能,您可以将任意文本转换为自然语音,支持多种情感、语速和风格。

- 操作步骤:

- 准备好要合成的文本,例如保存为

input.txt。 - 使用

text_to_speech.py脚本生成语音:python text_to_speech.py --model Step-Audio-TTS-3B --input input.txt --output output.wav --emotion happy --speed 1.0 - 参数说明:

--emotion:设置情感(如 happy、sad、neutral)。--speed:调整语速(0.5 为慢,1.0 为正常,2.0 为快)。--output:指定输出音频文件路径。

- 准备好要合成的文本,例如保存为

- 特色功能:支持生成 RAP 和哼唱风格的语音,例如:

python text_to_speech.py --model Step-Audio-TTS-3B --input rap_lyrics.txt --style rap --output rap_output.wav

这将生成一段带有 RAP 节奏的音频,非常适合音乐或娱乐应用。

#### 3. 多语言与情感控制

Step-Audio 支持多种语言和情感控制,适合国际化应用开发。

- **操作步骤**:

- 选择目标语言和情感,例如生成日语悲伤语气语音:

python generate_speech.py --language japanese --emotion sad --text "私は悲しいです" --output sad_jp.wav

- 方言支持:如果需要粤语输出,可以指定:

python generate_speech.py --dialect cantonese --text "我好掛住你" --output cantonese.wav

- **特色功能**:通过指令可以无缝切换语言和方言,适合构建跨文化语音交互系统。

#### 4. 语音克隆

语音克隆允许用户上传一段语音样本,生成相似的声音,适用于个性化语音设计。

- **操作步骤**:

- 准备一个音频样本(如 `sample.wav`),确保音频清晰。

- 使用 `voice_clone.py` 进行克隆:

python voice_clone.py --input sample.wav --output cloned_voice.wav --model Step-Audio-Chat

- 生成的 `cloned_voice.wav` 将模仿输入样本的音色和风格。

- **特色功能**:支持高保真克隆,适用于虚拟主播或定制语音助手。

#### 5. 对话管理与上下文保持

Step-Audio 内置上下文管理器,确保对话的连续性和逻辑性。

- **操作步骤**:

- 启动对话系统:

python chat_system.py --model Step-Audio-Chat

- 输入文本或语音,系统会根据上下文生成响应。例如:

- 用户:”今天天气怎么样?”

- 系统:”请告诉我您的位置,我来查查。”

- 用户:”我在北京。”

- 系统:”北京今天晴天,气温 15°C。”

- 特色功能:支持多轮对话,保持上下文信息,适合客服机器人或智能助理。

注意事项

- 硬件要求:确保 GPU 内存充足,推荐 80GB 以上以获得最佳性能。

- 网络连接:部分模型权重需要从 Hugging Face 下载,确保网络稳定。

- 错误排查:如果遇到安装或运行错误,检查日志文件或参考 GitHub Issues 页面寻求帮助。

通过以上步骤,您可以充分利用 Step-Audio 的强大功能,无论是开发实时语音应用、创建个性化语音内容,还是构建多语言对话系统。Step-Audio 的开源性质还允许您根据需求修改代码、优化模型,满足特定项目需求。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...