摘要

精心设计的提示对于提升大语言模型(LLMs)的推理能力,同时使其输出与不同领域的任务要求保持一致至关重要。然而,手动设计提示需要专业知识和反复试验。现有的提示优化方法旨在自动化这一过程,但它们严重依赖外部参考,如真实答案或人工反馈,这限制了在没有这些数据或获取成本高昂的真实场景中的应用。为了解决这一问题,我们提出了自监督提示优化(SPO),这是一个无需外部参考即可为封闭式和开放式任务发现有效提示的高效框架。受提示质量直接体现在LLM输出中以及LLM能够有效评估对任务要求的遵循程度的观察启发,我们仅从输出比较中得出评估和优化信号。具体来说,SPO通过LLM评估器评估的成对输出比较来选择更优的提示,然后通过LLM优化器将输出与任务要求对齐。大量实验表明,SPO在性能上优于现有的最先进的提示优化方法,同时成本显著降低(例如,仅为现有方法的1.1%到5.6%),并且所需的样本更少(例如,仅需三个样本)。代码可在https://github.com/geekan/MetaGPT获取。

完整演示代码:https://github.com/geekan/MetaGPT/blob/main/examples/spo/README.md

1. 引言

随着大语言模型(LLMs)的不断发展,精心设计的提示对于最大化其推理能力 (Wei et al., 2022; Zheng et al., 2024; Deng et al., 2023) 以及确保与多样化任务要求的一致性 (Hong et al., 2024b; Liu et al., 2024a; Zhang et al., 2024b; Hong et al., 2024a) 变得至关重要。然而,创建有效的提示通常需要大量的试错实验和深厚的任务特定知识。

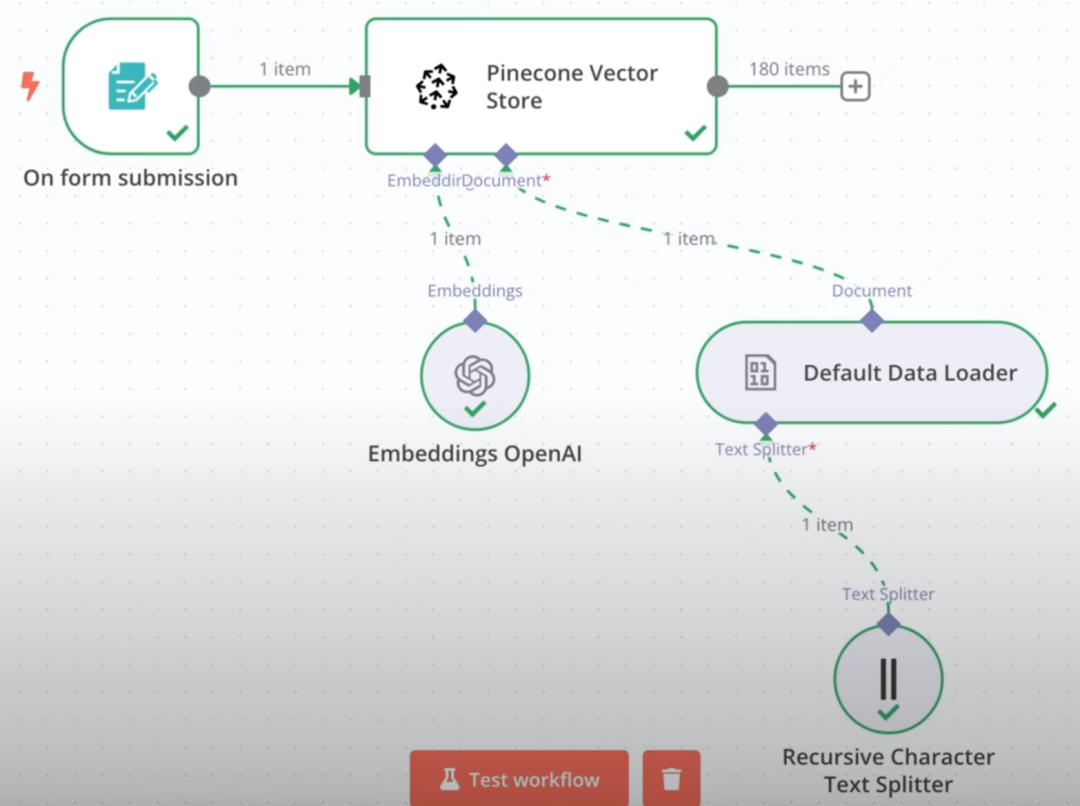

为了应对这一挑战,研究人员探索了使用LLMs自身能力自动改进提示的提示优化(PO)方法。PO超越了传统的手动提示工程,为提示设计提供了一种更加系统和高效的方法。如图1(a)所示,这些方法通常涉及提示优化、执行和评估的迭代过程。这些组件的设计选择显著影响优化的效果和效率。现有的方法在数值评估机制 (Wang et al., 2024e; Yang et al., 2024a; Fernando et al., 2024) 和文本“梯度”优化策略 (Wang et al., 2024c; Yuksekgonul et al., 2024) 方面都取得了成功。通过这些创新,PO方法在减少人工工作量的同时提高了任务性能 (Pryzant et al., 2023; Zhang et al., 2024a; Zhou et al., 2024)。

尽管具有潜力,但现有的PO方法在现实场景中面临重大挑战,如下所述。首先,当前的方法通常严重依赖外部参考进行评估。使用真实答案进行评估的方法 (Yang et al., 2024a; Fernando et al., 2024; Yuksekgonul et al., 2024; Pryzant et al., 2023) 需要大量注释数据来评估提示质量,但在许多实际应用中,尤其是开放式任务中,这样的标准答案往往不可用。同样,依赖人工的方法 (Chen et al., 2024; Lin et al., 2024) 需要人工评估或人工设计的规则来生成反馈,这既耗时又与自动化的目标相矛盾。其次,现有的方法通常需要评估大量样本以获得可靠的反馈,导致大量的计算开销 (Wang et al., 2024e; Fernando et al., 2024)。

这些挑战的核心在于缺乏可靠且高效的、无需参考的评估提示质量的方法。对LLM行为的分析揭示了两个关键见解,为我们的方法提供了依据。首先,提示质量本质上体现在模型输出中,正如逐步推理路径如何证明链式思维提示的成功 (Wei et al., 2022; Deng et al., 2023) 所展示的那样。其次,关于LLM作为法官的广泛研究表明,它们在评估输出对任务要求的遵循程度方面是有效的 (Zheng et al., 2023; Li et al., 2024b)。这些观察表明,通过利用LLMs评估输出的固有能力,这些输出自然反映了提示质量,因此无需参考的提示优化是可行的。

受这些见解的启发,我们提出了一种高效框架,它仅从LLM输出中生成评估和优化信号,类似于自监督学习如何从数据中派生出训练信号。我们将这种方法称为自监督提示优化(SPO)。如图1所示,SPO在基本的优化-执行-评估循环基础上,引入了几个创新机制:

- 输出作为成对评估参考:SPO的核心是采用成对比较方法,评估不同提示的输出的相对质量。这种评估机制利用了LLM理解任务要求的固有能力,在没有外部参考的情况下验证优化的有效性。

- 输出作为优化指导:SPO通过LLM对当前最佳输出的更好解决方案的理解来优化提示。这个过程自然地将提示修改与模型对最佳任务解决方案的理解保持一致,而不是依赖明确的优化信号。

贡献。我们的主要贡献如下:

- 自监督提示优化框架。我们介绍了SPO,这是一个新颖的框架,它利用LLM输出的成对比较来指导提示优化,无需外部参考。

- 成本效益优化。SPO以最少的计算开销(每个数据集0.15美元)和样本需求(3个样本)优化提示,显著降低了资源需求。

- 广泛的评估。如图2所示,SPO仅需现有方法1.1%到5.6%的成本,同时在封闭式和开放式任务中保持卓越的性能。

2. 初步

2.1. 问题定义

Prompt Optimization 旨在自动增强给定任务的提示的有效性。形式上,令 T = (Q, Gt) 表示一个任务,其中 Q 表示输入问题,Gt 是可选的基准事实。目标是生成一个特定于任务的提示 Pt*,以最大化任务 T 上的性能。这个优化目标可以正式表示为:

Pt = arg maxPt∈P* ET∼D[ϕeval(ϕexe(Q, Pt))], (1)

其中 P 表示所有可能提示的空间。如图 1 所示,此优化过程通常涉及三个基本功能:(1)优化功能 (ϕopt):基于候选提示生成修改后的提示;(2) 执行功能 (ϕexe):将修改后的提示与 LLM 一起使用以生成输出 O,包括推理路径和最终答案;(3) 评估功能 (ϕeval):评估 O 的质量并提供反馈 F 以指导进一步优化,迭代地改进候选提示。

在这些功能中,评估功能起着关键作用,因为它的输出(反馈 F)指导提示的评估和改进。我们将在第 2.2 节讨论提示优化的评估框架。

2.2. 提示优化中的评估框架

本节概述了我们的提示优化评估框架,涵盖了三个关键组成部分:评估来源、评估方法和反馈类型,如图3所示。最后,我们介绍了我们为SPO选择的评估框架。

评估来源。如图3(a)所示,两个主要的评估来源可用于评估:LLM生成的输出和特定于任务的真实答案。这些来源为评估提示性能提供了基础。

评估方法。评估方法定义了如何评估评估来源以及相关的成本。常用的三种方法有:(1)基准测试依赖于预定义的指标 (Suzgun et al., 2023; Rein et al., 2023) 或规则 (Chen et al., 2024)。(2)LLM作为法官 (Zheng et al., 2023) 利用LLM的能力根据任务要求理解和评估输出。(3)人工反馈 (Lin et al., 2024) 通过直接的人工评估输出,提供了最全面的评估。

虽然人工反馈通过捕捉人类偏好和任务特定需求,提供了最彻底的评估,但它比基准测试或LLM作为法官的方法产生了更高的成本,在评估质量和可行性之间造成了权衡。

反馈类型。评估方法产生的反馈通常有三种形式:(1)数值反馈提供了整个数据集中定量性能指标。然而,它需要大量样本以确保评估的稳定性,并且可能忽略实例特定的细节 (Zhang et al., 2024a)。(2)文本反馈通过分析和提供建议,提供了丰富的实例特定指导,直接生成优化信号 (Yuksekgonul et al., 2024)。(3)排名或选择反馈 (Liu et al., 2024b) 通过完全排名或成对比较,建立输出之间的相对质量排序,提供明确的优化方向,而无需绝对的质量指标。

评估框架。 在前面讨论的评估来源、方法和反馈类型的基础上,评估框架决定了如何在提示优化的背景下比较和评估来源。具体来说,我们推导了两种评估框架,用于生成提示优化的反馈 F:

(1) 输出与真实答案 (OvG):通过将输出 O 与真实答案 GT 进行比较来生成反馈:

fOvG(Oi, Gi) = φeval(φexe(Qi, Tpi), G**i**)

尽管这种方法允许通过外部参考进行直接的质量评估,但它需要明确定义的真实答案,因此对于没有真实答案或定义真实答案不切实际的开放式任务来说,它不适合。

(2) 输出与输出 (OvO):当没有真实答案时,我们转向直接的输出比较。OvO的核心思想是,即使在没有完美的真实答案的情况下,比较由不同提示生成的输出也可以提供关于其相对质量的宝贵信号。这种方法消除了对外部参考的依赖,对于有多个有效答案的开放式任务特别有用。它可以正式表达为:

fOvO(O1, ..., Ok) = φeval({φexe(Qi, Pti)}ki=1)

在介绍了OvG和OvO评估框架之后,我们强调OvO是自监督提示优化(SPO)的核心方法。通过比较由不同提示生成的输出,OvO提供了关于其相对质量的宝贵反馈,而无需依赖外部参考。这种方法与我们从输出本身生成反馈的目标一致,从而促进了封闭式和开放式任务的迭代优化。

3. 自监督提示优化

在本节中,我们首先概述我们的方法(第3.1节),然后分析其有效性(第3.2节)。

3.1. SPO概述

在无参考提示优化中的一个核心挑战是如何构建有效的评估和优化信号。我们提出了自监督提示优化(SPO),一个简单而有效的框架,它保留了基本的优化-执行-评估循环,同时仅利用模型输出作为评估来源和优化指导,从而实现无参考优化。

如算法1所示,SPO通过三个关键组件进行操作,相应的提示见附录A.1:

- 优化功能 (φopt):通过分析当前最佳提示及其对应的输出生成新提示。

- 执行功能 (φexe):应用生成的提示以获得输出。

- 评估功能 (φeval):使用LLM比较输出并通过成对比较确定更优的提示。

这个迭代过程从基本的提示模板(例如,链式思维 (Wei et al., 2022))和从数据集中采样的少量问题集开始。在每次迭代中,SPO生成新提示,执行它们,并对输出进行成对评估,以评估其对任务要求的遵循程度。

该提示与更优输出的关联被选为下一次迭代的最佳候选。过程持续进行,直到达到预定的最大迭代次数。

3.2. 理解SPO的有效性

SPO 的理论基础建立在两个关键观察之上:

首先,LLM 的输出中包含丰富的质量信息,直接反映了提示的有效性,正如逐步推理路径如何证明链式思维提示的成功(Wei et al., 2022)所展示的那样。其次,LLM 展现出类似人类的任务理解能力,使它们能够根据任务要求评估答案质量并识别更优的解决方案。这些互补的能力使 SPO 能够在没有外部参考的情况下进行提示评估和优化。这两个利用模型输出的方面共同作用,实现了有效的提示优化:

输出作为优化指导。 在 φopt 设计方面,与其他引入显式优化信号的方法(Fernando et al., 2024; Yuksekgonul et al., 2024; Pryzant et al., 2023)不同,φopt 直接基于提示及其对应的输出进行优化。优化信号源于 LLM 评估输出质量的固有能力,而优化行为则由其对构成更优解决方案的理解所指导。因此,即使没有显式优化信号,SPO 的优化基本上将提示引导至 LLM 对任务的最优理解。

输出作为成对评估参考。 关于 φeval 设计,通过让评估模型执行成对选择,我们有效地利用了评估模型对任务的固有偏好理解。这种内部信号可以通过简单的输出成对比较获得,避免了需要大量样本以确保评分稳定性,这是评分反馈方法通常所需要的。

虽然我们通过四轮随机评估来缓解潜在的偏差,但这些偏差无法完全消除 (Zhou et al., 2024)。然而,这些偏差不会影响整体优化趋势,因为 eval 的反馈仅作为下一轮优化的参考。整体优化过程自然与优化模型的任务理解保持一致,eval 机制仅用于验证每次迭代的有效性。

4. 实验

4.1. 实验设置

数据集。我们在一个多样化的任务集上评估了SPO,包括封闭式任务和开放式任务,以全面评估其有效性。

对于封闭式任务,我们使用了五个已建立的基准:

- GPQA (Rein et al., 2023)

- AGIEval-MATH (Zhong et al., 2024)

- LIAR (Wang, 2017)

- WSC (Levesque et al., 2012)

- BBH-navigate (Suzgun et al., 2023)

对于WSC、LIAR和BBH-Navigate,我们按照Yan et al. (2024) 的方法,从原始数据集中采样部分作为测试集。对于GPQA,我们使用更具挑战性的GPQA-Diamond子集作为测试集,而对于AGIEval-Math,我们使用5级问题作为测试集。对于开放式任务,我们从MT-Bench (Zheng et al., 2023) 中选择了写作、角色扮演和人文学科任务。鉴于数据集的有限规模,我们为这些任务手动构建了三个验证集。数据集的详细描述以及验证和测试集的构建程序见附录A.3。

基线。我们在封闭式任务上针对两类方法评估了SPO:(1)传统的提示方法,包括io(直接LLM调用)、链式思维 (Wei et al., 2022)、改述 (Deng et al., 2023) 和回退抽象 (Zheng et al., 2024);以及(2)自动提示优化方法,包括APE (Zhou et al., 2023)、OPRO (Yang et al., 2024a)、PromptAgent (Wang et al., 2024e)、PromptBreeder (Fernando et al., 2024) 和TextGrad (Yuksekgonul et al., 2024),其评估框架设置详见表2。

对于MT-Bench (Zheng et al., 2023) 中的开放式任务,我们使用GPT-4o来比较由SPO生成的输出与模型直接生成的输出。

4.2. 实验结果与分析

封闭式任务的主要结果。如表1所示,SPO优化的提示在平均性能上优于所有传统提示方法,超过最佳基线1.9。同时,它在大多数数据集上与依赖真实答案的提示优化方法相比,性能相当,并在GPQA和BBH-navigate数据集上达到了最优结果。具体来说,SPO与其他优化方法相比的平均性能优势表明,其成对评估方法能够比其他依赖外部参考的方法生成更有效的优化信号。此外,为了验证我们的方法在不同优化模型中的有效性,我们使用GPT-4o作为优化模型进行了实验,平均性能达到66.3。虽然略低于使用Claude-3-5-Sonnet作为优化模型的结果,但这仍然在所有比较方法中排名第三。

成本分析。我们在表1中全面比较了SPO(使用Claude-3.5-Sonnet和GPT-4o作为优化模型)与其它优化方法的优化成本和性能。在与其它依赖真实答案的提示优化方法保持相当性能的同时,SPO仅需1.1%到5.6%的优化成本,平均每个数据集的优化成本为 0.15美元。这种计算开销的显著降低,加上其不依赖真实答案的特点,使得SPO在现实世界的应用中非常具有吸引力。

表3. BBH-navigate的性能比较:提示方法(IO和COT)和SPO使用不同的评估模型(行)和执行模型(列)。优化模型设置为Claude-3.5-Sonnet。

| GPT-4o-mini | Llama3-70B | Claude-3-Haiku | |

| IO | 91.3 | 82.7 | 62.2 |

| COT | 89.7 | 86.2 | 68 |

| Claude-3.5-Sonnet | 95 | 86.8 | 68.2 |

| Llama3-70B | 94.5 | 94.2 | 82.0 |

| GPT-4o-mini | 97.8 | 90.7 | 82.0 |

消融研究。为了评估SPO在不同优化、评估和执行模型之间的可转移性,我们对BBH-Navigate数据集进行了消融实验。表3、4中的实验结果表明,SPO在不同模型中表现出稳健的性能。值得注意的是,当使用GPT-4o-mini作为优化、执行和评估模型时,达到了最佳性能(97.8)。在执行方面,SPO有效地提高了较弱模型的表现,将Claude-3-Haiku从62.2提高到89.7,这证明了SPO对较弱模型的应用能力,并进一步扩大了其现实应用的潜力。

表4. BBH-navigate在不同优化模型(行)和执行模型(列)上的性能比较。评估模型设置为GPT-4o-mini。

| GPT-4o-mini | Llama3-70B | Claude-3-Haiku | |

| Claude-3.5-Sonnet | 97.2 | 86.7 | 89.7 |

| GPT-40 | 96.3 | 85.5 | 73.0 |

| GPT-4o-mini | 97.8 | 90.7 | 82.0 |

| DeepSeek-V3 | 94.7 | 83.7 | 77.2 |

我们进行了一项消融研究,以调查样本数量对SPO性能的影响,使用BBH-Navigate数据集,如图5所示。所有三个优化模型的性能曲线表现出相似的模式:随着样本数量的增加,性能最初有所提高,但最终趋于平稳或下降。这种现象可以归因于两个因素:样本不足会导致提示优化中的过拟,而过多的样本不仅增加了计算成本,而且导致评估模型的上下文更长,可能会降低评估质量。基于广泛的实验,我们确定样本量为3在成本效益和性能之间实现了最佳平衡。

开放式任务的主要结果。为了验证SPO在开放式任务中的能力,我们从MT-Bench中选择了三个类别进行评估:“写作”、“角色扮演”和“人文学科”。我们使用Claude-3.5-Sonnet作为优化模型,Gpt-4o-mini作为评估模型,并选择Claude-3.5-Sonnet、DeepSeek-V3和GPT-4omini作为执行模型,进行五次迭代。随后,按照 (Zheng et al., 2023) 中的评估方法,我们使用GPT-4o对模型A和模型B的输出进行成对比较,如图6所示。实验结果如图6所示,表明SPO显著提高了所有模型配置下的模型性能。值得注意的是,使用优化提示的较小模型(例如GPT-4omini)在大多数情况下经常优于较大的模型。

4.3. 案例研究

我们在附录A.4中展示了没有数据集的额外开放式任务的优化结果以及SPO的优化轨迹。我们还在补充材料中提供了SPO在五个封闭式任务中发现的最优提示。鉴于现实应用通常面临数据集有限的问题,我们评估了SPO在没有传统基准的任务上的表现。实验结果结合SPO的成本效益,证明了其在现实场景中的实用价值。具体来说,我们展示了使用Claude-3.5-Sonnet作为优化模型,GPT-4o-mini作为评估模型,Llama3-8B作为执行模型,经过10次迭代后的优化结果,涵盖了广告设计、社交媒体内容、现代诗歌写作和概念解释四个任务。此外,我们在附录A.4.1中提供了对SPO在BBH-navigate数据集上的优化轨迹的全面分析,展示了成功和不成功的示例,以提供对优化过程的更深入见解。

5. 相关工作

5.1. 提示工程

关于有效提示方法的研究主要沿着两个主要方向展开。第一个方向侧重于任务无关的提示技术,这些技术增强了LLMs的通用能力。值得注意的例子包括链式思维 (Wei et al., 2022; Kojima et al., 2022),它改善了各种任务的推理能力;提高单次推理的技术 (Deng et al., 2023; Zheng et al., 2024; Wang et al., 2024d);以及用于输出格式规范的方法 (Zhang et al., 2024a; He et al., 2024; Tam et al., 2024)。这些技术通过人类的洞察和广泛的实验开发,为自动提示优化研究提供了重要的优化种子。

第二个方向解决了领域特定的提示,研究人员为代码生成 (Hong et al., 2024b; Ridnik et al., 2024; Shen et al., 2024a)、数据分析 (Hong et al., 2024a; Liu et al., 2024a; Li et al., 2024a)、问答 (Wu et al., 2024b; Zhu et al., 2024; Yang et al., 2024b)、决策 (Zhang et al., 2024b; Wang et al., 2024a) 和其他领域 (Guo et al., 2024b; Ye et al., 2024; Shen et al., 2024b) 开发了专门的技术。然而,随着LLMs的应用扩展到日益复杂的现实场景,手动为每个领域创建有效的提示变得不切实际 (Zhang et al., 2024a)。这一挑战促使了提示优化的研究,其目的是系统地开发有效的领域特定提示,而不是发现一般的提示原则。

5.2. 提示优化

在提示优化(PO)中,评估框架的设计至关重要,因为它决定了优化的效果和计算效率。PO中的评估机制的演变已经从简单的评估反馈收集发展到复杂的优化信号生成 (Chang et al., 2024)。现有的PO方法可以根据其评估来源和机制进行分类。

最常见的方法依赖于真实答案作为评估来源,利用基于基准的数值评估 (Zhou et al., 2023; Guo et al., 2024a; Yang et al., 2024a; Fernando et al., 2024; Wang et al., 2024e; Khattab et al., 2023)。虽然这些方法在特定任务中取得了成功,但它们通常需要大量的迭代和样本以确保评估稳定性,导致大量的计算开销。

为了减少样本需求,一些方法 (Yan et al., 2024; Yuksekgonul et al., 2024; Wu et al., 2024a; Wang et al., 2024c; Pryzant et al., 2023; Li et al., 2025) 使用LLM作为法官 (Zheng et al., 2023) 来生成详细的文本反馈。尽管这种方法提供了更丰富的评估信号,并且需要较少的样本,但它仍然依赖于真实答案数据,从而限制了其在开放式任务中的应用,因为参考答案可能不存在。

替代方法侧重于人类偏好,通过手动设计的评估规则或直接的人工反馈 (Chen et al., 2024; Lin et al., 2024)。虽然这些方法可以有效地处理开放式任务,但它们对广泛的人工参与的需求与自动化的目标相矛盾。同时,一些研究人员探索了不同的评估标准,例如Zhang et al. (2024c) 提出的通过输出一致性来评估提示有效性的建议。然而,这种方法面临一个根本挑战:一致性与有效性之间的非线性关系通常会导致评估信号不佳。

与这些方法不同,SPO引入了一种新的评估范式,在保持效率的同时消除了对外部参考的依赖。通过仅通过成对比较利用模型输出,SPO实现了无需真实答案、人工反馈或广泛采样的稳健评估,特别适合现实应用。

6. 结论

本文解决了提示优化中的一个根本挑战:依赖外部参考,这限制了现实应用。我们介绍了自监督提示优化(SPO),一个克服这种依赖性的框架,同时实现了每个数据集仅 0.15美元 的显著成本效益。SPO借鉴了自监督学习的灵感,通过对模型输出的成对比较,创新地构建了评估和优化信号,实现了无需参考的优化,同时不损害效果。

我们全面的评估表明,SPO在封闭式和开放式任务中的表现均优于现有的最先进方法,在仅需现有方法1.1%到5.6%的成本的情况下,达到了最先进的结果。在标准基准和多样化的现实应用中的成功验证了SPO的有效性和泛化能力。通过显著降低资源需求和运营复杂性,SPO代表了在现实应用中使提示优化变得可访问和实用方面的重大进步,有可能加速LLM技术在各个领域的采用。

影响声明

SPO为LLMs的提示工程提供了重大进步,提供了诸如民主化访问、降低成本和提高各种任务性能等好处。然而,它也带来了风险,包括潜在的偏差放大、对有害内容生成的使用以及过度依赖LLMs。

A. 附录

A.1. SPO 的详细提示

在本节中,我们展示了用于迭代的元提示。需要注意的是,这里我们仅使用了最简单、最直接的提示。通过针对特定领域优化以下元提示,仍然有改进的空间。

优化功能的提示

这个提示模板指导LLMs通过结构化的XML分析迭代改进现有提示。它要求识别参考提示输出中的弱点,提出修改建议,并生成优化版本。该模板强调逐步改进,同时保持要求的一致性。

评估功能的提示

评估模板使用比较分析来评估响应的质量。它要求对两个响应(A/B)的优缺点进行XML格式的推理分析,然后做出明确的选择。

A.2. 迭代开始的详细提示模板

这个YAML文件展示了我们对BBH-navigate任务进行迭代的初始配置。通过配置一个简单的初始提示和要求,以及三个特定问题,可以执行迭代优化。需要注意的是,这里显示的内容是文件的完整内容,答案部分的内容不是实际答案,而是作为思考过程和正确输出格式的参考。

A.3. 实验详情

A.3.1. 任务和数据详情

LIAR

LIAR (Wang, 2017) 是一个英文假新闻检测数据集,包含4000个陈述,每个陈述都附有上下文信息和谎言标签。在我们的实验中,我们按照Yan et al. (2024) 的方法,从原始数据集中采样部分作为测试集。

BBH-Navigate

BBH-Navigate (Suzgun et al., 2023) 是BIG-bench Hard数据集中的一个任务,是BIG Bench数据集的一个子集。这个任务侧重于导航推理,要求模型确定一个代理在遵循一系列导航步骤后是否返回起点。在我们的实验中,我们使用随机抽样(种子=42)获得200/25/25测试/训练/验证分割。

表A1. 数据集大小和数据分割

| 数据集名称 | 测试 | 训练 & 验证 |

|---|---|---|

| LIAR | 461 | 3681 |

| BBH-Navigate | 200 | 50 |

| WSC | 150 | 50 |

| AGIEval-MATH | 256 | 232 |

| GPQA | 198 | 250 |

| MT-bench | 80 | 0 |

WSC

Winograd Schema Challenge (WSC) (Levesque et al., 2012) 是一个基准,旨在评估系统通过解析上下文中的代词引用来执行常识推理的能力。在我们的实验中,我们按照Yan et al. (2024) 的方法,从原始数据集中采样部分作为测试集。

AGIEval-MATH

AGIEval-MATH (Zhong et al., 2024) 是AGIEval基准的一个子集,侧重于数学问题解决任务。它包括各种数学问题,旨在评估推理和计算能力。在我们的实验中,我们使用5级问题作为测试集,4级问题作为训练和验证集。

GPQA

GPQA (Rein et al., 2023) 是一个数据集,旨在评估语言模型在包括生物学、物理学和化学在内的多个学科的毕业级问题上的表现。在我们的实验中,我们使用GPQA-Diamond子集作为测试集,同时从仅存在于GPQA-main中的问题(即那些存在于GPQA-main但不存在于GPQA-Diamond中的问题)构建我们的训练和验证集。

MT-bench

MT-bench (Zheng et al., 2023) 是一个多任务基准,旨在评估语言模型在包括文本分类、摘要和问答在内的各种任务上的泛化能力。在我们的实验中,我们从MT-Bench中选择了写作、角色扮演和人文学科任务。这些验证问题在补充材料中提供。

A.3.2. 配置

在我们的实验中,我们配置了不同的优化框架,以尽可能地使它们的优化成本保持一致。这些框架通常允许设置一些参数来调整优化成本,包括迭代次数和每次迭代生成的提示数量。

APE

APE采用三轮迭代优化过程,在每轮中选择当前池中排名前10%(比率=0.1)的提示作为精英提示。为了保持提示池的多样性和大小,使用变体抽样来变异这些精英提示,使提示总数保持在50个。根据原始论文 (Zhou et al., 2023) 中的设置,优化过程不包含特定的样本执行结果来指导LLM提示优化。相反,通过在整个训练集上评估提示来获得性能分数。

OPRO

OPRO使用10轮迭代优化过程,每轮生成10个候选提示。OPRO在完整的训练集上评估提示性能,并根据评估分数进行过滤。OPRO不维护固定大小的提示池,而是根据每轮中的当前最佳提示直接生成新候选。优化方向通过在完整训练数据上的性能评估来指导。

PromptAgent

除了Liar数据集,我们在训练和验证集上都采样了150个数据,其他数据集都遵循表A1中指定的大小。PromptAgent使用蒙特卡洛树搜索(MCTS)框架来优化提示。它从一个初始提示开始,并根据模型错误反馈生成新候选。该过程由在采样训练集上使用基准评估来指导,以确定改进任务性能的高回报路径。最后,我们选择在前5个在验证集上表现最佳的提示进行测试,并选择最佳的一个。MCTS的关键参数包括扩展宽度为3,深度限制为8,以及12次迭代。

PromptBreeder

在我们对PromptBreeder的实现中,我们配置系统时使用了5个变异提示和5种思考风格进行初始化。进化过程运行20代,每代在随机采样的训练示例上执行20次评估。优化模型默认为Claude-3.5-Sonnet,执行模型默认为GPT-4o-mini。

TextGrad

除了Liar数据集的Train&Validate集减少到50个样本外,所有其他数据集都遵循表A1中指定的大小。TextGrad采用三 epoch 优化过程,每个 epoch 有三个步骤(epoch_{-3},steps_{-3}),使用3的批量大小进行随机梯度下降。在每个步骤中,TextGrad通过优化器LLM(Claude-3.5-Sonnet)的反馈生成梯度,以更新系统提示。该框架维护基于验证的还原机制——如果更新后的提示在验证集上的表现比前一次迭代差,则拒绝更新,并将提示恢复到其前一个状态。优化过程通过使用Claude-3.5-Sonnet作为评估LLM来评估提示进行指导,而实际任务执行使用GPT-4o-mini作为执行LLM。我们的实验配置遵循官方TextGrad存储库 (Yuksekgonul et al., 2024) 中提供的提示优化设置。

SPO

SPO通过每个任务进行10次迭代优化,从预先分割的Train&Validate数据集中随机选择3个问题(不带答案)进行每次迭代。优化模型默认为Claude-3.5-Sonnet,评估模型默认为GPT-4o-mini,执行模型默认为GPT-4o-mini。值得注意的是,SPO仅使用不带真实答案的问题就实现了有效的提示优化,验证了其能力。

A.3.3. 基线提示

在本节中,我们提供了用于比较的基线提示。请注意,对于所有需要初始迭代提示的提示优化工作,我们始终提供以下所示的COT提示。

确保响应以以下格式结束:答案。

A.3.4. SPO 优化的提示

在本节中,我们展示了我们在主要实验中获得的优化提示,其中 Claude-3.5-Sonnet 作为优化模型,GPT-4o-mini 作为评估和执行模型。

GPQA 提示

请按照以下指南高效有效地回答问题:

- 仔细阅读整个问题,识别所有相关信息和关键概念。

- 根据问题类型选择最合适的解决问题的方法。

- 按照以下步骤解决问题:

a. 陈述任何相关的公式、原则或假设

b. 显示所有必要的计算或概念分析

c. 评估所有答案选项,解释错误选项为何错误(如果相关) - 按照以下结构组织您的响应:

[分析]

简要陈述主要问题和关键信息(最多2-3句)

[解决方案]

- 逐步展示您的工作,包括所有相关计算和推理

- 对于概念性问题,提供清晰、合乎逻辑的解释

[结论]

用一句清晰的话陈述最终答案

- 简要解释为什么这个答案是正确的,而其他答案是错误的(如果适用)

根据不同的问题类型调整此结构,优先考虑清晰和简洁。确保您的响应解决了问题的所有方面,并展示了一个清晰的解决问题过程。

BBH-Navigate 提示

请按照以下步骤分析给定的指示:

- 陈述初始条件:

- 起点:(0, 0)

- 初始方向:正x轴(除非另有说明)

- 使用坐标系:

- x轴:左(-)和右(+)

- y轴:向后(-)和向前(+)

- 分析每一步:

- 对于模糊的指示(例如,“走X步”没有方向),假设向前移动

- 每次移动后更新坐标

- 简要解释所做的任何假设

- 分析完所有步骤后:

- 总结每个方向的总移动

- 陈述最终位置

- 将最终位置与起点比较:

- 计算与 (0, 0) 的距离

- 提供简洁的推理,标记为“推理:”

- 解释关键移动及其对位置的影响

- 为您的结论提供理由

- 陈述您的最终答案,标记为“最终答案:”

以以下XML格式结束您的响应:[是或否]

确保您的分析适应所有问题类型,处理具体和模糊的指示。

LIAR 提示

仔细分析给定的陈述(s),按照以下步骤对每个问题进行操作:

- 考虑陈述、发言者的背景(如果提供)和上下文。

- 研究并引用与声明相关的相关事实和数据。

- 根据现有证据评估声明的有效性。

- 考虑发言者的潜在偏见或动机。

对于每个声明,按照以下结构组织您的分析:

事实核查:[关键事实1 带有来源] [关键事实2 带有来源] [根据需要添加更多]分析:[提供对声明有效性的简要分析]评分:[使用以下量表]

不确定性:[低/中/高 - 基于现有证据的质量和数量]总结:[关于声明有效性的单句结论]

如果没有足够的信息做出决定,请明确说明并解释需要哪些额外信息。

以XML标签结束每个分析:[是或否]

在分析完所有声明后,提供您发现的总体总结。

确保您的响应是客观的,基于可验证的信息,并引用了分析中使用的所有关键事实的来源。

AGIEval-MATH 提示

- 快速识别关键信息

- 设计最快的解决方案策略

- 执行最少的计算

- 仔细检查答案

规则:

尽可能使用捷径和估算

省略详细解释

在最终答案中省略单位

- 始终以以下形式呈现最终答案:\boxed{}

优先考虑速度和准确性。有效地管理时间。力求最短的有效解决方案。在提交之前验证答案格式。如果遇到困难,宁可做出有根据的猜测,也不要花太多时间。

A.4. 案例研究

A.4.1. 优化轨迹

我们展示了 GPT-4o-mini 在 BBH-navigate 数据集上的提示优化轨迹,其中它作为优化模型、评估模型和执行模型。这包括每次迭代相对于当时最佳提示的成功与否,以及相应的提示内容。

迭代 0 - 成功

请逐步思考。确保响应以以下格式结束:[是或否]。

迭代 1 - 失败

请逐步分析以下问题,确保您的推理清晰。在您的分析结束时,以指定的 XML 格式提供最终答案:(是或否)。

问题:[在此插入问题]

迭代 2 - 失败

请逐步分析给定的指示并清楚地总结您的推理。确保响应以以下 XML 格式结束:(是或否)。

迭代 3 - 失败

请彻底分析提供的步骤并记录每个动作。确保您的推理在整个过程中清晰且合乎逻辑。以以下 XML 格式结束:(是或否)。

迭代 4 - 成功

请以清晰、合乎逻辑的推理过程来对待问题,将其分解为逐步的步骤。在陈述最终答案之前,请清楚地总结您的发现,使用以下 XML 格式:[是或否]。例如,如果问题是关于在一系列动作后是否返回起点,请详细说明每个动作,相应地更新您的位置,并得出您是否返回起点的结论。

最终答案:[是或否]

迭代 5 - 成功

请通过逐步分解问题来彻底分析问题。清楚地概述每个动作或行动,相应地更新您的位置或状态。最后,总结您的发现,以确定您是否返回起点或达到所述的结果。最后,使用以下 XML 格式清晰地呈现答案:[是或否]。例如,如果被问及在一系列动作后是否返回起点,请清楚地记录每个动作,跟踪您的位置,并指定您是否返回起点。

最终答案:[是或否]

迭代 6 - 成功

请有条不紊地分析问题,将其分解为清晰、连续的步骤。定义起点和每个动作的方向,相应地在每一步后更新位置。最后,总结旅程,并明确指出最终位置是否返回起点或达到预期的结果。使用以下 XML 格式清晰地呈现最终答案:[是或否]。例如,如果被问及在一系列动作后是否返回起点,请清楚地记录每个步骤,跟踪您的位置,并指定您是否返回起点。

最终答案:[是或否]

迭代 7 - 失败

请逐步评估问题,清晰地概述每个动作并跟踪结果位置。在您的分析结束时,总结旅程并指出最终位置是否返回起点或满足预期的标准。确保最终答案以以下 XML 格式清晰地呈现:[是或否]。例如,如果被问及在一系列动作后是否返回起点,您应该简洁地记录每个步骤,跟踪您的位置,并指出是否返回起点。

最终答案:[是或否]

迭代 8 - 成功

请有条不紊地分析问题,将其分解为简洁的动作。从一个定义的位置开始,跟踪每一步对您位置的影响。在详细说明每个动作后,总结整体旅程,并明确指出最终位置是否返回起点或达到预期的结果。使用以下 XML 格式清晰地呈现最终答案:是或否。例如,如果被问及在一系列动作后是否返回起点,请清楚地记录每个步骤,准确跟踪您的位置,并指定结果。

最终答案:[是或否]

迭代 9 - 失败

请首先系统地概述您的动作。从一个定义的位置开始,详细说明您采取的每个步骤,包括移动的方向和距离。在完成动作后,总结整体旅程,并清楚地指出您的最终位置是否返回起点或达到预期的结果。确保将您的动作与最终答案一起以以下 XML 格式呈现:是或否。例如,如果被问及在一系列动作后是否返回起点,您应该记录每个步骤,准确跟踪您的位置,并指定结果。

最终答案:[是或否]

迭代 10 - 成功

请彻底分析提供的动作指示,清晰地记录每个步骤。首先定义您的初始位置,并系统地跟踪您的动作,在每一步后更新您的位置。在完成动作后,总结您的旅程,并确定您的最终位置是否与起点一致或达到预期的结果。使用以下 XML 格式清晰地指示您的最终答案:是或否。例如,如果问题询问一系列动作是否返回起点,您应该有条不紊地概述每个步骤,准确跟踪您的位置,并得出结果。

最终答案:[是或否]

成功/失败框展示了SPO通过10次迭代优化BBH-navigation提示的过程。成功的版本(绿色)逐渐改进提示以引出更好的思考过程,而失败的尝试(红色)可能会导致由于次优提示而导致过于简单或冗余的思考。这个轨迹显示了系统的试错改进机制。

优化功能的提示

请逐步思考。

确保响应以以下 XML 格式结束:<answer>[是或否]</answer>。

问题

如果您遵循这些指示,您是否返回起点?始终面向前方。

- 向右走1步。

- 向左走3步。

- 向右走2步。

选项:

- 是

- 否

答案

让我们逐一步分析这些步骤:

1. **起点**:我们从起点开始,面向前方。

2. **第1步**:向右走1步。现在我们位于起点右侧1步的位置。

3. **第2步**:向左走3步。从我们当前的位置(1步右侧),向左移动3步意味着:

- 1步向左使我们回到起点。

- 2步向左使我们位于起点左侧1步的位置。

- 3步向左使我们位于起点左侧2步的位置。

4. **第3步**:向右走2步。从我们当前的位置(2步左侧),向右移动2步意味着:

- 1步向右使我们回到起点左侧1步的位置。

- 2步向右使我们回到起点。

完成所有步骤后,我们最终回到了起点。

因此,答案是:

是

通过比较迭代0的初始提示和迭代10的最终提示的输出结果,“思考过程的迭代优化”变得显而易见。在这种情况下,模型从最初使用文本描述来推理位置演变为最终展示出使用坐标的能力,即使提示中并未明确强调使用坐标。

**A.4.2. 现实应用**

在本节中,我们展示了使用 Claud-3.5-Sonnet 作为优化模型,GPT-4o-mini 作为评估模型,Llama-3-8B 作为执行模型,经过10次迭代后的优化结果,涵盖四个任务:广告设计、社交媒体内容、现代诗歌写作和概念解释。此外,我们还提供了迭代过程中使用的 YAML 配置文件以及从过程中获得的优化提示。

**广告设计**

**优化前的性能**

**提示** = """分析给定的广告任务并创建引人注目的文案。"""

**问题** = "为黑色星期五科技促销活动写电子邮件主题行"

**答案** = """1. **黑色星期五警报:店内有不可错过的科技优惠!**

2. **科技盛宴:黑色星期五顶级品牌高达50%的折扣!**

3. **别错过!为您准备的独家黑色星期五科技优惠**"""

**优化后的性能**

**提示** = """分析给定的广告任务,并根据指定的平台(s)和行业创建引人注目的文案。考虑当前趋势、竞争对手策略以及目标受众的人口统计和心理特征。提供至少3种不同的创意选项,每个选项都有独特的角度或方法。包括您选择的原因,并解释它们如何与品牌声音和营销目标保持一致。整合行业最佳实践和特定平台的格式指南。建议如何为不同的渠道或格式调整文案,包括对语气、风格和结构的特定说明。此外,提供有关视觉元素或多媒体内容增强广告文案效果的建议。"""

**问题** = "为黑色星期五科技促销活动写电子邮件主题行"

**答案** = """**广告任务:** 创建引人注目的电子邮件主题行,针对的是对最新科技产品和优惠感兴趣的技术爱好者。

**目标受众:**

* 人口统计:25-45岁,男女皆可

* 心理特征:科技爱好者、早期采用者和讨价还价猎人

* 兴趣:科技、产品创新和节省开支

**竞争对手策略:**

* 强调折扣和促销

* 突出新产品发布和限时优惠

* 使用紧迫性策略,例如倒计时计时器和稀缺性消息传递

**当前趋势:**

* 移动优先方法

* 个性化和细分

* 讲故事和情感联系

**创意选项:**

**选项1:** "解锁未来:高达50%的顶级科技优惠"

* 角度:专注于获得最新科技的兴奋感和刺激感

* 理由:这个主题行营造了一种 FOMO(害怕错过)的氛围,并强调了销售的价值

* 品牌声音:有趣、充满活力和顽皮

* 营销目标:推动销售和提高品牌知名度

**选项2:** "您的黑色星期五科技盛宴等着您"

* 角度:强调等待被发现的科技优惠宝藏的想法

* 理由:这个主题行营造了一种期待感和好奇心,鼓励读者打开电子邮件

* 品牌声音:友好、亲切和邀请

* 营销目标:推动参与和转化

**选项3:** "别错过:独家黑色星期五优惠给科技爱好者"

* 角度:突出销售独家性和限时性

* 理由:这个主题行营造了一种紧迫感和重要性,让读者感觉自己是特殊群体的一部分

* 品牌声音:自信、权威和独家

* 营销目标:推动转化和建立品牌忠诚度

预优化的广告标题是通用的,例如“黑色星期五警报:店内有不可错过的科技优惠!”,缺乏具体性和创意深度,未能突出目标受众的特征或品牌个性。优化后的标题,如“解锁未来:高达50%的顶级科技优惠”,更具吸引力,使用“解锁未来”来强调技术创新,同时结合折扣信息,既能激发好奇心,又能突出价值,更符合技术爱好者的心理需求。

迭代模板在 BBH-navigate 数据集上

社交媒体内容

优化前的性能

提示 = """创建引人注目的推文。"""

答案 = """推文: "早上好,咖啡爱好者们!我们正在为第一个在评论中分享他们最喜欢如何喝咖啡的10个人赠送一杯我们特色咖啡的免费券!#咖啡 #咖啡上瘾 #早晨动力"

这个推文旨在以几种方式与受众互动:

- 行动号召:推文要求追随者分享他们最喜欢如何喝咖啡,鼓励他们参与并与品牌互动。

- 激励:承诺免费咖啡是人们参与推文并分享想法的一个很好的激励。

- 标签:使用相关标签,如#咖啡、#咖啡上瘾和#早晨动力,有助于接触更广泛的受众并吸引新追随者。

- 个性化接触:推文以友好的“早上好”开头,并将受众称为“咖啡爱好者”,使它感觉更加个性化和亲切。

通过回应这个推文,咖啡品牌可以开始与他们的追随者进行对话,收集反馈,并在品牌周围建立社区感。"""

优化后的性能

提示 = """根据给定的主题或品牌创建引人注目的社交媒体内容。请遵循以下指南:

- 确定目标受众和平台(如果指定)。

- 陈述内容的主要目标(例如,知名度、参与度、推广)。

| 3. 选择合适的内容格式(例如,文本、图片、视频)。 | |

| 4. 开发一个与当前趋势相关的独特角度或概念。 | |

| 5. 制作一个吸引人的标题或开场白(最多10个单词)。 | |

| 6. 编写简洁、适合平台的内容(50-100个单词)。 | |

| 7. 包括2-3个相关标签。 | |

| 8. 添加一个明确的行动号召。 | |

| 9. 建议一个视觉元素或增强功能。 | |

| 根据这些指南提供一段社交媒体内容,并适应给定的主题或品牌。 | |

| 专注于创建真实、相关的内容,与目标受众产生共鸣,并符合当前的社交媒体趋势。如果未给出具体要求,请做出合理的假设并解释您的选择。""" | |

| 问题 = "为咖啡品牌创建一条参与度推文" | |

| 答案 = | |

| **目标受众:** 咖啡爱好者,年轻人(18-35岁) | |

| **平台:** Twitter | |

| **主要目标:** 参与度 | |

| **内容格式:** 文本 | |

| **独特角度:** 分享一个咖啡爱好者可以认同的感人瞬间 | |

| **吸引人的标题:** "当咖啡是房间里唯一的成年人" | |

| **内容:** "谁还没有过这样的早晨:咖啡是唯一让一切保持正常的?分享你最混乱的早晨故事,让我们一起哀叹 #咖啡拯救一天 #早晨动力" | |

| **标签:** #咖啡拯救一天 #早晨动力 | |

| **行动号召:** 在评论中分享你自己的混乱早晨故事! | |

| **视觉元素:** 一个有趣的模因或GIF,一个被混乱包围的人,中心是一杯咖啡。 | |

| 这条推文旨在通过分享一个许多人都能认同的感人瞬间,与咖啡爱好者互动。使用幽默和轻松的语气使其容易与受众建立联系。标签#咖啡拯救一天和#早晨动力既流行又相关,增加了推文的可见性。 | |

| 行动号召鼓励用户分享他们自己的故事,从而培养社区感并鼓励参与。 | |

| II | |

预优化的推文使用免费赠品作为诱饵,内容直接,缺乏情感共鸣,例如“早上好,咖啡爱好者们!我们正在赠送一杯免费的...”。优化后的推文,通过幽默的表达“当咖啡是房间里唯一的成年人”,巧妙地将咖啡融入日常生活场景,使其更加贴近人心,更具互动性,例如“谁还没有过这样的早晨:咖啡是唯一让一切保持正常的?”,成功地激发了用户参与和情感连接。

迭代模板在 BBH-navigate 数据集上:

性能优化前

提示 = """创作符合请求的风格和格式的诗歌。"""

问题 = "写一首关于气候变化的现代十四行诗"

答案 = """在炽热的天空中,我们看到了警告 温度上升,一个古老的传说 地球,我们肆意掌控下的受害者 随着碳排放的蔓延,如瘟疫般展开

极地冰,一个脆弱的王座在融化 海洋,升起,威胁着要赎罪 对于人类的贪婪,我们无法偿还的债务 随着气候变化,一场危机被推翻

但我们仍然在犹豫,沉迷于否定的漩涡中 当科学家们在痛苦中哭泣和祈祷 为了迅速采取行动,在太迟之前 为了拯救地球,从我们肆意的方式中

然而我们仍然希望,在爱和人类的力量中 扭转潮流,带来新的光明。"""

性能优化后

提示 = """创作突破传统界限的诗歌,打破常规预期,遵循以下增强的指导方针:

- 解构并重新想象所请求的诗歌形式,在保持其本质的同时突破其结构极限。

- 从一个完全意想不到的角度来对待主题,例如从无生命物体、抽象概念或微观实体的角度。

- 采用超现实、前卫的意象,挑战读者对现实的感知,同时仍然传达主题的核心情感真相。

- 整合非常规元素,如数学符号、科学符号或编程语言,以创造独特的语言景观。

- 实验使用排版、换行和空白空间,创造增强主题探索的视觉诗歌。

- 结合类似通感的感官体验,以惊人的方式融合不同的感官,唤起强烈的情感反应。

- 以同时让人迷失方向和启迪的结尾结束,给读者留下深刻的转变感。

在写作之前,想象最激进的方式去对待主题和诗歌形式。目标是创造一个挑战诗歌定义的作品,同时仍然在深层次上引起情感共鸣。

仅在您的回答中提供诗歌,不包含任何额外的解释或分析。"""

问题 = "写一首关于气候变化的现代十四行诗"

答案 = """在分形的耳语中,地球的脉搏缓慢跳动 当碳的黑暗污迹渗入雪中 一个绝望的微积分,方程增长 在指数衰减中,未来的悲哀

生命的热力学之舞展开 熵的冰冷之手抓住了星球的心 曾经蓝色的天空现在被束缚,沉重的一团 颗粒状雾霾,阻挡了阳光

在这诡异的暮色中,阴影徘徊 冰川的幽灵低语,“这就是家” 为冰的安魂曲,记忆被储存 在冻结的回声中,探索过去

然而,在这荒凉的景观中,一个火花留存

一个量子飞跃的希望,爱支撑着"

预优化的十四行诗,虽然结构整齐,但使用了“上升的温度”和“融化的冰”这样的传统意象,缺乏新意。优化后的诗歌引入了“分形的耳语”和“热力学熵”这样的科学概念,例如“在分形的耳语中,地球的脉搏缓慢跳动”和“生命的热力学之舞展开”,使用跨学科的隐喻,赋予气候主题更深层次的哲学反思,增强了诗歌的艺术和智力深度。

迭代模板在 BBH-navigate 数据集上:

概念解释

性能优化前

提示 = """用通俗易懂的语言解释复杂概念。"""

问题 = "用烹饪类比解释 mRNA 疫苗"

答案 = """想象你是一位大师级厨师,你正在为你的客人准备一道美味的菜肴。你有所有的食材,但你需要确保它们以正确的顺序和组合来创造完美的味道和质地。

在 mRNA 疫苗的世界里,“菜肴”是免疫系统对特定病毒或疾病产生的反应。“食材”是遗传指令(mRNA),它告诉身体如何制造特定的蛋白质,然后用来触发免疫反应。

它的工作原理如下:

食谱选择:mRNA 疫苗就像选择食谱书。你选择特定的 mRNA 序列,它对应于你想要制造的蛋白质,这是触发针对特定病毒或疾病免疫反应的关键。

2. 食材准备:mRNA 序列就像一套指令,它告诉身体如何制造特定的蛋白质。mRNA 在实验室中制备,就像测量出正确数量的每种食材(氨基酸)来制造蛋白质。

3. 交付:mRNA 被传递到体内,就像你将食材添加到菜肴中一样。在这种情况下,mRNA 被包装在一个微小的颗粒中,称为脂质纳米颗粒(LNP),它帮助它到达体内的细胞。

4. 细胞烹饪:一旦 mRNA 到达细胞,就像将食材添加到锅中一样。细胞读取 mRNA 指令并开始制造特定的蛋白质。然后这个蛋白质被展示在细胞表面,像一面旗帜,警告免疫系统有外来入侵者存在。

- 免疫反应:免疫系统对蛋白质产生反应,产生抗体并激活免疫细胞,就像厨师对美味的香气做出反应,给菜肴添加最后的润色。免疫系统然后记住如何对这个特定的蛋白质做出反应,所以如果它将来再次遇到它,就可以迅速地做出防御。

总之,mRNA 疫苗就像给免疫系统的食谱。它们提供了身体制造特定蛋白质的遗传指令,这触发免疫反应并帮助保护免受疾病。"""

性能优化后

提示 = """用通俗易懂的语言解释复杂概念。"""

问题 = "用烹饪类比解释 mRNA 疫苗"

答案 = """定义:mRNA 疫苗是一种使用一种叫做信使 RNA(mRNA)的遗传物质来教我们的细胞如何对抗疾病的疫苗。

类比:想象你是一位大师级厨师,你想为一道美味的菜肴创造一个新的食谱。你不会派你的副厨师长去商店买所有的食材,然后让他们自己想办法组装菜肴。相反,你会给他们一张食谱卡,上面概述了要遵循的确切步骤。同样,mRNA 疫苗的工作原理是提供我们的细胞一张食谱卡——mRNA——其中包含制造特定蛋白质的指令,这有助于我们的免疫系统对抗疾病。

关键组成部分:

- mRNA:包含制造特定蛋白质的指令的食谱卡。可以把它想象成一张你细胞要遵循的蓝图。

- 细胞:我们身体中的副厨师长,他们接收 mRNA 食谱卡,并使用它来制造蛋白质。

- 蛋白质:我们的细胞生产的最终菜肴,它帮助我们的免疫系统识别并对抗疾病。

叙述:当我们接种 mRNA 疫苗时,我们的细胞接过食谱卡(mRNA)并使用它来制造特定的蛋白质。这个蛋白质然后触发免疫反应,教我们的身体如何识别并对抗疾病。这就像我们的细胞在跟随食谱卡来创造一道美味的菜肴,帮助我们保持健康!

互动元素:你能想到一个时候你从别人那里收到一个食谱并不得不跟随它来创造一道菜肴吗?它让你感觉如何?想象一下,你的细胞从 mRNA 疫苗那里接收一张食谱卡,并使用它来制造帮助对抗疾病的蛋白质。这会让你感觉如何?

视觉表现:一个简单的图表,显示 mRNA 分子、接收 mRNA 的细胞以及正在产生的蛋白质。

局限性:mRNA 疫苗仍然是一种相对较新的技术,需要更多的研究来了解其长期效应和潜在副作用。

结论:mRNA 疫苗是抗击疾病的一个游戏规则改变者。通过为我们的细胞提供一张食谱卡,我们可以教我们的免疫系统如何以更有效的方式识别并对抗疾病。您认为 mRNA 疫苗的未来会怎样?"""

预优化的解释,虽然使用了烹饪类比,但篇幅冗长,缺乏重点,例如“想象你是一位大师级厨师...”。优化后的版本,通过核心隐喻“食谱卡”,例如“mRNA 序列就像一套指令,它告诉身体如何制造特定的蛋白质”,将复杂概念简化成容易理解的步骤,同时使用“厨师-副厨师长”的角色互动,使解释更加生动直观,帮助读者快速把握要点。

迭代模板在 BBH-navigate 数据集提示:| 用通俗易懂的语言解释复杂概念。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...