综合介绍

Pieces-OS 是一个开源项目,旨在将 Pieces-OS 的 GRPC 流逆向并转换为标准的 OpenAI API 接口,支持Claude、GPT、Gemini。该项目由 Nekohy 开发,基于 GPL-3.0 协议开源,主要用于学习和交流,不得用于商业用途。项目提供了多种模型的兼容性,并支持 Vercel 一键部署。

功能列表

- GRPC 流逆向:将 Pieces-OS 的 GRPC 流转换为标准的 OpenAI 接口。

- 多模型支持:兼容 Claude 系列、GPT 系列、Gemini 系列等多种模型。

- 一键部署:支持 Vercel 平台的一键部署,方便用户快速搭建。

- 云端模型配置:提供云端模型的配置文件,用户可以根据需要提取和使用不同的模型。

- API 请求管理:通过配置环境变量,管理 API 请求的前缀路径、密钥、重试次数等。

使用帮助

安装流程

- 克隆项目:使用

git clone命令将项目克隆到本地。git clone https://github.com/Nekohy/pieces-os.git - 安装依赖:进入项目目录并安装

package.json中定义的依赖库。cd pieces-os npm install - 启动程序:执行

node index.js启动程序。node index.js

使用流程

- 获取模型列表:通过以下命令获取可用模型列表。

curl --request GET 'http://127.0.0.1:8787/v1/models' --header 'Content-Type: application/json' - 发送请求:使用以下命令发送聊天请求。

curl --request POST 'http://127.0.0.1:8787/v1/chat/completions' --header 'Content-Type: application/json' --data '{ "messages": [ { "role": "user", "content": "你好!" } ], "model": "gpt-4o", "stream": true }'

环境变量配置

- API_PREFIX:API 请求的前缀路径,默认值为

'/'。 - API_KEY:API 请求的密钥,默认值为空字符串。

- MAX_RETRY_COUNT:最大重试次数,默认值为

3。 - RETRY_DELAY:重试延迟时间,单位为毫秒,默认值为

5000(5秒)。 - PORT:服务监听的端口,默认值为

8787。

模型配置

项目提供了多种模型的配置文件 cloud_model.json,用户可以根据需要提取和使用不同的模型。例如:

- Claude 系列:

claude-3-5-sonnet@20240620、claude-3-haiku@20240307等。 - GPT 系列:

gpt-3.5-turbo、gpt-4、gpt-4-turbo等。 - Gemini 系列:

gemini-1.5-flash、gemini-1.5-pro等。

部署后如何使用

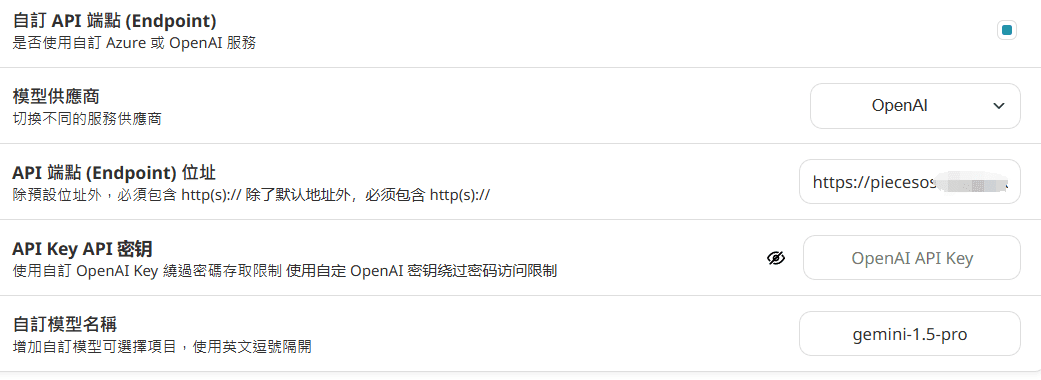

nextchat中配置:

直接填写域名,URL后不要添加/v1/models 、 /v1/chat/completions

Vercel中未配置API_KEY,则无需输入。

沉浸式翻译中配置:(因为并发问题不建议)

https://你的域名/v1/chat/completions

apikey未设置则随便填写

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...