综合介绍

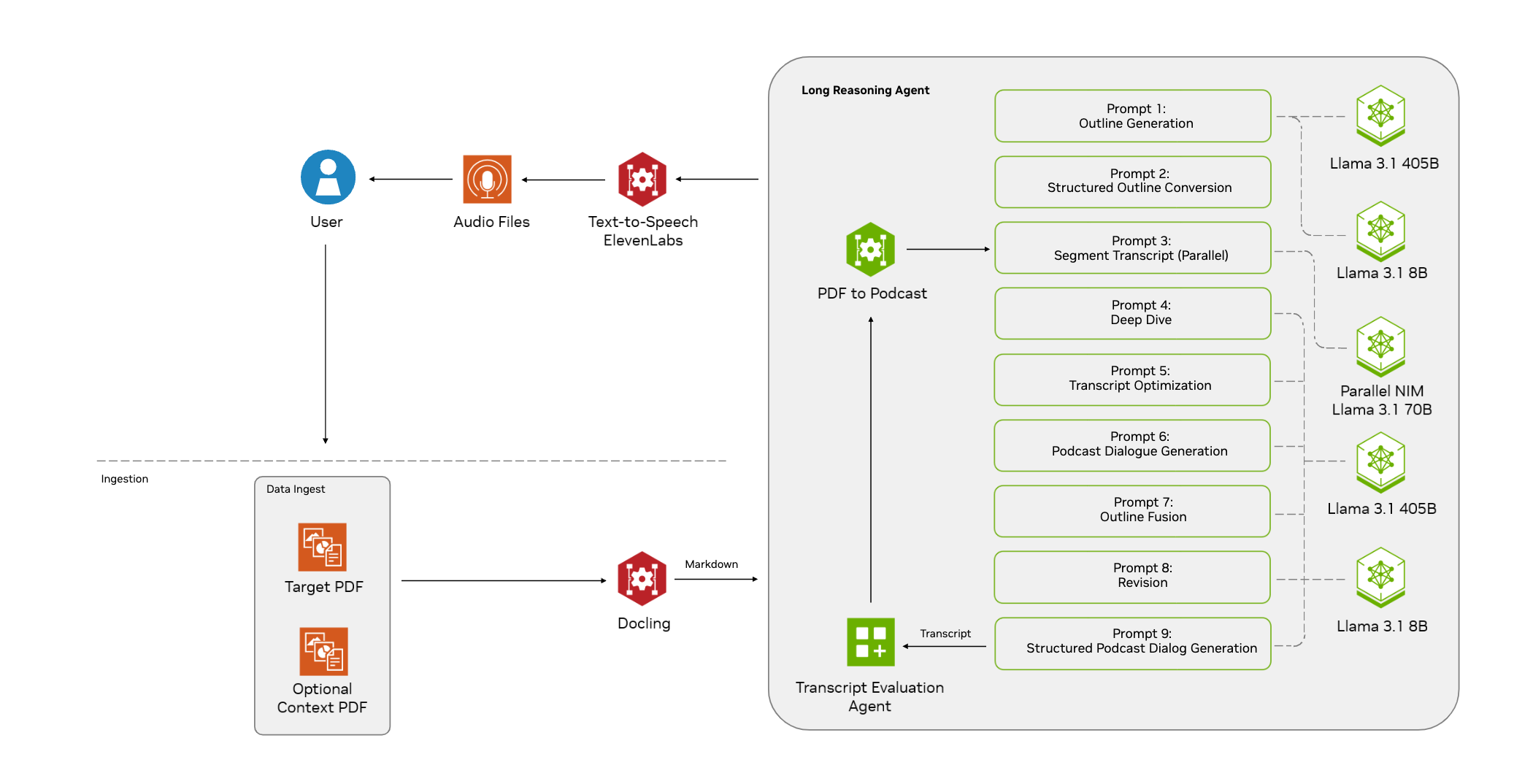

MMAudio是一个开源项目,旨在通过多模态联合训练生成高质量的同步音频。该项目由香港中文大学的程浩基(Ho Kei Cheng)等人开发,主要功能是根据视频和/或文本输入生成同步音频。MMAudio的核心创新在于其多模态联合训练方法,能够在广泛的音视频和音文本数据集上进行训练。此外,同步模块可以将生成的音频与视频帧对齐。该项目目前仍在建设中,但单例推理功能已经可以正常使用,训练代码将陆续添加。openart 站可以搜索相关工作流。

功能列表

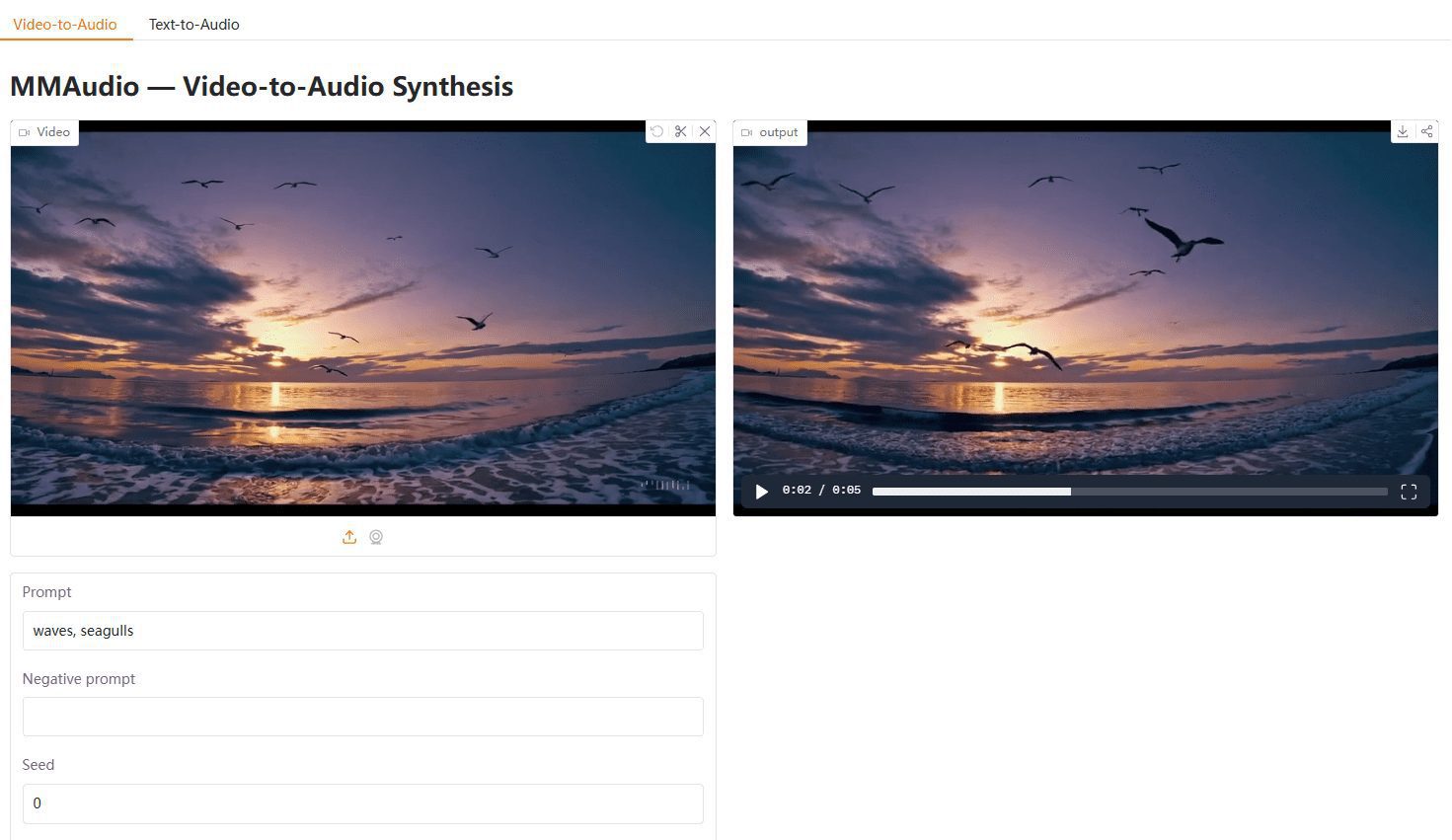

- 视频到音频生成:根据输入的视频生成同步音频。

- 文本到音频生成:根据输入的文本生成音频。

- 多模态联合训练:在音视频和音文本数据集上进行联合训练。

- 同步模块:将生成的音频与视频帧对齐。

- 开源代码:提供完整的开源代码,便于用户进行二次开发。

- 预训练模型:提供多种预训练模型,用户可以直接使用。

- 演示脚本:提供多种演示脚本,方便用户快速上手。

使用帮助

安装流程

- 环境准备:建议使用miniforge环境。确保安装Python 3.9+和PyTorch 2.5.1+及相应的torchvision/torchaudio。

- 安装依赖:运行以下命令安装必要的依赖项:

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118 --upgrade

- 克隆仓库:使用以下命令克隆MMAudio仓库:

git clone https://github.com/hkchengrex/MMAudio.git

- 安装MMAudio:进入MMAudio目录并运行安装命令:

cd MMAudio

pip install -e .

使用方法

- 运行演示脚本:MMAudio提供了多个演示脚本,用户可以通过以下命令运行默认的large_44k模型:

python demo.py

- 输入视频或文本:根据需要输入视频文件或文本,MMAudio将生成相应的同步音频。

- 查看结果:生成的音频将与输入的视频帧同步,用户可以直接查看和使用。

详细功能操作流程

- 视频到音频生成:将视频文件作为输入,运行演示脚本,MMAudio将自动生成与视频同步的音频。

- 文本到音频生成:将文本作为输入,运行相应的脚本,MMAudio将生成对应的音频。

- 多模态联合训练:用户可以根据提供的训练代码,在自己的数据集上进行多模态联合训练,以提升模型的生成效果。

- 同步模块:该模块自动将生成的音频与视频帧对齐,确保音视频同步。

注意事项

- 环境要求:目前仅在Ubuntu系统上进行了测试,其他系统可能需要额外配置。

- 依赖版本:确保安装的依赖版本与项目要求一致,以避免兼容性问题。

- 预训练模型:预训练模型将在运行演示脚本时自动下载,用户也可以手动下载并放置在指定目录。

通过以上步骤,用户可以快速安装和使用MMAudio,生成高质量的同步音频。详细的使用帮助和演示脚本将帮助用户更好地理解和操作该工具。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...