MinerU2.5是什么

MinerU2.5是上海人工智能实验室与北京大学团队联合研发的解耦式视觉语言模型,专注于高效处理高分辨率文档图像解析。核心创新在于采用"先全局版面检测后局部内容识别"的两阶段设计:第一阶段通过低分辨率缩略图快速定位文档结构和阅读顺序,第二阶段对关键区域裁剪后以原生分辨率进行精确识别。模型仅1.2B参数却能在8K文档上保持高精度,实测单卡RTX 4090可达2.12页/秒的处理速度,显著优于同类方案。独特之处还体现在对表格、公式等复杂元素的专项优化,例如通过OTSL中间语言压缩HTML序列长度,以及原子公式分解重组技术解决长公式结构幻觉问题。

MinerU2.5的功能特色

- 高效的两阶段解析架构:采用“先粗后精”的解耦策略:第一阶段对降采样图像进行全局布局分析,快速识别文档中的文本块、表格、公式等结构元素;第二阶段仅在原生分辨率下对高分辨率区域进行细粒度内容识别,有效平衡计算开销与细节保留。

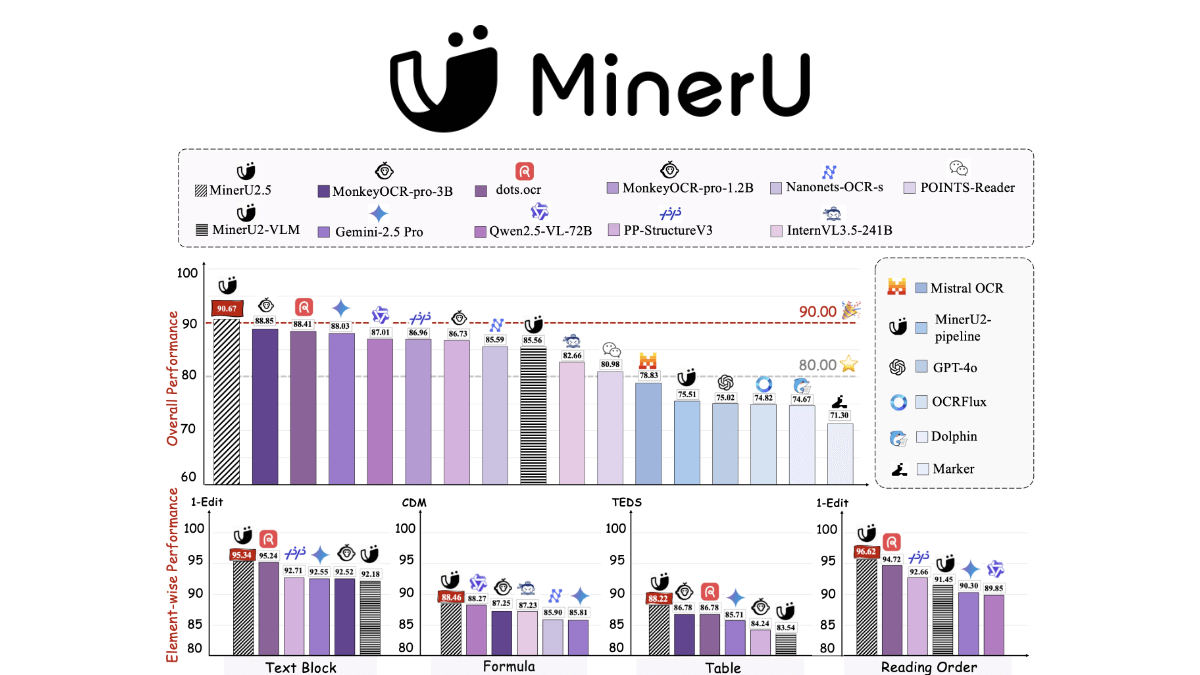

- 卓越的精度与性能表现:尽管参数量仅为 1.2B,但在 OmniDocBench、olmOCR-bench 等多个权威基准测试中,其综合解析精度全面超越了 Gemini 2.5 Pro、GPT-4o、Qwen2.5-VL-72B 等顶级通用多模态大模型,同时也显著领先于 dots.ocr、MonkeyOCR 等专业文档解析工具。

- 强大的复杂场景适应能力:通过多模态融合架构,深度融合文本识别与视觉布局分析,能有效处理表格线缺失、倾斜文本、复杂公式等传统 OCR 失效的场景。其在多栏排版、插图干扰、模糊扭曲及低分辨率扫描件等极端条件下表现稳定,支持中英日韩等 20+ 语言的混排识别。

- 极高的实用性与部署效率:模型小巧,易于集成,在消费级显卡(如 RTX 3090 或 4090)上可实现每秒 1.7 至 2 页的高速解析,非常适合 RAG(检索增强生成)知识库构建、大规模文档提取等实际业务部署需求。

- 全面的任务支持与结构化输出:创新性地将布局分析重构为一项多任务问题,在单次推理中同时预测文档元素的位置、类别、旋转角度和阅读顺序。支持将解析结果输出为 Markdown、JSON 等多种结构化格式,便于后续处理和应用。

MinerU2.5的核心优势

- 先进的两阶段解析架构:采用解耦策略,第一阶段对降采样图像进行高效的全局布局分析,识别文档结构元素;第二阶段则在原生分辨率下对高分辨率区域进行细粒度内容识别,有效平衡了计算开销与细节保留。

- 卓越的性能表现:在OmniDocBench、olmOCR-bench等多个权威基准测试中,其综合解析精度全面超越了Gemini 2.5 Pro、GPT-4o、Qwen2.5-VL-72B等顶级通用多模态大模型,同时也显著领先于dots.ocr、MonkeyOCR、PP-StructureV3等专业文档解析工具。

- 增强的多任务范式:将布局分析重新定义为一项多任务问题,在单次推理中同时预测文档元素的位置、类别、旋转角度和阅读顺序,有效解决了旋转元素解析等复杂挑战。

- 极高的实用性与效率:模型小巧,易于集成,能在消费级显卡上实现每秒1.7页的高速解析,非常适合RAG(检索增强生成)知识库构建、大规模文档提取等实际应用场景。

MinerU2.5官网是什么

- HuggingFace模型库:https://huggingface.co/opendatalab/MinerU2.5-2509-1.2B

- arXiv技术论文:https://arxiv.org/pdf/2509.22186

MinerU2.5的适用人群

- 企业数字化与知识管理团队:适用于需要处理大量合同、报告、档案等纸质文档数字化任务的企业,能高效完成扫描件、PDF等非结构化数据的解析与入库,显著提升RAG(检索增强生成)知识库的构建效率。

- 开发者与AI工程团队:模型完全开源且参数量小(1.2B),支持在消费级显卡(如RTX 4090)上部署,非常适合希望集成高性能OCR能力到自身产品中的开发者和工程团队,无需依赖大型闭源API。

- 研究机构与学术界:为文档理解、多模态大模型等领域的学术研究提供了一个强大的开源基线模型,研究者可基于其进行进一步实验、微调或方法对比。

- 金融、法律与政府机构:需处理大量结构复杂的表格、合同和表单,MinerU2.5在复杂排版和缺失表格线的场景下表现优异,能满足其对高精度、结构化信息提取的严苛需求。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...