综合介绍

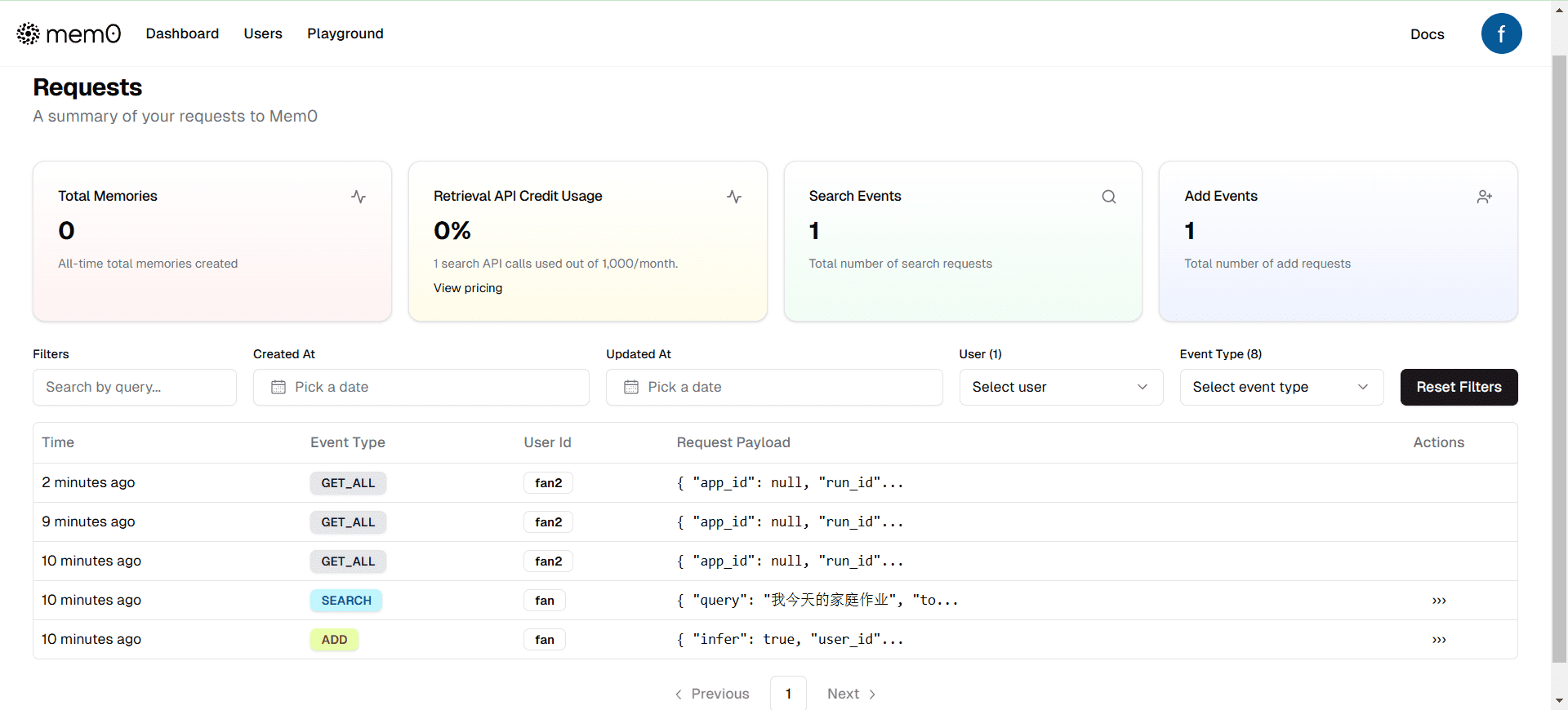

Mem0(发音为“mem-zero”)是一个为AI助手和代理提供智能记忆层的开源项目。它能够记住用户偏好,适应个体需求,并随着时间的推移不断改进,使其成为客户支持聊天机器人、AI助手和自主系统的理想选择。Mem0通过混合数据库方法管理和检索AI代理和助手的长期记忆,确保不同类型的信息以最有效的方式存储,从而使后续搜索快速且有效。

功能列表

- 多层记忆:用户、会话和AI代理记忆保留

- 自适应个性化:基于交互的持续改进

- 开发者友好的API:简单集成到各种应用中

- 跨平台一致性:设备间统一行为

- 托管服务:无忧托管解决方案

使用帮助

安装流程

- 确保已安装Python环境。

- 使用pip安装Mem0:

pip install mem0ai

基本使用

- 初始化Mem0:

from mem0 import Memory m = Memory() - 存储记忆:

result = m.add("我正在提高我的网球技能。建议一些在线课程。", user_id="alice", metadata={"category": "hobbies"}) print(result) - 检索记忆:

all_memories = m.get_all() print(all_memories) - 搜索相关记忆:

related_memories = m.search(query="Alice的爱好是什么?", user_id="alice") print(related_memories) - 更新记忆:

result = m.update(memory_id="m1", data="喜欢在周末打网球") print(result) - 获取记忆历史:

history = m.history(memory_id="m1") print(history)

高级使用

对于生产环境,可以使用Qdrant作为向量存储:

from mem0 import Memory

config = {

"vector_store": {

"provider": "qdrant",

"config": {

"host": "localhost",

"port": 6333,

}

}

}

m = Memory.from_config(config)

支持与社区

- 加入我们的Discord或Slack社区获取支持和讨论。

- 访问文档获取详细的使用说明和API参考。

Mem0的技术原理

Mem0的技术原理主要围绕为大语言模型(LLM)和AI代理提供一个智能、自我改进的记忆层。以下是其核心技术原理的详细介绍:

核心模块

Mem0的技术架构由四个核心模块组成:

- Embeddings:将文本数据转换为向量表示,以便进行高效的相似性搜索和记忆存储。

- LLMs(大语言模型):利用大语言模型生成和处理自然语言文本,提取用户偏好和记忆。

- Memory(记忆管理):管理和存储用户的长期记忆,包括用户偏好、会话历史等。

- Vector Stores(向量存储):使用向量数据库(如Qdrant)存储和检索记忆向量,确保快速高效的查询。

记忆提取与存储

Mem0通过以下步骤实现记忆的提取与存储:

- 数据嵌入:将用户输入的文本数据转换为向量表示。

- 记忆提取:利用预定义的提示(prompts)从文本中提取出有价值的记忆信息,如用户的偏好和事实。

- 记忆存储:将提取的记忆信息存储在向量数据库中,以便后续检索和使用。

自适应学习

Mem0具备自适应学习能力,能够根据用户的交互和反馈不断改进其个性化记忆。具体表现为:

- 上下文连续性:在多个会话中保留信息,确保对话的连续性和一致性。

- 动态更新:根据新的交互和信息动态更新记忆,保持记忆的相关性和准确性。

- 优先级管理:优先考虑最近的交互,并逐渐忘记过时的信息,以提供更准确的响应。

与RAG的对比

相比传统的检索增强生成(RAG)技术,Mem0在以下方面具有优势:

- 实体关系理解:能够理解和关联不同交互中的实体,提供更深刻的上下文理解。

- 实时更新:能够根据新的信息和交互实时更新记忆,而RAG依赖于静态数据。

通过这些技术原理,Mem0能够为AI助手和代理提供一个智能、个性化的记忆层,使其在各种应用中表现出色。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...