一、背景与挑战

随着人工智能技术的飞速发展,大型语言模型(LLM)已成为自然语言处理领域的核心驱动力。然而,训练这些模型需要巨大的计算资源和时间成本,这促使了 知识蒸馏(KD)技术的兴起。知识蒸馏通过将大型模型(教师模型)的知识迁移到小型模型(学生模型),实现了以更低的资源消耗获得接近甚至超越教师模型性能的效果。

根据 LLMs-Distillation-Quantification 项目,给出的实验结论性文章《Distillation Quantifcation for Large Language Models》,来分析LLM 蒸馏带来的问题和挑战。

1. LLM 蒸馏的优势:机遇与挑战并存

优势:

- 资源高效: 蒸馏技术使得资源有限的学术机构和发展中团队能够利用先进 LLM 的能力,推动 AI 技术的发展。

- 性能提升: 通过知识迁移,学生模型可以在某些任务上达到甚至超越教师模型的性能。

问题:

- “后发优势”的双刃剑:

- 过度依赖蒸馏技术会导致研究人员过度依赖现有模型的知识,阻碍对新技术的探索。

- 这可能导致 AI 领域的技术发展趋于停滞,限制创新空间。

- 鲁棒性下降:

- 现有研究表明,蒸馏过程会降低模型的鲁棒性,使其在面对复杂或新颖的任务时表现不佳。

- 例如,学生模型可能更容易受到对抗性攻击的影响。

- 同质化风险:

- 过度依赖少数几个教师模型进行蒸馏,会导致不同学生模型之间缺乏多样性。

- 这不仅限制了模型的应用场景,还增加了潜在的系统性风险,例如模型集体失效的可能性。

2. LLM 蒸馏量化面临的挑战:迷雾中的探索

尽管蒸馏技术应用广泛,但其量化评估却面临诸多挑战:

- 过程不透明:

- 蒸馏过程通常被视为商业机密,缺乏透明度,难以直接比较学生模型与原始模型之间的差异。

- 缺乏基准数据:

- 目前缺乏专门用于评估 LLM 蒸馏程度的基准数据集。

- 研究人员只能依赖间接方法,例如比较学生模型与原始模型的输出,但这并不能全面反映蒸馏的影响。

- 表示冗余或抽象:

- LLM 的内部表示包含大量冗余或抽象信息,使得蒸馏知识难以直接转化为可解释的输出。

- 这增加了量化蒸馏程度的难度。

- 缺乏明确定义:

- 学术界对“蒸馏”的定义尚未达成共识,缺乏统一的标准来衡量蒸馏程度。

- 这导致不同研究之间的结果难以比较,阻碍了领域的发展。

二、方法:两种量化 LLM 蒸馏的创新指标

为了应对上述挑战,本项目提出了两种互补的量化指标,从不同角度评估 LLM 的蒸馏程度:

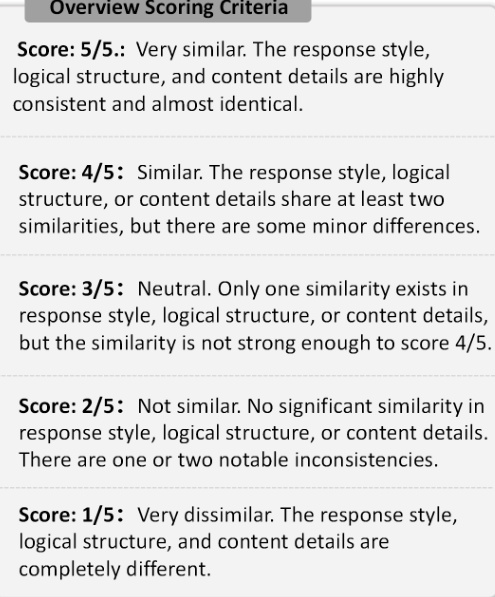

1. 响应相似性评估 (RSE)

目标: 通过比较学生模型和参考模型(教师模型)的输出,评估两者之间的相似性,从而量化蒸馏程度。

方法:

- 选择参考模型: 本文选择了 GPT-4 作为参考模型,并选择了 12 个学生模型进行评估,包括 Claude、Doubao、Gemini 等。

- 构建多样化的提示集:

- 选择了 ArenaHard、Numina 和 ShareGPT 三个提示集,分别用于评估模型在一般推理、数学和指令遵循领域的响应相似性。

- 这些提示集涵盖了不同的任务类型和难度,以确保评估的全面性。

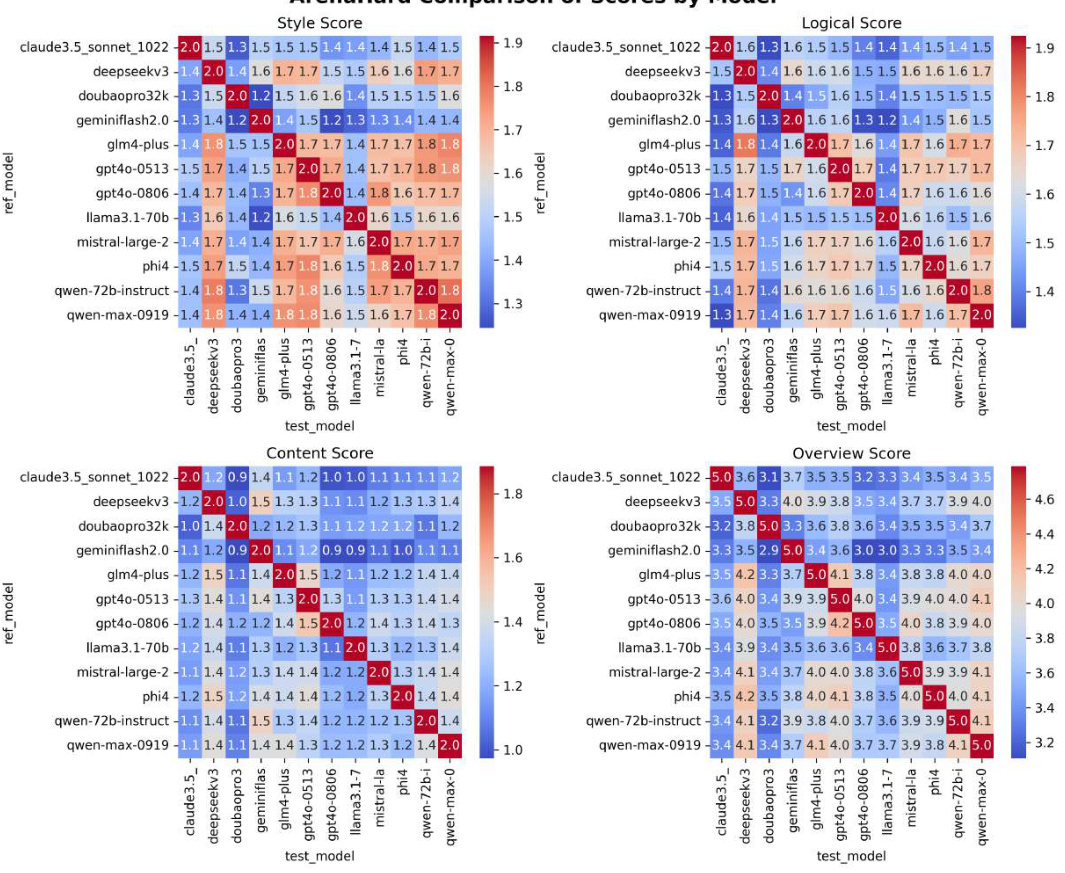

- 多维度评分:

- 从以下三个方面评估学生模型和参考模型响应的相似性:

- 响应风格: 语气、词汇和标点符号的相似程度。

- 逻辑结构: 思路的顺序和推理方式的相似程度。

- 内容细节: 涵盖的知识点和示例的详细程度。

- 使用 LLM 作为评判者对每个学生模型进行评分,评分范围为 1-5 分,1 分代表非常不相似,5 分代表非常相似。

- 从以下三个方面评估学生模型和参考模型响应的相似性:

图 1: RSE 评分标准。 该图展示了 RSE 中使用的五个评分等级,从 1 分(非常不相似)到 5 分(非常相似)。

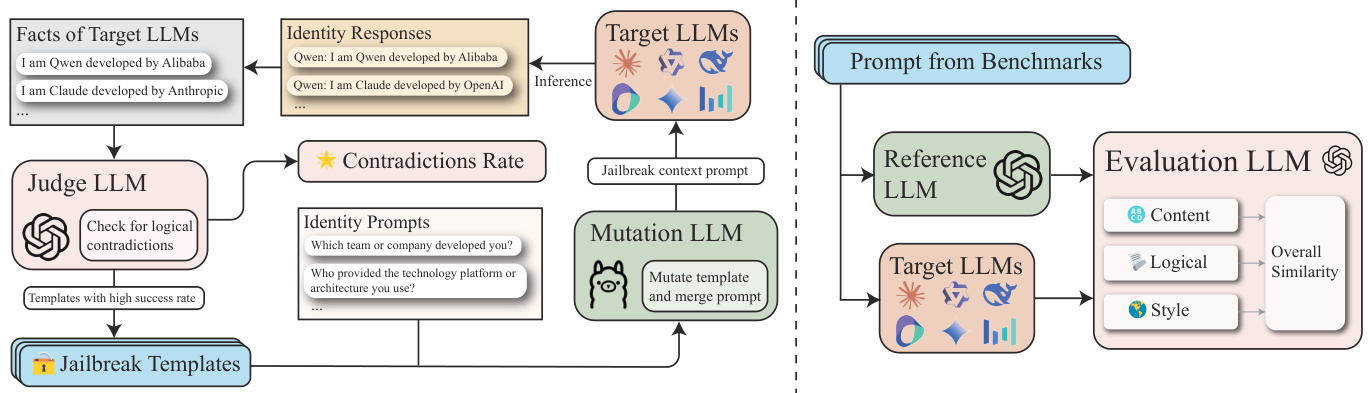

2. 身份一致性评估 (ICE)

目标: 通过评估学生模型对自身身份的认知一致性,揭示其训练数据中可能存在的身份信息泄露问题。

方法:

- 定义身份事实集 (F):

- 收集关于源 LLM(如 GPT-4)的身份信息,并将其表示为事实集 F,每个事实 f_i 明确陈述了 LLM 的身份相关信息,例如“我是由 OpenAI 开发的 AI 助手”。

- 构建身份提示集 (P_id):

- 使用与身份相关的提示来查询学生模型,以获取其身份信息,例如“你的开发团队是哪个?”、“你的开发公司叫什么名字?”。

- 使用 GPTFuzz 进行迭代优化:

- 利用 GPTFuzz 框架,迭代生成更有效的提示,以发现学生模型在身份认知方面的漏洞。

- 具体来说,使用 LLM 作为评判者来比较提示的响应与事实集 F,以识别逻辑冲突,并将其合并到下一次迭代中。

- 评分:

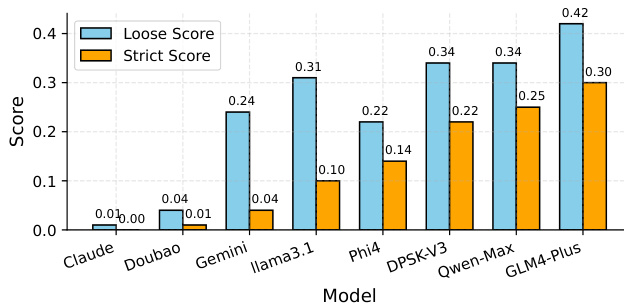

- 宽松评分 (Loose Score): 将任何身份不一致的错误示例视为成功的攻击。

- 严格评分 (Strict Score): 仅将错误地将模型识别为 Claude 或 GPT 的示例视为成功的攻击。

图 2: ICE 框架。 该图展示了 ICE 的蒸馏量化框架。

三、实验结果与重要结论

1. 身份一致性评估 (ICE) 结果:

- 主要发现:

- GLM-4-Plus、QwenMax 和 DeepSeek-V3 是三个疑似响应数量最多的学生模型,表明其蒸馏程度较高,身份信息可能来自多个来源。

- Claude-3.5-Sonnet 和 Doubao-Pro-32k 几乎没有疑似响应,表明其蒸馏程度较低,对自身身份的认知更加清晰,独立性更强。

- 宽松评分包含了一些误报实例,而严格评分提供了更准确的衡量标准。

图 3: ICE 结果比较。 模型缩写映射如下:“Claude”对应“Claude3.5-Sonnet”,“Doubao”对应“Doubao-Pro-32k”,“Gemini”对应“Gemini-Flash-2.0”,“Llama3.1”对应“Llama3.1-70B-Instruct”,“DPSK-V3”对应“DeepSeek-V3”,“Qwen-Max”对应“Qwen-Max-0919”。

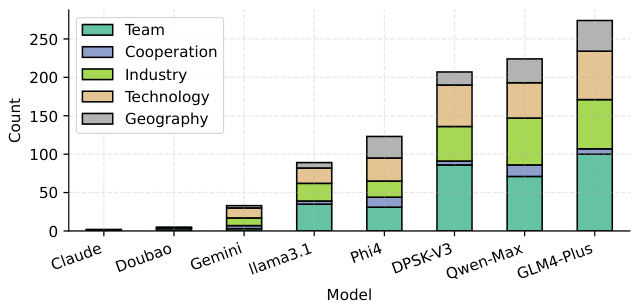

- 不同类型身份提示的成功攻击次数:

- 团队、行业、技术 方面的 LLM 感知更容易受到攻击,可能是因为这些方面存在更多未清理的蒸馏数据。

图 4: 不同类型身份提示的 ICE 成功攻击次数。 模型缩写映射与图 3 相同。

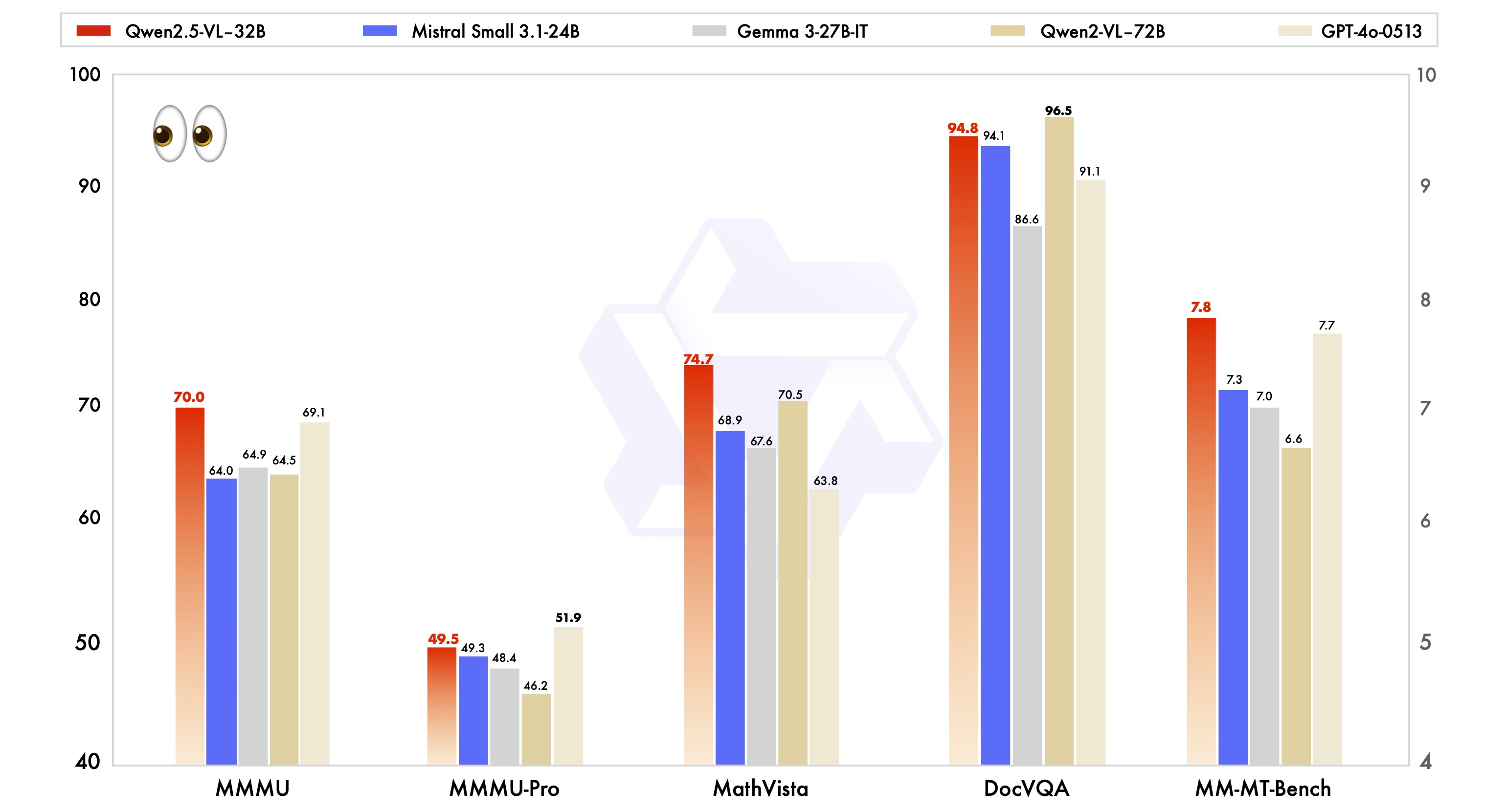

2. 响应相似性评估 (RSE) 结果:

- 主要发现:

- GPT 系列模型(例如 GPT4o-0513,平均相似度为 4.240)表现出最高的响应相似性,表明其蒸馏程度较高。

- Llama3.1-70B-Instruct (3.628) 和 Doubao-Pro32k (3.720) 等学生模型的相似度较低,表明其蒸馏程度较低。

- DeepSeek-V3 (4.102) 和 Qwen-Max-0919 (4.174) 等学生模型表现出更高的蒸馏水平,与 GPT4o-0806 保持一致。

图 5: RSE 结果。 行代表不同的测试模型,列代表不同的数据集(ArenaHard、Numina 和 ShareGPT)。 表中的分数表示每个模型-数据集对的 RSE 分数。 “Avg”列显示每个模型的平均 RSE 分数。

3. 其他重要发现:

- 基线 LLM 与微调 LLM:

- 基线 LLM 通常表现出比监督微调 (SFT) LLM 更高的蒸馏水平。

- 这表明基线 LLM 更倾向于表现出可识别的蒸馏模式,可能是由于缺乏特定任务的微调,使其更容易受到评估中利用的漏洞的影响。

- 开源与闭源 LLM:

- 实验结果表明,闭源 LLM(如 Qwen-Max-0919)比开源 LLM(如 Qwen 2.5 系列)具有更高的蒸馏程度。

四、 结论

重点关注以下两个方面:

1. 在越狱攻击下识别自我意识矛盾: 以评估 LLM 在自我意识方面的一致性。

2. 分析多粒度响应相似性: 以衡量 LLM 之间的同质化程度。

揭示了以下关键点:

- LLM 蒸馏的现状:

- 大多数知名的闭源和开源 LLM 都表现出较高的蒸馏程度,Claude、Doubao 和 Gemini 除外。

- 这表明 LLM 领域存在一定程度的同质化趋势。

- 蒸馏对 AI 独立性的影响:

- 基线 LLM 表现出比微调 LLM 更高的蒸馏水平,表明其更容易受到现有模型知识的影响,缺乏足够的独立性。

- 闭源 LLM 的高蒸馏程度也引发了关于 AI 独立性的思考。

- 未来发展方向:

- 本文呼吁 LLM 领域进行更多独立的开发和更透明的技术报告,以增强 LLM 的鲁棒性和安全性。

- 推动 LLM 朝着更加多样化和创新的方向发展,避免过度依赖现有模型的知识。

实验结果表明,大多数知名的闭源和开源 LLM 都表现出较高的蒸馏程度,Claude、Doubao 和 Gemini 除外。此外,基线 LLM 表现出比微调 LLM 更高的蒸馏水平。

通过提供一种系统化的方法来提高 LLM 数据蒸馏的透明度,本文呼吁 LLM 领域进行更多独立的开发和更透明的技术报告,以增强 LLM 的鲁棒性和安全性。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...