综合介绍

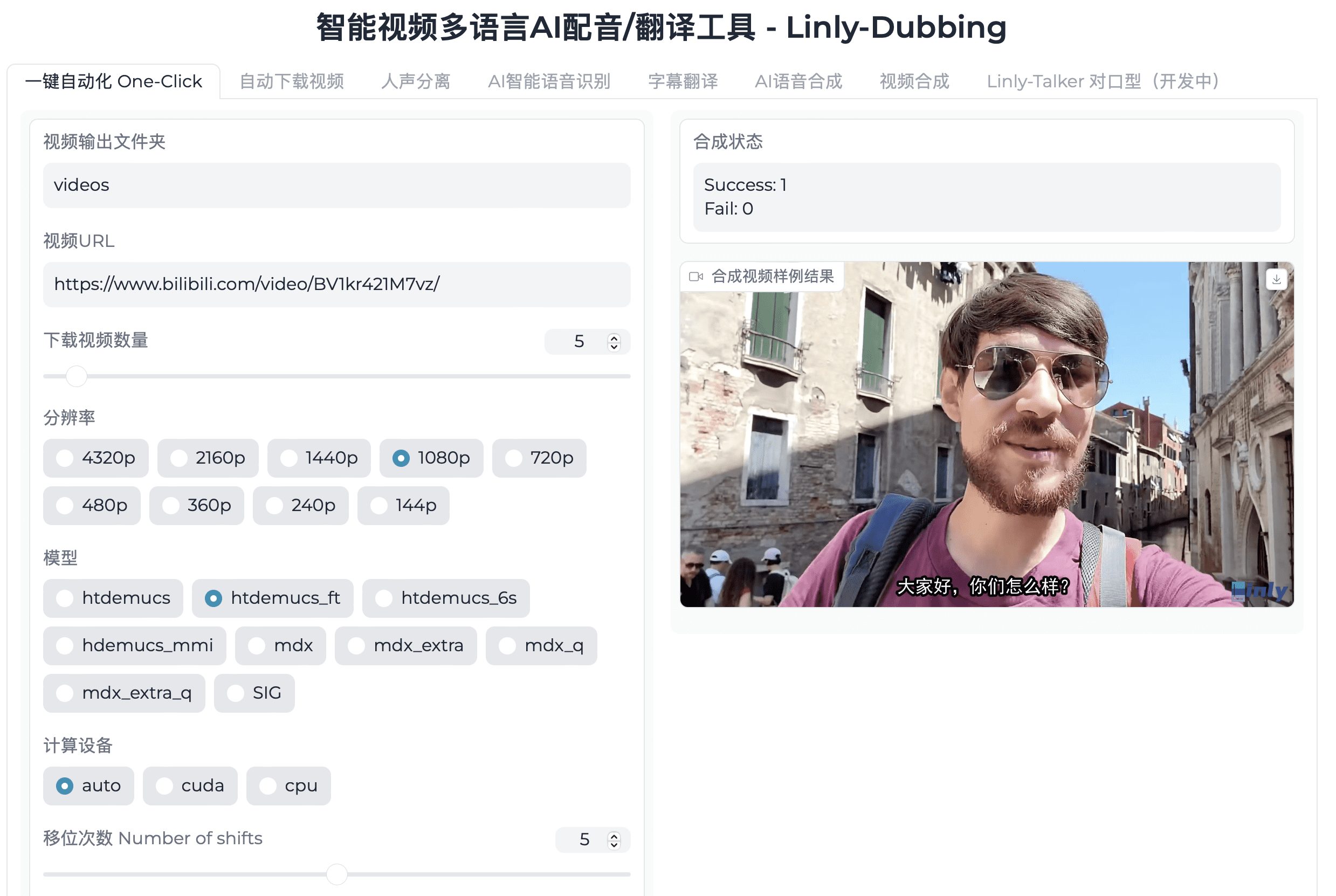

Linly-Dubbing 是一个智能多语言AI配音和翻译工具,旨在通过整合先进的AI技术,为用户提供高质量的多语言视频配音和字幕翻译服务。该工具特别适用于国际教育、全球内容本地化等场景,帮助团队将优质内容传播到全球各地。

功能列表

- 多语言支持:提供中文及多种其他语言的配音和字幕翻译,满足全球化需求。

- AI语音识别:采用先进的AI技术进行语音到文本转换和说话人识别。

- 大语言模型翻译:结合领先的语言模型(如GPT),快速且准确地进行翻译,确保专业性和自然性。

- AI语音克隆:利用尖端的语音克隆技术,生成与原视频配音高度相似的语音,保持情感和语调的连贯性。

- 数字人对口型技术:通过对口型技术,使配音与视频画面高度契合,提升真实感和互动性。

- 灵活上传与翻译:用户可以上传视频,自主选择翻译语言和标准,确保个性化和灵活性。

- 定期更新:持续引入最新模型,保持配音和翻译的领先地位。

使用帮助

安装流程

- 克隆仓库:首先,将 Linly-Dubbing 仓库克隆到本地机器,并初始化子模块。

git clone https://github.com/Kedreamix/Linly-Dubbing.git --depth 1 cd Linly-Dubbing git submodule update --init --recursive - 安装依赖:创建新的 Python 环境并安装所需依赖。

conda create -n linly_dubbing python=3.10 -y conda activate linly_dubbing cd Linly-Dubbing/ conda install ffmpeg==7.0.2 -c conda-forge python -m pip install --upgrade pip pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple pip install torch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 --index-url https://download.pytorch.org/whl/cu118 pip install -r requirements.txt pip install -r requirements_module.txt - 配置环境变量:在项目根目录下创建 .env 文件,并填写必要的环境变量。

OPENAI_API_KEY=sk-xxx MODEL_NAME=gpt-4 HF_TOKEN=your_hugging_face_token - 运行应用程序:下载所需模型并启动 WebUI 界面。

bash scripts/download_models.sh python webui.py

使用流程

- 上传视频:用户可以通过 WebUI 界面上传需要配音或翻译的视频文件。

- 选择语言和标准:在上传视频后,用户可以选择需要翻译的语言和配音标准。

- 生成配音和字幕:系统将自动进行语音识别、翻译和配音生成,并同步生成字幕文件。

- 下载结果:用户可以下载生成的配音视频和字幕文件,进行后续编辑和使用。

主要功能操作

- 自动视频下载:使用 yt-dlp 工具下载视频和音频,支持多种格式和分辨率选择。

- 人声分离:采用 Demucs 和 UVR5 技术进行人声和伴奏分离,生成高质量的伴奏和人声提取。

- AI语音识别:使用 WhisperX 和 FunASR 进行精准的语音识别和字幕生成,支持多说话人识别。

- 大语言模型翻译:结合 OpenAI API 和 Qwen 模型进行高质量的多语言翻译。

- AI语音合成:利用 Edge TTS 和 CosyVoice 生成自然流畅的语音输出,支持多种语言和语音风格。

- 视频处理:提供字幕添加、背景音乐插入、音量调整和播放速度修改等功能,个性化定制视频内容。

- 数字人对口型技术:通过 Linly-Talker 技术,实现数字人对口型同步,提升视频的专业性和观赏体验。

Linly-Dubbing一键安装包

夸克:https://pan.quark.cn/s/f526eb488113

度盘:https://pan.baidu.com/s/1aapXpIc7qwO5h5sDzF9dLA?pwd=np7w

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

Related posts

暂无评论...