Jina AI 发布了 Reader-LM-0.5B 和 Reader-LM-1.5B 两个小型语言模型,旨在将开放网络中的原始、嘈杂的 HTML 转换为干净的 Markdown 格式,这两个模型支持长达 256K 个标记的上下文长度,并在转换任务上表现出与大型语言模型相当甚至更优的性能。

前言

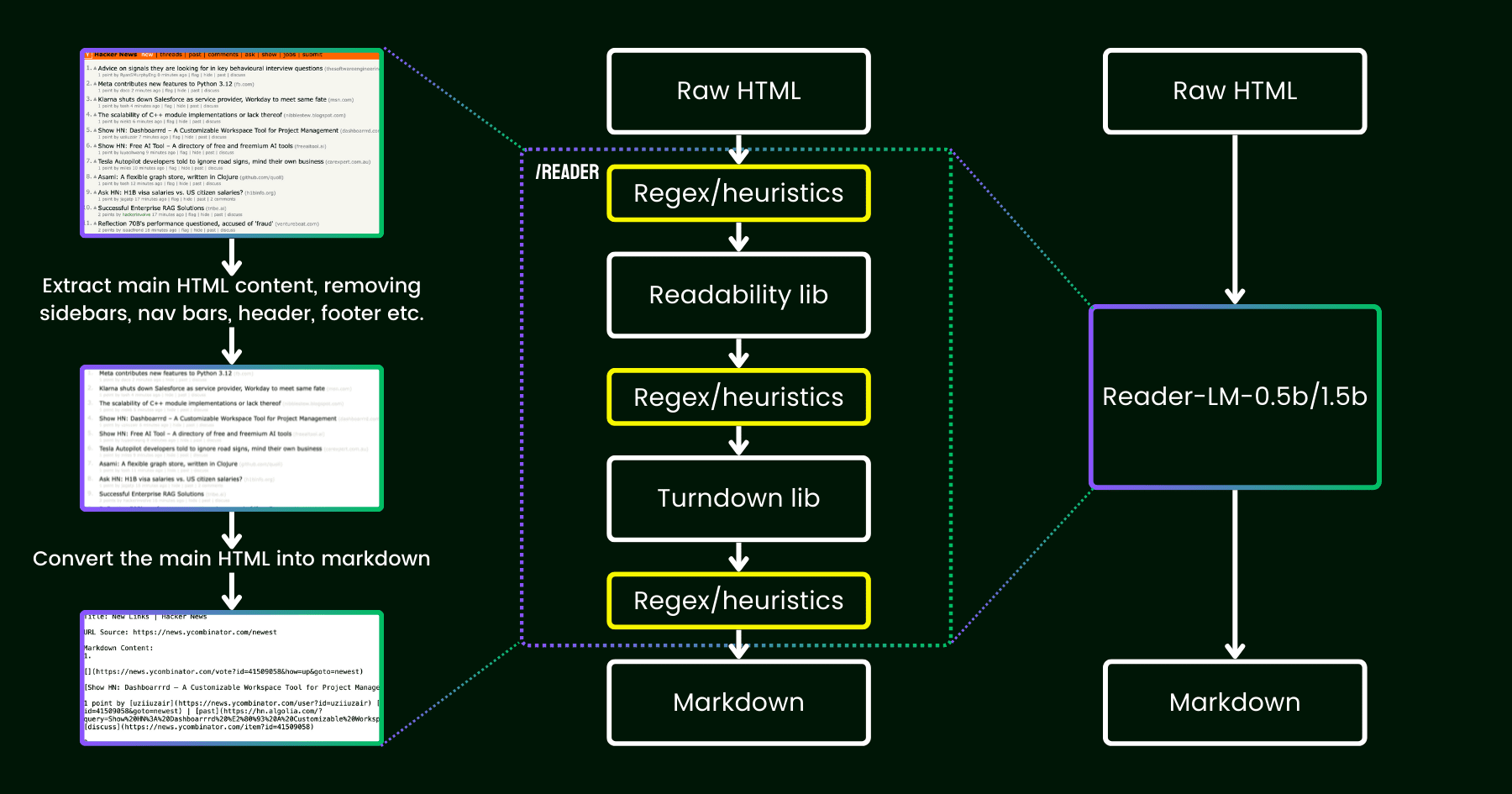

Jina AI 在 2024 年 4 月发布了 Jina Reader,一个可以将任何 URL 转换为 LLM 友好的 markdown 的简单 API。该 API 使用无头 Chrome 浏览器获取网页源代码,利用 Mozilla 的 Readability 包提取主要内容,并使用 regex 和 Turndown 库将清理后的 HTML 转换为 markdown。

在发布后,用户反馈指出内容质量存在问题,Jina AI 通过修补现有管道解决了这些问题。

从那时起,我们一直在思考一个问题:与其用更多的启发式方法和正则表达式来修补(这变得越来越难以维护,并且不利于多语言),我们能否用一个语言模型来端到端解决这个问题?

插图说明reader-lm,用一个小型语言模型替换了可读性+turndown+regex 启发式方法的管道。

关于Reader-LM

2024 年 9 月 11 日 —— 在持续推动人工智能在内容处理和文本转换领域的创新后,Jina AI 今日宣布推出其最新的技术成果 ——Reader-LM-0.5B 和 Reader-LM-1.5B 两款小型语言模型。这两款模型标志着开放网络中原始 HTML 内容处理的一个新纪元,它们能够高效地将复杂的 HTML 转换成结构化的 Markdown 格式,为大数据时代的内容管理和机器学习应用提供了强大的支持。

突破性的性能与效率

Reader-LM-0.5B 和 Reader-LM-1.5B 模型在保持参数规模紧凑的同时,实现了与大型语言模型相当甚至更优的性能。这两款模型支持长达 256K 个标记的上下文长度,能够处理现代 HTML 中的内联 CSS、脚本等嘈杂元素,生成干净、结构良好的 Markdown 文件。这对于需要从原始网页内容中提取和转换文本的用户来说,是一个巨大的便利。

用户友好的实践体验

Jina AI 提供了一个在 Google Colab(0.5B和1.5B) 笔记,使得用户可以轻松体验 Reader-LM 模型的强大功能。无论是加载不同版本的模型、更改处理的网站 URL,还是探索输出结果,用户都能够在一个免费的、基于云的环境中进行。此外,Reader-LM 将很快在 Azure 和 AWS 市场上市,为企业用户提供了更多的集成和部署选项。

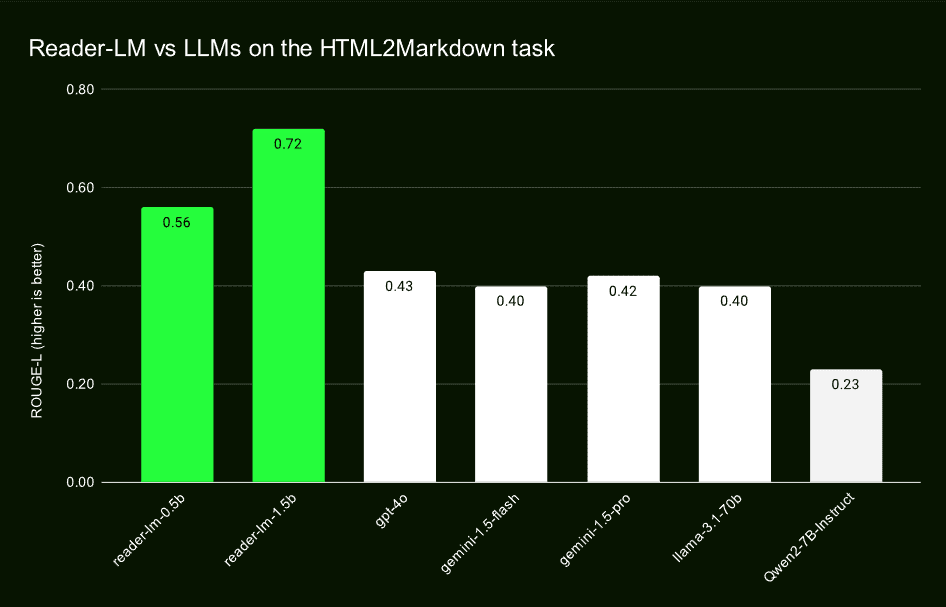

超越传统模型的表现

通过与 GPT-4o、Gemini-1.5-Flash、Gemini-1.5-Pro、LLaMA-3.1-70B 和 Qwen2-7B-Instruct 等大型语言模型的对比测试,Reader-LM 在 ROUGE-L、Word Error Rate (WER) 和 Token Error Rate (TER) 等关键指标上表现出色。这些评估结果证明了 Reader-LM 在准确性、召回率和生成干净 Markdown 的能力方面的领先地位。

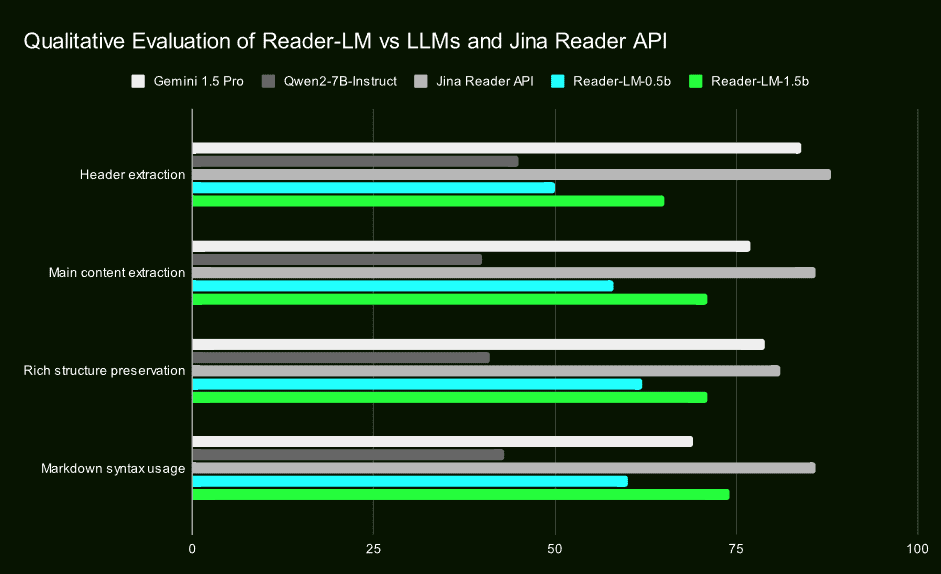

定性研究证实其优势

除了定量评估外,Jina AI 还通过视觉检查输出 Markdown 的定性研究,确认了 Reader-LM 在标题提取、主要内容提取、结构保留和 Markdown 语法使用等方面的卓越表现。这些研究结果强调了 Reader-LM 在实际应用中的高效性和可靠性。

两阶段训练的创新方法

Jina AI 透露了他们训练 Reader-LM 的详细过程,包括数据准备、两阶段训练、以及如何克服模型退化和循环问题。他们强调了训练数据质量的重要性,并通过对比搜索和重复停止标准等技术手段,确保了模型的稳定性和生成质量。

最后

Jina AI 的 Reader-LM 不仅是小型语言模型领域的一个重大突破,也是对开放网络内容处理能力的一次显著提升。这两款模型的发布,不仅为开发者和数据科学家提供了一个高效、易于使用的工具,也为 AI 在内容提取、清洗和转换方面的应用开辟了新的可能性。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...