综合介绍

Xorbits Inference(简称Xinference)是一个强大且多功能的库,专注于为语言模型、语音识别模型和多模态模型提供分布式部署和服务。通过Xorbits Inference,用户可以轻松部署和服务自己的模型或内置的先进模型,只需一条命令即可完成。无论是在云端、本地服务器,还是在个人电脑上,Xorbits Inference都能高效运行。该库特别适合研究人员、开发者和数据科学家,帮助他们充分发挥前沿AI模型的潜力。

功能列表

- 分布式部署:支持分布式部署场景,允许在多个设备或机器上无缝分布模型推理任务。

- 模型服务:简化大型语言模型、语音识别模型和多模态模型的服务过程。

- 单命令部署:通过单条命令即可部署和服务模型,适用于实验和生产环境。

- 异构硬件利用:智能利用包括GPU和CPU在内的异构硬件,加速模型推理任务。

- 灵活的API和接口:提供多种接口与模型交互,支持RPC、RESTful API(兼容OpenAI API)、CLI和WebUI。

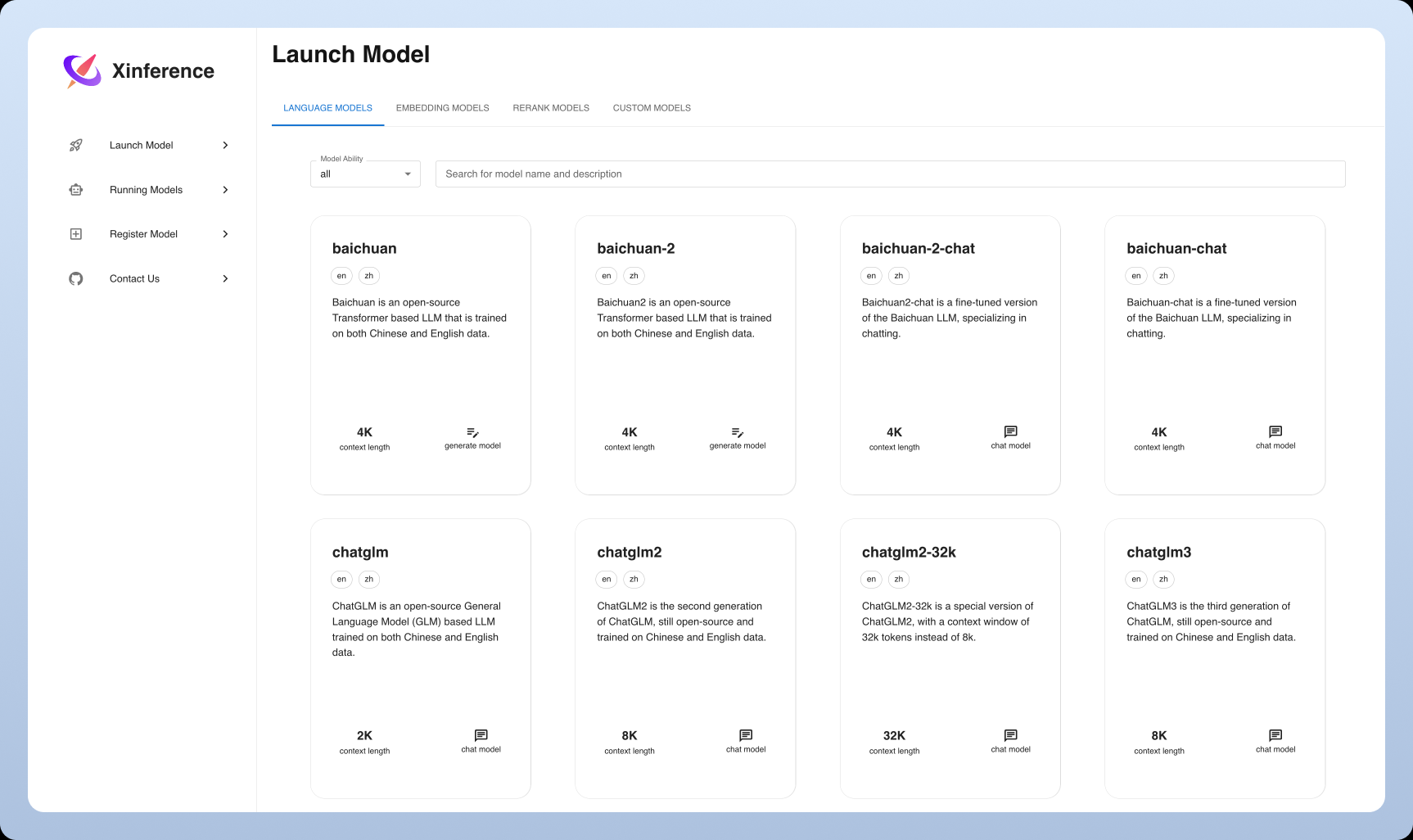

- 内置先进模型:内置支持多种前沿开源模型,用户可以直接使用这些模型进行实验。

使用帮助

安装流程

- 环境准备:确保已安装Python 3.7或更高版本。

- 安装Xorbits Inference:

pip install xorbits-inference

- 验证安装:安装完成后,可以通过以下命令验证安装是否成功:

xinference --version

使用指南

部署模型

- 加载模型:使用以下命令加载预训练模型:

xinference load-model --model-name <模型名称>

示例:

xinference load-model --model-name gpt-3

- 启动服务:加载模型后,启动服务:

xinference serve --model-name <模型名称>

示例:

xinference serve --model-name gpt-3

- 调用API:服务启动后,可以通过RESTful API进行调用:

curl -X POST http://localhost:8000/predict -d '{"input": "你好"}'

使用内置模型

Xorbits Inference内置支持多种先进模型,用户可以直接使用这些模型进行实验。例如:

- 语言模型:如GPT-3、BERT等。

- 语音识别模型:如DeepSpeech等。

- 多模态模型:如CLIP等。

分布式部署

Xorbits Inference支持分布式部署,用户可以在多个设备或机器上无缝分布模型推理任务。具体步骤如下:

- 配置分布式环境:在每个节点上安装Xorbits Inference,并配置网络连接。

- 启动分布式服务:在主节点上启动分布式服务:

xinference serve --distributed --nodes <节点列表>

示例:

xinference serve --distributed --nodes "node1,node2,node3"

- 调用分布式API:与单节点部署类似,通过RESTful API进行调用:

curl -X POST http://<主节点IP>:8000/predict -d '{"input": "你好"}'

常见问题

- 如何更新模型? 使用以下命令更新模型:

xinference update-model --model-name <模型名称>

- 如何查看日志? 使用以下命令查看服务日志:

xinference logs --model-name <模型名称>© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...