近期,大型语言模型领域,强化学习在训练后期的新范式日益受到业界关注。继 OpenAI 推出 GPT-4o 等 O 系列模型,以及 DeepSeek-R1 的发布,模型的出色表现证明了强化学习在优化过程中的关键作用。

腾讯混元大模型团队近期也取得了重大进展。今年 2 月中旬,该团队在腾讯元宝 APP 上推出了基于中等规模混元底座的混元 T1-Preview 推理模型。现在,混元大模型系列的深度思考模型已升级到混元-T1 正式版。

体验地址:

https://llm.hunyuan.tencent.com/#/chat/hy-t1

https://huggingface.co/spaces/tencent/Hunyuan-T1

混元-T1 基于 3 月初发布的 TurboS 快速思考底座。TurboS 是全球首个超大规模混合专家模型(MoE),融合了 Transformer 和 Mamba 架构。通过大规模的后期训练,混元-T1 的推理能力得到了显著扩展,并且更好地与人类偏好对齐。

混元-T1 在深度推理方面具有独特的优势。首先,TurboS 的长文本捕获能力有助于有效解决长文本推理中常见的上下文丢失和远距离信息依赖问题。其次,Mamba 架构专门优化了长序列的处理能力,通过高效的计算方法,在确保捕获长文本信息能力的同时,显著降低了计算资源消耗。在相同的部署条件下,解码速度提升了 2 倍。

在模型的后期训练阶段,计算资源的 96.7% 投入到了强化学习训练中,重点是提高纯粹的推理能力,并优化与人类偏好的对齐。

为了实现这一目标,研究团队收集了涵盖数学、逻辑推理、科学、代码等领域的世界级科学和推理问题。这些数据集覆盖了从基础数学推理到复杂科学问题解决的各种任务。结合真实的反馈(ground-truth),确保模型在面对各种推理任务时都能表现出色。

训练采用了课程学习(curriculum learning)方法,逐步增加数据难度,同时逐步扩展模型的上下文长度,使模型在提高推理能力的同时,学习有效地利用 token 进行推理。

在训练策略方面,借鉴了经典强化学习策略,如数据回放(data replay)和定期策略重置(periodic policy resetting),将模型训练的长期稳定性提高了 50% 以上。在与人类偏好对齐阶段,采用了统一的奖励系统反馈方案,包括自我奖励(self-rewarding,基于早期版本的 T1-Preview 对模型输出进行综合评估和评分)和奖励模式,指导模型自我改进。模型在响应中展现出更丰富的内容细节和更高效的信息。

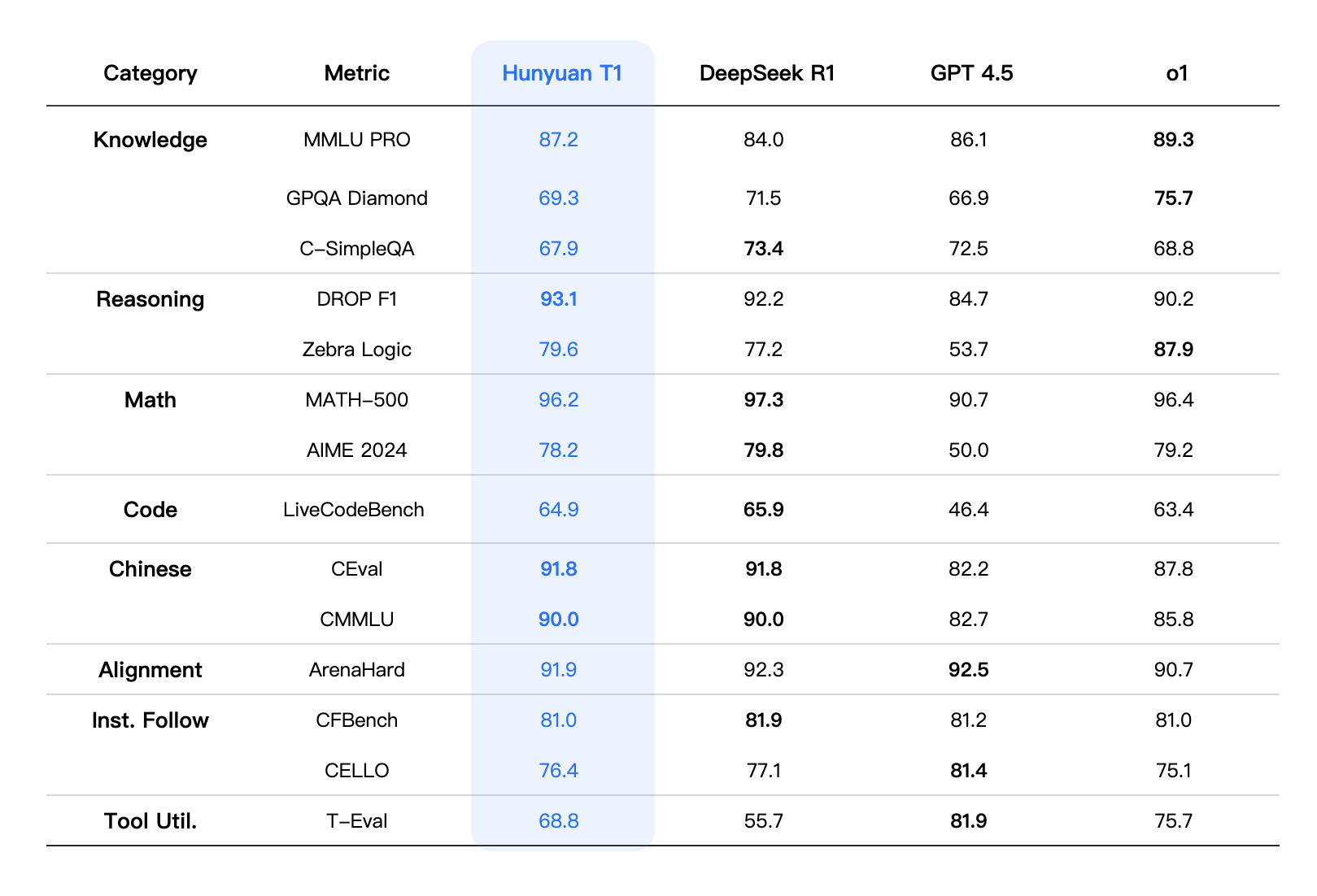

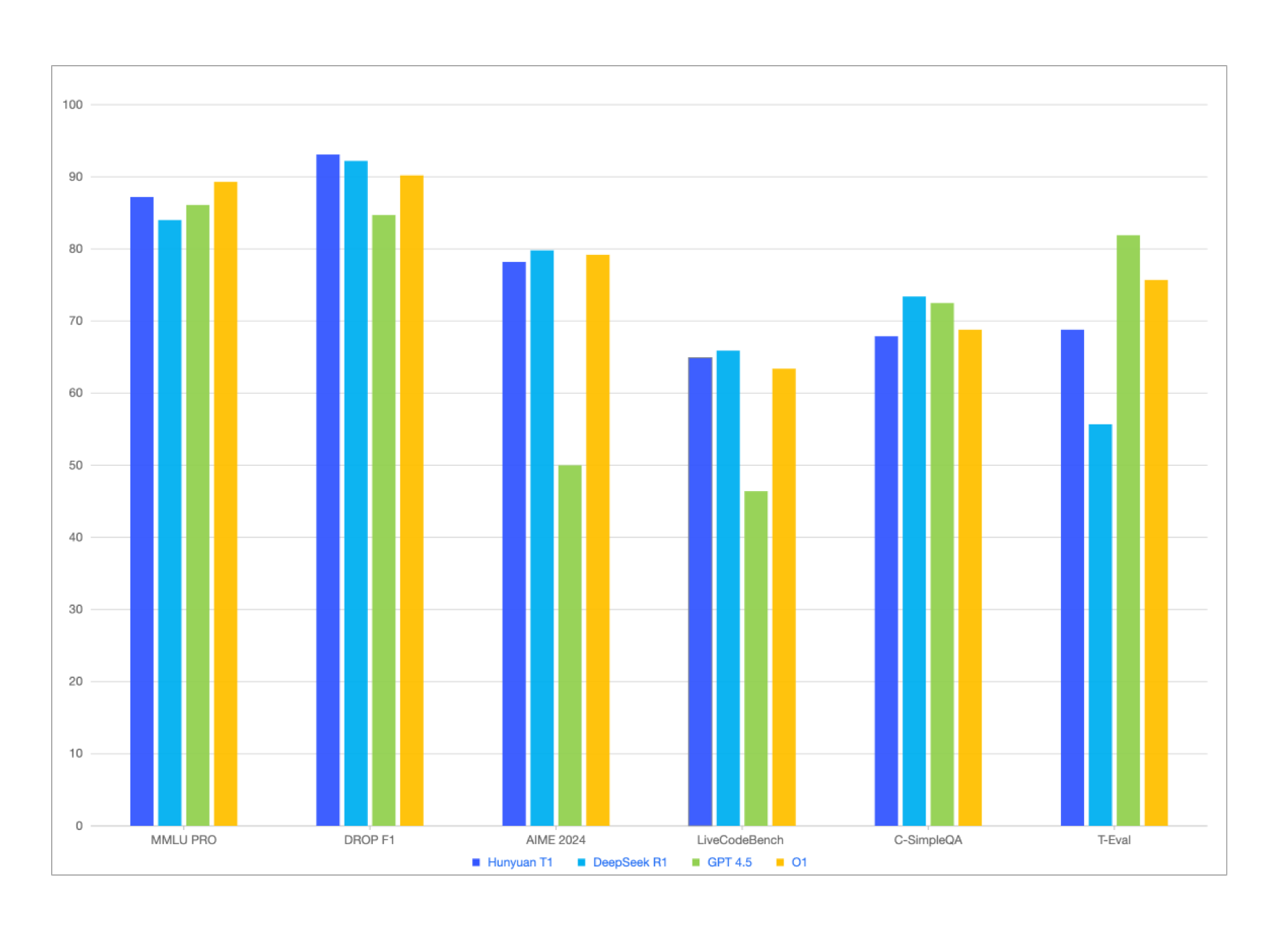

除了在 MMLU-pro、CEval、AIME、Zebra Logic 等中英文知识、竞赛级数学和逻辑推理等公开基准测试上取得与 DeepSeek-R1 相当或略优的结果外,混元-T1 在内部人类评估数据集上也表现出色,在文化创意指令跟随、文本摘要和智能体能力方面略有优势。

从综合评估指标来看,混元-T1 的整体性能可以与一流的前沿推理模型相媲美。在综合能力评估中,T1 在 MMLU-PRO 上仅次于O1,获得了 87.2 的高分。该测试集涵盖了人文、社会科学、科学与工程等 14 个领域的问题,主要测试模型对广泛知识的记忆和理解。此外,在专注于专业领域知识和复杂科学推理的 GPQA-diamond(主要包括物理、化学和生物学领域的博士级难题)上,T1 取得了 69.3 的分数。

在科学与工程领域,测试了需要强大推理能力的场景,如编码、数学和逻辑推理。在 LiveCodeBench 的代码评估中,T1 达到了 64.9 分。同时,T1 在数学方面也表现出色。特别是在 MATH-500 上,它取得了 96.2 的优异成绩,紧随 DeepSeek-R1,展示了 T1 在解决数学问题方面的综合能力。此外,T1 在多个对齐任务、指令跟随任务和工具利用任务中表现出很强的适应性。例如,T1 在 ArenaHard 任务中获得了 91.9 的分数。

模型效果

注:表中其他模型的评估指标来自官方评估结果。对于官方评估结果中未包含的部分,数据来源于混元内部评估平台。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...