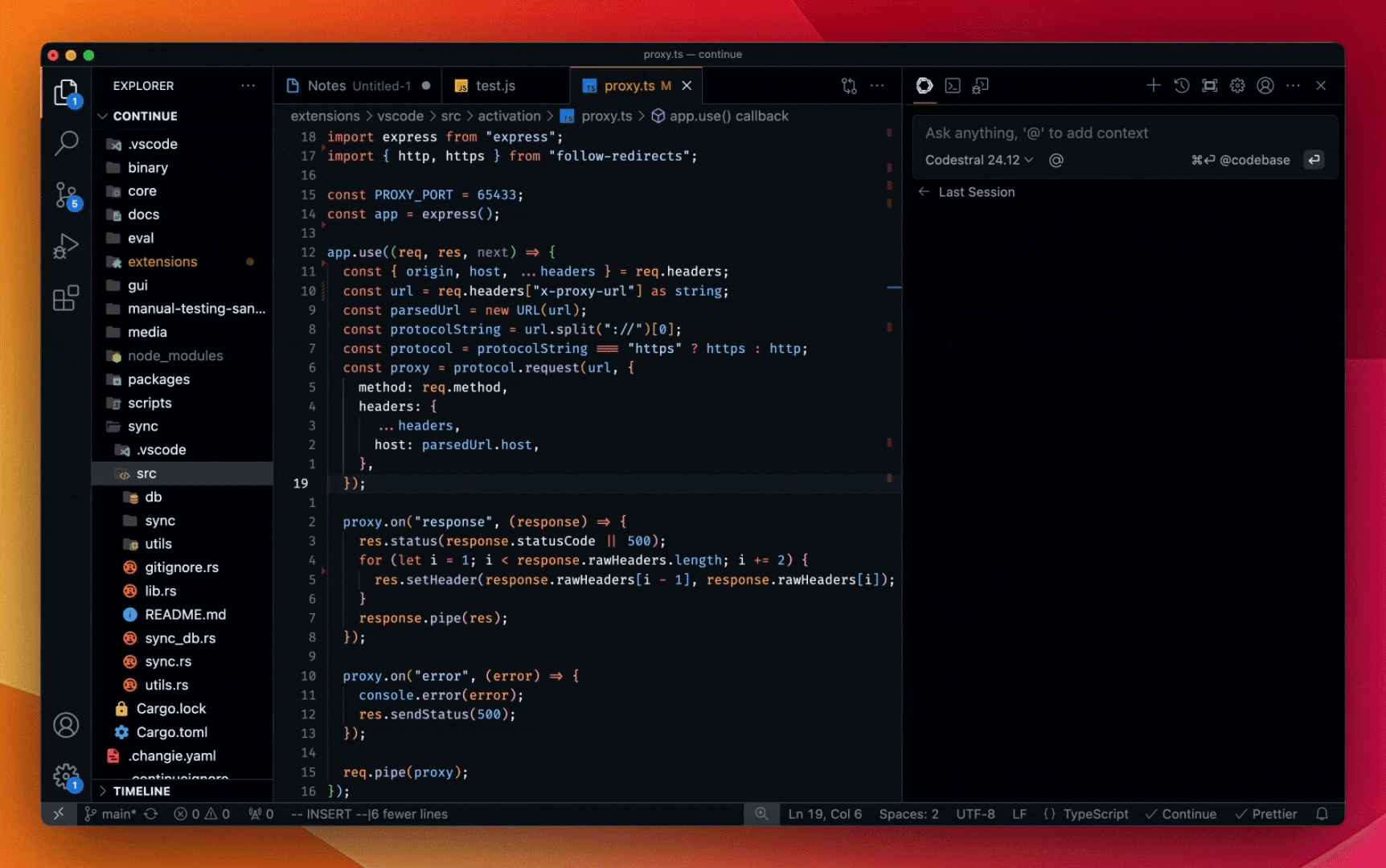

以 Tab 键的速度编写代码。今天在 Continue.dev 中可用,很快将在其他领先的 AI 代码助手上推出。

在过去一年中,AI 的所有创新中,代码生成可以说是最重要的。类似于流水线简化制造业和计算器改变数学的方式,编码模型代表了软件开发的重大变革。

Mistral AI 一直处于这一变革的前沿,推出了 Codestral,这是一个今年早些时候发布的先进(SOTA)编码模型。Codestral 轻量级、快速,精通 80 多种编程语言,针对低延迟、高频率用例进行了优化,并支持中间填充(FIM)、代码更正和测试生成等任务。Codestral 已被成千上万的开发人员用作功能强大的编码助手,经常使生产力提高数倍。今天,Codestral 正在进行重大升级。

Codestral 25.01 采用了比原始版本更高效的架构和改进的 Tokenizer,生成和完成代码的速度快约 2 倍。该模型现在是其权重级别中代码编写的明显领导者,并且在 FIM 用例中全面处于 SOTA 水平。

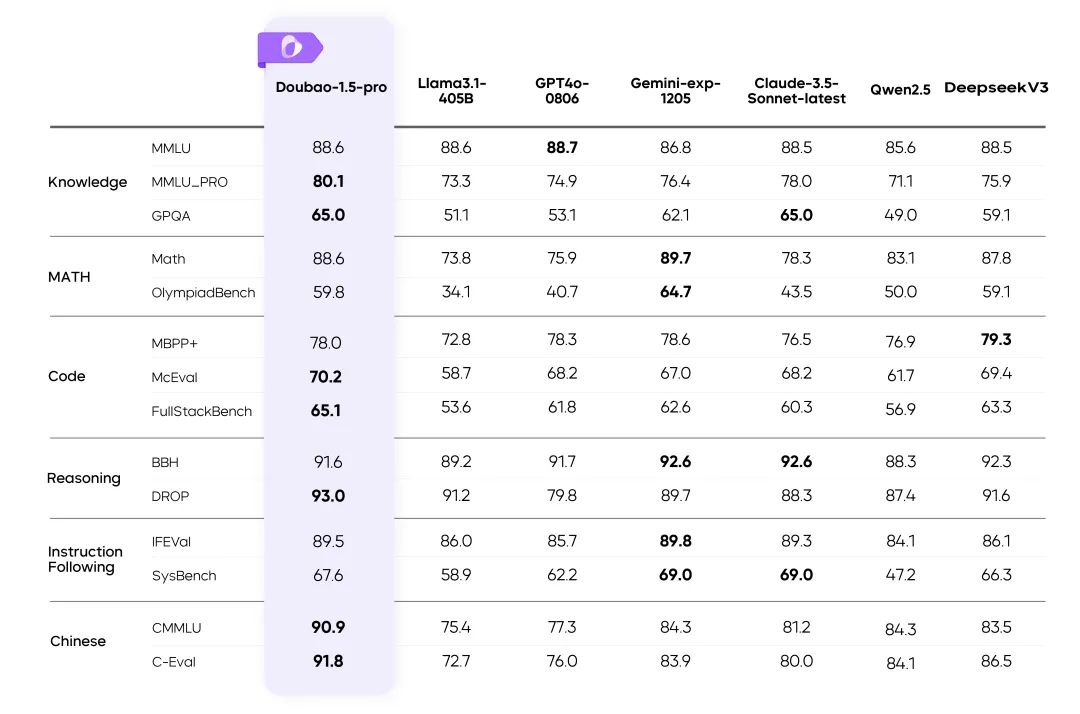

基准测试

我们使用被广泛认为是 FIM 任务最佳的领先的参数小于 100B 的编码模型对新的 Codestral 进行了基准测试。

概述

| Python | SQL | 多种语言的平均值 | |||

|---|---|---|---|---|---|

| 模型 | 上下文长度 | HumanEval | MBPP | CruxEval | LiveCodeBench |

| Codestral-2501 | 256k | 86.6% | 80.2% | 55.5% | 37.9% |

| Codestral-2405 22B | 32k | 81.1% | 78.2% | 51.3% | 31.5% |

| Codellama 70B instruct | 4k | 67.1% | 70.8% | 47.3% | 20.0% |

| DeepSeek Coder 33B instruct | 16k | 77.4% | 80.2% | 49.5% | 27.0% |

| DeepSeek Coder V2 lite | 128k | 83.5% | 83.2% | 49.7% | 28.1% |

按语言划分

| 模型 | HumanEval Python | HumanEval C++ | HumanEval Java | HumanEval Javascript | HumanEval Bash | HumanEval Typescript | HumanEval C# | HumanEval(平均值) |

|---|---|---|---|---|---|---|---|---|

| Codestral-2501 | 86.6% | 78.9% | 72.8% | 82.6% | 43.0% | 82.4% | 53.2% | 71.4% |

| Codestral-2405 22B | 81.1% | 68.9% | 78.5% | 71.4% | 40.5% | 74.8% | 43.7% | 65.6% |

| Codellama 70B instruct | 67.1% | 56.5% | 60.8% | 62.7% | 32.3% | 61.0% | 46.8% | 55.3% |

| DeepSeek Coder 33B instruct | 77.4% | 65.8% | 73.4% | 73.3% | 39.2% | 77.4% | 49.4% | 65.1% |

| DeepSeek Coder V2 lite | 83.5% | 68.3% | 65.2% | 80.8% | 34.2% | 82.4% | 46.8% | 65.9% |

FIM(单行精确匹配)

| 模型 | HumanEvalFIM Python | HumanEvalFIM Java | HumanEvalFIM JS | HumanEvalFIM(平均值) |

|---|---|---|---|---|

| Codestral-2501 | 80.2% | 89.6% | 87.96% | 85.89% |

| Codestral-2405 22B | 77.0% | 83.2% | 86.08% | 82.07% |

| OpenAI FIM API* | 80.0% | 84.8% | 86.5% | 83.7% |

| DeepSeek Chat API | 78.8% | 89.2% | 85.78% | 84.63% |

| DeepSeek Coder V2 lite | 78.7% | 87.8% | 85.90% | 84.13% |

| DeepSeek Coder 33B instruct | 80.1% | 89.0% | 86.80% | 85.3% |

FIM pass@1:

| 模型 | HumanEvalFIM Python | HumanEvalFIM Java | HumanEvalFIM JS | HumanEvalFIM(平均值) |

|---|---|---|---|---|

| Codestral-2501 | 92.5% | 97.1% | 96.1% | 95.3% |

| Codestral-2405 22B | 90.2% | 90.1% | 95.0% | 91.8% |

| OpenAI FIM API* | 91.1% | 91.8% | 95.2% | 92.7% |

| DeepSeek Chat API | 91.7% | 96.1% | 95.3% | 94.4% |

- GPT 3.5 Turbo 是 OpenAI 提供的最新 FIM API

今天开始可用

Codestral 25.01 正在通过我们的 IDE / IDE 插件合作伙伴向全球开发人员推出。您可以通过在各自的模型选择器中选择 Codestral 25.01 来感受到代码完成的响应质量和速度的差异。

对于企业用例,特别是那些需要数据和模型驻留的用例,Codestral 25.01 可在您的场所或 VPC 内本地部署。

查看下面的演示,并在 Continue for VS Code 或 JetBrains 中免费试用。

* Codestral 25.01 聊天演示

Continue 的联合创始人 Ty Dunn 表示:“对于 AI 代码助手,代码完成构成了大部分工作,这需要擅长中间填充(FIM)的模型。Codestral 25.01 标志着这方面取得了重大进展。Mistral AI 的新模型能够更快地提供更精确的建议——这是准确、高效的软件开发的关键组成部分。这就是为什么 Codestral 是我们推荐给开发人员的自动完成模型的原因。”

要使用 Codestral API 构建自己的集成,请访问 la Plateforme 并使用 codestral-latest。该 API 也可在 Google Cloud 的 Vertex AI 上使用,在 Azure AI Foundry 上以私有预览版提供,并即将推出 Amazon Bedrock。要了解更多信息,请阅读 Codestral 文档。

Codestral 25.01 在 LMsyscopilot arena 排行榜上首次亮相就名列第一。我们迫不及待地想听听您的体验!

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...