综合介绍

AkashChat 是一个基于去中心化云计算的AI聊天平台,由 Akash Network 开发并支持。它利用NVIDIA GPU提供的高性能算力,运行多个开源大语言模型(如QwQ-32B、Llama 3.3 70B、Llama 3.1 405B、DeepSeek R1 671B、等),为用户提供快速、免费且隐私友好的对话体验。无需注册账号即可使用,聊天记录仅存储在用户本地浏览器,确保数据安全。AkashChat 依托 Akash Supercloud 的去中心化架构,打破传统集中式云服务的限制,不仅响应速度快,还支持多种AI模型切换,适合需要高效对话工具的用户。

第二次推荐 AkashChat ,可以免登录使用各种大尺寸推理模型聊天,并提供免费的API密钥,对于想在客户端接入大模型但不想付费购买API的朋友十分友好(甚至免费提供嵌入模型BAAI-bge-large-en-v1-5)。Page Assist + AkashChat 的组合日常使用十分轻便!

- Akash 申请API 界面:https://chatapi.akash.network/

- 在 Page Assist 中配置密钥

功能列表

- 多模型选择:支持QwQ-32B、Llama 3.3 70B、DeepSeek R1 671B、Llama 3.1 405B、AkashGen(图片生成模型)、等开源AI模型,用户可根据需求切换。

- 高性能对话:借助NVIDIA H100和A100 GPU,最高可达27 tokens/秒的响应速度。

- 隐私保护:聊天记录本地存储,无需云端上传,确保用户数据安全。

- 无需注册:打开网页即可使用,无需账号登录,操作简单便捷。

- 开源支持:代码完全开源,用户可自行部署或贡献功能。

- 界面友好:提供现代化的聊天界面,操作直观,适合新手和专业用户。

使用帮助

如何开始使用AkashChat

AkashChat无需安装任何软件,只需通过浏览器访问https://chat.akash.network/即可使用。以下是详细的操作指南,帮助用户快速上手并充分利用其功能。

访问网站

- 打开任意现代浏览器(如Chrome、Firefox、Edge)。

- 在地址栏输入

https://chat.akash.network/并按回车键。 - 页面加载完成后,你将看到一个简洁的聊天界面,无需登录或注册,直接进入使用状态。

选择AI模型

AkashChat支持多种开源AI模型,用户可根据需求选择合适的模型。操作步骤如下:

- 在聊天界面顶部或侧边栏(具体位置根据最新界面设计可能有所调整),找到“模型选择”下拉菜单。

- 点击下拉菜单,会显示当前支持的模型列表,例如:

- Llama 3.1 405B:适合复杂问题解答,性能强大。

- Mistral-7B:轻量化模型,响应迅速,适合日常对话。

- QwQ-32B:最新高性能模型,超越部分大型模型。

- 点击你想要的模型名称,系统会自动切换,切换过程通常只需几秒钟。

输入问题并获取回答

- 在聊天界面的文本输入框中,输入你想询问的问题或内容,例如:“今天的天气怎么样?”或“帮我写一篇短文”。

- 按下回车键或点击发送按钮(通常是一个箭头图标)。

- AI会在几秒钟内生成回答,并显示在对话框中。响应速度因模型和网络状况而异,通常在27 tokens/秒以内。

管理聊天记录

AkashChat的隐私设计是其一大亮点,聊天记录不会上传到服务器,而是存储在你的浏览器本地。以下是管理记录的方法:

- 查看历史:每次打开网页时,之前的对话会自动加载(前提是使用同一浏览器且未清除缓存)。

- 清除记录:如果需要清空聊天历史,可以在浏览器设置中清除缓存,或直接使用浏览器的“无痕模式”以避免记录保存。

- 注意事项:更换设备或浏览器后,之前的聊天记录无法同步,因为数据不依赖云端存储。

开源部署(进阶用户)

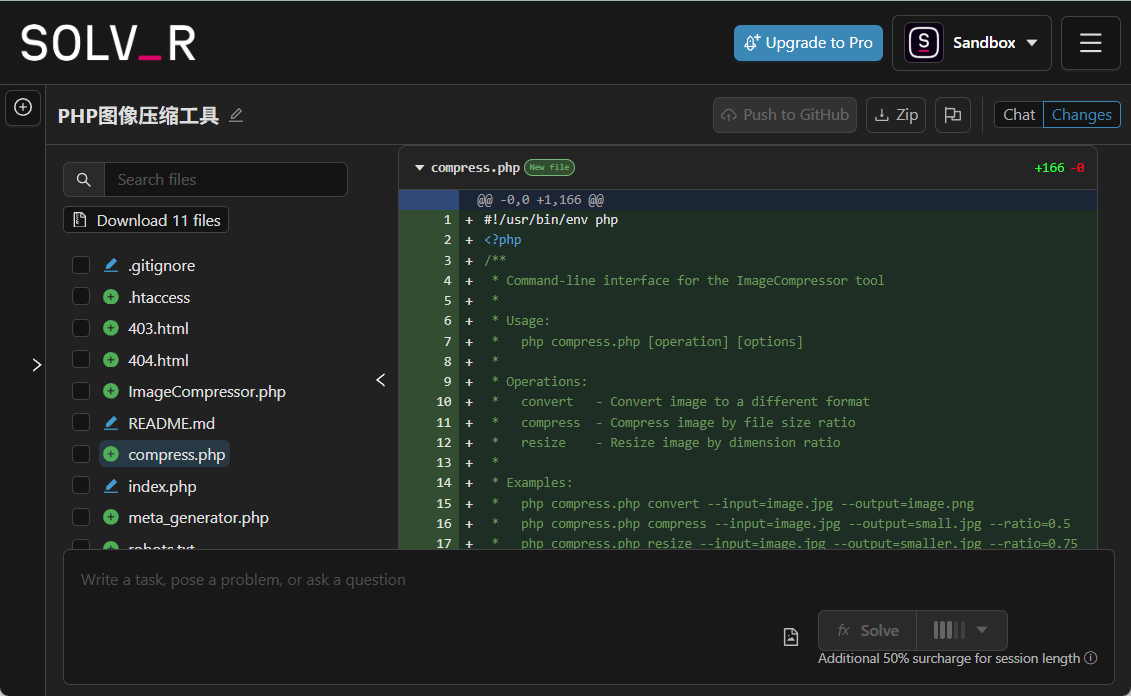

对于有技术背景的用户,AkashChat提供了开源代码,可以自行部署到本地或Akash Network上。操作步骤如下:

- 获取代码:访问GitHub仓库(https://github.com/akash-network/akash-chat),点击“Clone”或“Download ZIP”下载源码。

- 安装依赖:

- 确保本地已安装Node.js和npm。

- 在终端进入项目文件夹,运行

npm i安装所需依赖。

- 配置环境:

- 在项目根目录创建

.env.local文件。 - 输入以下配置(根据实际需求调整):

DEFAULT_MODEL=mistral DEFAULT_SYSTEM_PROMPT=你是一个有帮助的助手,提供准确信息。 API_KEY=你的密钥 API_HOST=你的API端点(如Ollama部署地址)

- 在项目根目录创建

- 运行项目:

- 在终端输入

npm run dev,本地开发服务器将启动。 - 打开浏览器,访问

http://localhost:3000,即可使用自部署版本。

- 在终端输入

- 部署到Akash:

- 使用Akash Provider Console,将项目部署到Akash Supercloud,具体步骤可参考Akash官网文档(https://akash.network/)。

特色功能操作

- 切换模型体验不同风格:尝试不同模型的回答风格,例如Llama 3.1适合深入分析,Mistral-7B更简洁直接。

- 快速响应测试:输入复杂问题(如“解释量子力学”),观察响应速度和回答质量。

- 隐私模式使用:若担心数据泄露,可全程使用浏览器的无痕窗口,确保不留痕迹。

注意事项

- 网络要求:确保网络稳定,AkashChat依赖实时计算,高延迟可能影响体验。

- 模型限制:部分模型可能不擅长处理特定领域问题,建议多尝试切换模型。

- 反馈建议:如遇到问题或有功能建议,可通过GitHub提交反馈,参与开源社区改进。

免费模型列表(与聊天界面提供模型不完全对等)

Chat + Completions

DeepSeek-R1-Distill-Llama-70B

DeepSeek-R1-Distill-Qwen-14B

DeepSeek-R1-Distill-Qwen-32B

Meta-Llama-3-1-8B-Instruct-FP8

Meta-Llama-3-1-405B-Instruct-FP8

Meta-Llama-3-2-3B-Instruct

Meta-Llama-3-3-70B-Instruct

Embedding

BAAI-bge-large-en-v1-5

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...