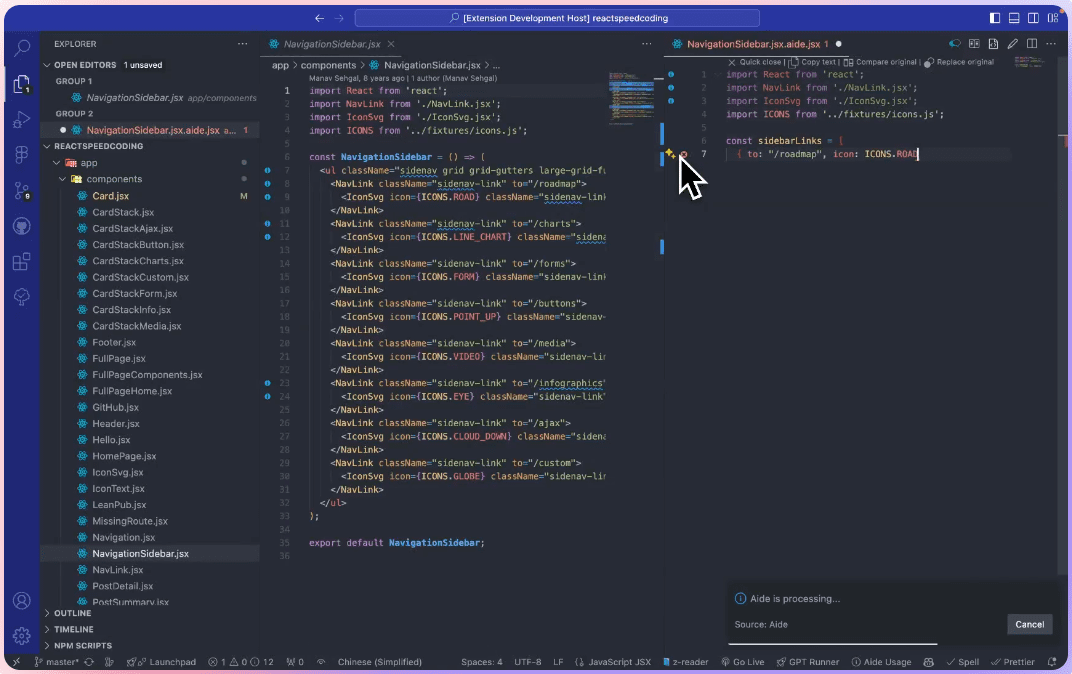

综合介绍

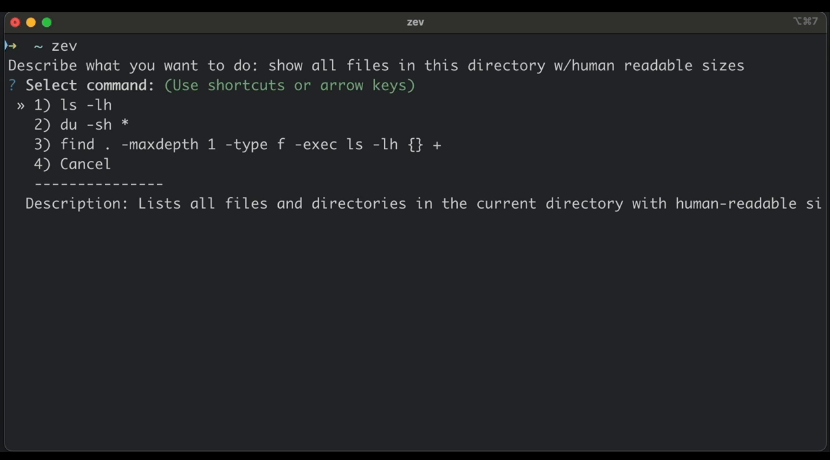

Zev 是一个简单易用的命令行界面(CLI)工具,帮助用户通过自然语言快速查询和生成终端命令。用户无需记住复杂的命令语法,只需用日常语言描述需求,Zev 就能生成对应的终端命令。基于 OpenAI API 或本地 Ollama 模型,Zev 支持多种操作场景,如文件管理、进程查看、网络检测和 Git 操作等。它的设计初衷是降低命令行使用的门槛,适合开发者和新手。用户需配置 OpenAI API 密钥或本地 Ollama 环境即可使用。Zev 的代码开源在 GitHub,允许用户自由贡献和定制。

功能列表

- 通过自然语言生成终端命令,如“显示当前目录磁盘使用情况”。

- 支持多种操作场景,包括文件操作、进程管理、网络检查和 Git 命令。

- 集成 OpenAI API,提供智能命令生成。

- 支持本地 Ollama 模型,允许离线运行。

- 提供 API 密钥管理功能,方便用户更新设置。

- 开源代码,支持社区贡献和功能扩展。

使用帮助

安装流程

Zev 是一个 Python 开发的 CLI 工具,安装和配置过程简单。以下是详细步骤:

- 克隆仓库

打开终端,运行以下命令克隆 Zev 的 GitHub 仓库:git clone https://github.com/dtnewman/zev.git

克隆完成后,进入项目目录:

cd zev

- 安装依赖

Zev 依赖 Python 3.6+ 环境。确保 Python 已安装,然后安装所需依赖:pip install -r requirements.txt依赖包括 OpenAI 的 Python 客户端库等,具体可在

requirements.txt中查看。 - 配置 OpenAI API 密钥

首次运行 Zev 时,系统会提示输入 OpenAI API 密钥。用户需在 OpenAI 官网注册账户并创建密钥。运行以下命令启动配置:python zev.py按提示输入密钥,密钥会保存至本地配置文件。

如果需要更新密钥,运行:zev --update-key - (可选)配置 Ollama 模型

如果希望本地运行 Zev,可安装 Ollama 并配置本地模型:- 访问 Ollama 官网,下载并安装 Ollama。

- 启动 Ollama 服务并选择模型,例如:

ollama run llama3 - 在 Zev 配置中启用 Ollama 模式,运行:

zev --use-ollama

这将使 Zev 使用本地模型,适合无网络环境或注重隐私的用户。

- 运行 Zev

安装和配置完成后,运行以下命令启动 Zev:python zev.py

主要功能操作

Zev 的核心功能是通过自然语言生成终端命令。以下是具体操作方法:

- 查询终端命令

在终端输入zev后跟自然语言描述。例如,查看所有运行的 Python 进程:zev 'show all running python processes'Zev 会返回类似

ps aux | grep python的命令。用户可直接复制执行。 - 文件操作

查找最近修改的文件,例如:zev 'find all .py files modified in the last 24 hours'输出命令可能为:

find . -type f -name "*.py" -mtime -1 - 系统信息查询

查看磁盘使用情况:zev 'show disk usage for current directory'输出命令如:

du -sh . - 网络检查

测试网络连通性,例如:zev 'check if google.com is reachable'输出命令可能为:

ping -c 4 google.com - Git 操作

查看 Git 未提交的更改:zev 'show uncommitted changes in git'输出命令如:

git status

特色功能操作

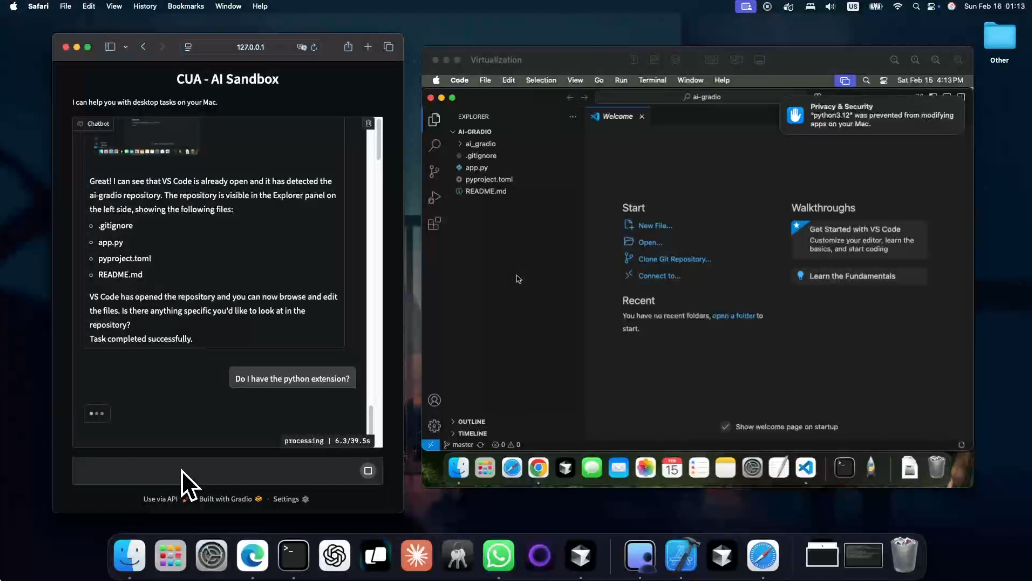

- 本地 Ollama 模型支持

使用 Ollama 运行 Zev 可完全离线操作,保护数据隐私。配置完成后,Zev 会自动调用本地模型生成命令,无需联网。

示例:zev --use-ollama 'list all files in current directory'输出命令:

ls -la - API 密钥管理

用户可随时更新 OpenAI 密钥或切换模型。运行:zev --update-key按提示输入新密钥,配置即刻生效。

操作注意事项

- 确保网络稳定以使用 OpenAI API。若使用 Ollama,需提前启动模型服务。

- 输入的自然语言描述尽量清晰具体,避免歧义。例如,“列出文件”可能生成

ls,而“列出所有隐藏文件”会生成ls -a。 - Zev 生成的命令仅供参考,建议在执行前检查命令是否符合预期。

进阶使用

- 自定义命令生成

用户可 fork Zev 的 GitHub 仓库,修改代码以支持特定场景。例如,添加自定义命令模板或支持其他 AI 模型。 - 批量操作

Zev 目前不支持批量命令生成,但用户可通过脚本调用 Zev。例如,编写 Shell 脚本循环调用zev命令,处理多个任务。

应用场景

- 开发者调试环境

开发者在调试代码时需频繁使用终端命令,如查看进程或文件状态。Zev 允许用自然语言快速生成命令,节省时间。例如,输入“查找占用 8080 端口的进程”,Zev 会生成lsof -i :8080。 - 新手学习命令行

命令行新手常因记不住复杂语法而感到挫败。Zev 通过自然语言输入降低学习门槛。例如,输入“显示当前文件夹所有文件大小”,Zev 会生成ls -lh,帮助用户快速上手。 - 系统管理员日常维护

系统管理员需检查服务器状态或执行网络诊断。Zev 支持快速生成命令,如“检查磁盘空间”生成df -h,提高工作效率。

QA

- Zev 支持哪些操作系统?

Zev 支持 macOS、Linux 和 Windows(需安装 Python 环境)。部分命令可能因系统差异需手动调整。 - 是否必须使用 OpenAI API?

不必须。Zev 支持本地 Ollama 模型,适合离线使用或不想依赖云服务的用户。 - 如何贡献代码?

访问https://github.com/dtnewman/zev,fork 仓库,提交 pull request。详细贡献指南见仓库的CONTRIBUTING.md。 - Zev 生成的命令是否安全?

Zev 生成的命令基于用户输入和模型推理,建议执行前检查命令内容,避免潜在风险。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...