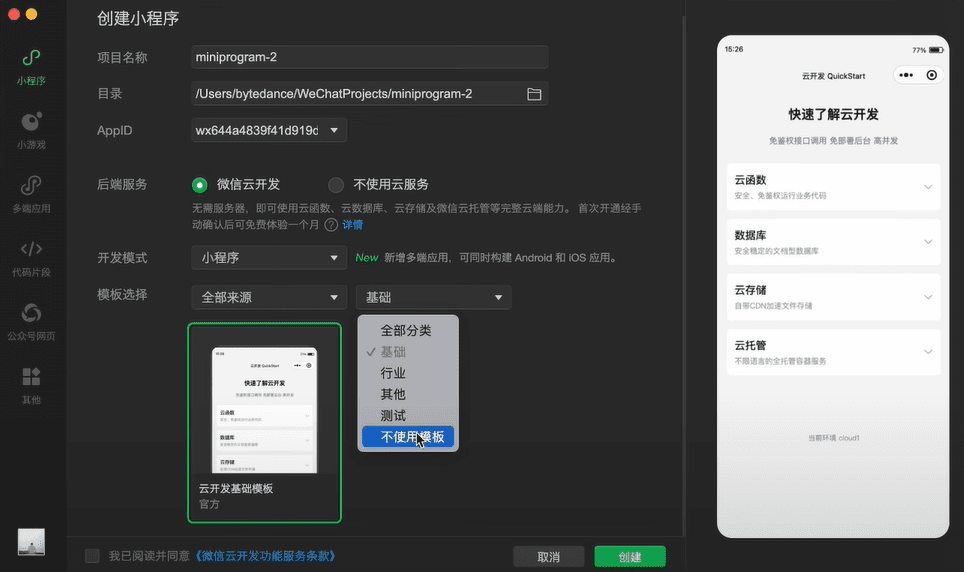

评估指标的定义

评估指标(Evaluation Metrics)是衡量机器学习模型性能的量化标准体系,如同多维体检报告全面评估人体健康状况。在分类任务中,准确率(Accuracy)反映模型整体判断正确率,精确率(Precision)关注预测为正例的准确性,召回率(Recall)衡量正例被找出的完整程度,F1分数(F1-Score)平衡精确率与召回率的综合表现,AUC-ROC评估模型在不同阈值下的整体分类能力。这些指标从不同角度揭示模型特性:准确率提供直观性能概览,精确率-召回率组合适用于非对称代价场景,F1分数在需平衡查准查全时特别有效,AUC-ROC摆脱阈值依赖给出稳定评估。选择合适的指标组合如同配备完善的质量检测工具,能发现模型优势,也能识别改进方向,确保模型在实际应用中发挥预期价值。随着机器学习应用深化,评估指标体系持续演进,从单一性能度量扩展到效率、公平性、鲁棒性等多维度综合评估。

评估指标的核心作用

- 性能量化基准:将模型性能转化为具体数值,消除主观判断的偏差。这些数值构成模型比较的客观基础,支持科学决策过程。

- 模型优化导向:指导模型改进的方向,如同导航仪显示当前位置与目标距离。优化过程围绕提升指标数值展开,形成明确改进路径。

- 资源分配依据:为项目决策提供数据支持,帮助确定是否投入更多资源。指标表现直接影响项目推进或终止的关键抉择。

- 风险预警机制:及时发现模型潜在问题,防止部署后产生严重后果。异常指标值如同健康体检的异常指标,提示需要深入检查。

- 沟通协作桥梁:为技术人员与非技术人员提供共同语言,促进团队协作。标准化指标让不同背景的成员能有效讨论模型表现。

评估指标的分类体系

- 任务类型维度:分类任务关注正确率、混淆矩阵相关指标,回归任务侧重误差大小,聚类任务考察簇内相似性与簇间差异性。

- 数据层级角度:微观指标关注每个样本的预测质量,宏观指标考虑整体分布特性,加权指标平衡不同类别的重要性。

- 业务场景划分:不同应用领域强调不同指标特性,金融风控重视召回率,推荐系统关注个性化程度,医疗诊断注重特异性。

- 计算复杂度区别:有些指标计算简单易于理解,有些需复杂统计运算,平衡可解释性与信息丰富度。

- 时间动态特性:静态指标反映固定时间点的性能,动态指标考察模型性能随时间的变化趋势,评估模型稳定性。

准确率指标详解

- 基本定义:准确率表示模型正确预测的样本比例,计算公式为(正确预测数)/(总样本数),直观反映模型整体判断能力。

- 适用场景:适合类别分布均衡的数据集,各类别重要性相当的场景,在平衡数据中提供可靠的性能评估。

- 计算示例:100个样本中90个预测正确,准确率为0.9,这种简单计算方式便于快速理解模型基础性能。

- 优势特点:计算简单、解释性强,作为入门级指标广泛应用。为模型性能提供快速概览。

- 局限缺陷:在类别不平衡数据中容易产生误导,比如99%负例时全预测负例就能获得0.99准确率。

精确率指标解析

- 核心概念:精确率关注预测为正例的样本中实际为正例的比例,计算公式为(真正例)/(真正例+假正例)。

- 业务意义:体现模型的"精准度",避免误报带来的成本,垃圾邮件过滤中精确率至关重要。

- 应用场景:适合假正例代价高的场景,如疾病诊断、欺诈检测,减少错误警报的重要性超过捕捉所有正例。

- 优势价值:帮助控制误报率,优化资源分配,在有限资源下确保处理样本的质量。

- 使用注意:单独使用可能忽略对正例的覆盖程度,需结合召回率综合评估。

召回率指标分析

- 指标定义:召回率衡量实际正例中被正确预测的比例,计算公式为(真正例)/(真正例+假反例)。

- 业务含义:体现模型的"查全率",避免漏报带来的风险,疾病筛查中召回率关乎生命安全。

- 适用情形:适合假反例代价高的应用,如安全隐患检测、癌症筛查,漏检成本远高于误检成本。

- 重要价值:确保重要事件不被遗漏,在安全关键领域具有特殊意义。

- 平衡需求:单独追求高召回率可能导致精确率下降,需寻找合适平衡点。

F1分数指标探讨

- 数学定义:F1分数是精确率和召回率的调和平均数,计算公式为2×(精确率×召回率)/(精确率+召回率)。

- 设计理念:平衡精确率和召回率两个维度,避免单一指标优化导致的性能偏斜。

- 应用价值:在精确率和召回率都重要的场景中提供单一评估标准,简化模型比较。

- 变体形式:Fβ分数允许调整精确率和召回率的相对权重,适应不同业务需求。

- 使用场景:类别不平衡数据中的核心评估指标,多分类问题可计算宏平均或微平均F1。

AUC-ROC指标阐释

- 基本概念:AUC-ROC表示ROC曲线下的面积,评估模型在不同分类阈值下的整体性能。

- ROC曲线:以假正例率为横轴、真正例率为纵轴的曲线,展示阈值变化时的性能轨迹。

- 指标含义:AUC值为1表示完美分类器,0.5相当于随机猜测,数值越大代表分类能力越强。

- 核心优势:不受类别分布影响,适合不平衡数据评估;与分类阈值选择无关,提供稳定评估。

- 应用局限:可能掩盖模型在特定操作点的实际表现,需结合具体业务阈值分析。

评估指标的选择方法

- 业务目标对齐:选择与业务需求最相关的指标,点击率预测关注排序质量,风险控制重视风险覆盖度。

- 数据分布考虑:针对类别不平衡数据选择合适指标,准确率可能失效,需关注F1分数或AUC值。

- 代价敏感分析:考虑不同类型错误的代价差异,欺诈检测中漏检代价远高于误检,需调整指标侧重。

- 可解释性需求:平衡指标复杂性与团队接受度,简单指标便于沟通,复杂指标包含更多信息。

评估指标的多维度评估

- 性能效率平衡:考察模型准确性和计算资源消耗,寻找最佳平衡点。

- 稳定性评估:通过交叉验证或多次训练测试模型性能稳定性,评估结果可靠性。

- 鲁棒性测试:检查模型在噪声数据或对抗攻击下的表现,评估抗干扰能力。

- 公平性审计:分析模型在不同人口统计群体的表现差异,确保公平无偏见。

- 可解释性评估:考察模型决策过程的透明程度,满足监管和用户信任需求。

评估指标的实践要点

- 基线建立:首先建立简单模型的性能基线,为后续改进提供参考基准。

- 多轮验证:采用交叉验证等方法减少评估结果的随机性,提高评估可靠性。

- 误差分析:深入分析模型错误案例,找出改进方向而非仅关注指标数值。

- 可视化辅助:利用混淆矩阵、学习曲线等可视化工具,更直观理解模型表现。

- 文档记录:详细记录每次实验的指标结果,建立可追溯的实验历史。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...