2025 年 1 月 30 日,微软表示,DeepSeek 的 R1 模型已在其 Azure 云计算平台和面向广大开发人员的 GitHub 工具上可供使用。微软还表示,客户很快就可以在他们的 Copilot + PC 上本地运行 R1 模型。

前文我们讲到,copilot会逐步使用除了OpenAI以外其他的大模型:

最近微软的新闻比较多,其中最令人瞩目的一条是,GitHub的copilot免费开放了,虽然次数较少(代码补全每月2000次,chat对话每月50次),但至少是一个标志性事件,并且模型也由原来的单一的GPT 4o拓展为o1 Claude 和 Gemini 等多家模型。

这其实就意味着,微软目前正逐步摆脱对 OpenAI 技术的依赖,从某种程度上讲,OpenAI并不再是唯一的最佳模型,并且运营成本恐怕也不再是最划算的。

由于最近 deepseek 在全球的影响力愈发强大,一系列扎眼的新功能不断上线,也造成了中美在AI领域的生死较量,微软为了让copilot更好地支持中文,准备在copilot中使用deepseek的R1模型。

微软CEO印度佬也在电话会上强调,DeepSeek R1 模型目前已可通过微软的AI平台Azure AI Foundry和GitHub获取,并且很快就能在Copilot+电脑上运行。纳德拉称DeepSeek“有一些真的创新”,AI成本下降是趋势:“缩放定律(Scaling Law)在预训练和推理时间计算中不断积累。多年来,我们已经看到了AI训练和推理方面的效率显著提高。在推理方面,我们通常看到每一代硬件的性价比提高2倍以上,每一代模型的性价比提高10倍以上。”

我们乐见于此。

copilot for Microsoft 365是适用于office365(word、excel、ppt、OneNote、teams等)的原生 copilot 插件,可以在word中根据其他文件生成内容、在excel中生成公式并计算、在PPT中根据其他文件创建演示文稿、在OneNote中整理笔记并生成更多笔记、在teams中极速总结会议内容,等功能。

相关阅读1:《在Copilot+ PC上本地运行蒸馏优化的DeepSeek R1模型》

AI正在向边缘端迈进,Copilot+ PC正引领这一趋势。随着Azure AI Foundry上线云端托管的DeepSeek R1(相关阅读2),我们正在将NPU优化版本的DeepSeek-R1直接引入Copilot+ PC,首批适配高通骁龙X平台,随后将支持英特尔酷睿Ultra 200V等平台。首个发布的DeepSeek-R1-Distill-Qwen-1.5B将登陆AI Toolkit,7B和14B版本也将陆续推出。这些优化模型让开发者能够构建和部署高效运行于设备的AI应用,充分发挥Copilot+ PC中NPU的强大性能。

Copilot+ PC的神经处理单元(NPU)为模型推理提供了高效引擎,开启了生成式AI不仅能按需运行,还可实现半持续运行服务的新范式。这使开发者能够利用强大的推理引擎构建主动式持续体验。通过Phi Silica项目的技术积累,我们实现了高效推理——在保证首Token响应时间和吞吐率竞争力的同时,将电池续航和系统资源消耗降至最低。NPU优化的DeepSeek模型采用了该项目的多项关键技术,包括:模型模块化设计实现性能与效率的最佳平衡、低位宽量化技术,以及Transformer在NPU上的映射策略。此外,我们利用Windows Copilot Runtime (WCR)通过ONNX QDQ格式实现跨Windows生态的扩展。

立即体验!

首先...让我们快速上手。

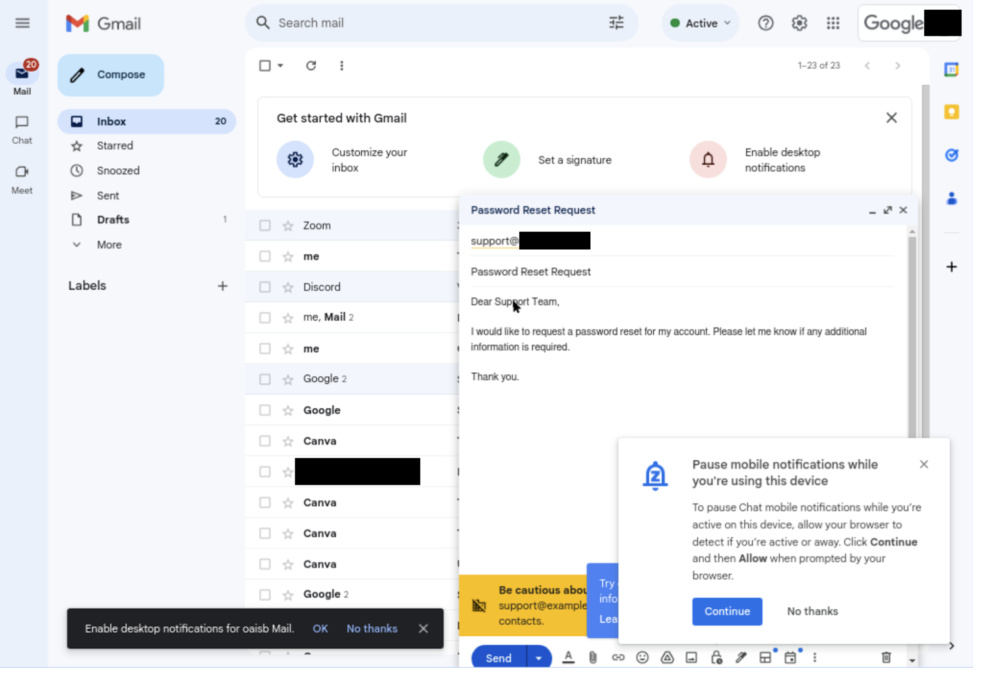

要在Copilot+ PC上体验DeepSeek,只需下载AI Toolkit的VS Code扩展。ONNX QDQ格式优化的DeepSeek模型即将登陆AI Toolkit模型库,并直接从Azure AI Foundry拉取。点击"Download"按钮即可下载到本地。下载完成后,只需打开Playground,加载"deepseek_r1_1_5"模型,即可开始输入提示词进行实验。

除了针对Copilot+ PC优化的ONNX模型外,您还可以通过点击"DeepSeek R1"下的"Try in Playground"按钮,在Azure Foundry中体验云端托管的原始模型。

AI Toolkit是开发者工作流的重要组成部分,支持模型实验和部署准备。通过这个Playground,您可以轻松测试Azure AI Foundry中适用于本地部署的DeepSeek模型。

芯片级优化

蒸馏优化的Qwen 1.5B模型包含Tokenizer、嵌入层、上下文处理模型、Token迭代模型、语言模型头和解Tokenizer模块。

我们对嵌入层和语言模型头采用4比特分块量化,并在CPU上运行这些内存密集型的操作。将主要的NPU优化资源集中在包含上下文处理和Token迭代的计算密集型Transformer模块,采用int4逐通道量化,并对权重实施选择性混合精度处理,同时激活值使用int16精度。

虽然DeepSeek发布的Qwen 1.5B已有int4版本,但由于动态输入形状和行为的存在,无法直接适配NPU——这些都需要进行优化以实现兼容性和最佳效率。此外,我们使用ONNX QDQ格式来支持Windows生态中各类NPU的扩展。我们通过优化CPU与NPU间的算子布局,实现功耗与速度的最佳平衡。

为实现低内存占用和快速推理的双重目标(类似Phi Silica方案),我们做了两项关键改进:首先采用滑动窗口设计,在硬件栈不支持动态张量的情况下,仍能实现超快首Token响应时间和长上下文支持;其次使用4比特QuaRot量化方案,充分发挥低位宽处理优势。QuaRot通过Hadamard旋转消除权重和激活值中的离群值,使模型更易量化。与GPTQ等现有方法相比,QuaRot显著提升了量化精度,特别是在逐通道量化等低粒度场景下。低位宽量化与滑动窗口设计等硬件优化的结合,使模型在紧凑型内存占用下实现了大型模型的行为特性。经过这些优化,该模型在短提示(<64 tokens)场景下可实现130毫秒的首Token响应时间和16 tokens/秒的吞吐率。

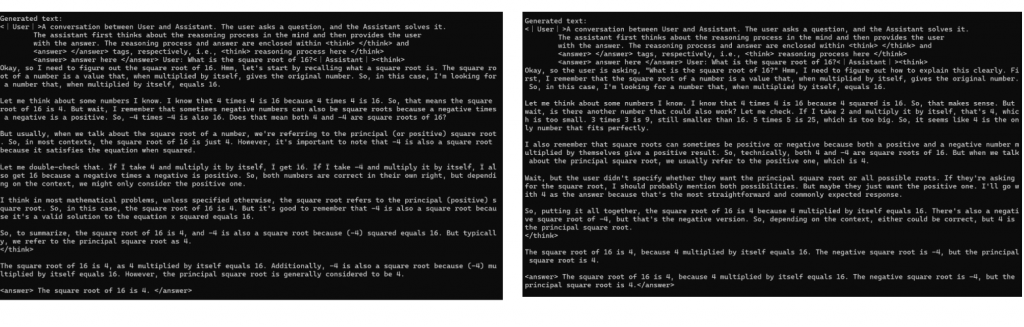

我们通过以下示例展示原始模型与量化模型响应的细微差异,后者在保持高性能的同时实现了能效优化:

图1: 定性对比。原始模型(左)与NPU优化模型(右)对相同提示的响应示例,包含模型的推理能力展示。优化模型保持了原始模型的推理模式并得出相同结论,证明其完整保留了原始模型的推理能力。

凭借NPU优化版DeepSeek R1模型的卓越速度和能效表现,用户将能够在本地完全自主地与这些突破性模型进行交互。

相关阅读2:《DeepSeek R1 现已在 Azure AI Foundry 和 GitHub 上线》

DeepSeek R1 现已登陆 Azure AI Foundry 和 GitHub 的模型目录,加入包含 1,800 多个模型的多样化组合,涵盖前沿模型、开源模型、行业专用模型和任务导向型 AI 模型。作为 Azure AI Foundry 的一部分,DeepSeek R1 可通过可信、可扩展且企业就绪的平台进行访问,使企业能够无缝集成先进 AI 技术,同时满足 SLA、安全性和负责任 AI 承诺——这一切都由微软的可靠性和创新力提供支持。

加速 Azure AI Foundry 开发者的 AI 推理能力

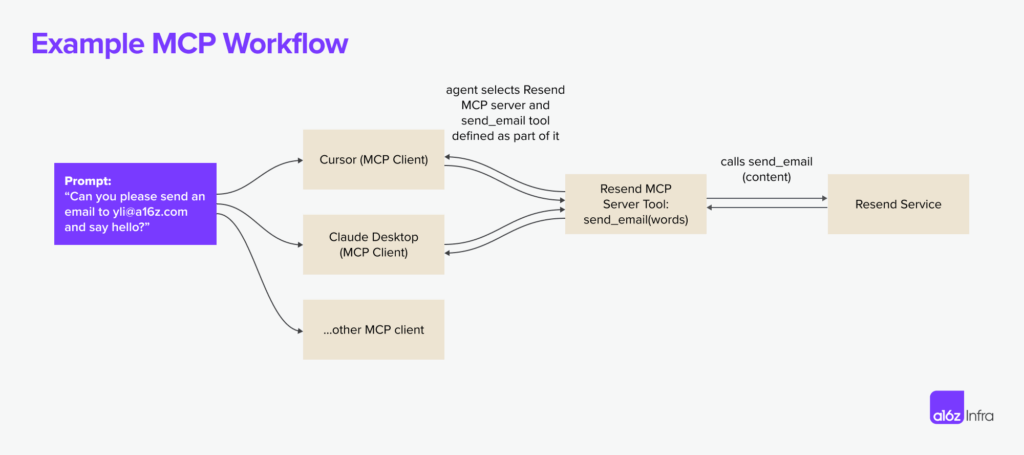

AI 推理正以惊人速度普及,改变着开发者和企业应用尖端智能的方式。正如 DeepSeek 所述,R1 提供了强大且高性价比的模型,让更多用户能以最小基础设施投资获取最先进的 AI 能力。

在 Azure AI Foundry 中使用 DeepSeek R1 或其他模型的关键优势在于开发者试验、迭代和将 AI 集成至工作流程的速度。通过内置模型评估工具,开发者可快速比较输出结果、评估性能基准并扩展 AI 驱动型应用。这种仅在数月前还难以想象的快速访问能力,正是我们对 Azure AI Foundry 愿景的核心:汇聚最佳 AI 模型于一处,加速全球企业的创新进程并解锁新可能。

使用可信赖的 AI 进行开发

我们致力于帮助客户在保持最高安全标准的同时快速构建生产就绪的 AI 应用。DeepSeek R1 已通过严格的"红队测试"和安全评估,包括模型行为的自动化评估和降低潜在风险的全面安全审查。通过 Azure AI 内容安全功能,默认启用内置内容过滤并提供灵活的退出选项。此外,安全评估系统可帮助客户在部署前高效测试应用程序。这些保障措施使 Azure AI Foundry 能够为企业提供安全、合规且负责任的 AI 解决方案部署环境。

如何在模型目录中使用 DeepSeek

- 若您没有 Azure 订阅,可立即注册 Azure 账户

- 在模型目录中搜索 DeepSeek R1

- 在 Azure AI Foundry 的模型目录中打开模型卡片

- 点击"部署"获取推理 API 和密钥,并访问测试平台

- 您将在 1 分钟内进入显示 API 和密钥的部署页面,可在测试平台中尝试输入提示

- 可通过多种客户端使用该 API 和密钥

立即开始使用

DeepSeek R1 现可通过 Azure AI Foundry 模型目录的无服务器端点进行访问。立即访问 Azure AI Foundry 并选择 DeepSeek 模型。

在 GitHub 上,您可以探索更多资源并获取分步指南,将 DeepSeek R1 无缝集成至应用程序。阅读 GitHub Models 博客文章。

即将推出:客户将能使用 DeepSeek R1 的精简版模型在 Copilot+ PC 本地运行。阅读 Windows Developer 博客文章。

随着我们持续扩展 Azure AI Foundry 的模型目录,我们期待见证开发者和企业如何运用 DeepSeek R1 应对现实挑战并创造变革性体验。我们致力于提供最全面的 AI 模型组合,确保各种规模的企业都能获取前沿工具来推动创新与成功。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...