综合介绍

SadTalker-Video-Lip-Sync 是一个基于 SadTalkers 实现的视频唇形合成工具。该项目通过语音驱动生成唇形,并使用可配置的面部区域增强方式来提高生成唇形的清晰度。项目还采用 DAIN 插帧算法对生成视频进行补帧,使唇形动作过渡更加流畅、真实和自然。用户可以通过简单的命令行操作,快速生成高质量的唇形视频,适用于各种视频制作和编辑需求。

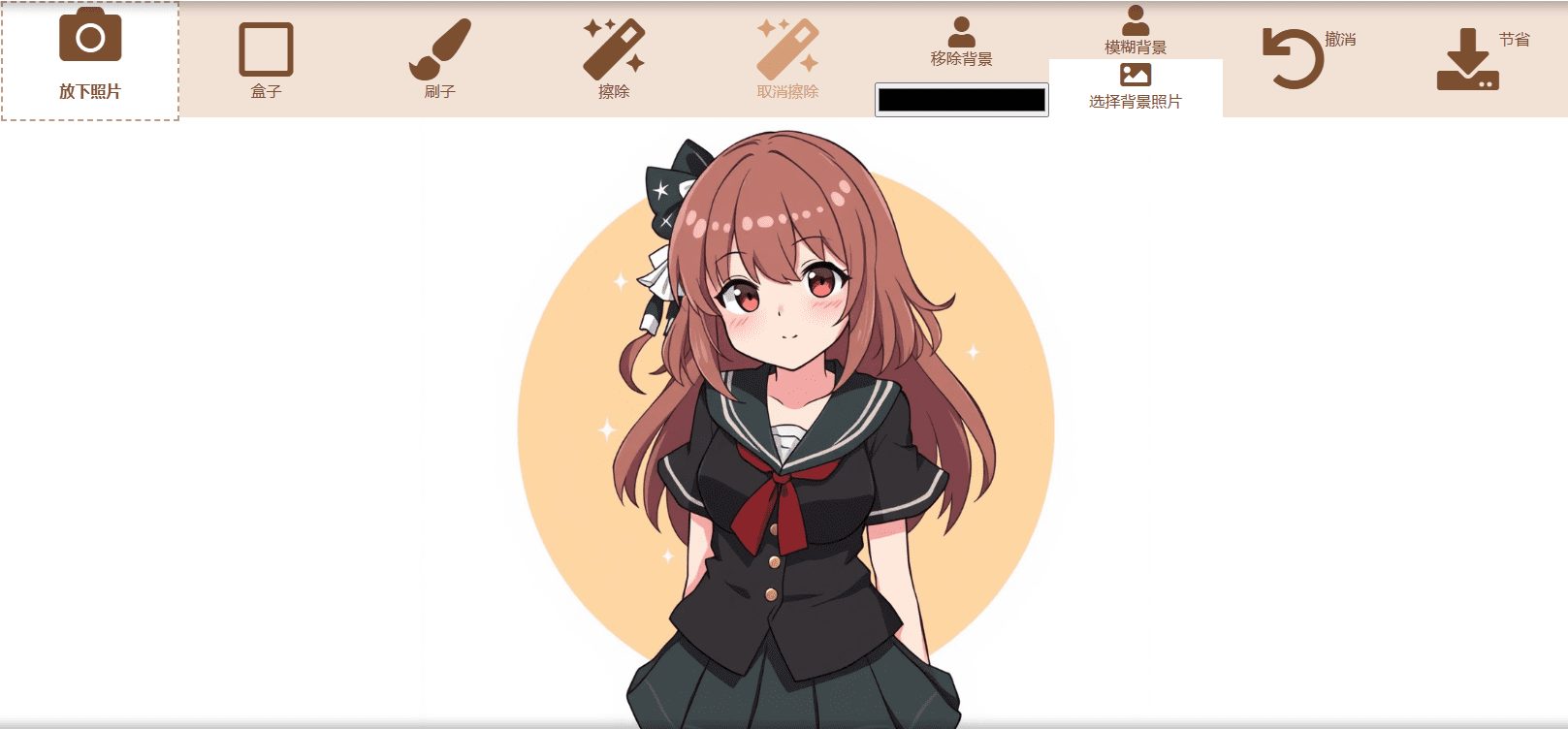

SadTalker 原版

SadTalker 增强版

功能列表

- 语音驱动唇形生成:通过音频文件驱动视频中的唇形动作。

- 面部区域增强:可配置唇形或全脸区域的画面增强,提高视频清晰度。

- DAIN 插帧:使用深度学习算法对视频进行补帧,提升视频流畅度。

- 多种增强选项:支持无增强、唇形增强和全脸增强三种模式。

- 预训练模型:提供多种预训练模型,方便用户快速上手。

- 简单命令行操作:通过命令行参数配置和运行,操作简便。

使用帮助

环境准备

- 安装必要的依赖:

pip install torch==1.12.1+cu113 torchvision==0.13.1+cu113 torchaudio==0.12.1 --extra-index-url https://download.pytorch.org/whl/cu113

conda install ffmpeg

pip install -r requirements.txt

- 如果需要使用 DAIN 模型进行补帧,还需安装 Paddle:

python -m pip install paddlepaddle-gpu==2.3.2.post112 -f https://www.paddlepaddle.org.cn/whl/linux/mkl/avx/stable.html

项目结构

checkpoints:存放预训练模型dian_output:存放 DAIN 插帧输出examples:示例音频和视频文件results:生成结果src:源代码sync_show:合成效果展示third_part:第三方库inference.py:推理脚本README.md:项目说明文件

模型推理

使用以下命令进行模型推理:

python inference.py --driven_audio <audio.wav> --source_video <video.mp4> --enhancer <none, lip, face> --use_DAIN --time_step 0.5

--driven_audio:输入音频文件--source_video:输入视频文件--enhancer:增强模式(none, lip, face)--use_DAIN:是否使用 DAIN 插帧--time_step:插帧频率(默认0.5,即25fps->50fps)

合成效果

生成的视频效果展示在 ./sync_show 目录下:

original.mp4:原始视频sync_none.mp4:无任何增强的合成效果none_dain_50fps.mp4:只使用 DAIN 模型将25fps添帧到50fpslip_dain_50fps.mp4:对唇形区域进行增强+DAIN 模型将25fps添帧到50fpsface_dain_50fps.mp4:对全脸区域进行增强+DAIN 模型将25fps添帧到50fps

预训练模型

预训练模型下载路径:

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...