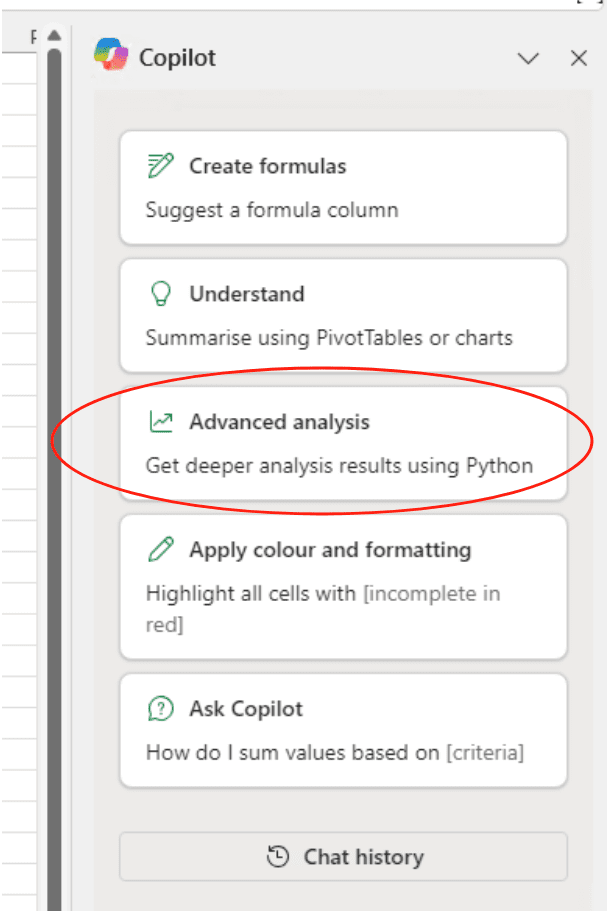

Erich Archer曾在最近的Demo Day公布了他的最新计划——一部纪录片,述说他的高祖的故事,而整部影片完全由AI编写并生成。[此处可以观看录播]

而昨天,OpenAI发布了一款名为[Sora]的新视觉特效模型,令人大为震撼。

但在我们讨论最新的科技进步之前,我先要介绍一下Rufus Archer,他活在1812-1909年间。而Erich则借助一些工具,将他一位当年的人“复活”:

- ChatGPT来撰写剧本

- Perplexity进行在Rufus生活的时间段内的事件研究

- Midjourney创造视觉,包括将两张古老的相片变得栩栩如生

- RunwayML完成从静态图片到运动视频的转换

我有几点感想:

- 以传统方式制作这样一个项目,Erich可能需要付费雇佣一支团队,花费几百小时。

- 但这个项目他只花费了20个小时和约200美元。

- 这个项目的完成度已经置于当地电视台甚至PBS电视网络播出。

- 它与获奖纪录片制作人Ken Burns的作品相比,也毫不逊色。

- AI的发展只会更进一步,速度更会加快。

那只是周一发生的事情。

接下来,Erich将运用OpenAI昨天发布的一款革命性视频生成模型Sora。我在下面给出了一个例子,那是一个完全由文字提示创建的视频:

目前市场上的一些视频生成模型展现出相当好的性能。Sora领先了他们很多

Sora还未对外公开,但一旦发布,你猜会是谁立即准备利用它构建原型?

当你构筑你的创新周期,你不只是构造一个创意,而是形成了一个充满想法的完整流水线。

每个想法都会演化成一个原型,给你学习新技能的机会并有机会与AI领域以及你行业内的其他人建立联系。

这意味着你的AI技能水平会提高,你会因为在你的领域变得出名而接触到新的机遇。

创新周期一旦启动,它就会自我强化。每一个想法都会让接下来的想法更好。并且当你遇到类似Sora这样的巨大进步时,你可以直接使用它,因为你已经通过你之前的试验搞清楚了“基础”问题。

其实,在2023年3月发布的AI图像识别工具[EveryAlt]()也发生了类似的事情。大约8个月后,OpenAI发布了GPT-4 Vision,解决了我们在早期图像识别模型中遇到的几乎所有问题。

如果我只是拿EveryAlt的想法坐视不动,而没有构建早期的原型,我可能会对新模型的发布感到失望 —— 我会觉得我的机会已经溜走了。

同样的,如果Erich没有在12月和2月制造他的第一代和第二代原型,他可能会蒙受Sora的打击。

但是由于我们投入并开始建设,我们能够抓住新的AI进步的机遇,而不是被其压倒。

这就是为什么我对即将来临的一年感到非常兴奋 —— 对于正在研制原型并形成思路流水线的Erich和超过800名其他的IWAI学生。

在两个月内,你将有机会在我们的下一次Demo Day上看到我们正在做什么,时间定在4月2日。请把这个日期记在日历上,我会在接近日期时再联系你,提供更多的细节。

同时,不要错过[Sora的演示]

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...