综合介绍

SkyReels-V2 是一个开源的视频生成模型,由 SkyworkAI 开发。它通过先进的 Diffusion Forcing 技术,支持生成无限长度的视频,适用于文本转视频(T2V)和图像转视频(I2V)任务。用户可以利用文本描述或输入图像,生成高质量、电影级别的视频内容。该模型在开源社区表现突出,性能媲美商业模型如 Kling 和 Runway-Gen4。它提供灵活的推理模式,适合开发者、创作者和研究人员使用。SkyReels-V2 的代码和模型权重公开在 GitHub,方便用户下载和部署。

功能列表

- 无限长度视频生成:支持生成任意时长的视频,适合短片到完整电影的创作。

- 文本转视频(T2V):通过文本提示生成符合描述的视频内容。

- 图像转视频(I2V):基于输入图像生成动态视频,保持图像特征。

- 多模态支持:结合大型语言模型(MLLM)和强化学习,提升视频生成质量。

- 故事生成:自动生成符合叙述逻辑的视频故事板。

- 相机控制:提供导演视角,支持自定义镜头角度和运动。

- 多主体一致性:通过 SkyReels-A2 系统,确保多角色视频的视觉一致性。

- 高效推理框架:支持多 GPU 推理,优化生成速度和资源使用。

使用帮助

安装流程

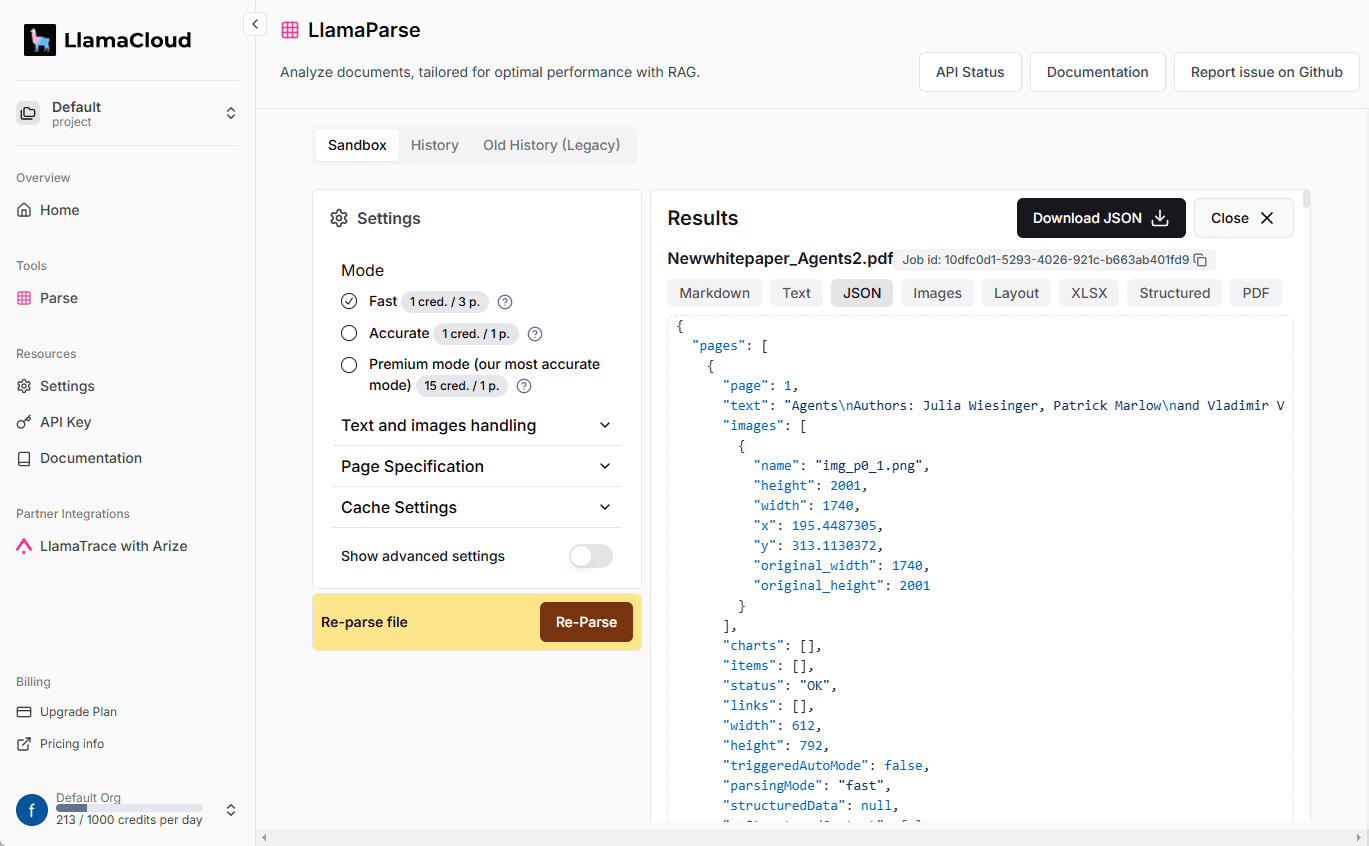

SkyReels-V2 是一个基于 Python 的开源项目,需在本地或服务器上配置环境。以下是详细的安装步骤:

- 克隆仓库

打开终端,运行以下命令获取 SkyReels-V2 代码:git clone https://github.com/SkyworkAI/SkyReels-V2 cd SkyReels-V2 - 创建虚拟环境

建议使用 Python 3.10.12 创建虚拟环境以避免依赖冲突:conda create -n skyreels-v2 python=3.10 conda activate skyreels-v2 - 安装依赖

安装项目所需的 Python 库,运行:pip install -r requirements.txt - 下载模型权重

SkyReels-V2 的模型权重托管在 Hugging Face。使用以下命令下载:pip install -U "huggingface_hub[cli]" huggingface-cli download Skywork/SkyReels-V2 --local-dir ./models确保有足够的磁盘空间(模型大小可能达数十 GB)。

- 硬件要求

- 最低配置:单块 RTX 4090(24GB VRAM),支持 FP8 量化降低内存需求。

- 推荐配置:多 GPU(如 4-8 张 A100),支持高效并行推理。

- 至少 32GB 系统内存和 100GB 磁盘空间。

使用方法

SkyReels-V2 提供文本转视频(T2V)和图像转视频(I2V)两种主要功能。以下是具体操作流程:

文本转视频(T2V)

- 准备提示词

编写描述视频内容的文本提示,例如:A serene lake surrounded by towering mountains, with swans gliding across the water.可添加负面提示词以避免不需要的元素:

low quality, deformation, bad composition - 运行生成脚本

修改generate_video.py的参数,设置分辨率、帧数等:python generate_video.py --model_id "Skywork/SkyReels-V2-T2V-14B-540P" --prompt "A serene lake surrounded by mountains" --num_frames 97 --fps 24 --outdir ./output--model_id:选择模型(如 540P 或 720P)。--num_frames:设置视频帧数(默认 97)。--fps:帧率(默认 24)。--outdir:输出视频保存路径。

- 查看输出

生成的视频将保存为 MP4 格式,例如output/serene_lake_42_0.mp4。

图像转视频(I2V)

- 准备输入图像

提供一张高质量图像(如 PNG 或 JPG),确保分辨率与模型匹配(默认 960x544)。 - 运行生成脚本

在generate_video.py中指定图像路径:python generate_video.py --model_id "Skywork/SkyReels-V2-I2V-14B-540P" --prompt "A warrior fighting in a forest" --image ./input_image.jpg --num_frames 97 --fps 24 --outdir ./output--image:输入图像路径。- 其他参数与 T2V 类似。

- 优化设置

- 使用

--guidance_scale(默认 6.0)调整文本引导强度。 - 使用

--inference_steps(默认 30)控制生成质量,步数越多质量越高但耗时更长。 - 启用

--offload优化内存使用,适合低显存设备。

- 使用

特色功能操作

- 无限长度视频

SkyReels-V2 使用 Diffusion Forcing 技术,支持生成超长视频。运行长视频推理脚本:python inference_long_video.py --model_id "Skywork/SkyReels-V2-T2V-14B-720P" --prompt "A sci-fi movie scene" --num_frames 1000- 建议分段生成,每段 97-192 帧,再通过后期工具拼接。

- 故事生成

使用 SkyReels-A2 系统的故事生成功能,输入剧情描述:A hero’s journey through a futuristic city, facing challenges.运行:

python story_generate.py --prompt "A hero’s journey" --output story_video.mp4系统将生成包含故事板的视频,自动安排场景和镜头。

- 相机控制

通过--camera_angle参数设置镜头视角(如 “frontal” 或 “profile”):python generate_video.py --prompt "A car chase" --camera_angle "profile" --outdir ./output - 多主体一致性

SkyReels-A2 支持多角色场景。提供多张参考图像,运行:python multi_subject.py --prompt "Two characters talking" --images "char1.jpg,char2.jpg" --outdir ./output确保角色在视频中保持视觉一致性。

优化与调试

- 内存不足:启用

--quant使用 FP8 量化,或--offload卸载部分计算到 CPU。 - 生成质量:增加

--inference_steps(如 50)或调整--guidance_scale(如 8.0)。 - 社区支持:遇到问题可查看 GitHub Issues 或加入 SkyReels 社区讨论。

应用场景

- 短视频创作

创作者可使用 T2V 功能,通过文本快速生成短视频素材,适合社交媒体内容制作。 - 电影预制片

导演可利用无限长度视频和故事生成功能,制作电影预告片或概念片,降低前期成本。 - 虚拟电商展示

使用 I2V 功能,将产品图片转为动态视频,展示产品在虚拟场景中的使用效果。 - 教育动画

教师可通过文本描述生成教学动画,直观展示复杂概念,如科学实验过程。 - 游戏开发

开发者可生成游戏场景或角色动画,作为原型设计或过场动画的素材。

QA

- SkyReels-V2 支持哪些分辨率?

当前支持 540P(960x544)和 720P(1280x720),未来可能扩展更高分辨率。 - 需要多大显存才能运行?

单块 RTX 4090(24GB)可运行基本推理,多 GPU 配置可加速生成长视频。 - 如何提高生成视频质量?

增加推理步数(--inference_steps)、优化提示词,或使用高质量输入图像。 - 是否支持实时生成?

当前为离线生成,实时生成需更高硬件支持,未来可能优化。 - 模型权重是否免费?

是的,SkyReels-V2 是完全开源的,权重可从 Hugging Face 免费下载。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...