开源在即:AI 视频创作的大众化

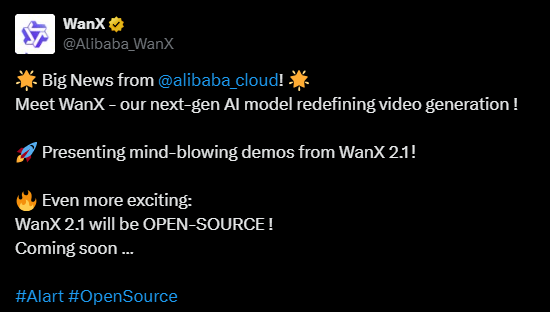

令人振奋的消息传来! 阿里云正式宣布,其备受瞩目的新一代 AI 视频生成模型 WanX 2.1 即将开源! 🎉 这款被誉为 “重新定义视频生成” 的模型,自发布以来就吸引了业界的广泛关注。而现在,阿里云决定将 WanX 2.1 开源,无疑将为 AI 视频创作领域注入一股强大的新动力。

WanX 2.1 是阿里云 “通义万象” (Wanx) 多模态大模型的最新力作。 “通义万象” 于 2023 年 7 月首次亮相,而 WanX 2.1 则代表了该系列模型的最新技术高度。 它不仅能够根据文本指令生成高质量的图像和视频,更是全球首个支持中英文文字特效的模型。

卓越性能:VBench 榜单的领跑者

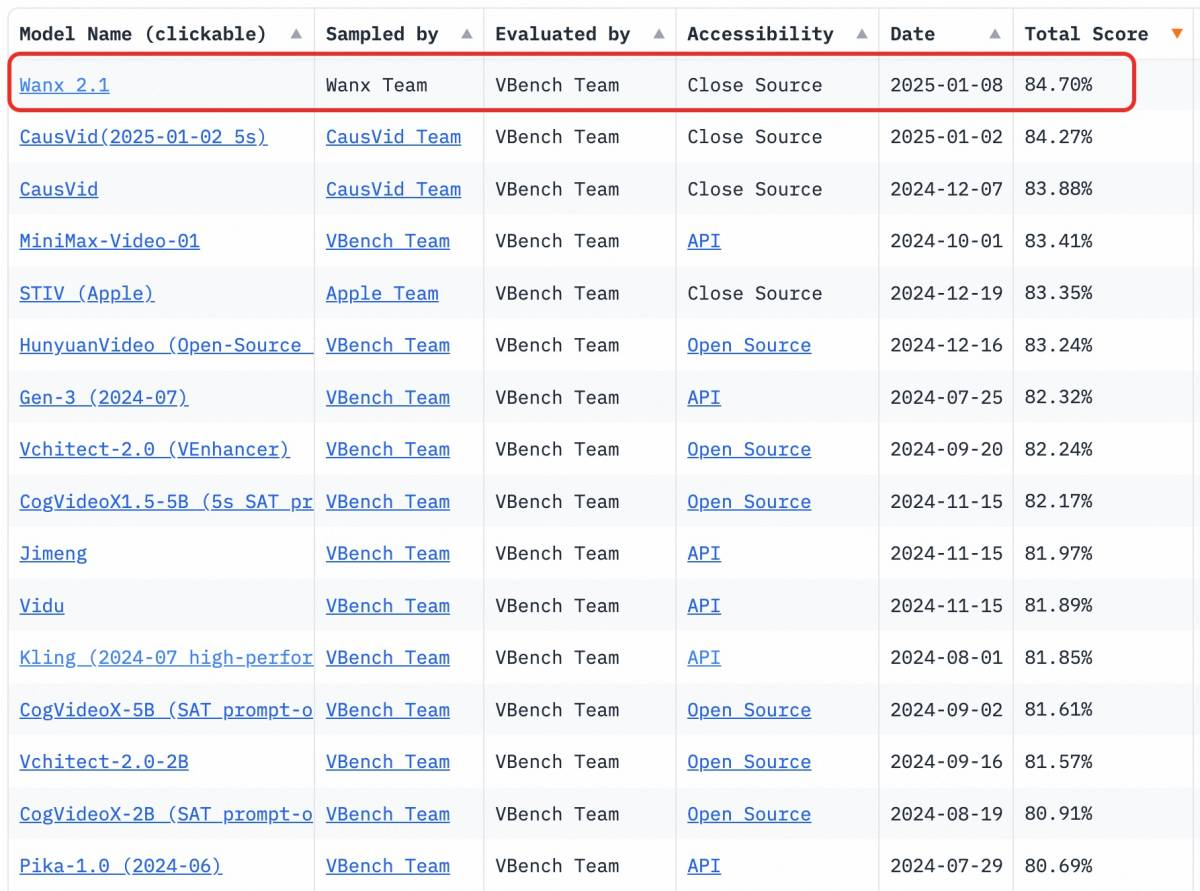

WanX 2.1 在生成逼真视频方面表现出了惊人的实力。 无论是处理复杂的运动场景,还是优化像素质量,亦或是对物理规则的精准把握,WanX 2.1 都展现出了卓越的性能。 尤其值得一提的是,它在理解和执行用户指令方面的精确性,使其在权威的 VBench 视频生成模型评测榜单上傲视群雄,以 84.7% 的总分领跑各项关键指标,例如动态程度、空间关系以及多物体互动等。

在本文发布前,榜首已更替为 MiracleVision V5 。

是什么让 WanX 2.1 如此出色? 这背后离不开阿里云研究团队在技术上的持续创新和突破。

技术创新:打造更真实的视频世界

为了追求极致的视觉生成质量,WanX 2.1 的研发团队在多个关键技术领域进行了深入探索和创新:

- 自研 VAE 和 DiT 框架: WanX 2.1 采用了阿里云自研的 VAE (变分自编码器) 和 DiT (去噪扩散 Transformer) 框架,显著增强了模型对视频时序和空间关系的理解能力。 这使得 WanX 2.1 在处理包含复杂运动和物理规则的场景时,能够生成更加逼真自然的视频内容。

- 全时空注意力机制: 通过引入全时空注意力机制,WanX 2.1 能够更精准地捕捉和模拟真实世界中复杂多变的动态效果,让生成的视频更加生动鲜活。

- 超长上下文训练: 为了提升模型对文本指令的理解和执行能力,WanX 2.1 还采用了超长上下文训练方法,加速了模型训练进程,并实现了文本指令与视频内容创作的无缝衔接,让视频创作变得更加快速和直观。

- 首创中英文双语文本特效: WanX 2.1 更是行业首个支持中英文双语文本特效的视频生成模型, 这无疑极大地拓展了其应用场景,能够更好地满足广告设计、短视频制作等行业的多样化创意需求。

文本提示:「平拍一位女性花样滑冰运动员在冰场上进行表演的全景。她穿着紫色的滑冰服,脚踩白色的滑冰鞋,正在进行一个旋转动作。她的手臂张开,身体向后倾斜,展现了她的技巧和优雅」。

得益于这些创新技术的加持,WanX 2.1 能够轻松驾驭大幅度的肢体运动和复杂的旋转场景。 即使是花样滑冰、游泳、跳水这类对运动轨迹和身体协调性要求极高的挑战性场景,WanX 2.1 依然能够出色完成,为视频生成树立了新的质量标杆。

开源共享:赋能更广阔的创意生态

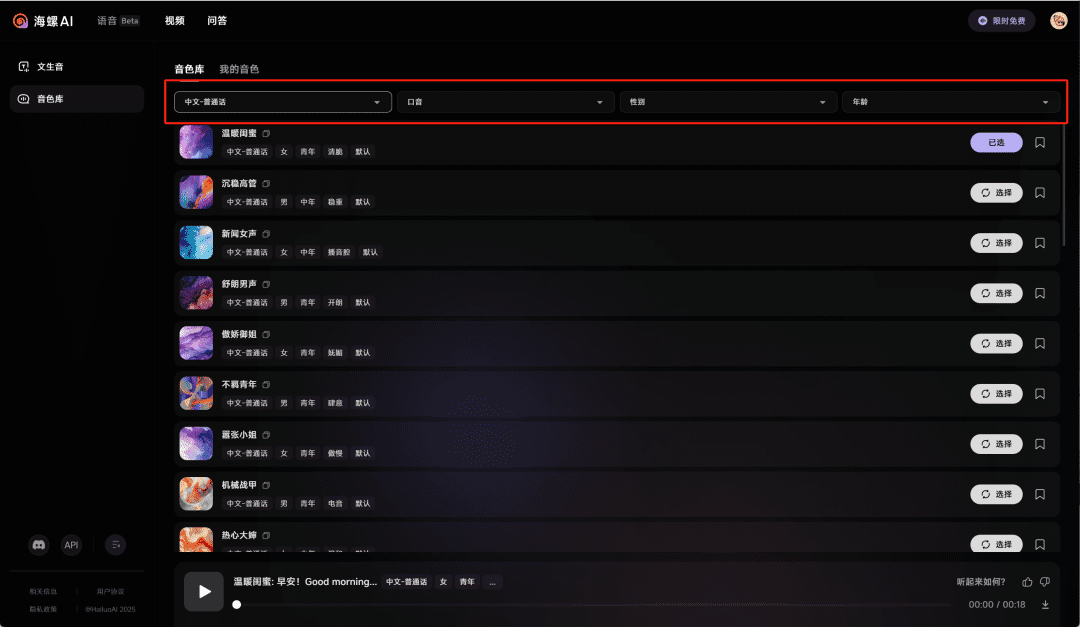

目前,WanX 2.1 已在中国官方网站 通义万相 提供免费体验。 个人开发者和企业用户可以通过阿里云 Model Studio 平台率先体验 WanX 2.1 的强大功能, 释放创意,高效生成高质量的视频内容。

而即将到来的开源,则意味着 WanX 2.1 将不再局限于特定平台,而是会融入更广阔的 AI 技术生态之中。 阿里云此举无疑将极大地推动 AI 视频生成技术的普及和发展,让更多开发者和创意人士能够站在巨人的肩膀上,共同探索 AI 视频创作的无限可能,真正实现 AI 技术与创意产业的深度融合。 让我们共同期待 WanX 2.1 开源的那一天,见证 AI 视频创作新时代的到来!

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...