综合介绍

RunPod是一个专为AI设计的云计算平台,旨在为开发者、研究人员和企业提供一站式的AI模型开发、训练和扩展解决方案。该平台集成了按需GPU资源、无服务器推理、自动扩展等功能,为AI项目的各个阶段提供强大的支持。RunPod的核心理念是简化AI开发过程,让用户能够专注于模型创新而不必过多担心基础设施问题。

只在请求时付费且冷启动速度快,适合低频服务且要求高质量运行。同时自然语言处理类大语言模型支持按tokens付费。

功能列表

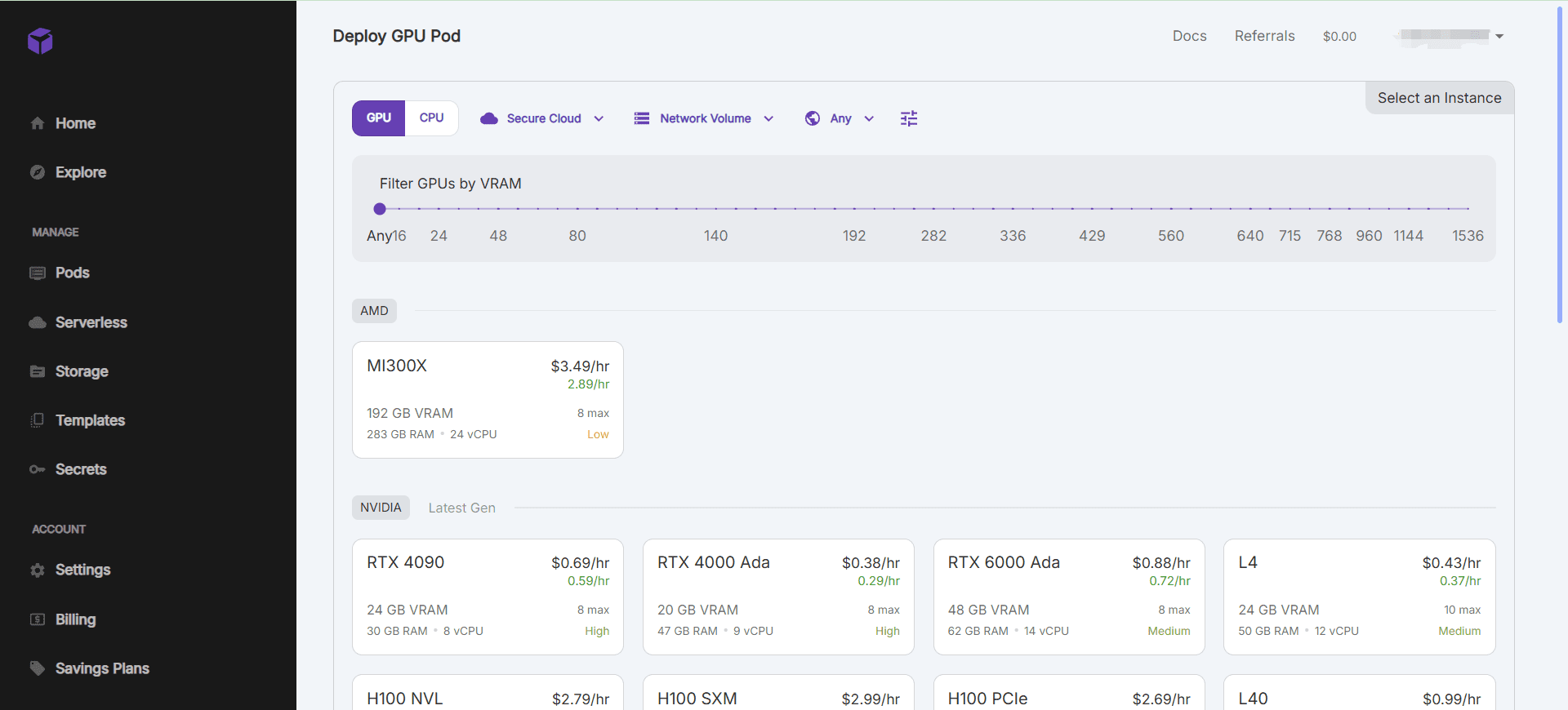

- 按需GPU资源:快速启动GPU实例,支持多种GPU型号,满足不同算力需求。

- 无服务器推理:自动扩展推理能力,高效处理变化的工作负载。

- 开发环境集成:预配置的AI开发环境,支持常用的深度学习框架和工具。

- 数据管理与存储:集成化的数据存储解决方案,高效的数据传输和访问机制。

- 协作与版本控制:支持团队协作开发,提供模型版本管理功能。

使用帮助

安装与使用

- 创建GPU实例:

- 登录后,进入控制台页面,点击“Create Pod”。

- 选择所需的GPU型号和配置,点击“Create”启动实例。

- 实例启动后,可以通过SSH或Web终端连接进行操作。

- 使用预配置环境:

- RunPod提供多种预配置的AI开发环境,如PyTorch、TensorFlow等。

- 在创建实例时,可以选择所需的环境模板,快速开始项目开发。

- 数据管理:

- RunPod提供集成的数据存储解决方案,可以在控制台中管理数据集。

- 支持数据的上传、下载和共享,确保数据安全和隐私保护。

- 协作与版本控制:

- 支持团队协作开发,可以邀请团队成员共同参与项目。

- 提供模型版本管理功能,方便跟踪和管理不同版本的模型。

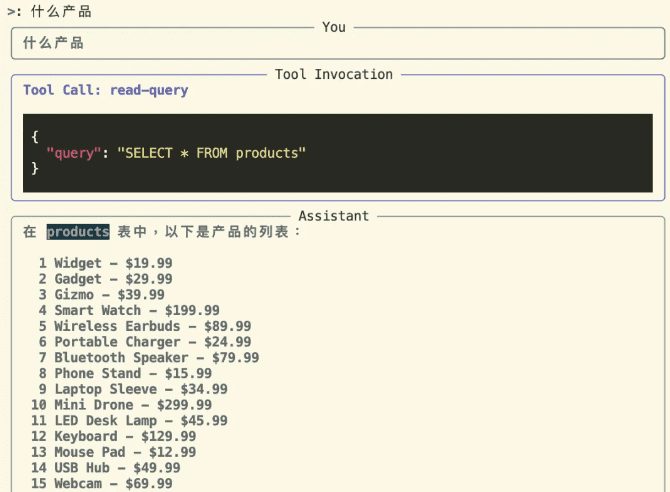

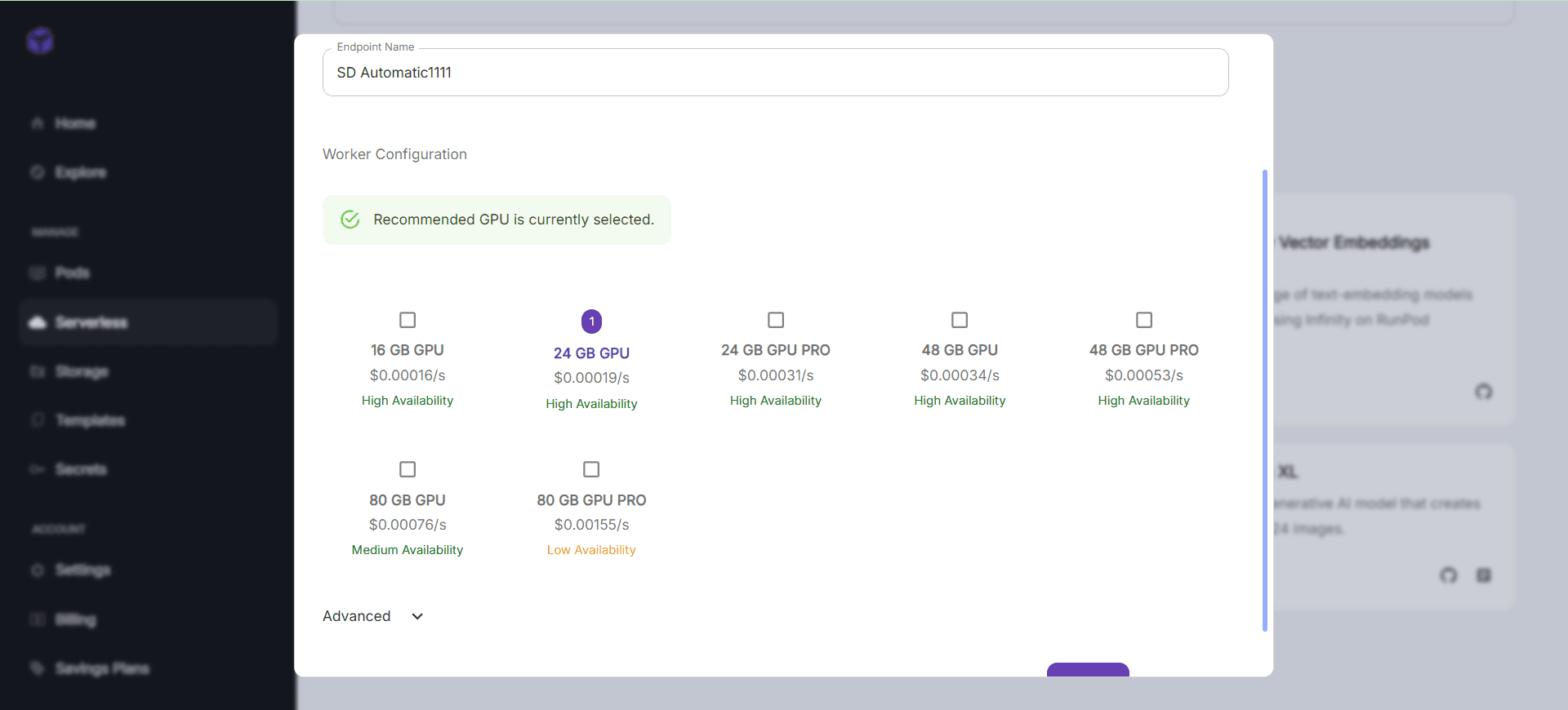

- 无服务器推理:

- RunPod支持无服务器架构,自动扩展推理能力。

- 可以在控制台中配置API端点,实现模型的在线推理服务。

操作流程

- 快速启动GPU实例:

- 登录控制台,选择“Create Pod”。

- 选择所需的GPU型号和配置,点击“Create”。

- 实例启动后,通过SSH或Web终端连接进行操作。

- 使用预配置环境:

- 在创建实例时,选择所需的环境模板。

- 连接实例后,可以直接使用预配置的开发环境进行项目开发。

- 数据管理:

- 在控制台中管理数据集,支持数据的上传、下载和共享。

- 确保数据安全和隐私保护。

- 协作与版本控制:

- 邀请团队成员共同参与项目,使用版本管理功能跟踪和管理模型版本。

- 无服务器推理:

- 在控制台中配置API端点,实现模型的在线推理服务。

- 自动扩展推理能力,高效处理变化的工作负载。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...