Chatbox功能的基础认知与准备

DeepSeek平台提供的Chatbox功能本质上是一个API接口调用系统,用户需要通过API方式与模型进行交互。创建聊天机器人前需要完成准备工作:

- 本地部署Ollana:见下方详细教程

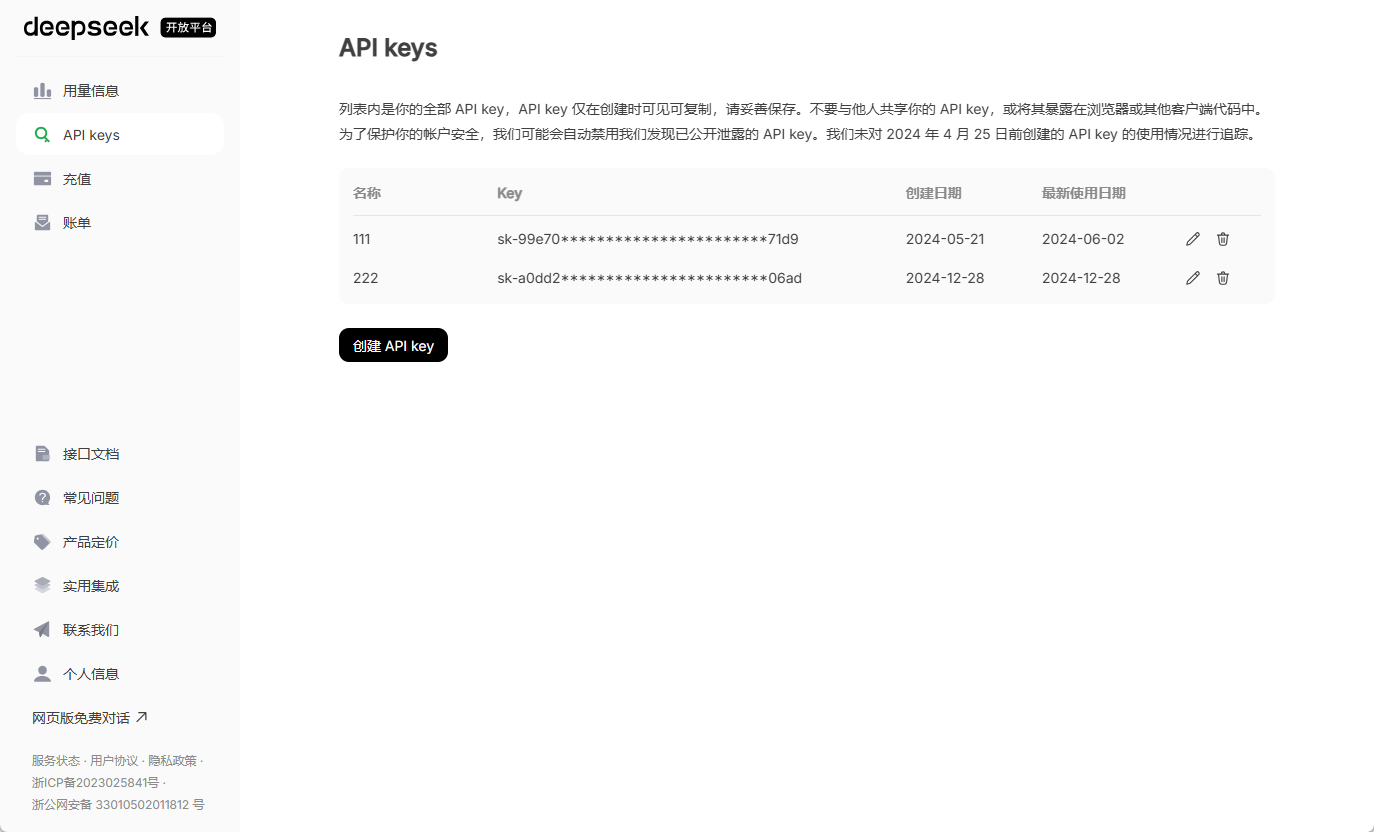

- 获取官方API密钥:访问DeepSeek官网创建账号并通过企业认证(个人开发者选择个人类型),在控制台的「凭证管理」模块生成专属API Key,密钥格式通常为ds-xxxxxxxxxxxxxxxxxxxxxxxx

要使用DeepSeek的ChatBox功能创建聊天机器人,可遵循以下步骤,结合本地部署与界面配置实现高效交互:

一、基础环境搭建

- 安装Ollama框架

Ollama是运行本地AI模型的轻量级框架,支持DeepSeek等开源模型。- 访问Ollama官网,根据系统选择安装包(Windows选.exe,Mac选.dmg)。

- 安装完成后,在终端输入

ollama list验证是否成功,若显示模型列表(如llama3)则说明安装完成。

- 部署DeepSeek模型

- 根据硬件配置选择模型版本:

- 低配设备:选择

1.5B或8B参数版本(需2GB以上显存)。 - 高性能设备:推荐

16B或更高版本(需16GB以上显存)。

- 低配设备:选择

- 在终端运行命令下载模型:

ollama run deepseek-r1:8b # 替换数字为所选参数版本首次运行需下载约5GB模型文件,需保持网络稳定。

- 根据硬件配置选择模型版本:

二、ChatBox界面配置

- 安装ChatBox工具

- 访问ChatBox官网,下载对应系统的安装包(Windows、Mac或Linux)。

- 安装后启动软件,进入设置界面。

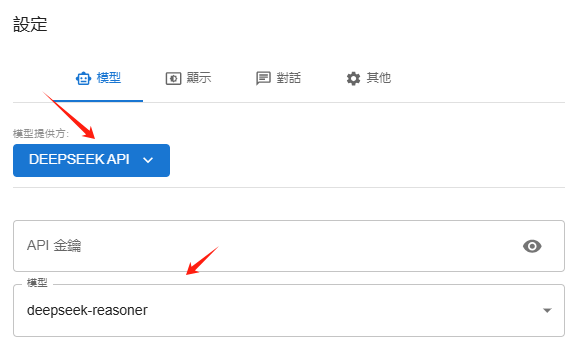

- 连接Ollama与DeepSeek模型

- 在ChatBox的“模型提供方”中选择 OLLAMA API。

- 填写API地址为默认的

http://localhost:11434(若未自动填充需手动输入)。 - 在“模型”下拉菜单中选择已安装的DeepSeek版本(如

deepseek-r1:8b)。

- 功能测试

- 返回主界面,输入问题(如“写一句新年祝福”),ChatBox会通过本地模型生成响应,实现无网络依赖的对话。

- Ollama配置

- DeepSeek官方API配置

三、进阶功能扩展

- 多模态交互与知识库集成

- 使用 Page Assist 等浏览器插件,可为本地模型添加联网搜索能力,支持从指定引擎获取实时信息。

- 通过上传PDF、TXT等文件至知识库,模型可结合本地数据生成更精准的回答(需配置嵌入模型如BERT)。

- 性能优化建议

- 硬件适配:若对话延迟高,可降低模型参数版本或升级显卡(推荐RTX 4080以上)。

- 隐私保护:本地部署避免数据上传,适合处理敏感信息。

四、常见问题解决

- 模型下载失败:检查网络连接,关闭防火墙或杀毒软件。

- ChatBox无响应:确认Ollama服务已启动(终端输入

ollama serve)。 - 显存不足:尝试较小模型或增加虚拟内存。

通过上述步骤,可快速搭建一个本地化、高隐私的DeepSeek聊天机器人。如需进一步定制功能(如网页集成),可参考API开发教程。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...