综合介绍

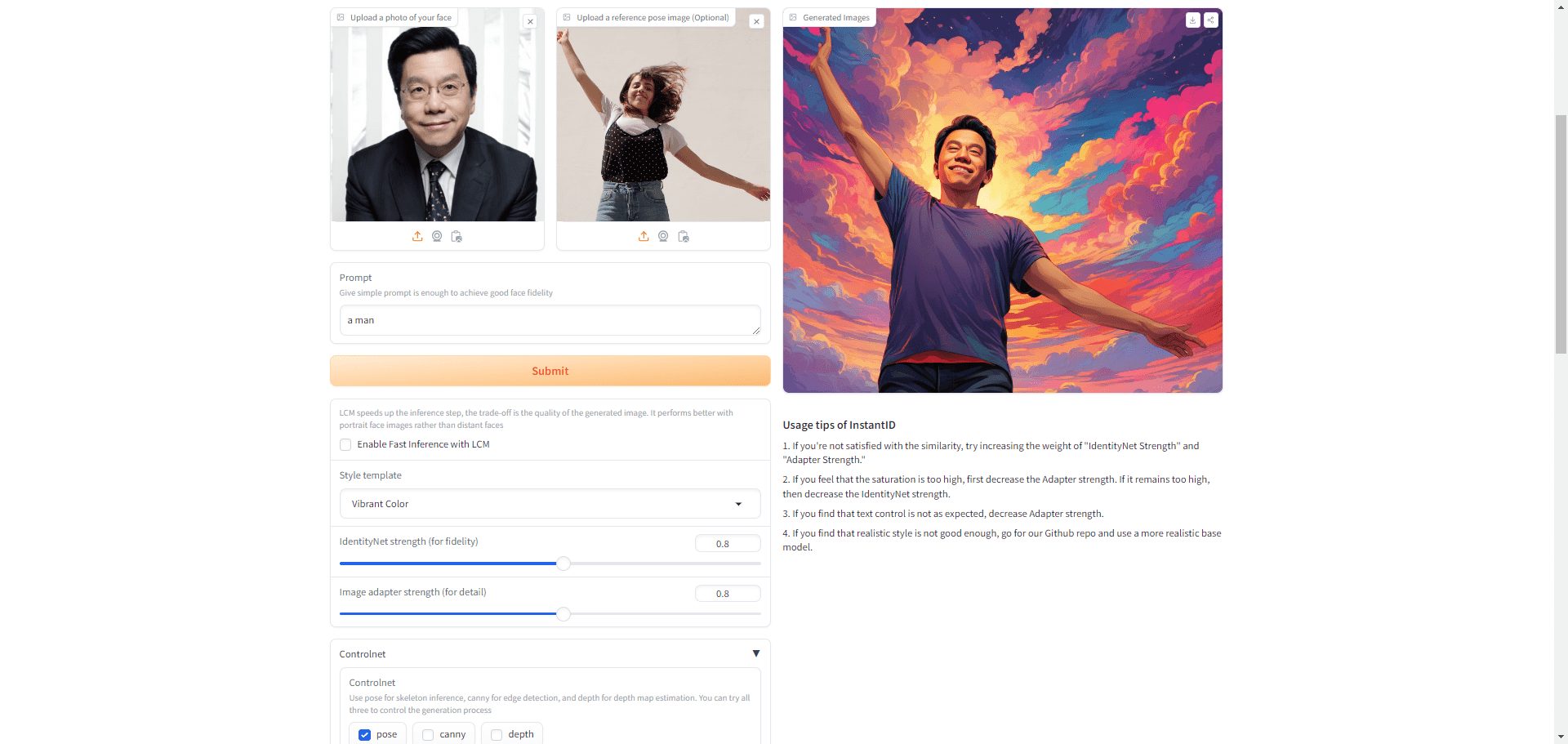

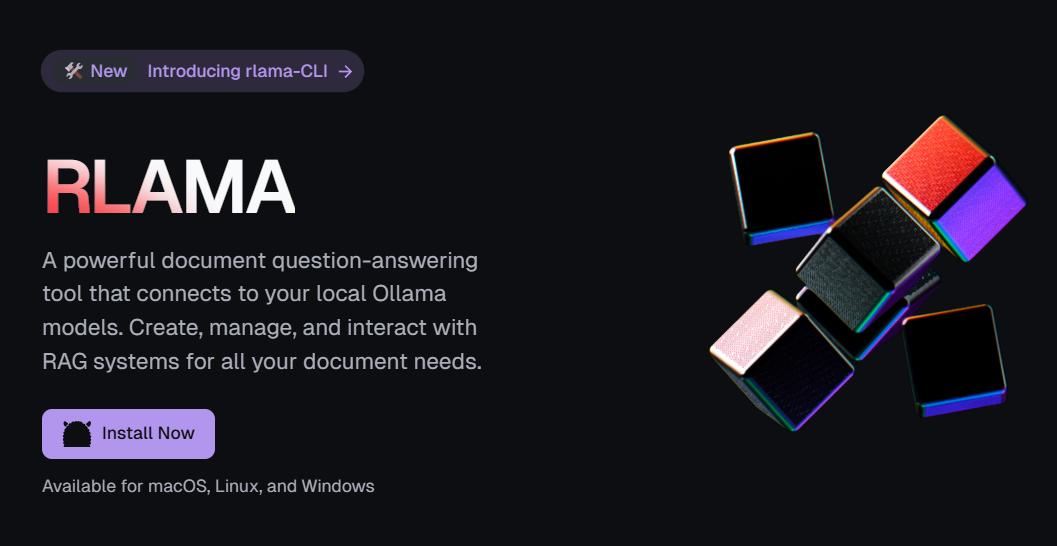

RLAMA 是一个由 DonTizi 开源开发并托管于 GitHub 的文档智能问答 RAG(检索增强生成)系统,其核心特色在于通过命令行操作实现功能。用户可以通过简洁的终端命令,连接本地 Ollama 模型,将文件夹中的文档快速索引为可交互的知识库,并进行智能问答。无论是代码文件、技术文档还是办公文件,RLAMA 都能胜任,且完全本地运行,无需云端服务,保障数据隐私。它支持多种文件格式,安装简便,特别适合习惯命令行操作的开发者和技术爱好者,是本地化文档管理的强大选择。

功能列表

- 命令行创建 RAG 系统:通过命令索引文件夹文档,生成智能问答知识库。

- 命令行交互问答:使用终端会话查询已有 RAG 系统中的文档内容。

- RAG 系统管理:通过命令列出、删除 RAG 系统,轻松维护知识库。

- 本地模型集成:无缝连接本地 Ollama 模型,保持完全本地化。

- 版本与更新管理:用命令查看版本或更新系统至最新状态。

- 多格式支持:兼容文本、代码和办公文档等多种格式。

- 命令行卸载:提供命令清理工具和数据。

使用帮助

安装流程

RLAMA 通过命令行实现文档智能问答,安装适用于 macOS、Linux 和 Windows。以下是详细步骤:

1. 前置条件

- 安装 Ollama:需本地运行 Ollama 模型。访问 Ollama 官网 下载安装,运行

ollama run llama3(或其他模型)确认可用,默认地址http://localhost:11434。 - 网络连接:安装时需联网下载脚本或依赖。

- 可选依赖:为支持更多格式(如 .pdf、.docx),建议运行

install_deps.sh安装工具(如pdftotext)。

2. 通过命令行脚本安装(推荐)

在终端输入:

curl -fsSL https://raw.githubusercontent.com/dontizi/rlama/main/install.sh | sh

- 脚本自动完成下载和配置,完成后运行

rlama --version检查版本(如v0.1.0)确认成功。

3. 手动源码安装(可选)

若需自定义:

- 克隆仓库:

git clone https://github.com/DonTizi/rlama.git cd rlama - 编译安装(需 Go 环境):

go build go install - 将可执行文件移至 PATH(如

/usr/local/bin),运行rlama --help验证。

4. 验证安装

运行:

rlama --help

显示命令列表即为成功。

主要功能操作流程

通过命令行创建 RAG 系统

将文档转化为智能问答知识库。例如,文件夹 ./docs 包含 readme.md 和 guide.pdf:

- 确保 Ollama 模型运行(如

ollama run llama3)。 - 输入命令:

rlama rag llama3 mydocs ./docsllama3:模型名称。mydocs:RAG 系统名称。./docs:文档路径。

- 输出示例:

Indexing documents in ./docs... Processed: readme.md Processed: guide.pdf RAG system "mydocs" created successfully!

通过命令行进行交互问答

查询已有 RAG 系统:

- 启动会话:

rlama run mydocs - 输入问题:

如何安装 rlama? - 获取回答:

可通过终端运行 `curl -fsSL https://raw.githubusercontent.com/dontizi/rlama/main/install.sh | sh` 安装。 - 输入

exit退出。

管理 RAG 系统

- 列出系统:

rlama list示例输出:

Available RAG systems: - mydocs - 删除系统:

rlama delete mydocs或跳过确认:

rlama delete mydocs --force

版本与更新

- 检查版本:

rlama --version或

rlama -v,显示如v0.1.0。 - 更新系统:

rlama update可加

--force强制更新。

卸载系统

- 移除工具:

rlama uninstall - 清理数据:数据存储在

~/.rlama,运行:rm -rf ~/.rlama

特色功能详解

1. 命令行操作

rlama 的所有功能通过命令行实现,简洁高效。例如,一行命令 rlama rag mistral docs ./project 即可索引整个文件夹,适合命令行熟练用户。

2. 多格式文档支持

支持多种文件类型:

- 文本:

.txt、.md、.html、.json、.csv等。 - 代码:

.go、.py、.js、.java、.cpp等。 - 文档:

.pdf、.docx、.pptx、.xlsx等。

运行./scripts/install_deps.sh增强支持。例如:

rlama rag gemma code-docs ./src

3. 本地化运行

数据处理全程本地,无需云端,适合敏感文档。例如,索引公司机密文件:

rlama rag llama3 contracts ./legal

使用技巧与故障排除

- 精准命令:输入完整参数,如

rlama run mydocs而非简写,确保准确性。 - Ollama 问题:若连接失败,检查

http://localhost:11434,运行ollama ps查看状态。 - 格式支持:若提取失败,运行

install_deps.sh安装依赖。 - 答案不佳:确认文档已索引,尝试更具体问题。

- 求助:问题可至 GitHub Issues 提交,附命令和版本。

通过以上命令,用户可快速掌握 rlama,管理本地文档并实现智能问答。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...