Ring-2.5-1T是什么

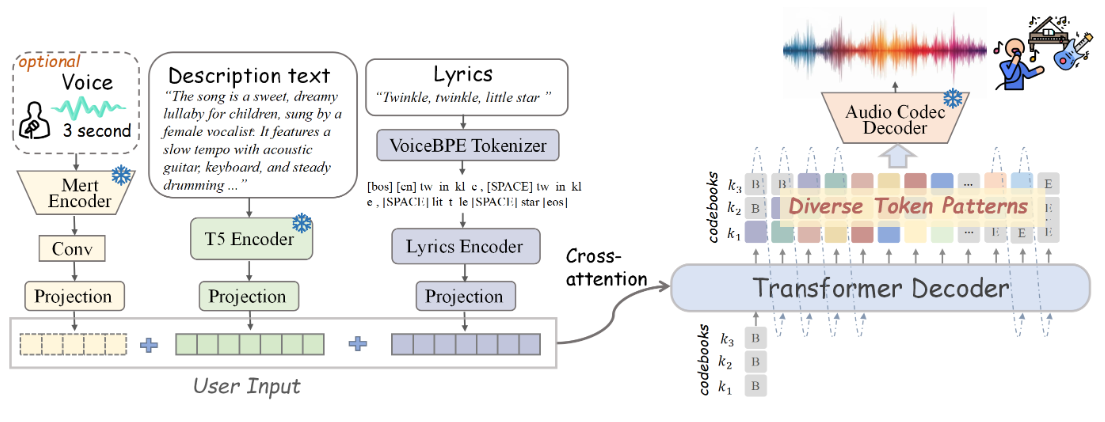

Ring-2.5-1T 是蚂蚁集团百灵大模型团队开源的全球首个万亿参数混合线性架构思考模型,采用1:7 MLA与Lightning Linear Attention混合设计,激活参数量达63B。模型在生成效率上实现突破:32K以上长文本生成时访存降低10倍、吞吐提升3倍,特别适合深度推理与长程任务。在数学能力方面,IMO 2025自测获35分(金牌水平),CMO 2025达105分(远超国家集训队线)。通过全异步智能体强化学习训练,Ring-2.5-1T可无缝适配Claude Code、OpenClaw等框架,在Gaia2-search、SWE-Bench Verified等长程执行基准上表现领先。模型已在Hugging Face和ModelScope开源,采用MIT协议,为开发者提供了可本地部署的顶级推理能力。

Ring-2.5-1T的功能特色

- 万亿参数混合架构:采用1:7 MLA与Lightning Linear Attention混合设计,激活参数63B,实现高效长文本生成。

- 超长上下文生成:32K以上文本生成时访存降低10倍、吞吐提升3倍,生成长度越长效率优势越明显。

- 顶级数学推理:IMO 2025获35分达金牌水平,CMO 2025获105分远超国家集训队入选线。

- 深度思考能力:引入dense reward密集奖励机制,强化思考过程的严谨性与准确性。

- 智能体长程执行:通过全异步Agentic RL训练,支持Claude Code、OpenClaw等框架的深度任务执行。

- 开源可部署:已在Hugging Face和ModelScope开源,采用MIT协议,支持FP8本地部署。

Ring-2.5-1T的核心优势

- 混合线性架构领先:全球首个万亿参数混合线性思考模型,1:7 MLA设计实现KV Cache高效压缩。

- 长文本生成效率极致:32K以上生成场景下访存降低10倍、吞吐提升3倍,突破传统Transformer瓶颈。

- 数学推理能力顶尖:IMO/CMO奥赛自测达金牌及国家集训队水平,代码与智能体任务开源领先。

- 异步Agent训练:大规模fully-async agentic RL训练,长程任务执行能力显著优于同类开源模型。

- 开源生态友好:MIT协议开源,无缝适配Claude Code、OpenClaw等主流智能体框架,降低接入门槛。

Ring-2.5-1T官网是什么

- GitHub仓库:https://github.com/inclusionAI/Ring-V2.5

- HuggingFace模型库:https://huggingface.co/inclusionAI/Ring-2.5-1T

Ring-2.5-1T的适用人群

- AI研究员与算法工程师:需要研究混合线性架构、长文本生成优化及大规模RL训练的前沿技术人员。

- 数学与竞赛教育从业者:寻求IMO/CMO级别解题能力、辅助数学教学与竞赛备战的教师和学生。

- 智能体开发者:构建Claude Code、OpenClaw等框架的深度任务执行Agent的开发者。

- 长文本处理需求者:从事法律文档分析、学术论文写作、代码审查等需要超长上下文生成的专业人士。

- 开源模型部署团队:具备A100/H100等高端算力资源、希望本地部署万亿参数模型的企业技术团队。

- AI应用产品经理:关注最新开源大模型能力边界、探索Agent商业化落地场景的产品决策者。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...