模型概览

近年来,基于混合专家系统(Mixture of Experts,MoE)架构的大模型训练成为人工智能领域的重要研究方向。Qwen团队近期发布的Qwen2.5-Max模型,采用超过20万亿token的预训练数据和精细化后训练方案,在MoE架构的规模化应用上取得突破性进展。该模型现可通过API接口或Qwen Chat平台进行体验。

技术特性

1. 模型架构创新

- 混合专家系统优化:通过动态路由机制实现计算资源的高效分配

- 多模态扩展能力:支持文本、结构化数据等多类型输入输出

- 上下文处理增强:最大输入30,720 tokens,可生成长达8,192 tokens的连续文本

2. 核心功能矩阵

| 功能维度 | 技术指标 |

|---|---|

| 多语言支持 | 覆盖29种语言(含中/英/法/西等) |

| 计算能力 | 复杂数学运算与代码生成 |

| 结构化处理 | JSON/表格数据生成与解析 |

| 上下文理解 | 8K tokens长文本连贯生成 |

| 应用适配性 | 对话系统/数据分析/知识推理 |

性能评估

指令模型对比

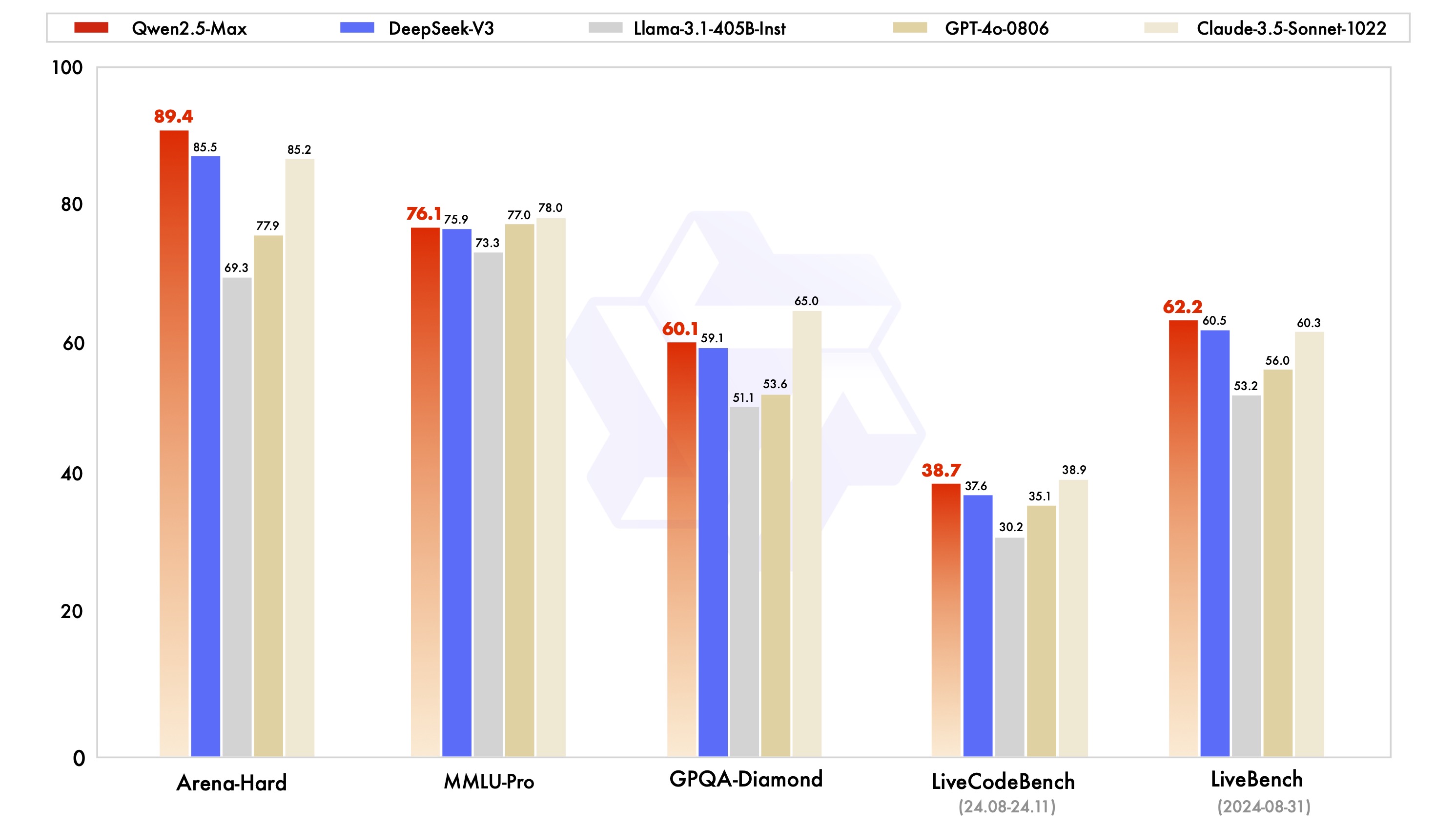

在MMLU-Pro(大学知识测试)、LiveCodeBench(编程能力评估)、Arena-Hard(人类偏好模拟)等基准测试中,Qwen2.5-Max展现出显著竞争力:

测试数据显示,该模型在编程能力(LiveCodeBench)和综合推理(LiveBench)等维度超越DeepSeek V3,在GPQA-Diamond高阶推理测试中达到顶尖水平。

基座模型对比

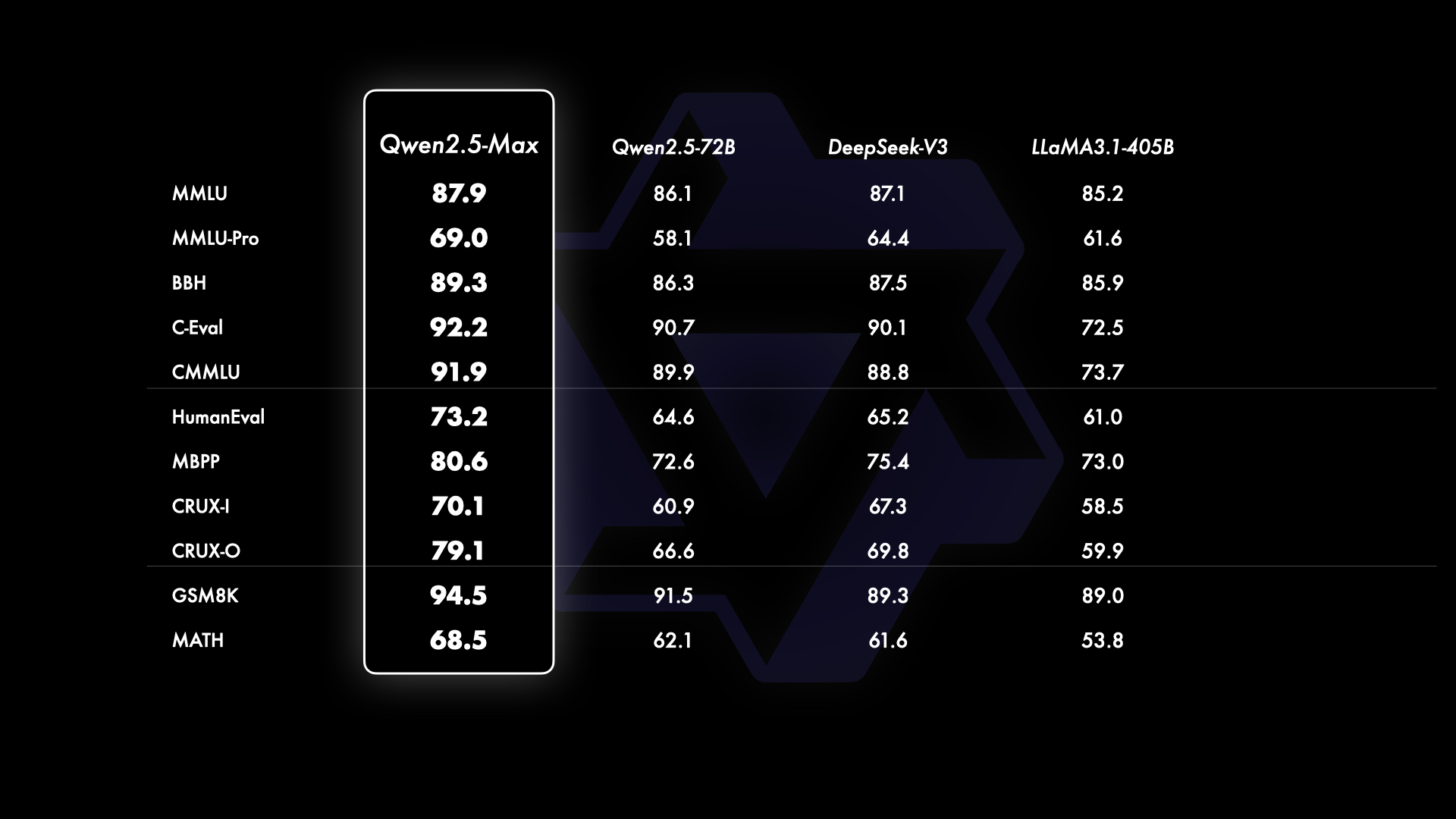

相较于主流开源模型,Qwen2.5-Max在基础能力层面展现技术优势:

对比参数规模达405B的Llama-3.1和720B参数的Qwen2.5-72B,Qwen2.5-Max在多数测试项保持领先,验证了MoE架构在模型规模化方面的有效性。

接入与使用

1. 云端API接入

from openai import OpenAI

import os

client = OpenAI(

api_key=os.getenv("API_KEY"),

base_url="https://dashscale.aliyuncs.com/compatible-mode/v1",

)

response = client.chat.completions.create(

model="qwen-max-2025-01-25",

messages=[

{'role':'system', 'content':'设定AI助手角色'},

{'role':'user', 'content':'输入查询内容'}

]

)

2. 交互式体验

- 访问Hugging Face演示空间

- 启动"运行"按钮加载模型

- 通过文本输入框进行实时交互

3. 企业级部署

- 注册阿里云账号

- 开通大模型服务平台

- 创建API密钥进行系统集成

技术演进方向

当前版本在以下方面持续优化:

- 后训练数据质量提升策略

- 多专家协同效率优化

- 低资源消耗的推理加速

- 多模态扩展接口开发

未来展望

持续提升数据规模和模型参数规模能够有效提升模型的智能水平。接下来,我们将持续探索,除了在 pretraining 的 scaling 继续探索外,将大力投入强化学习的 scaling,希望能实现超越人类的智能,驱动 AI 探索未知之境。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...