上周六,Triplegangers 的 CEO Oleksandr Tomchuk 接到通知,他公司的电商网站宕机了。这看起来像是某种分布式拒绝服务攻击。

他很快发现罪魁祸首是 OpenAI 的一个机器人,它正在不懈地尝试抓取他的整个庞大网站。

“我们有超过 65,000 种产品,每种产品都有一个页面,”Tomchuk 告诉 TechCrunch。“每个页面至少有三张照片。”

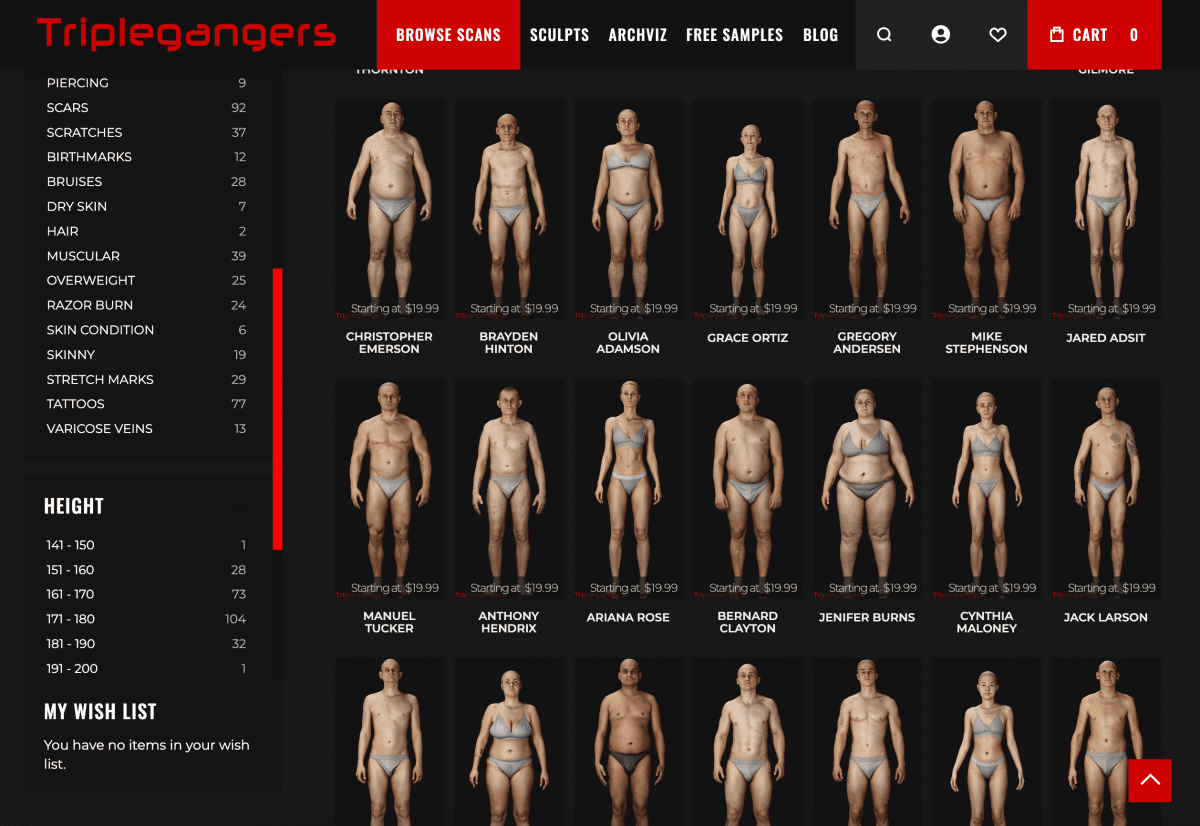

OpenAI 发送了“数以万计”的服务器请求,试图下载所有这些内容,包括数十万张照片以及它们的详细描述。

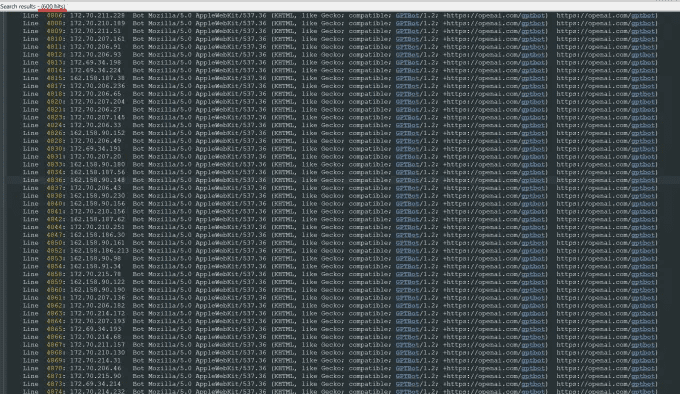

“OpenAI 使用了 600 个 IP 来抓取数据,我们仍在分析上周的日志,也许数量更多,”他在谈到该机器人用来尝试访问他网站的 IP 地址时说道。

“他们的爬虫正在摧毁我们的网站,”他说,“这基本上是一次 DDoS 攻击。”

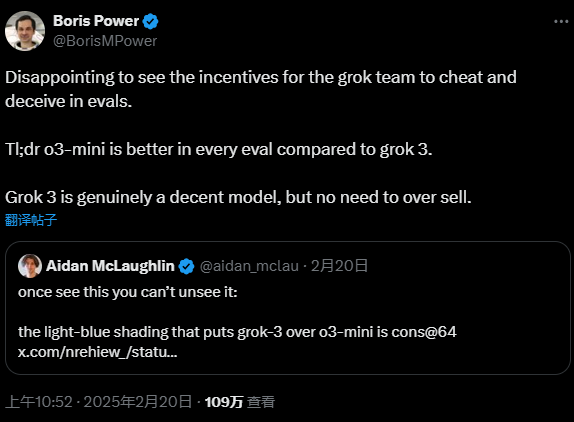

Triplegangers 的网站是它的业务。这家拥有七名员工的公司花费了十多年的时间组建了它所谓的网络上最大的“人类数字替身”数据库,这意味着从实际人体模型扫描的 3D 图像文件。

它向 3D 艺术家、视频游戏制作人以及任何需要以数字方式重建真实人体特征的人出售 3D 对象文件以及照片——从手到头发、皮肤和全身的一切。

Tomchuk 的团队总部设在乌克兰,但也在美国佛罗里达州坦帕市获得了许可,其网站上有一个 服务条款页面,禁止机器人在未经允许的情况下获取其图像。但这本身并没有任何作用。网站必须使用正确配置的 robot.txt 文件,其中包含明确告知 OpenAI 的机器人 GPTBot 不要访问该网站的标签。(OpenAI 还有其他几个机器人,ChatGPT-User 和 OAI-SearchBot,它们有自己的标签,根据其关于爬虫的信息页面)。

Robot.txt,也称为 Robots Exclusion Protocol(机器人排除协议),旨在告诉搜索引擎网站不要抓取哪些内容,因为它们会索引网络。OpenAI 在其信息页面上表示,当配置了自己的禁止抓取标签时,它会遵守此类文件,尽管它也警告说,它的机器人可能需要长达 24 小时才能识别更新的 robot.txt 文件。

正如 Tomchuk 所经历的那样,如果一个网站没有正确使用 robot.txt,OpenAI 和其他公司会认为这意味着他们可以随意抓取内容。这不是一个选择加入的系统。

更糟糕的是,Triplegangers 不仅在 U.S. 营业时间被 OpenAI 的机器人搞得下线,而且 Tomchuk 预计由于该机器人的所有 CPU 和下载活动,AWS 账单会大幅增加。

Robot.txt 也不是万无一失的。AI 公司自愿遵守它。另一家 AI 初创公司 Perplexity,去年夏天因《连线》杂志的一项调查而声名狼藉 当一些证据暗示 Perplexity 没有 遵守它时。

无法确定哪些内容被获取

到周三,在 OpenAI 的机器人返回几天后,Triplegangers 已经正确配置了 robot.txt 文件,并设置了一个 Cloudflare 帐户来阻止其 GPTBot 和他发现的其他几个机器人,如 Barkrowler(一个 SEO 爬虫)和 Bytespider(TikTok 的爬虫)。Tomchuk 也希望他已经阻止了其他 AI 模型公司的爬虫。他说,周四早上,该网站没有崩溃。

但是 Tomchuk 仍然没有合理的方法来确切地找出 OpenAI 成功获取了什么内容或删除该材料。他找不到联系 OpenAI 并询问的方法。OpenAI 没有回应 TechCrunch 的置评请求。而且 OpenAI 到目前为止 未能交付其长期承诺的退出工具,正如 TechCrunch 最近报道的那样。

这对 Triplegangers 来说尤其是一个棘手的问题。“我们所从事的业务中,权利是一个严重的问题,因为我们扫描的是真人,”他说。根据欧洲的 GDPR 等法律,“他们不能只是在网络上拍摄任何人的照片并使用它。”

Triplegangers 的网站对 AI 爬虫来说也是一个特别美味的发现。价值数十亿美元的初创公司,如 Scale AI,已经成立,人类在其中费力地标记图像以训练 AI。Triplegangers 的网站包含详细标记的照片:种族、年龄、纹身与疤痕、所有体型等等。

具有讽刺意味的是,OpenAI 机器人的贪婪正是提醒 Triplegangers 意识到它有多么暴露。他说,如果它抓取得更温和,Tomchuk 永远不会知道。

“这很可怕,因为这些公司似乎正在利用一个漏洞来爬取数据,他们说‘如果你用我们的标签更新你的 robot.txt,你可以选择退出’,”Tomchuk 说,但这将责任推给了企业主,让他们了解如何阻止它们。

他希望其他小型在线企业知道,发现 AI 机器人是否正在获取网站受版权保护的内容的唯一方法是积极查找。他肯定不是唯一一个被它们恐吓的人。其他网站的所有者最近告诉 Business Insider,OpenAI 的机器人如何摧毁他们的网站并增加了他们的 AWS 账单。

2024 年,这个问题的严重性成倍增长。数字广告公司 DoubleVerify 的一项新研究 发现,AI 爬虫 和抓取工具导致 2024 年“一般无效流量”增加了 86%——也就是说,流量不是来自真实用户。

尽管如此,“大多数网站仍然不知道它们被这些机器人抓取了,”Tomchuk 警告说。“现在我们必须每天监控日志活动,以发现这些机器人。”

当你考虑到这一点时,整个模式的运作方式有点像黑手党的敲诈勒索:除非你有保护,否则 AI 机器人会拿走它们想要的东西。

“他们应该征求许可,而不是只是抓取数据,”Tomchuk 说。

相关阅读

1.OpenAI 推出了一款名为GPTBot的新网络爬虫工具,以应对公共网站数据收集引发的隐私和知识产权问题。该技术旨在透明地收集公共网络数据并将其用于训练其 AI 模型,所有这些都在 OpenAI 的旗帜下进行。

2.OpenAI 使用网络爬虫(“机器人”)和用户代理为其产品执行操作,这些操作要么是自动的,要么是由用户请求触发的。OpenAI 使用以下 robots.txt 标签,使网站管理员能够管理其网站和内容如何与 AI 配合使用。每个设置都独立于其他设置 - 例如,网站管理员可以允许 OAI-SearchBot 出现在搜索结果中,同时禁止 GPTbot 以表明抓取的内容不应用于训练 OpenAI 的生成式 AI 基础模型。对于搜索结果,请注意,从网站的 robots.txt 更新到我们的系统可能需要大约 24 小时才能进行调整。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...