之前出了很多期关于 Ollama 安装部署的教程,信息较为零散,这次一步到位整理出完整的面向本地电脑使用 Ollama 的完整教学。教学面向初级使用者避免踩坑,有能力推荐阅读 Ollama 官方说明文档。接下来我会一步步指导安装并使用 Ollama。

本地安装大模型为什么选择 Ollama

很多新人和我一样不理解,网上有其他性能更好的大模型部署工具,比如:盘点与 Ollama 类似的 LLM 框架:本地部署大模型的多元选择 ,最后为什么推荐安装 Ollama ?

首先当然是个人电脑安装简单啦,但其中最重要的一点是,面向单机部署模型性能、参数优化更好,安装不容易出错。举个例子,同配置电脑安装 QwQ-32B 使用 Ollama 可能使用流畅,换成“更强大的” llama.cpp 可能会卡,甚至输出的答案都不对。这背后原因有很多,我也解释不清楚,就不解释了,只需要知道 Ollama 底层就包含 llama.cpp ,因为优化的更好,反而运行起来比 llama.cpp 更稳定。

Ollama 可以运行哪类大模型文件

Ollama支持以下两种格式的模型文件,并通过不同的推理引擎进行支持:

- GGUF 格式:通过

llama.cpp进行推理。 - safetensors 格式:通过

vllm进行推理。

这意味着:

- 如果使用 GGUF 格式的模型,Ollama 会调用

llama.cpp进行高效的 CPU/GPU 推理。 - 如果使用 safetensors 格式的模型,Ollama 会利用

vllm,通常依赖于 GPU 进行高性能推理。

当然你并不需要关心,仅做了解,其实你安装的绝大多数都是 GGUF 格式的文件。为什么特意强调 GGUF 呢?

GGUF 支持 量化(如 Q4、Q6_K),能够在极低的显存和内存占用下保持较好的推理性能,而 safetensors 通常是完整的 FP16/FP32 模型,体积更大、占用资源更多。可以在这里了解更多:模型量化是什么:FP32, FP16, INT8, INT4 数据类型详解。

Ollama 最低配置要求

操作系统: Linux:Ubuntu 18.04 或更高版本,macOS:macOS 11 Big Sur 或更高版本

RAM: 8GB 用于运行 3B 模型,16GB 用于运行 7B 模型,32GB 用于运行 13B 模型

磁盘空间: 12GB 用于安装 Ollama 和基本模型,存储模型数据所需的额外空间,具体取决于您使用的模型。C盘建议预留6G空间。

CPU: 建议使用至少 4 核的任何现代 CPU,对于运行 13B 模型,建议使用至少 8 核的 CPU。

GPU(可选): 运行 Ollama 不需要 GPU,但它可以提高性能,尤其是运行较大的模型。如果您有 GPU,可以使用它来加速 定制模型的训练。

安装 Ollama

进入:https://ollama.com/download

根据电脑环境选择就好,安装十分简单,这里唯一要注意的事项就是网络环境可能导致无法正常安装。

macOS安装:https://ollama.com/download/Ollama-darwin.zip

Windows安装:https://ollama.com/download/OllamaSetup.exe

Linux安装:curl -fsSL https://ollama.com/install.sh | sh

Docker镜像:(请自行在官网学习)

CPU 或者 Nvidia GPU:docker pull ollama/ollama

AMD GPU:docker pull ollama/ollama:rocm

安装完成后你会在桌面右下角看到 Ollama 的图标,如果图标中出现绿色提醒,表示需要升级。

Ollama 设置

Ollama 安装十分简单,但大多数设置需要修改“环境变量”,对新人十分不友好,我列出所有变量供需要的朋友参考(不需要记住):

| 参数 | 标识与配置 |

|---|---|

| OLLAMA_MODELS | 表示模型文件的存放目录,默认目录为当前用户目录即 C:\Users%username%.ollama\modelsWindows 系统 建议不要放在C盘,可放在其他盘(如 E:\ollama\models) |

| OLLAMA_HOST | 表示ollama 服务监听的网络地址,默认为127.0.0.1 如果想要允许其他电脑访问 Ollama(如局域网中的其他电脑),建议设置成 0.0.0.0 |

| OLLAMA_PORT | 表示ollama 服务监听的默认端口,默认为11434 如果端口有冲突,可以修改设置成其他端口(如8080等) |

| OLLAMA_ORIGINS | 表示HTTP 客户端的请求来源,使用半角逗号分隔列表 如果本地使用不受限制,可以设置成星号 * |

| OLLAMA_KEEP_ALIVE | 表示大模型加载到内存中后的存活时间,默认为5m即 5 分钟 (如纯数字300 代表 300 秒,0 代表处理请求响应后立即卸载模型,任何负数则表示一直存活) 建议设置成 24h ,即模型在内存中保持 24 小时,提高访问速度 |

| OLLAMA_NUM_PARALLEL | 表示请求处理的并发数量,默认为1 (即单并发串行处理请求) 建议按照实际需求进行调整 |

| OLLAMA_MAX_QUEUE | 表示请求队列长度,默认值为512 建议按照实际需求进行调整,超过队列长度的请求会被抛弃 |

| OLLAMA_DEBUG | 表示输出 Debug 日志,应用研发阶段可以设置成1 (即输出详细日志信息,便于排查问题) |

| OLLAMA_MAX_LOADED_MODELS | 表示最多同时加载到内存中模型的数量,默认为1 (即只能有 1 个模型在内存中) |

1.修改大模型文件下载目录

在Windows系统中,Ollama下载的模型文件默认存放在用户文件夹下的特定目录中。具体来说,默认路径通常为C:\Users\<用户名>\.ollama\models。这里,<用户名>指的是当前Windows系统的登录用户名。

例如,如果系统登录用户名为yangfan,则模型文件的默认存储路径可能是C:\Users\yangfan\.ollama\models\manifests\registry.ollama.ai。在这个目录下,用户可以找到通过Ollama下载的所有模型文件。

注:较新系统安装路径一般是:C:\Users\<用户名>\AppData\Local\Programs\Ollama

大模型下载动辄几个G,如果你的C盘空间较小,第一步要做的就是修改大模型文件的下载目录。

1.找到环境变量的入口

最简单的方法:Win+R 打开运行窗口,输入 sysdm.cpl,回车打开系统属性,选择高级选项卡,点击环境变量。

其他方法:

1.开始->设置->关于->高级系统设置->系统属性->环境变量。

2.此电脑->右键->属性->高级系统设置->环境变量。

3.开始->控制面板->系统和安全->系统->高级系统设置->系统属性->环境变量。

4.桌面底部搜索框->输入->环境变量

进入后会看到以下界面:

2.修改环境变量

在系统变量中寻找变量名称OLLAMA_MODELS,没有则点击新建

如果已存在OLLAMA_MODELS ,选中后双击鼠标左键,或选中后单击“编辑”

变量值修改为新的目录,这里我已经提前从C盘修改为磁盘空间较大的E盘。

保存后,建议从新启动电脑,再使用,更稳妥。

2.修改默认访问地址和端口

在浏览器输入网址:http://127.0.0.1:11434/ ,会看到以下信息,表示正在运行,这里有一些安全风险,需要修改,依然在环境变量中修改。

1.修改OLLAMA_HOST

没有则新增,如果是0.0.0.0允许外网访问,修改为127.0.0.1

2.修改OLLAMA_PORT

没有则新增,11434修改为任意端口,比如:11331(端口修改范围从1~65535),从1000以后数字开始修改可以避免端口冲突。注意用英文":"

记得重启电脑,关于Ollama的安全问题,推荐阅读:DeepSeek 带火 Ollama,你的本地部署安全吗?警惕算力被“盗用”!

安装大模型

进入网址:https://ollama.com/search

选择模型,选择模型尺寸,复制命令

进入命令行工具

粘贴命令即可自动安装

这里正在下载,如果下载速度较慢,考虑换一个开心的上网环境

如果你想下载 Ollama 没有提供的大模型,当然也可以,绝大多数模型都是 huggingface 上的 GGUF 文件,我以一个特殊量化版的 DeepSeek-R1 32B 为例进行安装演示。

1.安装huggingface量化版本模型的基础命令格式

记住以下安装命令格式

ollama run hf.co/{username}:{reponame}

2.选择量化版本

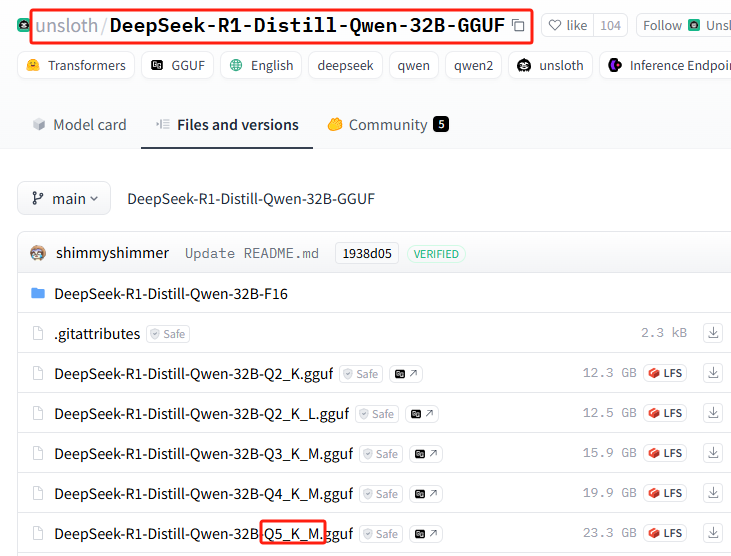

所有量化版本列表:https://huggingface.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF/tree/main

此次安装使用:Q5_K_M

3.拼接安装命令

{username}=unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF

{reponame}=Q5_K_M

拼接后得到完整安装命令:ollama run hf.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

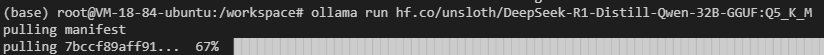

4.在 Ollama 中执行安装

执行安装命令

你可能会遇到网络故障(祝你好运),多重复几次安装命令...

还是不行?执行以下命令试试,hf.co/部分修改为https://hf-mirror.com/(切换为国内镜像地址),最后拼接的完整安装命令如下:

ollama run https://hf-mirror.com/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

此部分完整教程可参考:无需本地GPU即可私有化部署 DeepSeek-R1 32B

Ollama 基础命令

| 命令 | 描述 |

|---|---|

ollama serve | 启动 Ollama |

ollama create | 从 Modelfile 创建模型 |

ollama show | 显示模型信息 |

ollama run | 运行模型 |

ollama stop | 停止正在运行的模型 |

ollama pull | 从注册表中拉取模型 |

ollama push | 将模型推送到注册表 |

ollama list | 列出所有模型 |

ollama ps | 列出正在运行的模型 |

ollama cp | 复制模型 |

ollama rm | 删除模型 |

ollama help | 显示任意命令的帮助信息 |

| 标志 | 描述 |

|---|---|

-h, --help | 显示 Ollama 的帮助信息 |

-v, --version | 显示版本信息 |

多行输入命令时,可以使用 """ 进行换行。

使用 """ 结束换行。

终止 Ollama 模型推理服务,可以使用 /bye。

在本地AI对话工具中使用Ollama

主流本地AI对话工具绝大多数已默认适配 Ollama ,不需要进行任何设置。比如 Page Assist 、OpenwebUI 。

但有些本地AI对话工具需要自己输入API地址,http://127.0.0.1:11434/:(注意端口是否修改)

有些网页版的AI对话工具当然也支持配置,例如 NextChat :

如果想让本地电脑运行的 Ollama 完全暴露在外网使用,请自行学习cpolar或ngrok,这已经超出初级使用的范畴。

文章看似很长,其实里面就4个很简单的知识点,学会以后未来使用 Ollama 基本畅通无阻,让我们再次回顾:

1.设置环境变量

2.安装大模型的两种方式

3.记住基础运行、删除模型命令

4.在不同客户端中使用

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...