Ollama 综合介绍

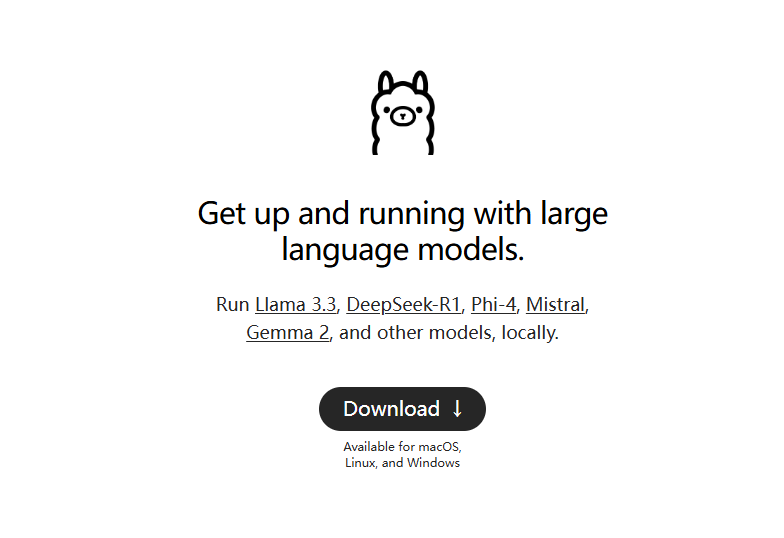

ollama是一个轻量级的本地语言模型运行框架,让用户能够容易地搭建和运行大型语言模型。它提供多种快速开始和安装选项,支持Docker,包含了丰富的库供用户选择。它的使用方法简单,提供了REST API,并有多种与社区整合的插件和扩展。

ollama是纯命令行工具,个人电脑使用,推荐部署本地聊天界面,比如:Open WebUI 、Lobe Chat、NextChat

修改默认安装目录:https://github.com/ollama/ollama/issues/2859

Ollama 功能列表

快速搭建和运行大型语言模型

支持macOS、Windows、Linux系统

提供ollama-python、ollama-js等库

包括Llama 2, Mistral, Gemma等预构建模型

支持本地和Docker两种安装方式

提供自定义模型功能

支持从GGUF和PyTorch转换模型

提供CLI操作指南

提供REST API支持

常用ollama命令

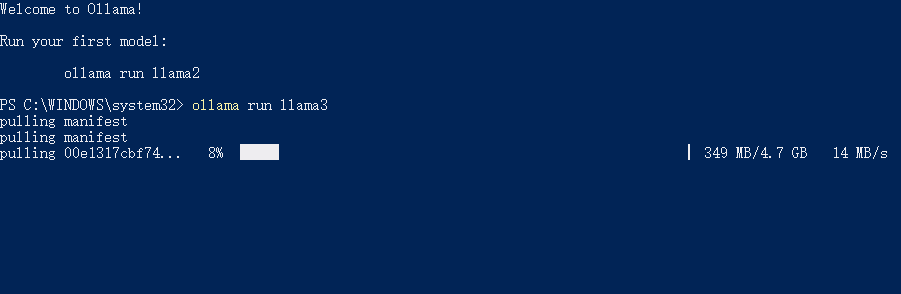

拉取模型:ollama pull llama3.1

运行模型:ollama run llama3.1

删除模型:ollama rm llama3.1

列出所有可用模型:ollama list

查询API服务地址:ollama serve(默认http://localhost:11434/)

Ollama 使用帮助

通过ollama网站和GitHub页面获取安装脚本和指南

使用提供的Docker镜像进行安装

通过CLI操作进行模型创建、拉取、移除和复制

初始化和运行本地构建

运行模型并与其交互

Ollama 支持的部分模型

| Model | Parameters | Size | Download |

|---|---|---|---|

| Llama 2 | 7B | 3.8GB | ollama run llama2 |

| Mistral | 7B | 4.1GB | ollama run mistral |

| Dolphin Phi | 2.7B | 1.6GB | ollama run dolphin-phi |

| Phi-2 | 2.7B | 1.7GB | ollama run phi |

| Neural Chat | 7B | 4.1GB | ollama run neural-chat |

| Starling | 7B | 4.1GB | ollama run starling-lm |

| Code Llama | 7B | 3.8GB | ollama run codellama |

| Llama 2 Uncensored | 7B | 3.8GB | ollama run llama2-uncensored |

| Llama 2 13B | 13B | 7.3GB | ollama run llama2:13b |

| Llama 2 70B | 70B | 39GB | ollama run llama2:70b |

| Orca Mini | 3B | 1.9GB | ollama run orca-mini |

| Vicuna | 7B | 3.8GB | ollama run vicuna |

| LLaVA | 7B | 4.5GB | ollama run llava |

| Gemma | 2B | 1.4GB | ollama run gemma:2b |

| Gemma | 7B | 4.8GB | ollama run gemma:7b |

Ollama 下载

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

Related posts

暂无评论...