Nvidia's GeForce RTX 40 series GPU.

如果你拥有一张GeForce RTX 30系列或更新款GPU,这款名为"与RTX聊天"的演示应用能够实现不需要互联网连接的个性化内容服务。

Nvidia推出了Chat with RTX,一款AI聊天机器人,能够在配备至少8GB VRAM的RTX 30或40系列显卡的任何PC上运行。

另外还支持检索、摘要本地文档或者YouTube视频。

推荐阅读:[全球最佳AI聊天机器人:ChatGPT及其他备选]

由Nvidia的TensorRT-LLM软件提供动力的这款应用,不仅能生成内容,还能根据用户提供的资料进行学习,支持的文件类型包括.txt、.pdf、.doc/.docx、.xml,并且可以链接YouTube视频的URL。

用户在选择了用于训练机器人的内容后,可以针对这些内容向它提出定制化的问题。比如,这个机器人能够概述YouTube教学视频里的步骤说明,或者告诉用户他们购物清单中记录的是哪种电池。

机器人基于用户喜好的内容进行训练,让整个体验变得更为私人定制。而数据的本地化处理则确保了用户信息的私密性。"与RTX聊天"由于不依赖于云服务,即便在无网环境下也能快速响应,保障了用户数据的安全。

另见:[ChatGPT 与 Copilot 比较:哪个AI聊天机器人更适合你?]

要运行这款聊天机器人,你需要Nvidia的GeForce RTX 30系列或更高配置的GPU,并至少拥有8GB显存。"与RTX聊天"还要求安装Windows 10或11操作系统以及最新的Nvidia GPU驱动。

Nvidia 表明,其 TensorRT-LLM 软件结合检索增强式生成技术(RAG)和RTX加速功能,允许"与RTX聊天"在不依赖网络的情况下,通过使用本地文件作为知识库并结合诸如 Mistral 和 Llama 2 这样的开源大型语言模型(LLM)来提供精准的答案。

Chat with RTX 评测

Nvidia今日发布了其[Chat with RTX]的早期版本——一款演示应用程序,让你能在个人电脑上运行自己的AI聊天机器人。无论是YouTube视频还是个人文档,都能用来生成摘要或获取基于个人数据的相关答案。整个过程完全在本地电脑上进行,你只需要一张拥有至少8GB VRAM的RTX 30或40系列显卡即可。

我在过去一天简单试用了Chat with RTX,尽管应用尚显粗糙,我已经能看到其成为数据研究的有价值工具的潜力,无论是对记者还是需要分析众多文档的任何用户而言。

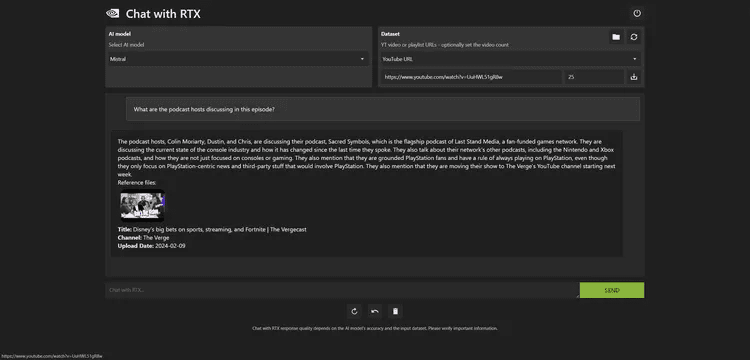

Chat with RTX支持处理YouTube视频,你只需输入视频URL,它便能让你搜索特定字幕或总结整个视频。这对我搜索视频播客特别有用,尤其是在寻找最近一周有关Microsoft新Xbox战略转变传闻中的特定内容时。

然而,在搜索YouTube视频方面并非完美无缺。尝试搜索一段_Verge_的YouTube视频字幕时,Chat with RTX却下载了一个完全不同视频的字幕,这显然是早期版本中的一个漏洞。

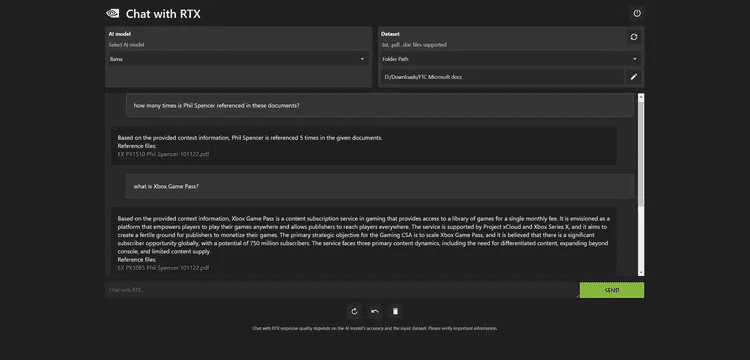

图一:Chat with RTX擅长于搜索本地文档。

当其正常工作时,我能够在几秒内找到视频中的相关内容。我还使用Chat with RTX分析了_FTC对Microsoft_的案件文档集。去年在报道此案件时,迅速浏览大量

文档是一大挑战,但Chat with RTX使我能够几乎瞬间完成查询。

例如,该聊天机器人能够从审判公开的内部文件中,精准总结出Microsoft的Xbox Game Pass策略:

根据提供的背景信息,Xbox Game Pass是一个游戏内容订阅服务,通过支付单一月费即可访问游戏库。它旨在成为一个平台,使玩家能够在任何地方游玩自己的游戏,同时让发行商能够触及全球玩家。该服务得到了Project xCloud和Xbox Series X的支持,目标是为发行商提供一个他们的游戏能够实现变现的良好环境。游戏CSA的核心战略目标是扩大Xbox Game Pass的规模,全球有着高达7.5亿的潜在订阅者市场。该服务面临三个主要的内容挑战:需求有差异化的内容、扩展到控制台之外的平台、以及内容供应有限。

我还发现这个工具能够帮助快速扫描PDF文档和核实数据。尽管Microsoft自家的Copilot系统处理Word内的PDF文件并不理想,但Nvidia的Chat with RTX能够轻松提取所有关键信息,并且反应速度快到几乎无感知延迟,这与使用基于云的ChatGPT或Copilot聊天机器人时的体验截然不同。

Chat with RTX的主要缺陷在于它真的给人一种初期开发者演示版的感觉。实际上,Chat with RTX在你的PC上安装了一个Web服务器和Python实例,通过Mistral或Llama 2模型处理输入的数据,再利用Nvidia的Tensor核心通过RTX GPU加速查询过程。

图二:Chat with RTX的准确性有时会有所偏差。

在我的PC上,配备Intel Core i9-14900K处理器和RTX 4090 GPU,安装Chat with RTX大约需要30分钟。应用程序体积近40GB,Python实例占用大约3GB的RAM,而我的系统共有64GB RAM。一旦运行起来,你可以通过浏览器访问Chat with RTX,后台则通过命令提示符显示处理过程和任何错误代码。

Nvidia并未将其作为所有RTX用户都应立即下载并安装的成熟应用程序推出。该应用存在一些已知的问题和局限性,包括源头归因可能不总是准确。我最初尝试让它索引25,000份文档,但这导致应用崩溃,必须清除偏好设置才能重新启动。

此外,Chat with RTX不会记住之前的上下文,因此后续问题不能基于先前问题的上下文进行。它还会在索引文件夹内创建JSON文件,因此我不建议在Windows的Documents文件夹中全盘使用此功能。

尽管如此,我仍然对这样的技术演示抱有极大兴趣,Nvidia在这方面确实展现了潜力。这预示了未来AI聊天机器人在个人电脑上本地运行的可能性,特别是对于那些不愿订阅像Copilot Pro或ChatGPT Plus这类服务来分析个人文件的用户而言。

Chat with RTX 下载地址

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...