综合介绍

NSFW Detector 是一个基于 AI 的不适内容检测工具,主要用于检测图像、视频、PDF 文件等是否包含不适内容。该工具采用了 Falconsai/nsfwimagedetection 模型,并使用 Google 的 vit-base-patch16-224-in21k 模型进行检测。NSFW Detector 支持 CPU 运行,无需 GPU,适用于大多数服务器。它通过 API 提供服务,便于与其他应用集成,并支持 Docker 部署,适合分布式部署。该工具具有高准确性和数据安全性,能够在本地运行,保护用户数据。

功能列表

- AI检测:基于 AI 模型,提供高准确性的不适内容检测。

- 多文件类型支持:支持检测图像、视频、PDF 文件和压缩包内的文件。

- CPU运行:无需 GPU 支持,适用于大多数服务器。

- API服务:通过 API 提供检测服务,便于与其他应用集成。

- Docker部署:支持 Docker 部署,适合分布式部署。

- 本地运行:保护用户数据安全,检测过程在本地完成。

使用帮助

安装与部署

- Docker 部署:

- 启动 API 服务器:

bash

docker run -d -p 3333:3333 --name nsfw-detector vxlink/nsfw_detector:latest - 如果需要检测服务器本地路径的文件,可以将路径挂载到容器中:

bash

docker run -d -p 3333:3333 -v /path/to/files:/path/to/files --name nsfw-detector vxlink/nsfw_detector:latest

- 启动 API 服务器:

使用 API 进行内容检测

- 检测图像文件:

curl -X POST -F "file=@/path/to/image.jpg" http://localhost:3333/check

- 检测本地文件路径:

curl -X POST -F "path=/path/to/image.jpg" http://localhost:3333/check

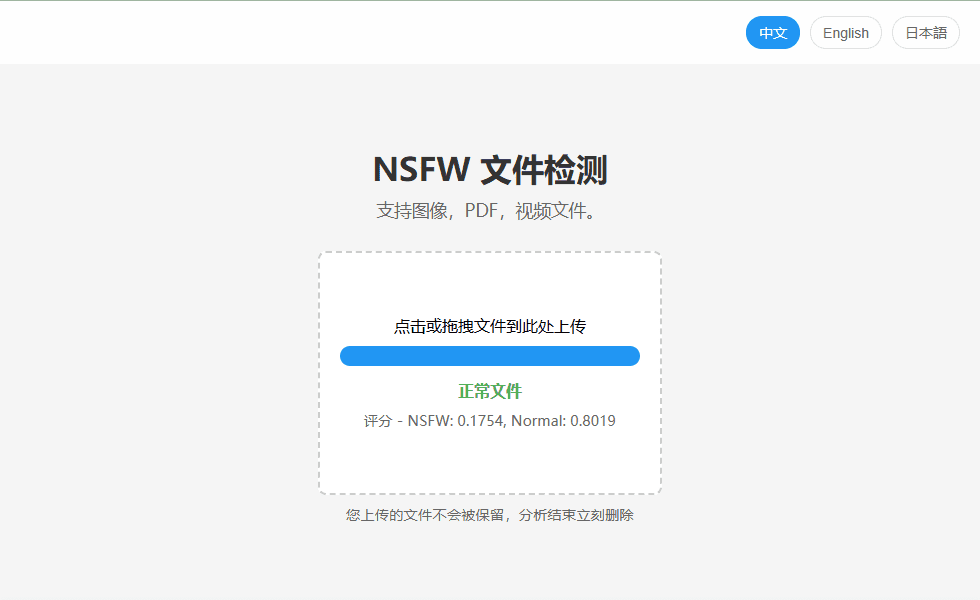

使用内置网页界面进行检测

- 访问以下地址:

http://localhost:3333

配置文件

- 编辑配置文件:

- 在

/tmp目录下创建一个名为config的文件,并根据需要配置检测器的行为。 - 配置示例:

bash

nsfw_threshold=0.5

ffmpeg_max_frames=100

ffmpeg_max_timeout=30

- 在

性能要求

- 运行该模型需要最多 2GB 内存。

- 当同时处理大量请求时,可能需要更多内存。

- 支持的架构:x86_64, ARM64。

支持的文件类型

- 图像(支持)

- 视频(支持)

- PDF 文件(支持)

- 压缩包内的文件(支持)

公共 API

如果不想自行部署,可以使用 vx.link 提供的公共 API 服务:

curl -X POST -F "file=@/path/to/image.jpg" https://vx.link/public/nsfw

请注意,公共 API 的请求速率限制为每分钟 30 次。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...