综合介绍

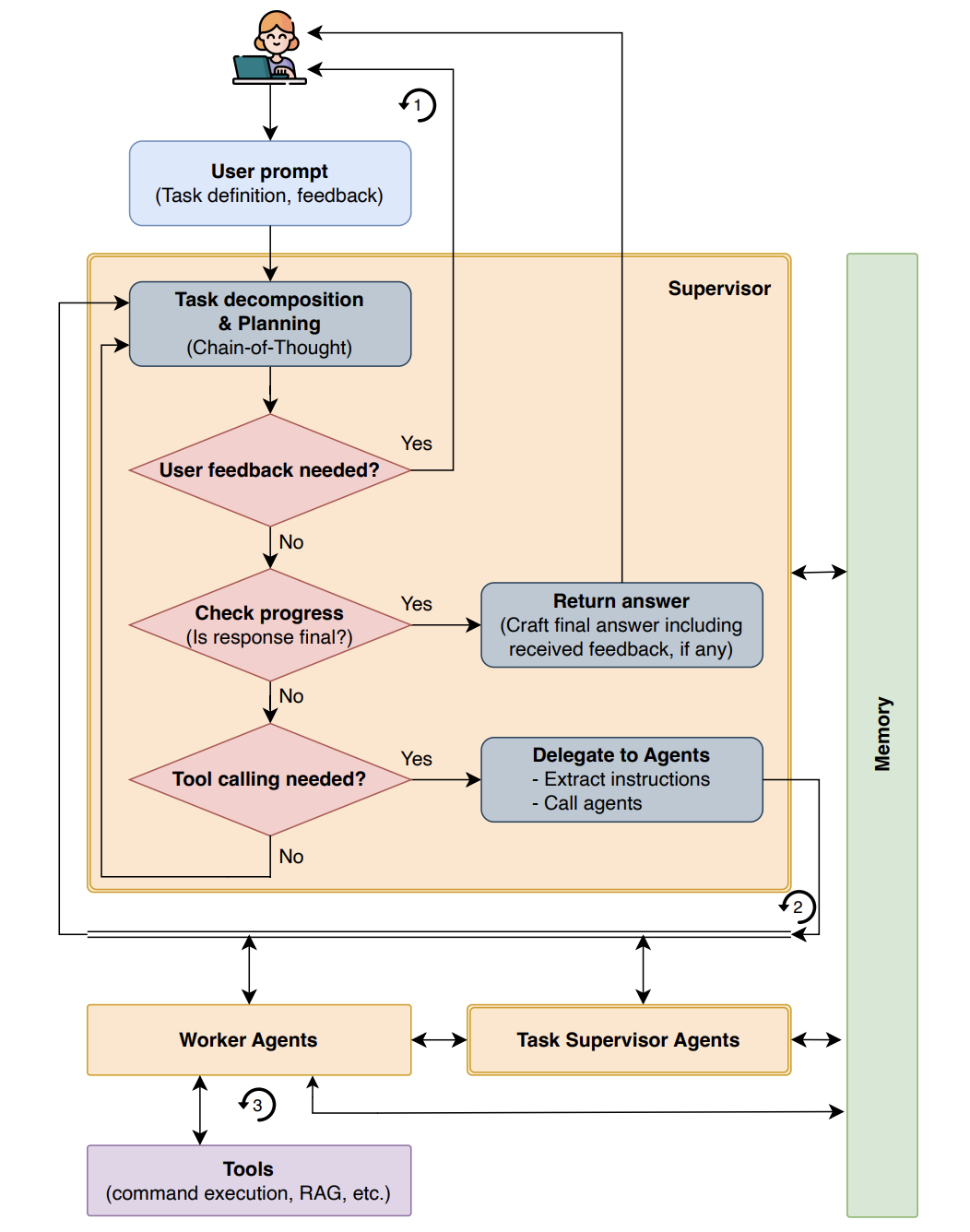

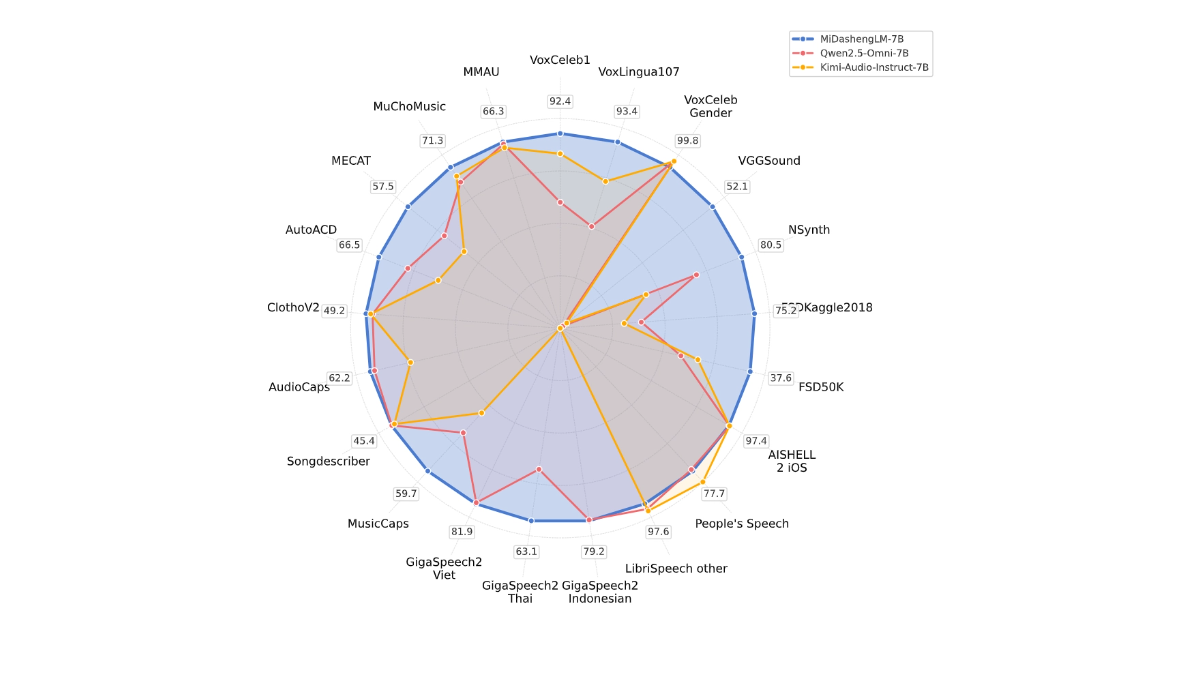

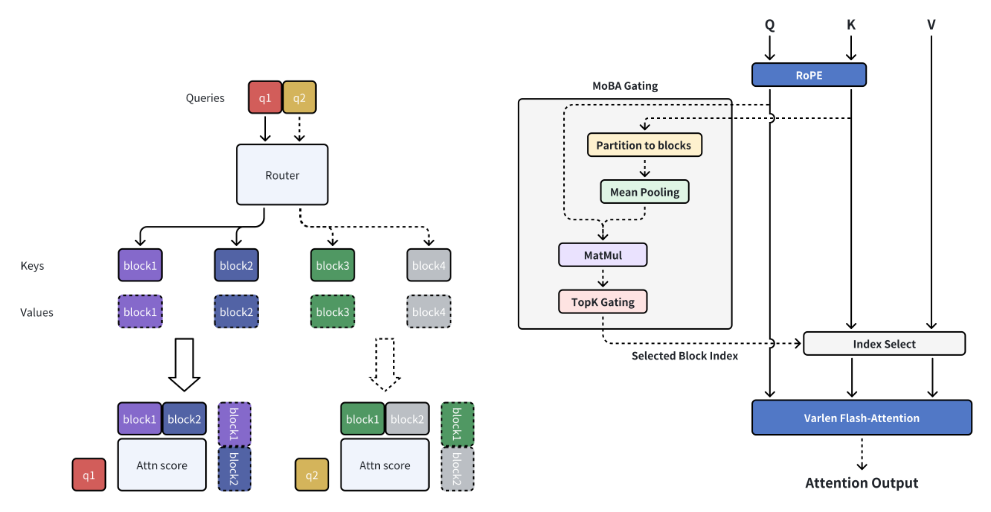

MoBA(Mixture of Block Attention)是由MoonshotAI开发的一种创新注意力机制,专为长上下文处理的大语言模型(LLMs)设计。MoBA通过将全上下文划分为多个块,每个查询token学习关注最相关的KV块,从而实现高效的长序列处理。其独特的无参数top-k门控机制确保模型仅关注最具信息量的块,显著提升计算效率。MoBA能够在全注意力和稀疏注意力模式之间无缝切换,既保证了性能,又提高了效率。该技术已成功应用于支持Kimi的长上下文请求,展示了在高效注意力计算方面的显著进步。

功能列表

- 块稀疏注意力:将全上下文划分为多个块,每个查询token学习关注最相关的KV块。

- 无参数门控机制:引入无参数top-k门控机制,选择每个查询token最相关的块。

- 全稀疏注意力切换:在全注意力和稀疏注意力模式之间无缝切换。

- 高效计算:显著提升长上下文任务的计算效率。

- 开源代码:提供完整的开源代码,便于用户使用和二次开发。

使用帮助

安装流程

- 创建虚拟环境:

conda create -n moba python=3.10

conda activate moba

- 安装依赖:

pip install .

快速开始

我们提供了与transformers兼容的MoBA实现。用户可以通过--attn参数在moba和moba_naive之间选择注意力后端。

python3 examples/llama.py --model meta-llama/Llama-3.1-8B --attn moba

详细功能操作流程

- 块稀疏注意力:在处理长上下文时,MoBA将全上下文划分为多个块,每个查询token学习关注最相关的KV块,从而实现高效的长序列处理。

- 无参数门控机制:MoBA引入了一种无参数top-k门控机制,选择每个查询token最相关的块,确保模型仅关注最具信息量的块。

- 全稀疏注意力切换:MoBA设计为全注意力的灵活替代方案,允许在全注意力和稀疏注意力模式之间无缝切换,既保证了性能,又提高了效率。

- 高效计算:通过上述机制,MoBA显著提升了长上下文任务的计算效率,适用于各种复杂推理任务。

示例代码

以下是一个使用MoBA的示例代码:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("meta-llama/Llama-3.1-8B")

model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-3.1-8B", attn="moba")

inputs = tokenizer("长上下文示例文本", return_tensors="pt")

outputs = model(**inputs)

print(outputs)

一句话描述(简介)

MoBA是一种创新的块注意力机制,专为长上下文处理的大语言模型设计,显著提升计算效率,支持全稀疏注意力切换。

网页关键字

长上下文处理, 块注意力机制, 大语言模型, 高效计算, MoonshotAI

综合介绍

MoBA(Mixture of Block Attention)是由MoonshotAI开发的一种创新注意力机制,专为长上下文处理的大语言模型(LLMs)设计。MoBA通过将全上下文划分为多个块,每个查询token学习关注最相关的KV块,从而实现高效的长序列处理。其独特的无参数top-k门控机制确保模型仅关注最具信息量的块,显著提升计算效率。MoBA能够在全注意力和稀疏注意力模式之间无缝切换,既保证了性能,又提高了效率。该技术已成功应用于支持Kimi的长上下文请求,展示了在高效注意力计算方面的显著进步。

功能列表

- 块稀疏注意力:将全上下文划分为多个块,每个查询token学习关注最相关的KV块。

- 无参数门控机制:引入无参数top-k门控机制,选择每个查询token最相关的块。

- 全稀疏注意力切换:在全注意力和稀疏注意力模式之间无缝切换。

- 高效计算:显著提升长上下文任务的计算效率。

- 开源代码:提供完整的开源代码,便于用户使用和二次开发。

使用帮助

安装流程

- 创建虚拟环境:

conda create -n moba python=3.10

conda activate moba

- 安装依赖:

pip install .

快速开始

我们提供了与transformers兼容的MoBA实现。用户可以通过--attn参数在moba和moba_naive之间选择注意力后端。

python3 examples/llama.py --model meta-llama/Llama-3.1-8B --attn moba

详细功能操作流程

- 块稀疏注意力:在处理长上下文时,MoBA将全上下文划分为多个块,每个查询token学习关注最相关的KV块,从而实现高效的长序列处理。

- 无参数门控机制:MoBA引入了一种无参数top-k门控机制,选择每个查询token最相关的块,确保模型仅关注最具信息量的块。

- 全稀疏注意力切换:MoBA设计为全注意力的灵活替代方案,允许在全注意力和稀疏注意力模式之间无缝切换,既保证了性能,又提高了效率。

- 高效计算:通过上述机制,MoBA显著提升了长上下文任务的计算效率,适用于各种复杂推理任务。

示例代码

以下是一个使用MoBA的示例代码:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("meta-llama/Llama-3.1-8B")

model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-3.1-8B", attn="moba")

inputs = tokenizer("长上下文示例文本", return_tensors="pt")

outputs = model(**inputs)

print(outputs)© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...