Ming-UniAudio是什么

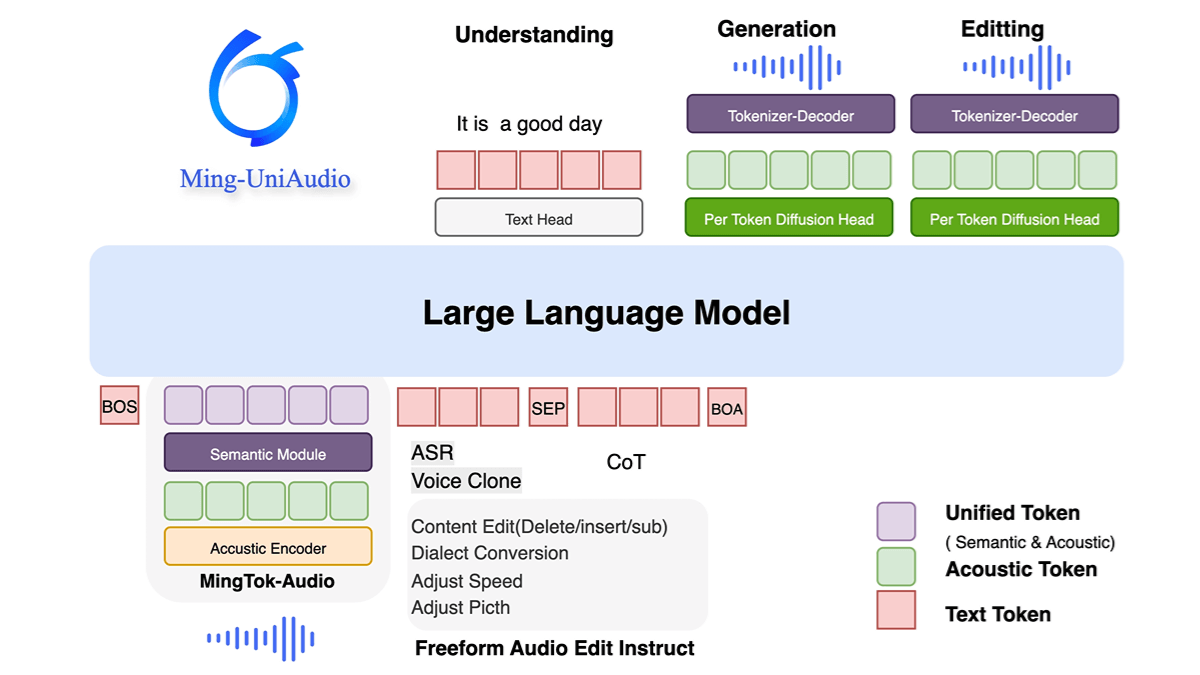

Ming-UniAudio是蚂蚁集团开源的统一音频多模态生成模型,支持文本、音频、图像和视频的混合输入与输出。采用多尺度Transformer和混合专家(MoE)架构,通过模态感知路由机制高效处理跨模态信息,显著提升计算效率。模型在语音合成、声纹克隆、多方言生成及音频-文本跨模态任务上表现优异,同时具备高质量实时生成能力。开源特性为研究社区提供了可扩展的解决方案,推动多模态技术发展与实际应用创新。

Ming-UniAudio的功能特色

- 统一多模态处理:支持音频、文本、图像和视频的混合输入与生成,实现跨模态的统一建模与交互。

- 端到端语音合成与克隆:具备高质量语音生成能力,支持多方言克隆和个性化声纹定制。

- 多任务联合训练:通过离散序列标记化处理多种音频类型,结合LLM进行联合训练与微调,适配未见任务。

- 高效计算架构:采用多尺度Transformer结构,优化编解码器设计,提升生成效率与质量。

Ming-UniAudio的核心优势

- 统一多模态处理能力:支持音频、文本、图像和视频的混合输入与生成,通过单一模型实现跨模态的统一建模与交互,无需依赖多个独立模型。

- 高效计算架构:采用多尺度Transformer与MoE(混合专家)设计,结合模态专用路由机制,显著提升计算效率与资源利用率。

- 高质量语音合成与克隆:集成先进音频解码器,支持多方言语音生成、个性化声纹定制及实时响应,在语音自然度与适应性上表现突出。

- 多任务联合优化:通过离散序列标记化与分阶段训练策略,同步优化感知与生成任务,在音频理解、文本生成等基准测试中达到领先水平。

- 开源与可扩展性:全面开放代码与模型权重,支持社区进一步研究与开发,推动多模态技术普及与应用创新。

Ming-UniAudio官网是什么

- 项目官网:https://xqacmer.github.io/Ming-Unitok-Audio.github.io/

- Github仓库:https://github.com/inclusionAI/Ming-UniAudio

- HuggingFace模型库:https://huggingface.co/inclusionAI/Ming-UniAudio-16B-A3B

Ming-UniAudio的适用人群

- AI研究与开发者:需要统一多模态模型进行音频、文本、图像和视频的混合处理与生成任务。

- 语音技术应用者:专注于语音合成、声纹克隆及多方言生成,如智能助手、有声内容创作者。

- 多模态产品团队:寻求高效计算架构与开源方案,以集成感知与生成能力至实际应用。

- 计算资源优化需求者:关注模型效率,需利用MoE与模态路由机制提升资源利用率。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...