MiMo-V2-Flash是什么

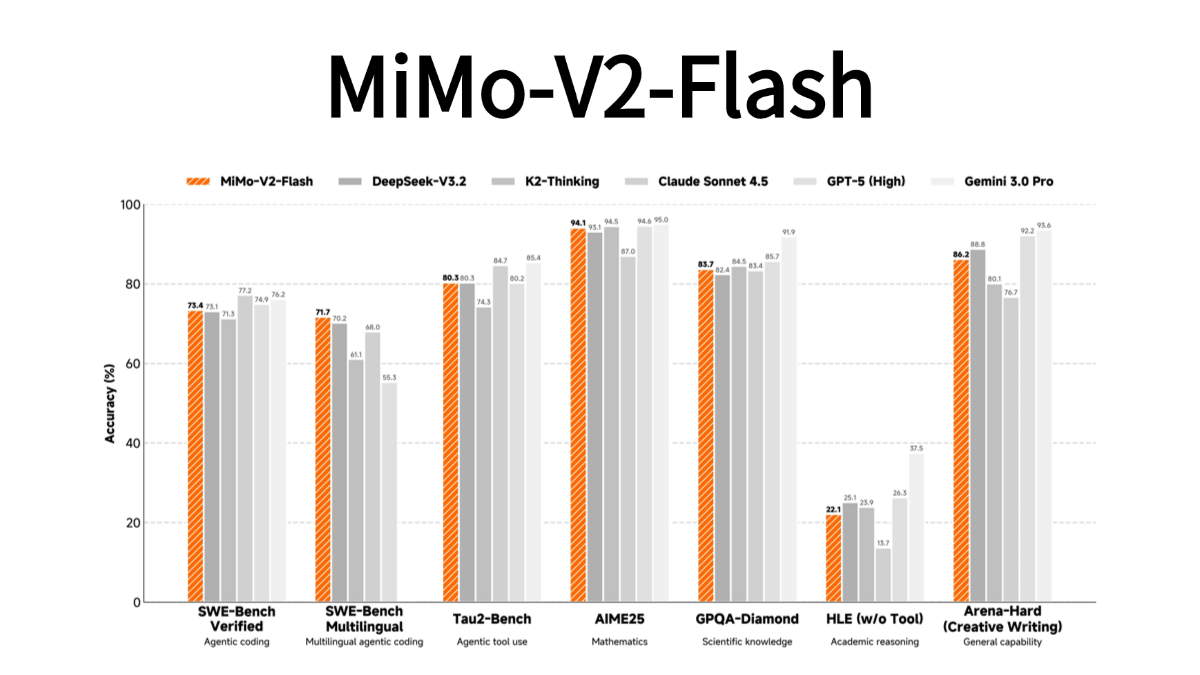

MiMo-V2-Flash是小米发布的开源MoE架构大模型,总参数3090亿,活跃参数150亿,主打高效推理和智能体应用。模型采用混合注意力架构与多词元预测技术,推理速度达150 tokens/秒,成本仅为同类模型的2.5%,在代码生成、数学推理等任务中表现优异。其创新点包括三层MTP并行预测技术(提升2-2.6倍速度)、多教师在线蒸馏训练(算力节省98%),支持256K超长上下文窗口及联网搜索功能。目前模型已在Hugging Face开源,提供MIT协议授权,API定价为输入0.1美元/百万token、输出0.3美元/百万token。

MiMo-V2-Flash的功能特色

- 高性能推理:采用混合注意力架构和轻量级多Token预测技术,显著提升推理效率,生成速度更快,推理成本大幅降低。

- 长文本处理能力:支持长达256K的上下文长度,适合长文本生成和理解任务,如长篇内容创作和文档处理。

- 智能体优化:专为智能体AI设计,通过大规模智能体强化学习和多教师在线策略蒸馏,提升复杂任务处理能力。

- 代码能力:在代码生成、补全和理解方面表现出色,支持多种编程语言,适合开发者工具集成。

- 多语言支持:具备多语言能力,能够处理多种语言的文本生成、翻译和理解任务,适用于国际化应用。

- 开源易用:模型权重和推理代码全面开源,采用MIT协议,便于开发者使用和二次开发,支持快速部署。

- 推理优化:支持FP8混合精度推理,结合SGLang框架,提供高效的推理性能,适合大规模应用。

MiMo-V2-Flash的核心优势

- 极致推理效率:推理成本仅为标杆闭源模型的2.5%,生成速度提升2倍,适合高效率任务处理。

- 强大的长文本能力:支持256K的超长上下文长度,显著优于其他开源模型,适合长文本生成和理解。

- 卓越的代码能力:在代码生成、补全和理解任务中表现优异,超越多数开源模型,接近标杆闭源模型水平。

- 智能体任务专长:通过大规模智能体强化学习,擅长复杂推理和多轮对话任务,适合智能体AI场景。

MiMo-V2-Flash官网是什么

- Github仓库:https://github.com/xiaomimimo/MiMo-V2-Flash

- HuggingFace模型库:https://huggingface.co/XiaomiMiMo/MiMo-V2-Flash

- 技术论文:https://github.com/XiaomiMiMo/MiMo-V2-Flash/blob/main/paper.pdf

MiMo-V2-Flash的适用人群

- 开发者:适合需要高性能AI模型进行应用开发的软件工程师,可用于构建智能助手、自动化工具等。

- 研究人员:适用于从事自然语言处理和人工智能研究的学者,可用于模型研究和算法改进。

- 企业用户:适合企业用于提升业务效率,如客服自动化、数据分析、智能决策支持等。

- 教育工作者:可用于教育领域,辅助教学、生成教学材料、提供智能辅导等。

- 内容创作者:适合作家、编辑、文案策划等,用于内容创作、文案生成和创意启发。

- 技术爱好者:对AI技术感兴趣的个人用户,可用于学习、实验和探索AI应用。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...