这是我们在 Anthropic 开发的一种开放标准,旨在解决大语言模型(LLM)应用的核心挑战——将它们与您的数据连接起来。

无需为每个数据源构建定制集成。MCP 提供了一个协议来连接所有数据源:

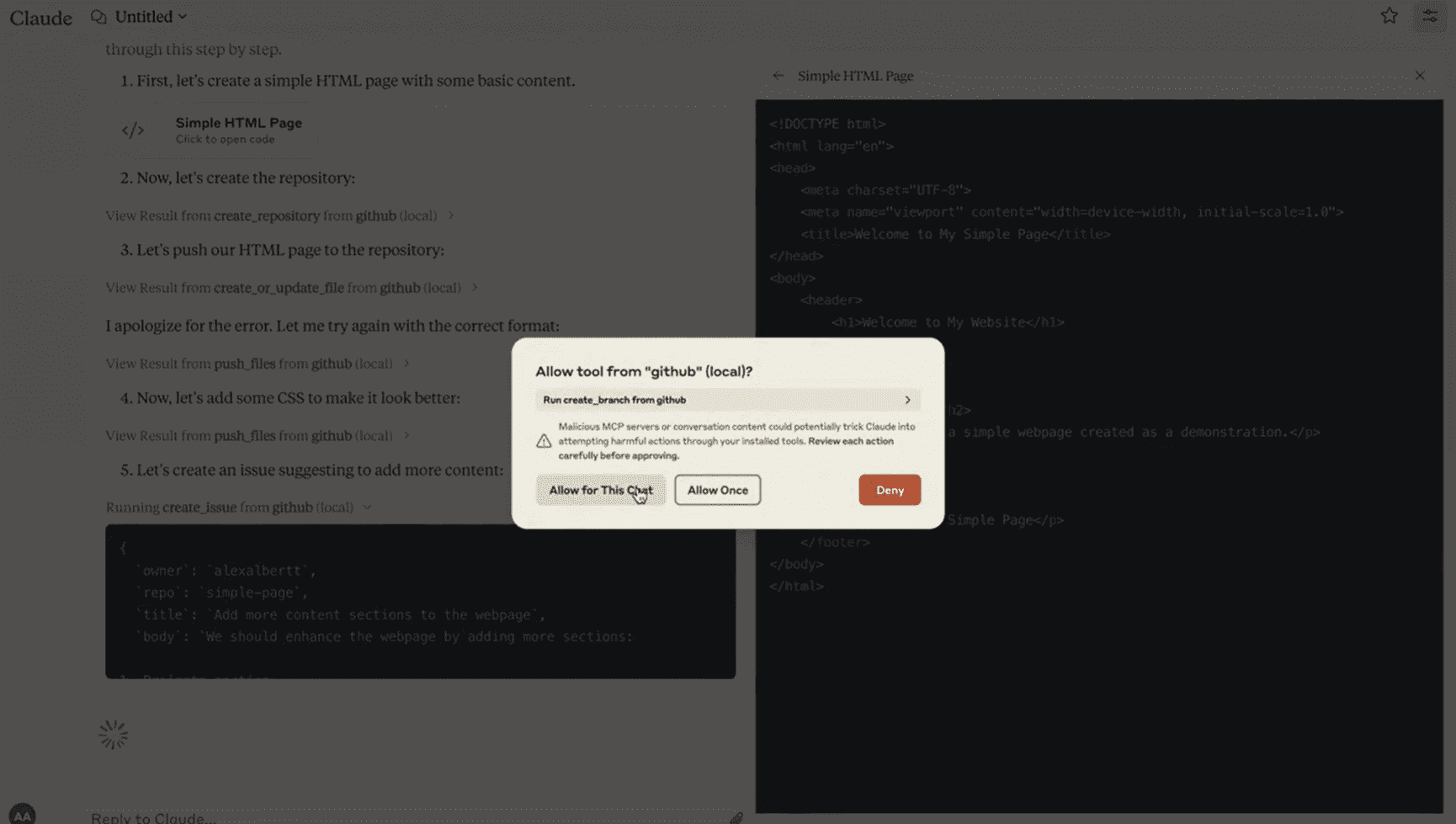

以下是使用 Claude 桌面应用程序的快速演示,我们在其中配置了 MCP:

观看 Claude 直接连接到 GitHub,创建一个新的代码库(repo),并通过一个简单的 MCP 集成发起一个 PR。

在 Claude 桌面应用程序中设置 MCP 后,构建此集成的时间不到一小时。

让 LLM 与外部系统交互通常并非易事。

目前,每个开发者都需要编写定制代码,以将其 LLM 应用与数据源连接。这是一项繁琐且重复的工作。

MCP 通过一种共享资源、工具和提示的标准协议解决了这一问题。

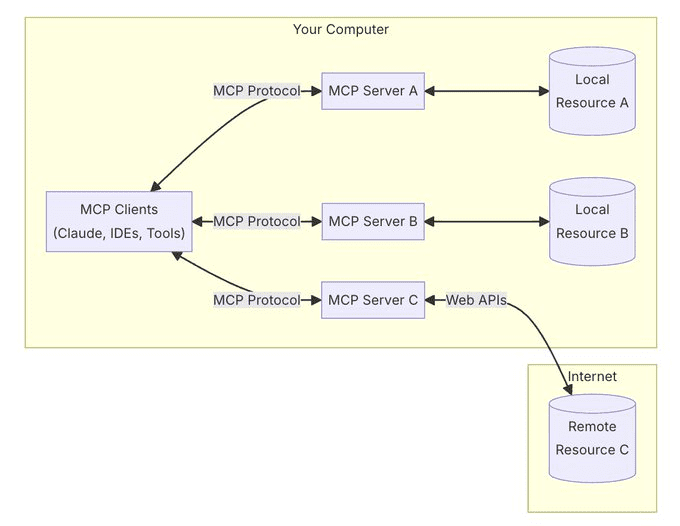

MCP 的核心是遵循客户端-服务器架构,其中多个服务可以连接到任何兼容的客户端。

客户端是类似 Claude 桌面应用程序、IDE 或 AI 工具的应用程序。服务器是轻量级的适配器,负责暴露数据源。

MCP 的强大之处之一在于它可以通过相同的协议处理本地资源(您的数据库、文件、服务)和远程资源(类似 Slack 或 GitHub 的 API)。

一个 MCP 服务器不仅共享数据。除了资源(文件、文档、数据)外,它们还可以暴露:

- 工具(API 集成、操作)

- 提示(模板化的交互)

安全性已集成到协议中——服务器控制自己的资源,无需与 LLM 提供商共享 API 密钥,并且系统边界清晰。

目前,MCP 仅支持本地部署——服务器必须运行在您的机器上。

但我们正在开发支持远程服务器的功能,并提供企业级认证,以便团队可以安全地在组织内共享其上下文来源。

我们正在构建一个 AI 能够通过单一优雅协议连接到任何数据源的世界——MCP 是通用的翻译器。

只需将 MCP 集成到您的客户端一次,即可随时连接到任意数据源。

在不到 5 分钟内开始使用 MCP——我们已经为 GitHub、Slack、SQL 数据库、本地文件、搜索引擎等构建了服务器。

安装 Claude 桌面应用程序,并按照我们的分步指南连接您的第一个服务器:

https://modelcontextprotocol.io/quickstart

Anthropic开源的模型上下文协议:Model Context Protocol(MCP),让AI助手原生接入存储数据。

就像 LSP 为 IDE 所做的那样,我们正在将 MCP 构建为 LLM 集成的开放标准。

构建您自己的服务器,为协议做出贡献,共同塑造 AI 集成的未来:

https://github.com/modelcontextprotocol

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...