综合介绍

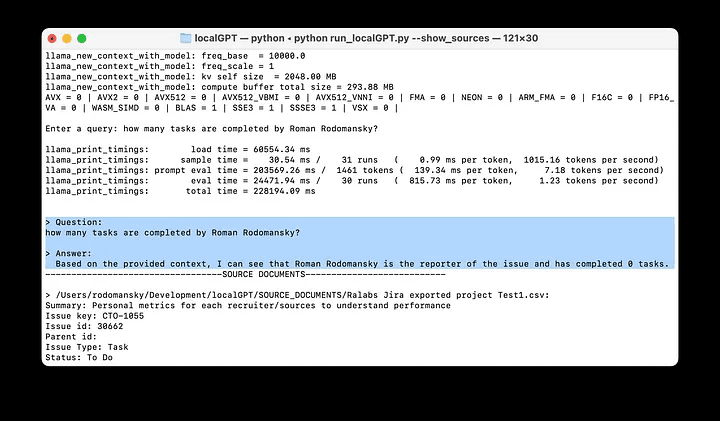

LocalGPT是一个开源项目,旨在让用户在本地设备上与文档进行对话,确保数据隐私。通过使用各种开源模型,LocalGPT可以在不将数据上传到云端的情况下处理和理解文档内容。该项目支持多种平台,包括GPU、CPU、HPU和MPS,提供了丰富的功能,如会话历史记录、API接口和图形用户界面。LocalGPT的设计目标是为用户提供一个安全、私密的文档交互环境,适用于需要高隐私保护的场景。

功能列表

- 数据隐私:所有数据处理均在本地设备上进行,确保100%数据安全。

- 多模型支持:支持多种开源模型,包括HF、GPTQ、GGML和GGUF。

- 多种嵌入:提供多种开源嵌入选项。

- 模型重用:下载后可重复使用LLM,无需重复下载。

- 会话历史:记住会话中的对话历史。

- API接口:提供API接口,便于构建RAG应用程序。

- 图形用户界面:提供基于API和独立的图形用户界面(基于streamlit)。

- 多平台支持:支持CUDA、CPU、HPU(Intel® Gaudi®)和MPS等多种平台。

使用帮助

安装流程

- 克隆仓库:在终端中运行以下命令克隆LocalGPT仓库:

git clone https://github.com/PromtEngineer/localGPT.git

- 安装依赖:进入项目目录并安装所需依赖:

cd localGPT

pip install -r requirements.txt

- 配置环境:根据需要配置环境变量和模型路径。

使用方法

- 启动服务:运行以下命令启动LocalGPT服务:

python run_localGPT.py

- 访问界面:打开浏览器并访问提供的本地地址,进入图形用户界面。

- 上传文档:在界面中上传需要处理的文档。

- 开始对话:在对话框中输入问题,LocalGPT将根据文档内容生成回答。

详细功能操作

- 数据隐私:所有数据处理均在本地设备上进行,确保100%数据安全。用户无需担心数据泄露问题。

- 多模型支持:LocalGPT支持多种开源模型,用户可以根据需求选择合适的模型进行文档处理。

- 会话历史:LocalGPT会记录会话中的对话历史,方便用户查看和管理之前的对话内容。

- API接口:LocalGPT提供API接口,开发者可以利用这些接口构建自己的RAG应用程序,实现更多自定义功能。

- 图形用户界面:LocalGPT提供了基于streamlit的图形用户界面,用户可以通过直观的界面进行文档上传和对话操作。

示例操作流程

- 上传文档:点击“上传文档”按钮,选择需要处理的文档文件。

- 输入问题:在对话框中输入问题,例如“这份文档的主要内容是什么?”。

- 查看回答:LocalGPT将根据文档内容生成回答,并显示在对话框中。

- 管理会话:用户可以查看和管理会话历史,方便后续参考和使用。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...