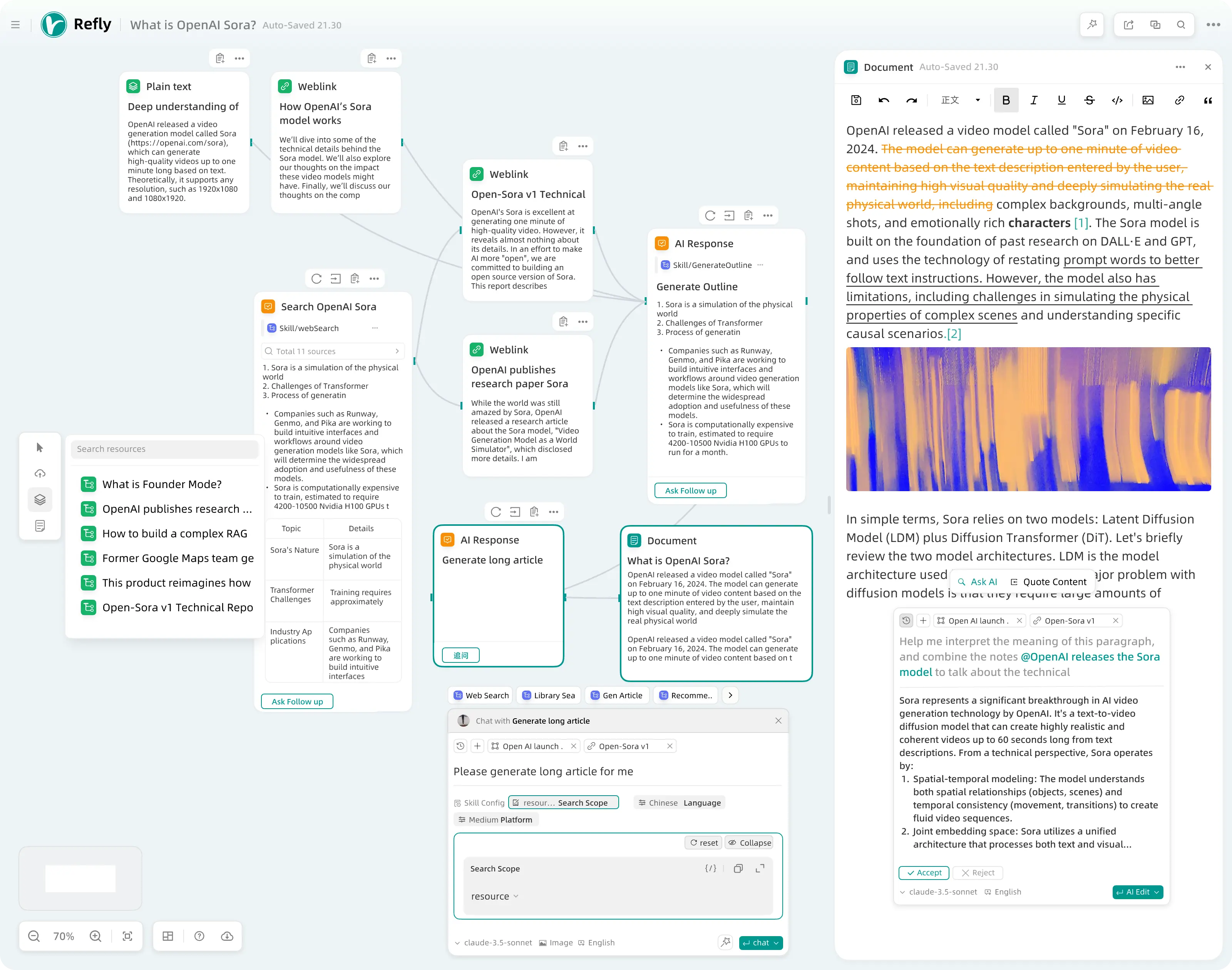

综合介绍

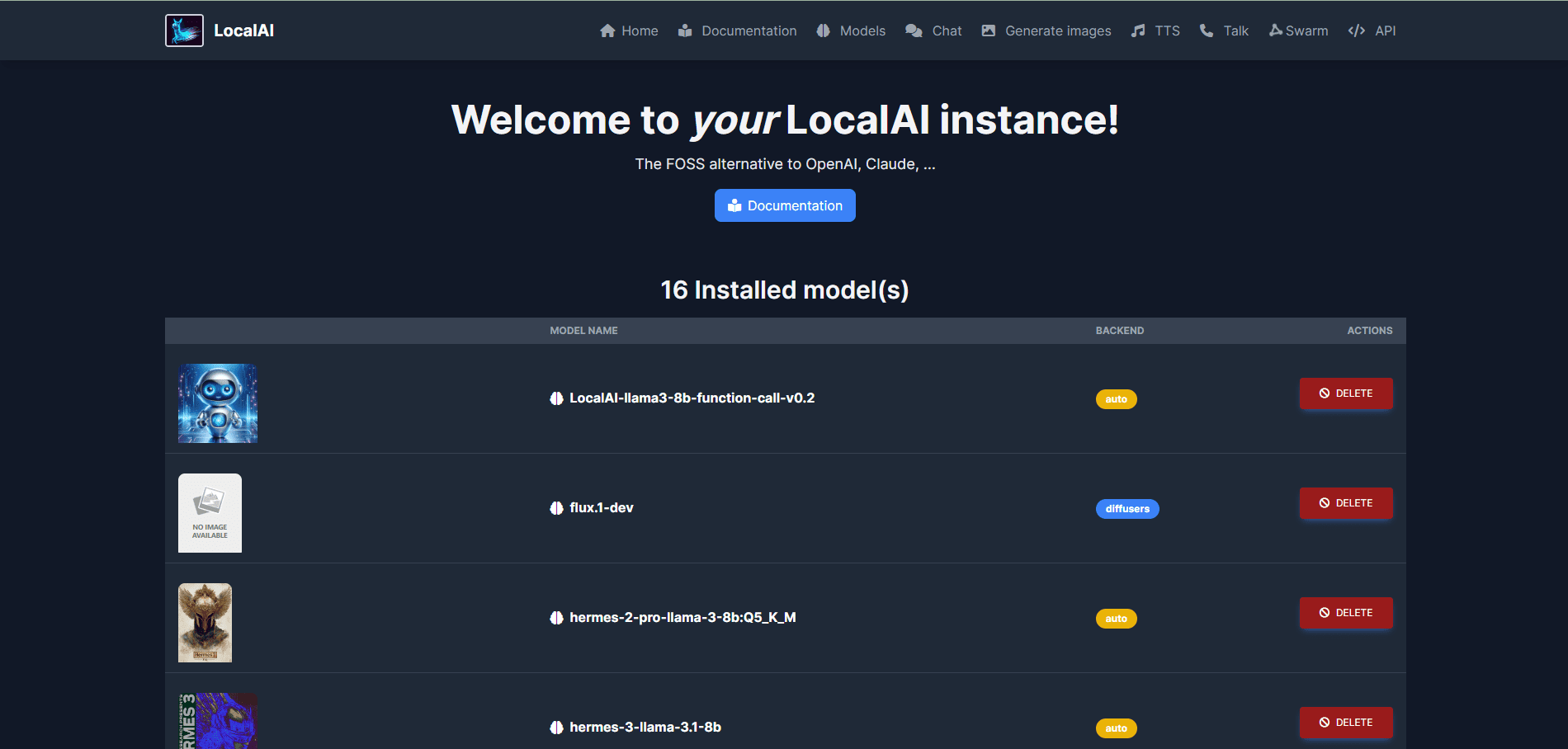

LocalAI 是一个开源的本地AI替代方案,旨在提供与OpenAI、Claude等兼容的API接口。它支持在消费级硬件上运行,不需要GPU,能够进行文本、音频、视频、图像生成和语音克隆等多种任务。LocalAI 由 Ettore Di Giacinto 创建和维护,支持多种模型架构,包括gguf、transformers、diffusers等,适用于本地或内部部署。

功能列表

- 文本生成:支持GPT系列模型,能够生成高质量的文本内容。

- 音频生成:通过文本转音频功能,生成自然流畅的语音。

- 图像生成:使用稳定扩散模型生成高质量图像。

- 语音克隆:通过语音克隆技术,生成与原声相似的语音。

- 分布式推理:支持P2P推理,提升模型推理效率。

- 模型下载:直接从Huggingface等平台下载并运行模型。

- 集成WebUI:提供集成的Web用户界面,方便用户操作。

- 向量数据库嵌入生成:支持向量数据库的嵌入生成。

- 约束语法:支持生成受限语法的文本内容。

- 视觉API:提供图像处理和分析功能。

- 重新排序API:支持文本内容的重新排序和优化。

安装流程

- 使用安装脚本:

- 运行以下命令下载并安装LocalAI:

curl -s https://localai.io/install.sh | sh

- 运行以下命令下载并安装LocalAI:

- 使用Docker:

- 如果没有GPU,运行以下命令启动LocalAI:

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu - 如果有Nvidia GPU,运行以下命令:

docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-aio-gpu-nvidia-cuda-12

- 如果没有GPU,运行以下命令启动LocalAI:

使用流程

- 启动LocalAI:

- 通过上述安装流程启动LocalAI后,访问

http://localhost:8080进入WebUI。

- 通过上述安装流程启动LocalAI后,访问

- 加载模型:

- 在WebUI中,导航到“模型”选项卡,选择并加载所需模型。

- 或者,使用命令行加载模型,例如:

local-ai run llama-3.2-1b-instruct:q4_k_m

- 生成内容:

- 在WebUI中,选择相应的功能模块(如文本生成、图像生成等),输入所需参数,点击生成按钮。

- 例如,生成文本时,输入提示词,选择模型,点击“生成文本”按钮。

- 分布式推理:

- 配置多个LocalAI实例,实现分布式P2P推理,提升推理效率。

- 参考官方文档中的分布式推理配置指南。

高级功能

- 自定义模型:

- 用户可以从Huggingface或OCI注册表中下载并加载自定义模型,满足特定需求。

- API集成:

- LocalAI 提供与OpenAI API兼容的REST API,方便开发者集成到现有应用中。

- 参考官方API文档,了解详细的API使用方法。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...