综合介绍

LMSYS Org,全称Large Model Systems Organization,是由加利福尼亚大学伯克利分校的学生和教师与加州大学圣地亚哥分校以及卡内基梅隆大学合作共同创立的开放式研究组织。该组织的目标是通过共同开发开放模型、数据集、系统和评估工具,使大型模型对所有人都可访问。

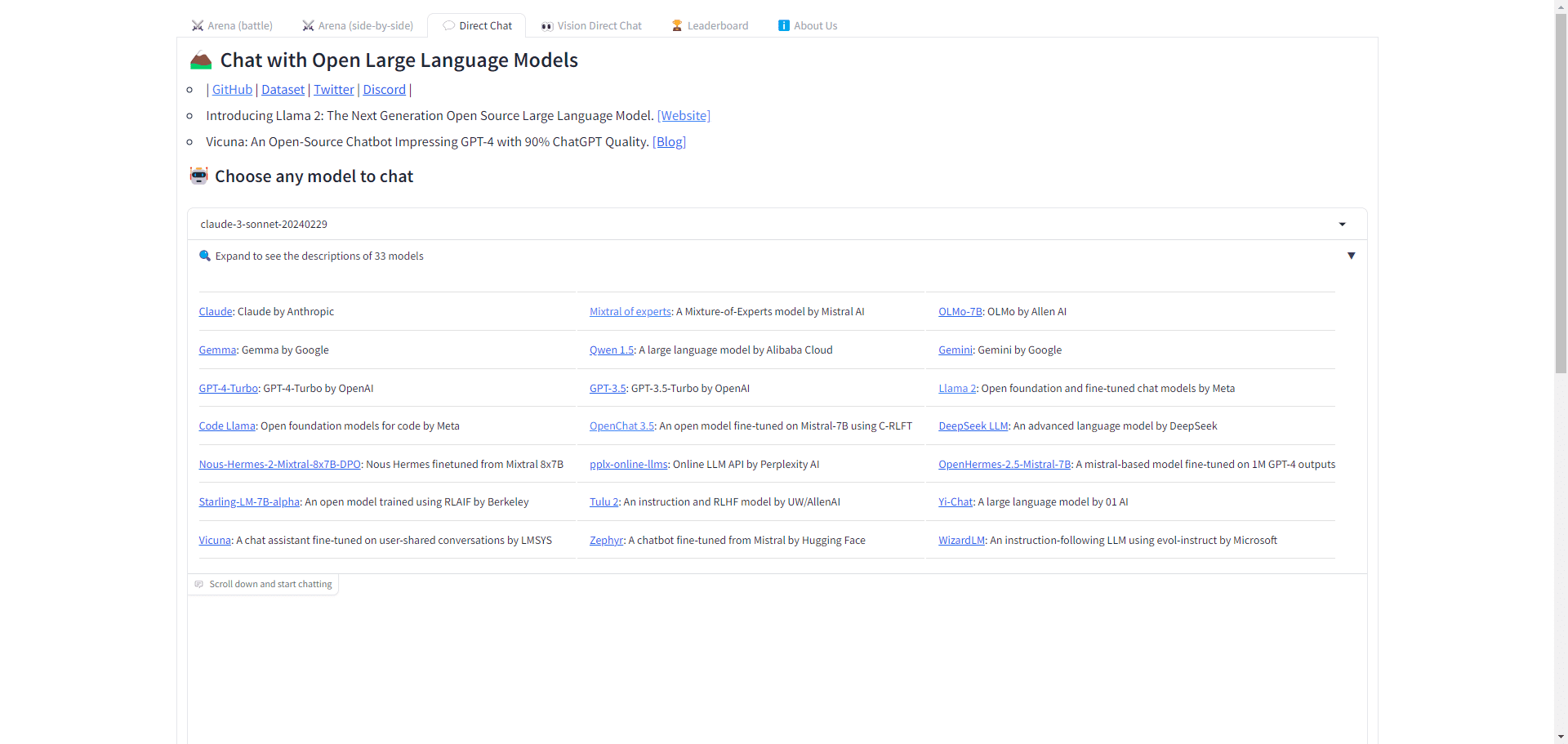

Chatbot Arena 是一个专注于基准测试和比较不同大型语言模型(LLM)性能的在线平台。该平台由研究人员创建,旨在为用户提供一个匿名、随机的环境,以便并排互动和评估各种AI聊天机器人。通过详细的质量、性能和价格分析,Chatbot Arena 帮助用户找到最适合其需求的AI解决方案。

模型PK:https://lmarena.ai/

功能列表

- Vicuna:一个聊天机器人,具有90%的ChatGPT质量,可在7B/13B/33B大小中选择。

- Chatbot Arena:通过众包和Elo评级系统对LLMs进行可扩展和游戏化的评估。

- SGLang:用于复杂LLM程序的高效接口和运行时。

- LMSYS-Chat-1M:大规模的实际LLM对话数据集。

- FastChat:用于训练、服务和评估基于LLM的聊天机器人的开放平台。

- MT-Bench:用于评估聊天机器人的一套具有挑战性的、多轮的、开放式的问题。

使用帮助

- 模型对比:

- 访问“模型对比”页面。

- 选择你想比较的模型,点击“添加到对比”按钮。

- 查看对比结果,包括质量、性能、价格等指标。

- 质量测试:

- 在模型详情页面,查看质量测试结果。

- 了解不同测试维度的具体分数和排名。

- 价格分析:

- 在模型详情页面,查看价格分析。

- 比较不同模型的价格,找到性价比最高的选择。

- 性能评估:

- 在模型详情页面,查看性能评估结果。

- 了解模型的输出速度、延迟等性能指标。

- 上下文窗口分析:

- 在模型详情页面,查看上下文窗口分析。

- 了解模型的上下文窗口大小,适用于不同应用场景。

通过以上步骤,用户可以全面了解不同大型语言模型的性能和特点,做出最适合自己需求的选择。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...