Meta 公司于 2025 年 4 月 5 日发布了其 Llama 大语言模型系列的最新成员—— Llama 4,标志着其在 AI 领域,特别是在原生多模态和模型架构方面的重大进展。此次发布的核心是 Llama 4 Scout 和 Llama 4 Maverick 两款模型,以及作为技术支撑的巨型“教师”模型 Llama 4 Behemoth 的预览。此举不仅展示了 Meta 在追赶并试图超越业界顶尖模型方面的决心,也延续了其推动开源 AI 生态的策略。

Llama 4 系列核心模型概览

Meta 本次推出了 Llama 4 系列中的两款面向开发者和应用的模型:

- Llama 4 Scout: 这款模型拥有 170 亿活跃参数和 16 个专家(Experts),总参数量 1090 亿。其亮点在于号称同级别最佳的多模态能力,超越了所有前代 Llama 模型。更引人注目的是,它支持高达 1000 万 token 的上下文窗口,远超 Llama 3 的 128K。Meta 声称,该模型性能优于 Google 的 Gemma 3 、 Gemini 2.0 Flash-Lite 和 Mistral AI 的 Mistral 3.1,并且经过 Int4 量化后可部署在单块 NVIDIA H100 GPU 上,显示出对效率的重视。

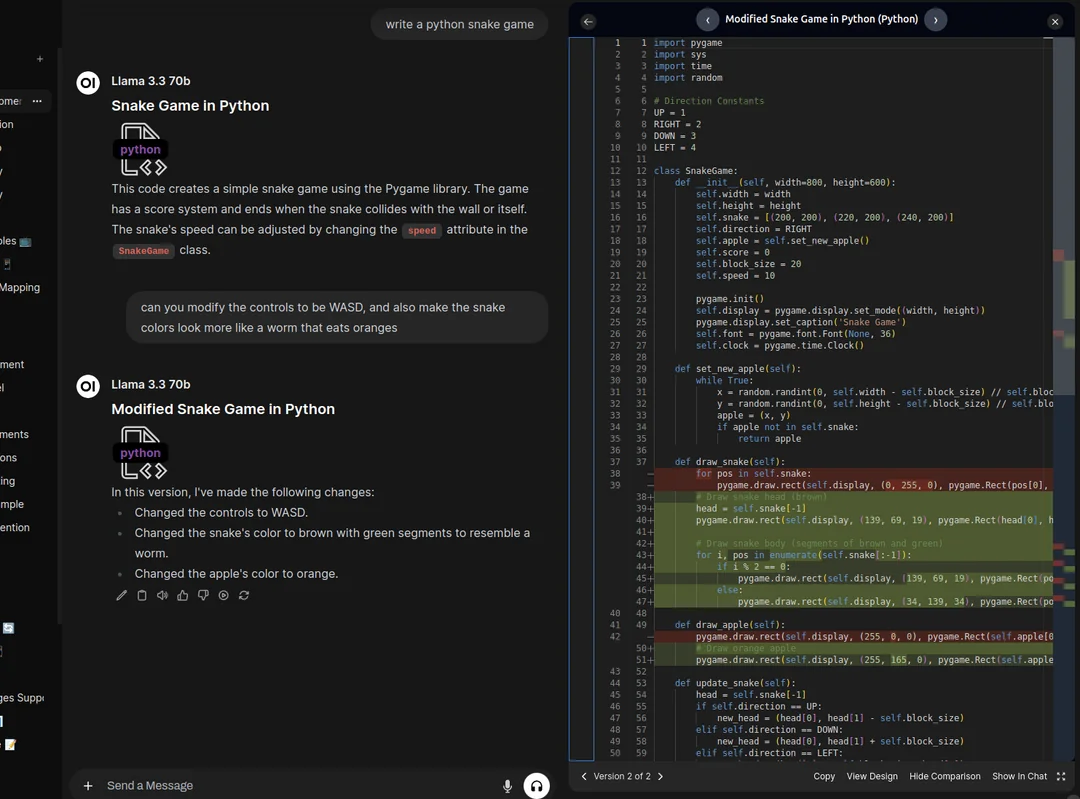

- Llama 4 Maverick: 同样拥有 170 亿活跃参数,但配备了 128 个专家,总参数量达到 4000 亿。定位为同级别中的顶级多模态模型,其目标是挑战 OpenAI 的 GPT-4o 和 Google 的 Gemini 2.0 Flash 。据 Meta 公布的数据, Maverick 在多个基准测试中表现优异,并在推理和编码能力上接近参数量两倍于其活跃参数的 DeepSeek v3 。一个实验性的聊天版本在 LMArena 排行榜上获得了 1417 的 ELO 评分,显示出其在对话能力上的潜力。该模型可在单个 NVIDIA H100 DGX 主机上运行。

此外,Meta 还预告了 Llama 4 Behemoth 模型。这是一个拥有 2880 亿活跃参数、16 个专家、总参数量近 2 万亿的庞然大物。虽然仍在训练中且暂未发布,但它作为 Scout 和 Maverick 的“教师”模型,通过知识蒸馏技术提升了后两者的性能。 Behemoth 在数学、多语言和图像基准测试中表现突出,Meta 称其在部分 STEM 基准(如 MATH-500 和 GPQA Diamond)上超越了 GPT-4.5 、 Anthropic 的 Claude Sonnet 3.7 和 Google 的 Gemini 2.0 Pro 。

关键技术创新:MoE、多模态与长上下文

Llama 4 系列引入了多项关键技术革新,这些是其性能提升的基础。

混合专家模型 (MoE) 架构

Llama 4 是 Meta 首个采用混合专家 (MoE) 架构的模型系列。MoE 架构近年来备受关注,因为它允许模型在拥有巨大总参数量的同时,每次推理只激活一小部分参数(即“专家”)。这种设计能够在给定的训练计算预算下,实现比传统密集型(Dense)模型更高的性能,并提高训练和推理的计算效率。

以 Llama 4 Maverick 为例,其 4000 亿总参数分布在 128 个路由专家和一个共享专家中。推理时,每个 token 会被发送到共享专家和其中一个路由专家。模型采用交替的密集层和 MoE 层来平衡性能和效率。这种架构使得 Maverick 可以在单个 H100 DGX 主机上部署,或通过分布式推理实现最大效率,从而降低了模型服务的成本和延迟。

原生多模态与早期融合

与以往先训练语言模型再适配视觉能力不同, Llama 4 被设计为原生多模态模型。它采用了“早期融合”(Early Fusion)策略,在模型骨干网络中将文本和视觉 token 无缝集成。这意味着模型可以利用大量的无标签文本、图像和视频数据进行联合预训练。 Llama 4 还改进了其视觉编码器,该编码器基于 MetaCLIP ,但与一个冻结的 Llama 模型协同训练,以更好地适应大语言模型的需求。模型预训练最多可处理 48 张图像输入,后训练测试中在最多 8 张图像输入下表现良好,能够处理多图像输入和文本提示,进行视觉推理和理解。

突破性的 1000 万 Token 上下文窗口

Llama 4 Scout 的另一个显著特点是其高达 1000 万 token 的上下文窗口,这在业界处于领先地位。如此巨大的上下文容量,为处理超长文档、分析大规模数据集或进行需要长期记忆的对话开辟了新的可能性,例如:

- 对多份冗长报告或书籍进行摘要和问答。

- 分析完整的代码库以理解依赖关系或查找错误。

- 基于用户数周甚至数月的活动记录提供深度个性化服务。

- 在法律或医学等需要处理大量文本的领域进行信息提取和分析。

Meta 将 Scout 的长上下文能力归功于其创新的 iRoPE 架构。该架构在预训练和后训练中均使用了 256K 的上下文长度,并结合了交错注意力层(interleaved attention layers,不含位置嵌入)和推理时注意力温度缩放(inference time temperature scaling)技术来增强长度泛化能力。“i”代表交错(interleaved),“RoPE”指旋转位置嵌入(Rotary Position Embeddings),暗示了其支持“无限”上下文长度的长远目标。

训练方法与性能表现

Llama 4 的开发涉及了训练流程的诸多改进。

预训练阶段:

- 数据与规模: 训练数据总量超过 30 万亿 token,是 Llama 3 的两倍多,包含多样化的文本、图像和视频数据集。支持 200 种语言,其中超过 100 种语言的训练数据量超过 10 亿 token。

- 效率与精度: 采用 FP8 精度进行训练,以提高计算效率(在 32K GPU 上训练 Behemoth 时达到 390 TFLOPs/GPU),同时声称未牺牲质量。

- 超参数优化: 开发了名为 MetaP 的新技术,用于可靠地设置关键超参数(如每层学习率、初始化尺度),并发现这些参数在不同批次大小、模型宽度、深度和训练 token 数下具有良好的迁移性。

- 中段训练 (Mid-training): 在预训练后引入特定训练方法和数据集,用于扩展长上下文能力和提升核心性能。

后训练阶段:

- 新流程: 采用了轻量级监督微调 (SFT) -> 在线强化学习 (RL) -> 轻量级直接偏好优化 (DPO) 的新流程。Meta 发现,传统的 SFT 和 DPO 可能会过度约束模型,限制 RL 阶段的探索,影响推理、编码和数学能力。

- 数据筛选: 通过使用 Llama 模型作为判断器,移除了超过 50% 被标记为“简单”的 SFT 数据,专注于在更难的数据集上进行轻量级 SFT。

- 在线强化学习: 在多模态在线 RL 阶段,通过精心选择更难的提示(prompts),实现了性能的显著提升。采用了持续在线 RL 策略,交替进行模型训练和使用模型过滤数据,只保留中等到困难的提示,从而在计算和准确性之间取得平衡。

- 轻量级 DPO: 最后进行轻量级 DPO,处理与模型响应质量相关的边界情况,平衡模型的智能和对话能力。

性能对比:

Meta 公布的基准测试结果显示:

- Llama 4 Maverick: 在编码、推理、多语言、长上下文和图像基准上优于 GPT-4o 和 Gemini 2.0 。在编码和推理方面与参数规模更大的 DeepSeek v3.1 相当。

- Llama 4 Scout: 在同类模型中表现最佳,性能强于 Gemma 3, Gemini 2.0 Flash-Lite, Mistral 3.1 ,且优于所有前代 Llama 模型。在图像定位(image grounding)能力上表现突出。

需要注意的是,基准测试结果通常在特定条件下获得,实际应用中的表现可能有所不同。但这些数据至少表明 Llama 4 在多个维度上具备了与业界领先模型竞争的潜力。

Behemoth:2 万亿参数的“教师”与训练挑战

Llama 4 Behemoth 的存在,不仅是为了展示 Meta 训练超大规模模型的能力,更关键的是它在 Llama 4 开发中扮演了“教师”的角色。通过知识蒸馏(codistillation), Behemoth 将其在数学、多语言和图像理解方面的强大能力迁移到规模更小的 Maverick 模型上。Meta 开发了一种新的蒸馏损失函数,可以在训练过程中动态调整软目标(来自教师模型的概率分布)和硬目标(真实标签)的权重。这种在预训练期间进行的协同蒸馏,摊销了为学生模型计算蒸馏目标所需的大量计算成本。

训练一个 2 万亿参数的模型本身就是一项巨大的工程挑战。Meta 披露了一些后训练阶段的经验:

- 数据剪枝: 为了最大化性能,需要比小模型更激进地修剪 SFT 数据,比例高达 95%,以专注于高质量和高难度的数据。

- 强化学习: 轻量级 SFT 后进行大规模 RL 对提升模型的推理和编码能力尤为重要。RL 策略侧重于通过 pass@k 分析选择困难提示,并构建难度递增的训练课程。动态过滤掉零优势(zero advantage)的提示,并将来自不同能力维度的提示混合到训练批次中,对提升数学、推理和编码性能至关重要。

- 指令遵循: 采样多样化的系统指令(system instructions)对于确保模型在推理和编码任务中保持良好的指令遵循能力至关重要。

- 基础设施: 针对 MoE 架构和超大规模,Meta 优化了并行化设计,并开发了一个完全异步的在线 RL 训练框架。该框架允许将不同模型灵活分配到不同 GPU 上,根据计算速度平衡资源,据称训练效率比上一代提升了约 10 倍。

安全防护与偏见缓解

与所有大型模型开发者一样,Meta 强调了其在 Llama 4 开发中对安全和负责任 AI 的重视。其方法涵盖了模型开发的全生命周期:

- 预训练和后训练缓解: 在预训练阶段使用数据过滤等措施;在后训练阶段应用多种技术,包括在各阶段注入适量的安全数据,使模型符合使用策略。

- 系统级工具: Meta 开源了一系列安全工具,供开发者集成:

- Llama Guard: 基于 MLCommons 的风险分类法开发的输入/输出安全检测模型。

- Prompt Guard: 用于检测恶意提示(如越狱攻击)和注入攻击的分类器模型。

- CyberSecEval: 用于评估和降低生成式 AI 网络安全风险的评估工具。

Meta 强调这些工具的可定制性,允许开发者根据自身需求调整安全策略。

- 评估与红队测试: 进行系统的模型测试,并采用自动化和手动对抗性探测。开发了名为 GOAT (Generative Offensive Agent Testing) 的新方法,通过模拟中等技能攻击者的多轮交互来提高测试覆盖率和效率,使人类红队专家能专注于更前沿的风险领域。

解决偏见问题

Meta 承认大型语言模型普遍存在的偏见问题,特别是历史上在有争议的政治和社会议题上倾向于某些立场,这部分源于互联网训练数据的固有偏见。 Llama 4 的目标是消除模型偏见,使其能够理解和阐述争议问题的不同侧面,而不带偏见或评判。

Meta 声称 Llama 4 在这方面取得了显著进步,表现优于 Llama 3 ,并与 Grok 相当:

- 在有争议的政治和社会议题上,拒绝回答的比例从 Llama 3.3 的 7% 降至 2% 以下。

- 在拒绝回答的提示中,表现出不平等(偏向性)拒绝的比例低于 1%。

- 在一组有争议的政治或社会议题上, Llama 4 表现出强烈政治倾向的回应频率与 Grok 相当,约为 Llama 3.3 的一半。

Meta 表示将继续努力降低模型的偏见率。

开放性、可用性与生态系统

Llama 4 Scout 和 Llama 4 Maverick 现已在 llama.com 和 Hugging Face 上提供下载,并将陆续登陆各大云平台、数据平台和边缘计算合作伙伴。用户也可以通过 WhatsApp, Messenger, Instagram Direct 以及 Meta.AI 网站体验由 Llama 4 驱动的 Meta AI 。

Meta 再次强调了其对开放生态的承诺,认为开放能够推动创新。 Llama 4 的发布,特别是其采用的 MoE 架构、原生多模态能力和超长上下文窗口,无疑为 AI 开发者和研究者提供了强大的新工具。然而,这些先进模型的实际性能、易用性、微调成本以及它们在推动“个性化体验”的同时可能带来的潜在风险,仍有待业界的进一步检验和观察。 Llama 4 系列是否能真正开启一个由 Meta 引领的 AI 新时代,市场将给出最终答案。 Meta 也预告将在 4 月 29 日的 LlamaCon 上分享更多关于其愿景的信息。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...