综合介绍

Lepton AI 是一个领先的云原生AI平台,致力于为开发者和企业提供高效、可靠且易于使用的AI解决方案。通过其强大的计算能力和用户友好的界面,Lepton AI 帮助用户在复杂的AI项目中实现快速落地和扩展。

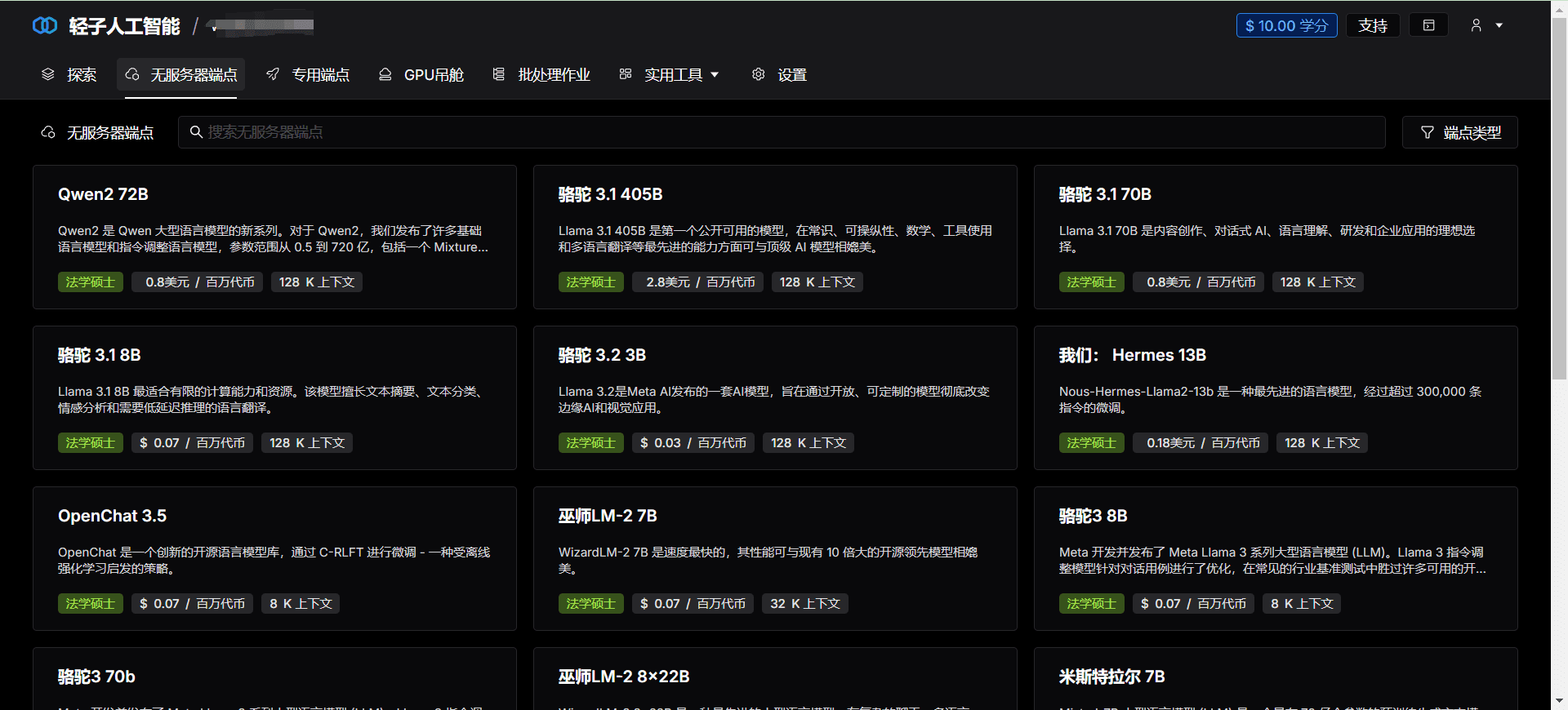

功能列表

- 高效计算:提供高性能计算资源,支持大规模AI模型的训练和推理。

- 云原生体验:无缝集成云计算技术,简化AI应用的开发和部署流程。

- GPU基础设施:提供顶级的GPU硬件支持,确保AI任务的高效执行。

- 快速部署:支持Python原生开发,无需学习容器或Kubernetes,即可快速部署模型。

- 灵活API:提供简单灵活的API,方便在任何应用中调用AI模型。

- 水平扩展:支持水平扩展,能够处理大规模工作负载。

使用帮助

安装与使用

- 注册账号:访问Lepton AI官网,点击“注册”按钮,填写相关信息完成注册。

- 创建项目:登录后,进入“控制台”,点击“创建项目”,填写项目名称和描述。

- 选择计算资源:在项目设置中,选择所需的计算资源,包括GPU类型和数量。

- 上传模型:在“模型管理”中,点击“上传模型”,选择本地模型文件进行上传。

- 配置环境:在“环境配置”中,选择所需的运行环境和依赖包。

- 部署模型:点击“部署”,系统会自动进行模型部署,并生成API接口。

- 调用API:在“API文档”中,查看生成的API接口文档,使用提供的API调用模型进行推理。

操作流程

- 模型训练:在本地使用Python进行模型训练,确保模型性能达到预期。

- 模型测试:在本地进行模型测试,验证模型的准确性和稳定性。

- 模型上传:将训练好的模型上传至Lepton AI平台,进行在线部署。

- 环境配置:根据模型需求,配置运行环境和依赖包,确保模型正常运行。

- API调用:使用生成的API接口,在应用程序中调用模型进行推理,实时获取结果。

- 监控与维护:在“监控”页面,查看模型运行状态和性能指标,及时进行维护和优化。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...