일반 소개

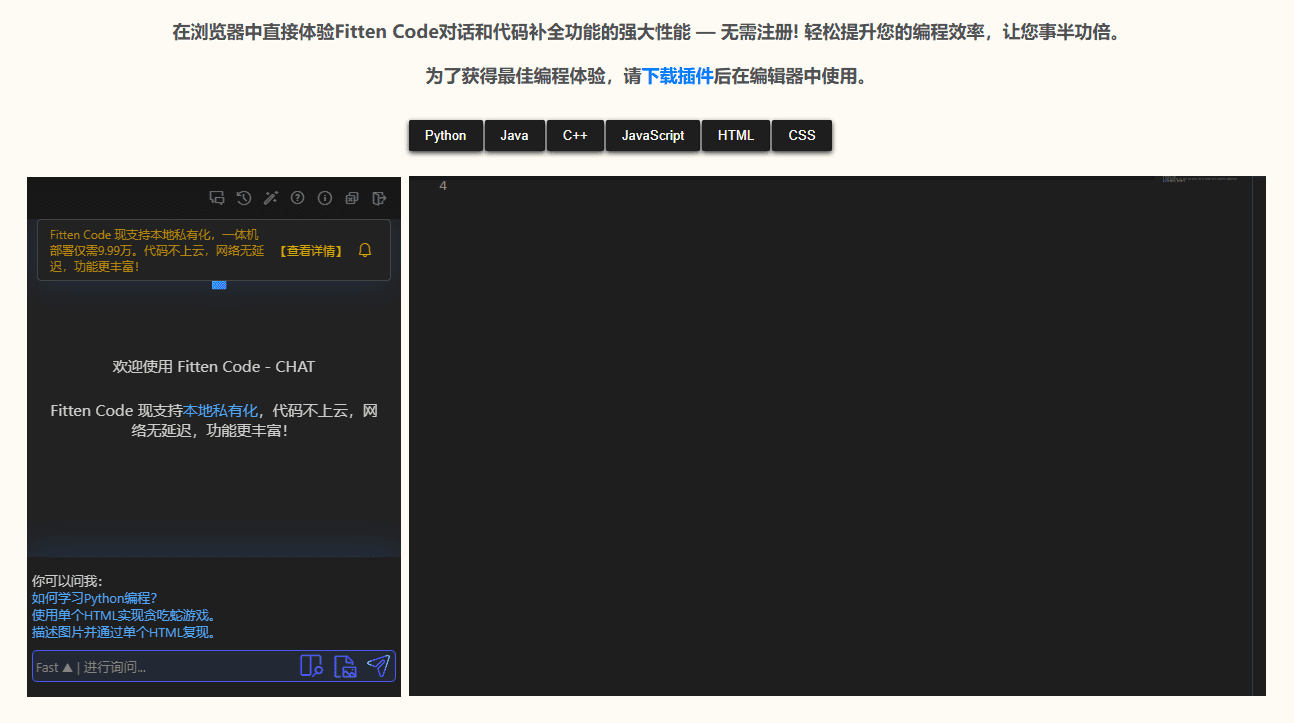

Langfuse는 오픈 소스 LLM(대규모 언어 모델) 엔지니어링 플랫폼입니다. 개발자가 호출 관찰, 프롬프트 관리, 실험 실행 및 결과 평가를 위한 도구를 제공하여 LLM 애플리케이션을 추적, 디버그 및 최적화하는 데 도움을 줍니다. Langfuse 팀이 개발한 이 플랫폼은 LangChain, OpenAI 등과 같은 프레임워크를 지원하며 MIT 라이선스를 따르고 활발한 커뮤니티를 보유하고 있습니다. 로컬 또는 클라우드에서 신속하게 자체 호스팅할 수 있으며, 신뢰할 수 있는 AI 애플리케이션을 개발하기 위해 협력하는 팀에 이상적입니다. langfuse는 클라우드 서비스(무료 패키지 포함)와 배포하기 쉽고 프로덕션 환경에서 검증된 자체 호스팅 옵션을 제공합니다.

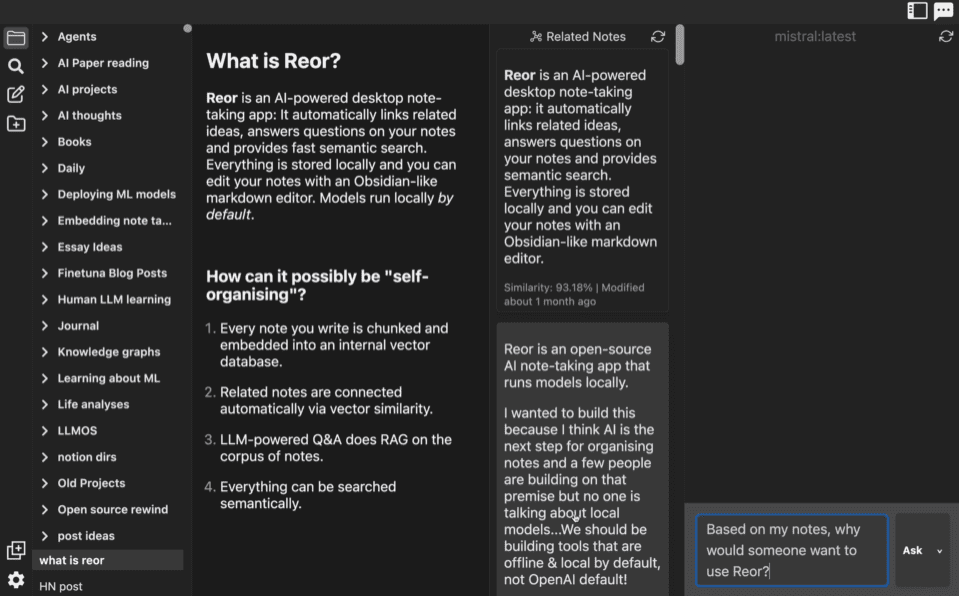

상담원 및 RAG 런타임이 시각화되고 관찰되는 방식은 LangSmith와 유사합니다.

기능 목록

- 응용 관찰LLM 애플리케이션에 대한 각 호출을 추적하여 입력 및 출력, 지연 시간 및 비용을 기록합니다.

- 큐 관리버전 관리 및 팀워크 조정을 지원하기 위해 큐 단어를 중앙 집중식으로 저장합니다.

- 데이터 집합 관리테스트 데이터 세트를 만들고 실험을 실행하여 모델 또는 큐 효과를 비교합니다.

- 평가 도구:: 사용자 피드백, 수동 라벨링 및 자동 평가를 지원하여 출력물의 품질을 확인합니다.

- 디버깅 지원상세 로그 및 사용자 세션을 확인하여 문제를 빠르게 파악하세요.

- 실험적인 놀이터개발 반복을 가속화하기 위해 프롬프트 단어 및 모델 구성을 테스트합니다.

- 멀티 프레임워크 지원LangChain, OpenAI SDK, LiteLLM 등과 호환됩니다.

- API 통합LLMOps 워크플로우를 사용자 지정할 수 있는 포괄적인 API를 제공합니다.

도움말 사용

설치 및 배포

클라우드 서비스

- 계정 등록하기액세스 :: 액세스 랑퓨즈 클라우드등록하려면 '가입'을 클릭합니다.

- 프로젝트 만들기로그인 후 '새 프로젝트'를 클릭하고 프로젝트 이름을 입력합니다.

- 키 받기:: 프로젝트 설정에서 생성

PUBLIC_KEY노래로 응답SECRET_KEY. - 사용 시작설치 필요 없음, SDK를 통해 클라우드 서비스에 직접 연결합니다.

로컬 배포(Docker Compose)

- 환경 준비하기Docker 웹 사이트에서 다운로드할 수 있는 Docker 및 Docker Compose가 설치되어 있는지 확인합니다.

- 코드 복제터미널에서 실행

git clone https://github.com/langfuse/langfuse.git그런 다음 카탈로그를 입력합니다.cd langfuse. - 서비스 시작: 입력

docker compose up를 클릭하고 시작이 완료될 때까지 기다리면 기본 주소는http://localhost:3000. - 검증(이론): 브라우저 액세스

http://localhost:3000로그인 페이지가 표시되면 성공한 것입니다. - 키 구성등록 후 SDK용 UI에서 키를 생성합니다.

쿠버네티스 배포(프로덕션 권장 사항)

- 클러스터 준비하기미니큐브(로컬 테스트용) 또는 AWS와 같은 클라우드 서비스를 사용하여 Kubernetes 클러스터를 생성합니다.

- 헬름 추가: 달리기

helm repo add langfuse https://langfuse.github.io/langfuse-k8s노래로 응답helm repo update. - 구성만들기

values.yaml데이터베이스 및 주요 정보가 채워집니다( 공식 문서). - 배포: 입력

helm install langfuse langfuse/langfuse -f values.yaml완료될 때까지 기다립니다. - 인터뷰: 인그레스를 기반으로 서비스 주소에 대한 액세스를 구성합니다.

가상 머신 배포

- 단일 가상 머신에서 실행

docker compose up단계는 로컬 배포와 동일합니다.

주요 기능

응용 관찰

- SDK 설치하기파이썬 프로젝트 실행

pip install langfuseJS/TS 프로젝트 실행npm install langfuse. - 초기화: 코드에서 키와 호스트를 구성합니다:

from langfuse import Langfuse langfuse = Langfuse(public_key="pk-lf-xxx", secret_key="sk-lf-xxx", host="http://localhost:3000")

- 통화 녹음: 데코레이터 또는 수동 추적을 사용합니다:

from langfuse.decorators import observe @observe() def chat(input): return openai.chat.completions.create(model="gpt-3.5-turbo", messages=[{"role": "user", "content": input}]) chat("你好") - 체크 아웃: UI의 '추적' 페이지에서 통화 내역을 확인하세요.

큐 관리

- 새로운 팁UI의 '프롬프트' 페이지에서 '새 프롬프트'를 클릭하고 이름과 내용(예: 이름과 내용)을 입력합니다:

System: 你是一个助手,直接回答问题。 User: {{question}} - 사용 팁코드 호출

langfuse.get_prompt("prompt-name"). - 버전 관리프롬프트를 수정한 후 자동으로 버전을 저장하며, 롤백할 수 있습니다.

데이터 세트 및 실험

- 데이터 집합 만들기UI의 '데이터 세트' 페이지에서 '데이터 세트 만들기'를 클릭하고 이름을 'qa-test'로 지정합니다.

- 데이터 추가예를 들어 CSV를 입력하거나 업로드합니다:

Input: "1+1等于几?" Expected: "2" - 실험 실행:: 코드에서 테스트하세요:

dataset = langfuse.get_dataset("qa-test") for item in dataset.items: result = chat(item.input) item.link(langfuse.trace({"output": result}), "test-1") - 분석: UI에서 실험 결과를 확인합니다.

놀이터

- 로 이동UI에서 '놀이터'를 클릭하고 프롬프트와 모델 매개변수를 입력합니다.

- 테스트(기계 등)실행을 클릭하여 출력을 확인하고 매개변수를 조정한 후 저장합니다.

- 점프"추적" 오류 결과에서 바로 보기 놀이터 수정.

주요 기능 작동

디버깅 로그

- '추적' 페이지에서 통화를 클릭하면 입력, 출력 및 컨텍스트를 볼 수 있습니다.

- '세션'에서 사용자 세션을 보고 다자간 대화를 분석할 수 있습니다.

평가 결과

- 수동 작동: "점수" 페이지에서 출력(0-1)을 평가합니다.

- 자동화API를 통해 평가를 추가합니다:

langfuse.score(trace_id="xxx", name="accuracy", value=0.95)

API 사용

- 추적을 생성하기 위해 OpenAPI 사양 또는 SDK(예: Python/JS)를 사용하여 호출합니다:

curl -X POST "http://localhost:3000/api/traces" -H "Authorization: Bearer sk-lf-xxx" -d '{"id": "trace-1", "name": "test"}'

애플리케이션 시나리오

- RAG 프로세스 시각화 추적

- 키워드 리콜, 벡터 리콜, 리콜 융합, 재배치, 답변에 이르는 전체 프로세스의 시각적 추적

- 지능형 고객 서비스 개발

- 이 팀은 Langfuse를 사용하여 대화를 추적하고 답변의 품질을 최적화하며 고객 경험을 개선합니다.

- 모델 성능 비교

- 개발자는 퀴즈 작업에서 여러 LLM의 성능을 테스트하기 위해 데이터 세트를 생성합니다.

- 온프레미스 배포

- 이 회사는 민감한 데이터를 보호하고 내부 AI 애플리케이션을 디버깅하기 위해 Langfuse를 자체 호스팅하고 있습니다.

QA

- 어떤 언어와 프레임워크가 지원되나요?

- Python 및 JS/TS를 지원하며 LangChain, OpenAI, LlamaIndex 등과 호환됩니다.

- 셀프 호스팅을 위한 최소 구성은 무엇인가요?

- 소규모 프로젝트는 2코어 CPU와 4GB RAM을 사용하고, 대규모 프로젝트는 8코어와 16GB를 권장합니다.

- 원격 측정을 비활성화하려면 어떻게 하나요?

- 에서 환경 변수를 설정합니다.

TELEMETRY_ENABLED=false.

- 에서 환경 변수를 설정합니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...