综合介绍

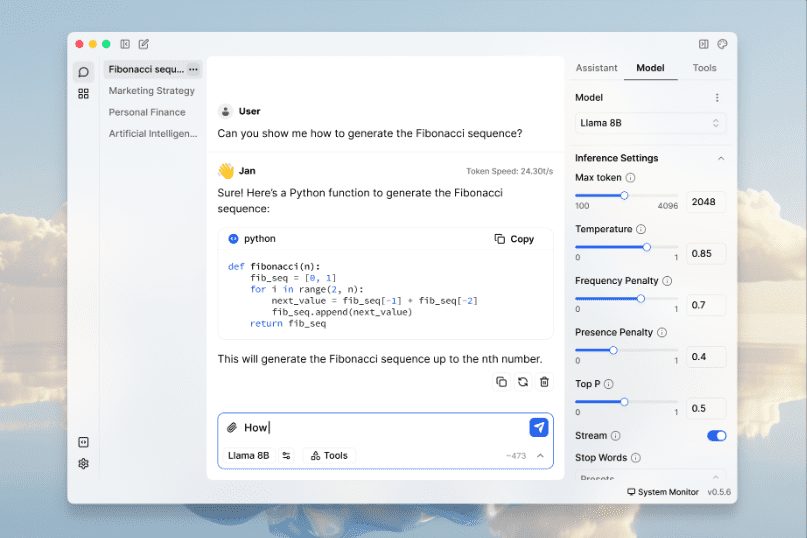

Jan 是一个开源的 ChatGPT 替代品,能够在用户的设备上 100% 离线运行。它由 Cortex 引擎驱动,支持多种硬件平台,包括 NVIDIA GPU 和 Apple M 系列芯片。Jan 提供了丰富的模型库,用户可以下载并运行如 Llama、Gemma 和 Mistral 等流行的语言模型,同时也可以连接到远程 AI API。Jan 强调用户隐私,所有数据处理均在本地完成,确保用户数据的安全和控制。Jan 由 Cortex 提供支持,这是一种可嵌入的本地 AI 引擎,能够在任何硬件上运行,从个人电脑到多 GPU 集群。

功能列表

- 本地运行AI模型:支持 Llama、Gemma、Mistral 等多种流行模型。

- 多引擎支持:兼容 llama.cpp、TensorRT-LLM 等多种引擎。

- 离线运行:无需互联网连接,所有数据处理均在本地完成。

- 模型库:提供丰富的模型下载和管理功能。

- 远程AI连接:可连接到 OpenAI、Groq、Cohere 等远程 AI 服务。

- 本地API服务器:设置并运行与 OpenAI 兼容的本地 API 服务器。

- 高度可定制:支持通过扩展插件进行功能定制。

- 隐私保护:所有数据存储在本地,用户完全控制数据。

使用帮助

安装流程

- 下载:访问 Jan 官方网站 或 GitHub 页面 下载适用于 Windows、MacOS 或 Linux 的安装包。

- 安装:

- Windows:运行下载的

jan.exe文件,按照提示完成安装。 - MacOS:下载

jan.dmg文件,双击打开并将 Jan 拖动到应用程序文件夹。 - Linux:下载

.deb或.AppImage文件,使用命令行安装或直接运行。

- Windows:运行下载的

使用指南

- 启动应用:安装完成后,打开 Jan 应用程序。

- 选择模型:在模型库中选择并下载所需的 AI 模型,如 Llama、Gemma 或 Mistral。

- 本地运行:选择已下载的模型,点击“运行”按钮,模型将在本地设备上启动。

- 连接远程AI:如果需要更强大的计算能力,可以在设置中配置并连接到 OpenAI、Groq 等远程 AI 服务。

- 使用API服务器:在设置中启用本地 API 服务器,按照提示配置 API 密钥,即可使用与 OpenAI 兼容的 API 进行开发和测试。

- 定制扩展:访问扩展中心,下载并安装所需的扩展插件,定制 Jan 的功能以满足特定需求。

详细操作流程

- 模型下载与管理:

- 打开 Jan 应用,进入“模型库”。

- 浏览可用模型,点击“下载”按钮进行下载。

- 下载完成后,模型将显示在“已下载”列表中。

- 选择模型,点击“运行”按钮启动模型。

- 本地API服务器配置:

- 进入“设置”页面,找到“API服务器”选项。

- 启用 API 服务器,设置 API 密钥。

- 使用提供的 API 文档,开始调用本地 API 进行开发。

- 扩展插件安装:

- 访问“扩展中心”,浏览可用的扩展插件。

- 点击“安装”按钮,按照提示完成安装。

- 安装完成后,扩展插件将显示在“已安装”列表中。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...