Inception Labs 推出 Mercury 系列扩散大语言模型 (dLLM),其速度和成本比现有 LLM 降低了 10 倍,将语言模型的智能和速度推向了新的前沿。

核心要点

- Inception Labs 正式发布 Mercury 系列扩散大语言模型 (dLLM),这标志着新一代 LLM 的诞生,预示着快速、高质量文本生成技术迈上新的台阶。

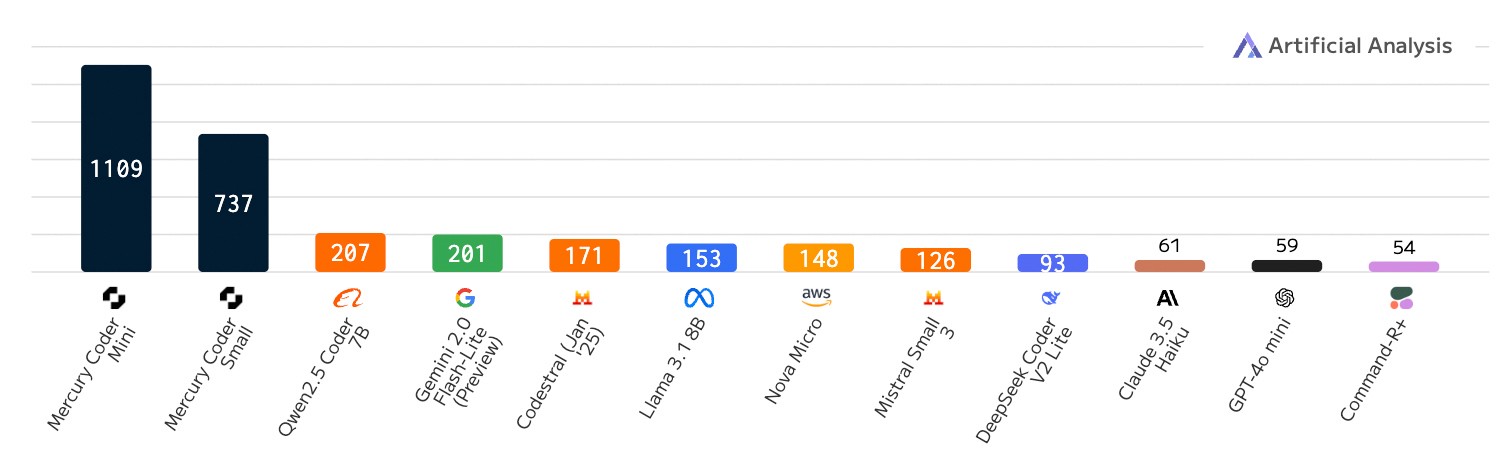

- Mercury 的速度比目前速度优化的 LLM 快 10 倍。在 NVIDIA H100 GPU 上,Mercury 模型运行速度超过 1000 tokens/秒,这种速度此前只有使用定制芯片才能实现。

- 代码生成模型 Mercury Coder 现已在 playground 平台开放测试。Inception Labs 通过 API 和本地部署的方式,为企业客户提供代码模型和通用模型的使用权限。

Inception Labs 的愿景 — Diffusion 赋能下一代 LLM

目前的大语言模型 (LLM) 普遍采用自回归模式,这意味着它们像人类写作一样,从左到右逐个 token 生成文本。这种生成方式本质上是串行的 —— 必须先生成前面的 token,才能生成后面的 token。而且,每生成一个 token 都需要评估一个拥有数十亿参数的神经网络。行业领先的 LLM 公司正押注于增加推理时计算,以提升模型的推理和纠错能力,但生成冗长的推理过程也导致了推理成本的飙升和延迟的增加,最终使得产品变得难以使用。为了让高质量的 AI 解决方案真正普及,一场范式转变势在必行。

扩散模型为我们提供了这样一种范式转变的可能。这类模型采用 “由粗到精” 的生成过程。正如视频所示,模型的输出结果从最初的纯噪声开始,经过几个 “去噪” 步骤逐步优化 refined。

与自回归模型不同,扩散模型不受限于仅考虑先前输出的内容。这使得它们在推理和构建响应结构方面表现更出色。此外,由于扩散模型能够持续优化其输出,因此可以有效纠正错误和减少幻觉。正是基于这些优势,扩散模型成为了当前视频、图像和音频生成领域众多杰出 AI 解决方案的核心驱动力,例如 Sora、Midjourney 和 Riffusion 等等。然而,将扩散模型应用于文本和代码等离散数据的尝试,在此之前从未获得成功。直到 Mercury 的出现,这一局面被彻底打破。

Mercury Coder — 1000+ Tokens/秒,前沿智能触手可及

Inception Labs 激动地宣布推出 Mercury Coder,这是首个公开可用的 dLLM。

Mercury Coder 将 AI 能力推向新的前沿:其速度比当前一代 LLM 快 5-10 倍,并以更低的成本提供高质量的响应。Mercury Coder 的诞生,离不开 Inception Labs 创始团队突破性的研究成果 —— 他们不仅是图像扩散模型的先驱,还共同发明了包括直接偏好优化 (Direct Preference Optimization, DPO)、 Flash Attention 和 Decision Transformers 等在内的多项核心生成式 AI 技术。

dLLM 可以作为现有自回归 LLM 的直接替代方案,并支持包括 RAG(检索增强生成)、工具使用和 Agent 工作流在内的所有应用场景。当接收到用户查询时,dLLM 不会逐个 token 生成答案,而是采用由粗到精的方式生成答案,具体过程可参考上文的动画演示。Transformer 模型(在 Mercury Coder 中使用)经过大量数据训练,能够全局性地优化答案质量,并行修改多个 token,从而不断改进生成结果。

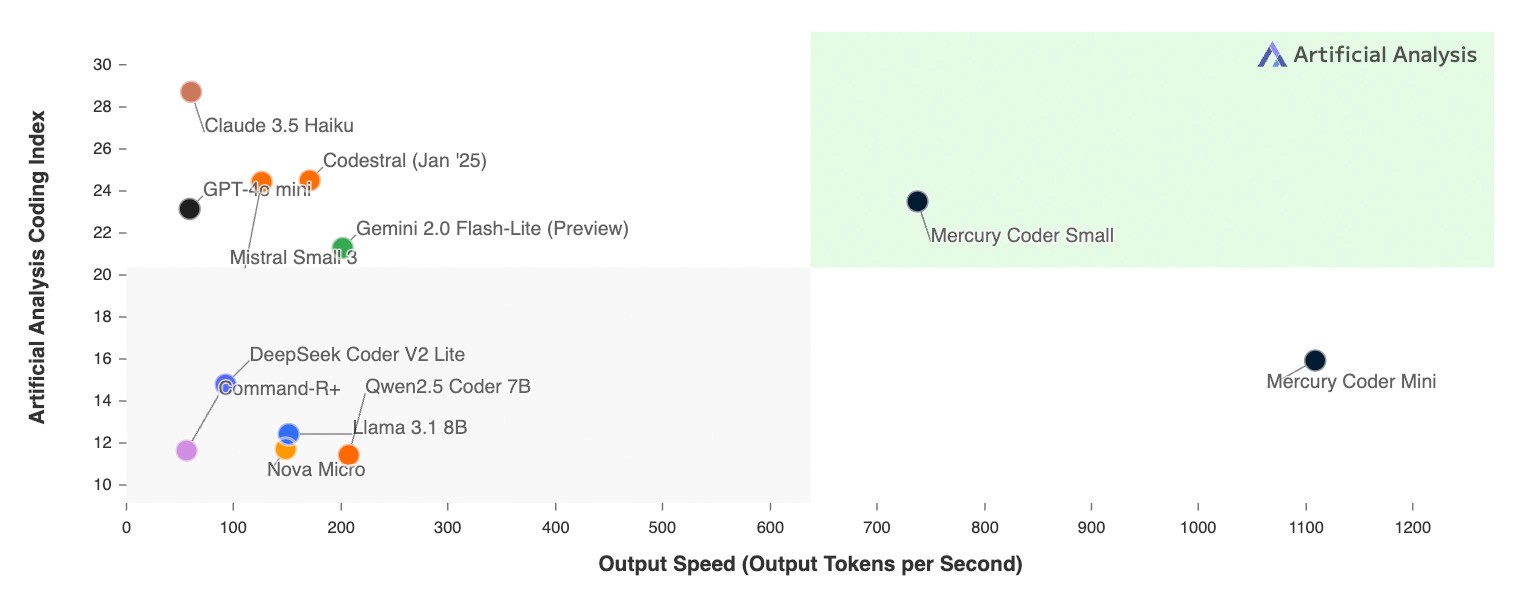

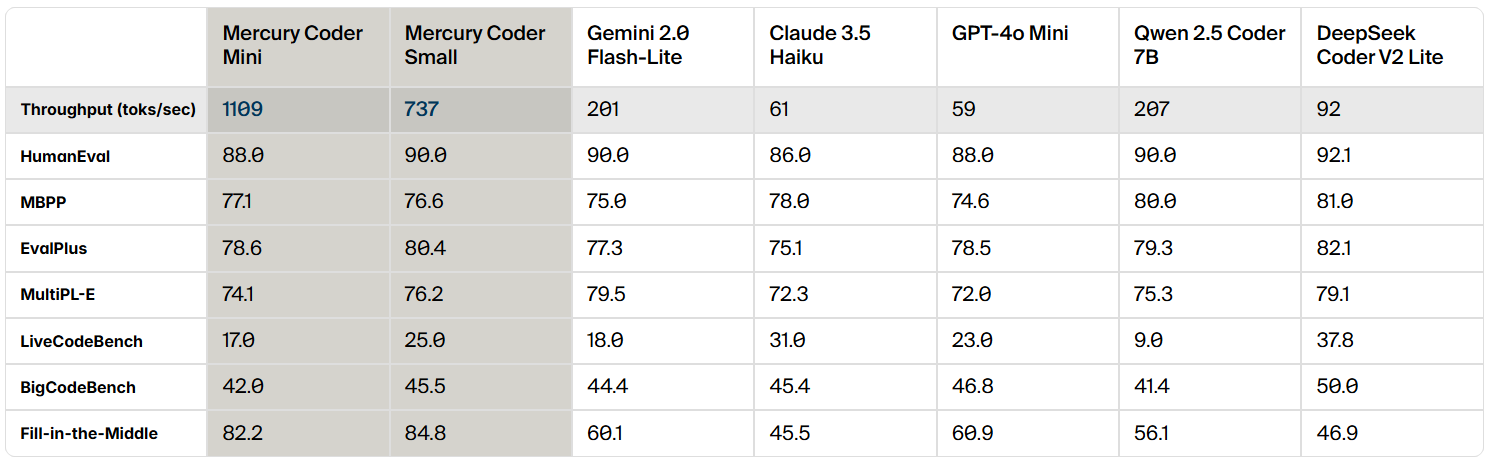

Mercury Coder 是一款专门为代码生成优化的 dLLM。在标准代码 benchmark 评测中,Mercury Coder 在众多 benchmark 上都表现出色,其性能通常超越了 GPT-4o Mini 和 Claude 3.5 Haiku 等速度优化的自回归模型,同时速度还提升了高达 10 倍。

dLLM 的独特之处在于其惊人的速度。即使是速度优化的自回归模型,其运行速度最多也只能达到 200 tokens/秒,而 Mercury Coder 在通用 NVIDIA H100 GPU 上运行速度却超过了 1000 tokens/秒,速度提升了 5 倍。与某些前沿模型(运行速度可能低于 50 tokens/秒)相比,Mercury Coder 的速度提升甚至超过 20 倍。

此前,只有 Groq、Cerebras 和 SambaNova 等专用硬件才能实现 dLLM 这样的吞吐量。 Mercury Coder 的算法改进与硬件加速是相辅相成的,在更快的芯片上,速度提升还将进一步叠加。

速度对比:每秒输出 Tokens 数;代码编写工作负载

更令人兴奋的是,开发者们更青睐 Mercury Coder 的代码补全功能。在 Copilot Arena 的 benchmark 评测中,Mercury Coder Mini 并列第二,超越了 GPT-4o Mini 和 Gemini-1.5-Flash 等速度优化模型,甚至与 GPT-4o 等更大模型的性能不相上下。与此同时,Mercury Coder 也是速度最快的模型,比 GPT-4o Mini 快大约 4 倍。

Inception Labs 诚邀您亲自体验 Mercury Coder 的强大功能。Inception Labs 与 Lambda Labs 合作,在 playground 平台为您提供了 Mercury Coder 的试用入口。正如以下视频所示,体验 Mercury Coder 如何在极短的时间内生成高质量代码。

这对 AI 应用意味着什么?

Mercury dLLM 的早期采用者,包括客户支持、代码生成和企业自动化等领域的市场领导者,正在成功地将标准的自回归基础模型切换为 Mercury dLLM 作为直接替代方案。这种转变直接转化为更出色的用户体验和更低的成本。在对延迟敏感的应用场景中,合作伙伴们过去常常为了满足严格的延迟要求,而不得不选择规模较小、能力较弱的模型。现在,得益于 dLLM 的卓越性能,这些合作伙伴可以使用更大、更强大的模型,同时仍然满足他们原有的成本和速度要求。

Inception Labs 通过 API 和本地部署两种方式提供 Mercury 系列模型的使用权限。Mercury 模型与现有硬件、数据集以及监督微调 (SFT) 和对齐 (RLHF) 流程完全兼容。API 和本地部署均支持微调。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...