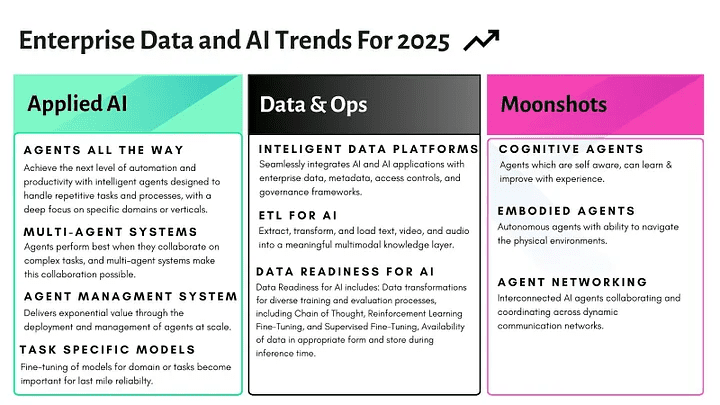

英伟达 CEO 黄仁勋将 AI 智能体誉为 “数字劳动力”,而他并非唯一持有此观点的科技领袖。 微软 CEO 萨提亚 · 纳德拉也认为,智能体技术将从根本上变革企业的运作模式。

这些智能体能够与外部工具和 API 进行交互,从而极大地拓展了其应用场景。 然而,AI 智能体技术远非完美,由于潜在交互的复杂性,评估其在实际应用中的性能一直是一项挑战。

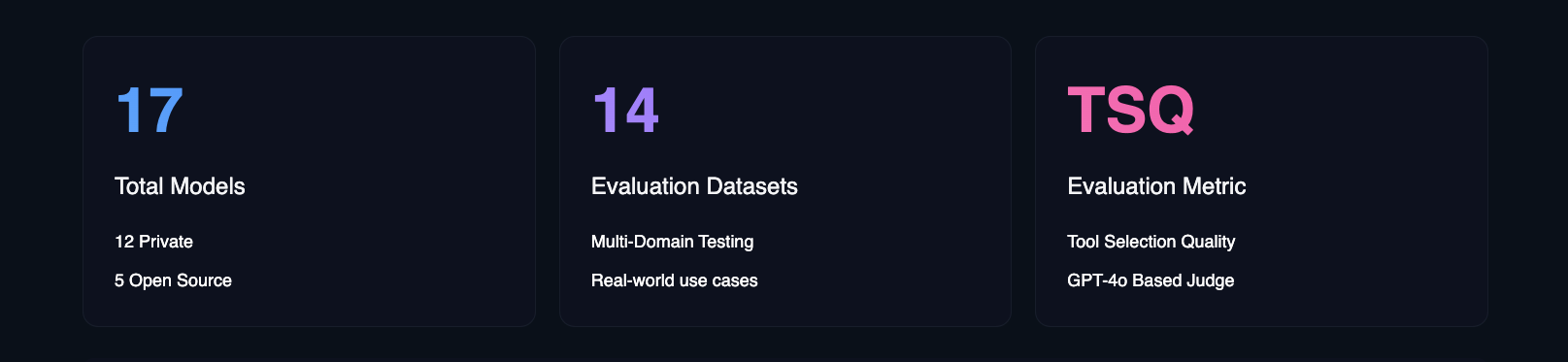

为了解决这一难题,Hugging Face 推出了 Agent 智能体排行榜。 该排行榜利用 Galileo 的工具选择质量(Tool Selection Quality, TSQ)指标,对不同的大语言模型(LLM)在处理基于工具的交互时的性能进行评估,从而为开发者提供清晰的参考。

- Hugging Face Agent 智能体排行榜

Hugging Face 构建此排行榜旨在解答一个核心问题:“AI 智能体在真实的商业环境中表现究竟如何?” 学术基准测试固然重要,但它们侧重于技术能力,而 Hugging Face 更关注哪些模型能够真正适用于各种实际用例。

Hugging Face Agent 智能体评估排行榜的独特之处

目前的主流评估框架通常侧重于特定领域。 例如,BFCL 在数学、娱乐和教育等学术领域表现突出; τ-bench 则专注于零售和航空等特定行业场景; xLAM 覆盖了 21 个数据生成领域; 而 ToolACE 则专注于 390 个领域中的 API 交互。 Hugging Face 的排行榜则独辟蹊径,它将这些数据集整合为一个全面的评估框架,旨在覆盖更广泛的领域和真实世界的用例。

通过整合 विविध 基准和测试场景,Hugging Face 的排行榜不仅提供模型技术能力的评估,更侧重于提供关于模型如何处理边缘情况和安全考量的可操作性洞见。 Hugging Face 还深入分析了成本效益、实施指南和业务影响等多重因素——这些因素对于希望部署 AI 智能体的企业而言至关重要。 Hugging Face 希望通过此排行榜,帮助企业团队更精准地定位最符合其特定需求的 AI 智能体模型,并充分考虑实际应用中的各种约束。

考虑到新型大语言模型(LLM)的发布频率,Hugging Face 计划每月更新排行榜基准,以确保其与快速发展的模型技术保持同步。

主要发现

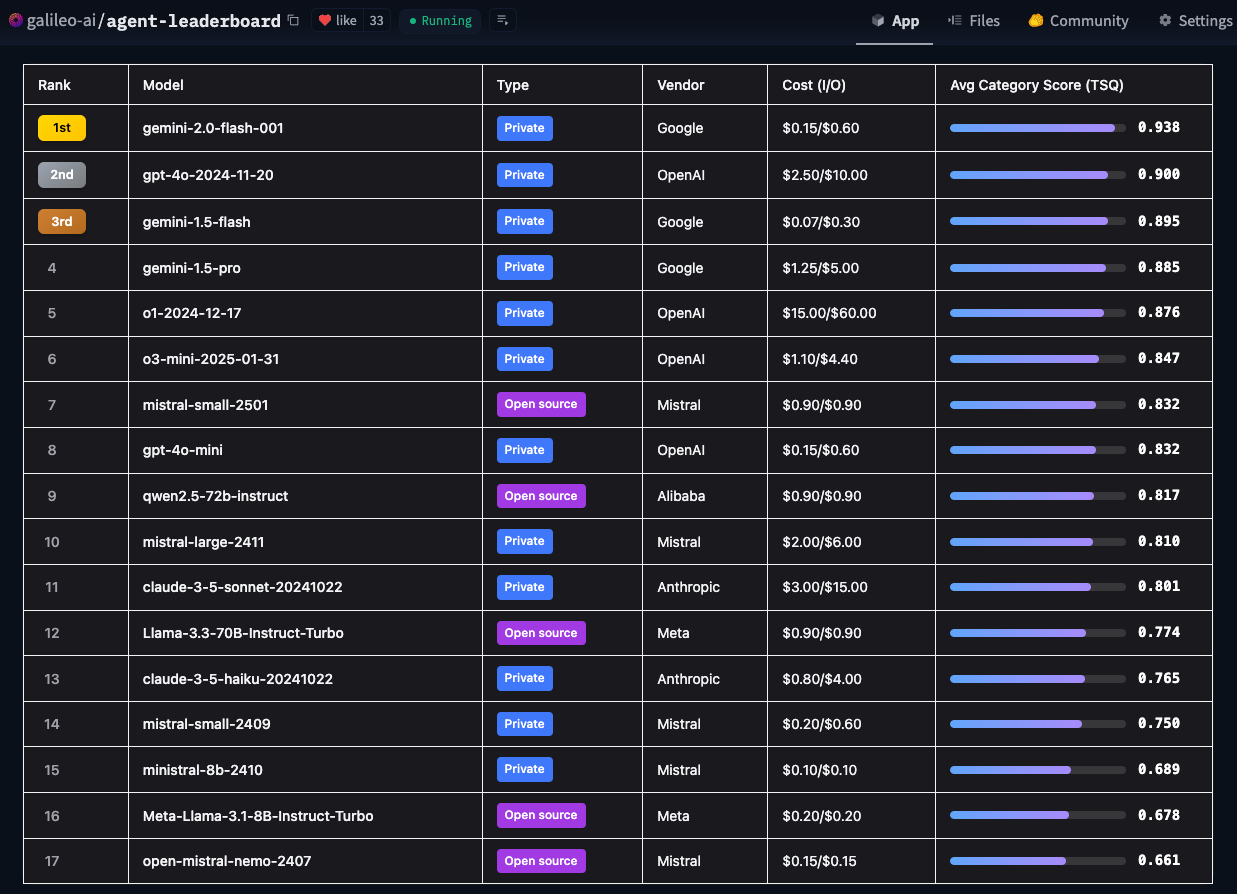

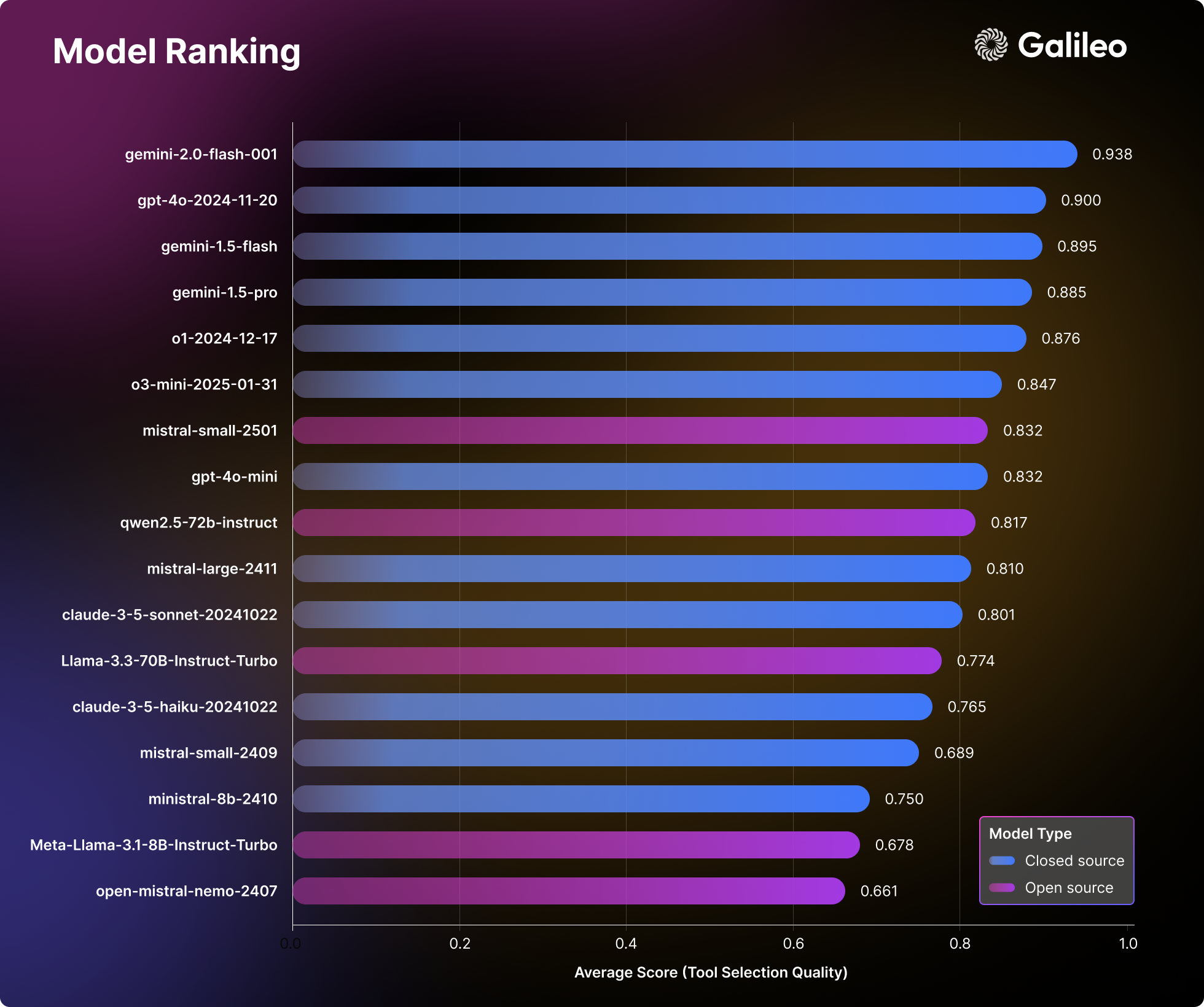

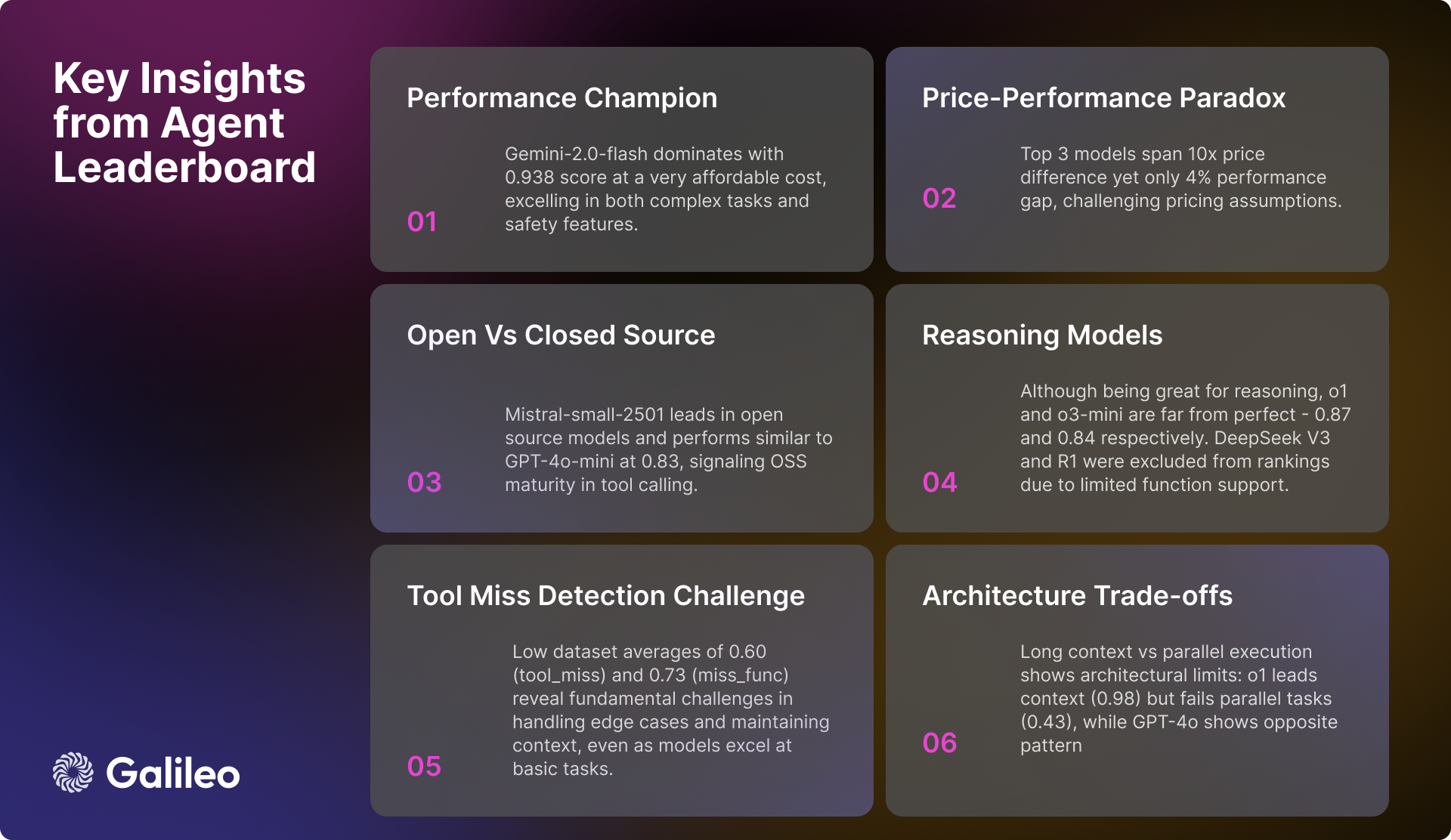

Hugging Face 对 17 个领先的大语言模型(LLM)进行了深入分析,揭示了 AI 智能体在处理真实世界任务时所展现出的有趣模式。 Hugging Face 对私有模型和开源模型进行了全面的压力测试,测试过程涵盖 14 个不同的基准,评估维度从简单的 API 调用到复杂的多工具交互。

大语言模型(LLM)排名

Hugging Face 的评估结果,挑战了人们对于模型性能的传统认知,并为正在构建 AI 智能体的团队提供了极具价值的实践参考。

Agent 智能体排行榜的主要发现

工具调用的复杂性

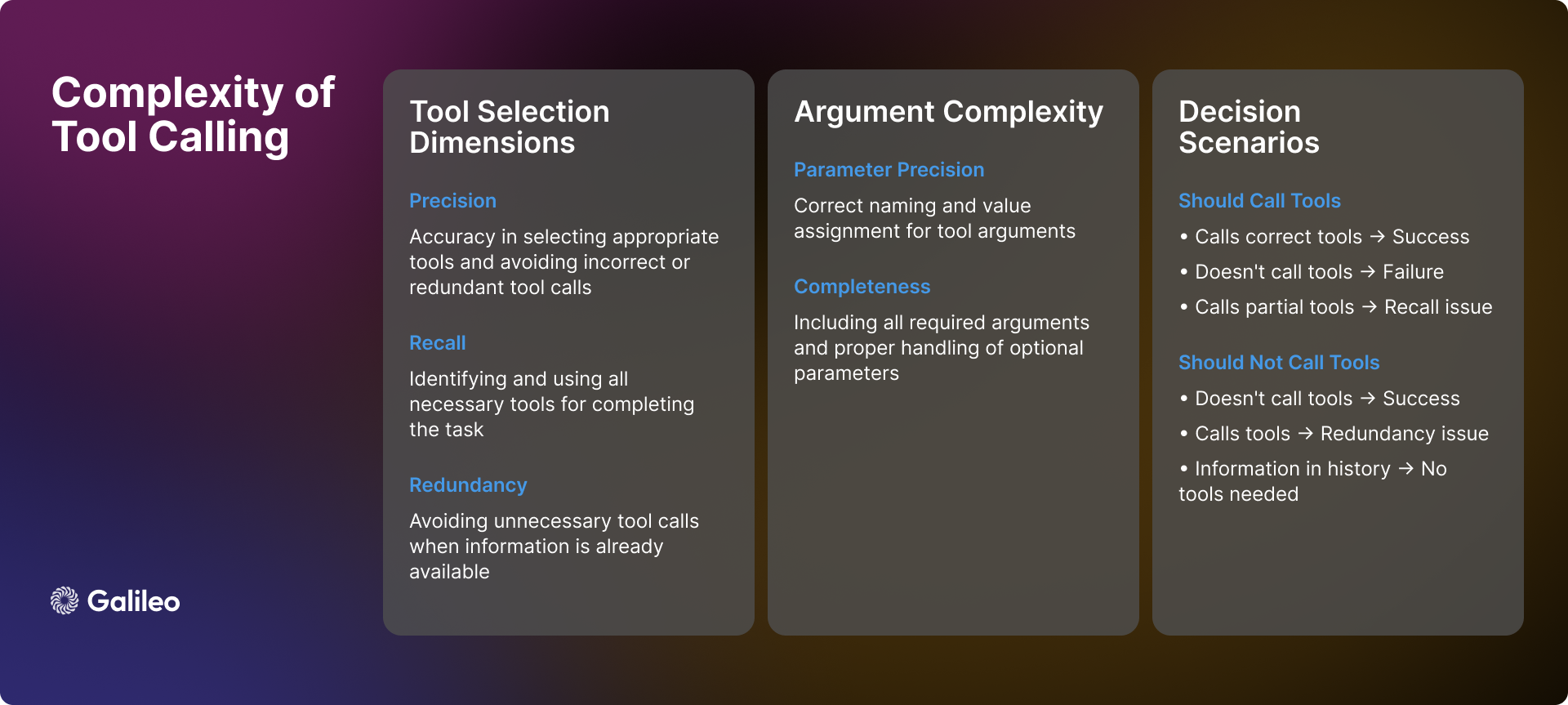

工具调用的复杂性远不止简单的 API 调用。 在实际应用中,AI 智能体在工具使用方面面临着诸多复杂场景和挑战,需要做出精准的决策:

场景识别

当智能体接收到用户查询时,首要任务是判断是否需要调用工具。 有时,所需信息可能已存在于对话历史记录中,此时工具调用便显得多余。 此外,可用的工具可能不足以解决用户问题,或者与任务本身毫不相关。 在这些情况下,智能体需要能够识别自身的局限性,并坦诚告知用户,而不是强行使用不合适的工具。

工具选择动态

工具选择并非简单的 “是” 或 “否” 的二元问题,它涉及到精确率和召回率。 理想情况下,智能体应能准确识别所有必要的工具,同时避免选择不相关的工具。 然而,现实情况往往更为复杂。 智能体可能会正确识别出一个必要的工具,但遗漏了其他工具(召回率不足),或者在选择合适工具的同时,也错误地选择了一些不必要的工具(精确率不足)。 虽然这两种情况都非最优,但它们代表了不同程度的选择偏差。

参数处理

即使智能体成功选择了正确的工具,参数处理仍然可能引入新的挑战。 智能体必须:

- 提供所有必需的参数,并确保参数命名正确。

- 妥善处理可选参数。

- 保证参数值的准确性。

- 根据工具的具体规范格式化参数。

顺序决策

对于多步骤任务,智能体需要展现出更高级的决策能力:

- 确定最佳的工具调用顺序。

- 处理工具调用之间的相互依赖关系。

- 在多个操作之间保持上下文连贯性。

- 灵活应对局部成功或失败的情况。

上述复杂性充分说明,工具选择质量不应被视为一个简单的指标。 相反,它应被视为对智能体在真实场景中进行复杂决策能力的综合评估。

方法论

Hugging Face 的评估过程遵循一套系统化的方法,力求对 AI 智能体进行全面且公正的评估:

- 模型选择: Hugging Face 精心挑选了一组多样化的领先语言模型,既包括专有模型,也包括开源实现。 这种选择策略旨在全面反映当前技术 landscape 的全貌。

- 智能体配置: Hugging Face 将每个模型都配置为一个智能体,并采用标准化的系统提示,同时授予它们访问一组一致的工具的权限。 这种标准化的配置确保了性能差异能够真实反映模型自身固有的能力,而非受到提示工程等外部因素的影响。

- 指标定义: Hugging Face 将工具选择质量(Tool Selection Quality,TSQ)确立为核心评估指标,重点考察工具选择的正确性以及参数使用的有效性。 TSQ 指标的设计充分考虑了真实世界应用场景中的性能需求。

- 数据集策划: Hugging Face 从已有的成熟基准数据集中,有策略地抽样构建了一个平衡且多领域的数据集。 该数据集全面测试了智能体的各项能力,从基础的函数调用到复杂的多轮交互均有覆盖,确保评估的全面性。

- 评分系统: 最终的性能得分通过计算所有数据集上的等权重平均值得出。 这种方法保证了评估的均衡性,避免任何单一能力主导整体评估结果,从而更客观地反映智能体的综合性能。

通过这种结构化的评估方法,Hugging Face 旨在提供能够直接指导真实世界部署决策的深刻见解。

Hugging Face 如何衡量 Agent 智能体的性能?

评估框架的工作原理

正如上文所述,工具调用评估需要在各种不同的场景中进行可靠的测量。 Hugging Face 专门开发了 工具选择质量 (Tool Selection Quality) 指标,用于评估智能体的工具调用性能,全面考察工具选择的准确性和参数使用的有效性。 该评估框架旨在判断智能体是否合理利用工具完成任务,并识别工具使用不必要的情况。

在评估过程中,Hugging Face 采用了 GPT-4o 和 ChainPoll 模型来评估工具选择决策。 针对每次交互,Hugging Face 收集了多个独立的判断结果,最终得分代表正面评估的比例。 每个判断结果都包含详细的解释,从而确保评估过程的透明度。

以下代码示例展示了如何使用 TSQ 指标评估数据集上大语言模型(LLM)的工具调用性能:

import promptquality as pq

import pandas as pd

file_path = "path/to/your/dataset.parquet" # 替换为你的数据集文件路径

project_name = "agent-leaderboard-evaluation" # 替换为你的项目名称

run_name = "tool-selection-quality-run" # 替换为你的运行名称

model = "gpt-4o" # 你想要评估的模型名称

tools = [...] # 你的工具列表

llm_handler = pq.LLMHandler() # 初始化 LLMHandler

df = pd.read_parquet(file_path, engine="fastparquet")

chainpoll_tool_selection_scorer = pq.CustomizedChainPollScorer(

scorer_name=pq.CustomizedScorerName.tool_selection_quality,

model_alias=pq.Models.gpt_4o,

)

evaluate_handler = pq.GalileoPromptCallback(

project_name=project_name,

run_name=run_name,

scorers=[chainpoll_tool_selection_scorer],

)

llm = llm_handler.get_llm(model, temperature=0.0, max_tokens=4000)

system_msg ={

"role":"system",

"content":'Your job is to use the given tools to answer the query of human. If there is no relevant tool then reply with "I cannot answer the question with given tools". If tool is available but sufficient information is not available, then ask human to get the same. You can call as many tools as you want. Use multiple tools if needed. If the tools need to be called in a sequence then just call the first tool.',

}

outputs = []

for row in df.itertuples():

chain = llm.bind_tools(tools)

outputs.append(

chain.invoke(

[system_msg,*row.conversation],

config=dict(callbacks=[evaluate_handler])

)

)

evaluate_handler.finish()

为何 Hugging Face 选择使用大语言模型(LLM)进行工具调用评估?

基于大语言模型(LLM)的评估方法能够对各种复杂场景进行全面评估。 这种方法可以有效验证智能体是否妥善处理了上下文信息不足的情况,从而判断在工具使用前是否需要用户提供更多信息。 在多工具应用场景中,该方法能够检查智能体是否识别出所有必要的工具,并以正确的顺序调用它们。 在长上下文对话中,该方法可以确保智能体充分考虑对话历史中早期的相关信息。 即使在工具缺失或不适用的情况下,该评估方法也能判断智能体是否正确地避免了工具调用,从而避免了不恰当的操作。

要在 TSQ 指标上取得优异成绩,AI 智能体需要展现出复杂的能力,包括:在必要时选择正确的工具、提供准确的参数、高效地协调多个工具,以及识别工具使用不必要的场景。 例如,当所有必要信息都已存在于对话历史中,或者没有合适的工具可用时,避免使用工具反而是更优选择。

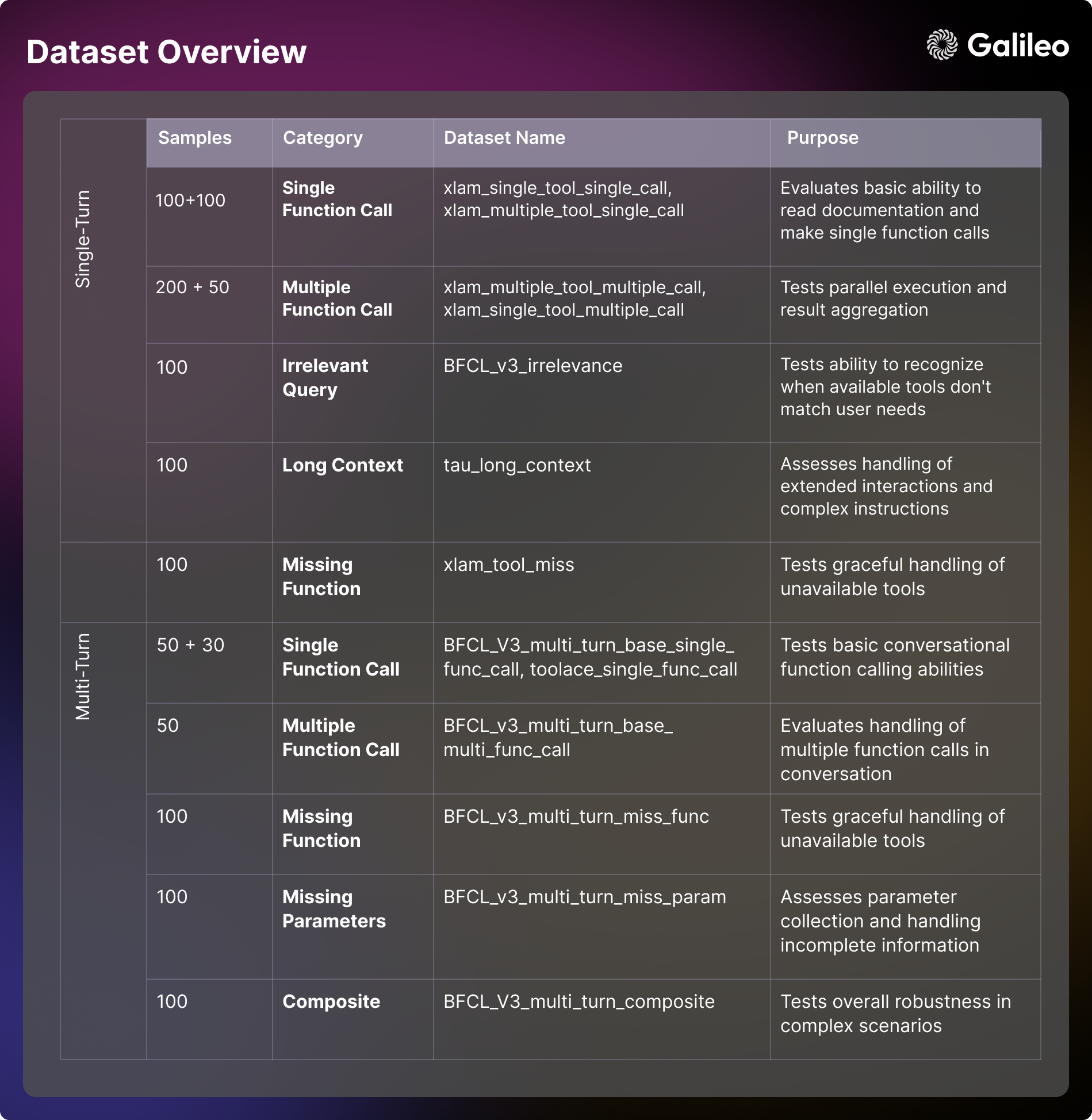

评估数据集的内容构成

Hugging Face 的评估框架采用了一组精心策划的基准数据集,这些数据集来源于 BFCL (Berkeley Function Calling Leaderboard,伯克利函数调用排行榜)、 τ-bench (Tau benchmark,τ 基准)、 Xlam 和 ToolACE。 每个数据集都旨在针对性地测试智能体在特定方面的能力。 理解这些评估维度,对于模型评估和实际应用开发都至关重要。

单轮能力

- 基本工具使用 场景: 主要评估智能体理解工具文档、处理参数和执行基本函数调用的能力。 此维度侧重于考察直接交互中智能体的响应格式化和错误处理能力。 这种能力对于实际应用中简单的自动化任务至关重要,例如设置提醒或获取基本信息 [xlam_single_tool_single_call]。

- 工具选择 场景: 评估模型从多个工具选项中选择正确工具的能力。 此维度考察模型在多大程度上能够理解工具文档,并就工具的适用性做出合理决策。 对于构建多用途智能体的实际应用场景,这种能力至关重要 [xlam_multiple_tool_single_call]。

- 并行执行 场景: 考察模型同时编排多个工具协同工作的能力。 此维度对于提升实际应用中的效率至关重要 [xlam_multiple_tool_multiple_call]。

- 工具重用 场景: 评估智能体有效处理批量操作和参数变化的能力。 这方面对于实际应用中的批量处理场景尤为重要 [xlam_single_tool_multiple_call]。

错误处理和边缘情况

- 不相关性检测 场景: 测试模型识别工具局限性,并在可用工具与用户需求不匹配时进行合理沟通的能力。 这种能力是保障用户体验和系统可靠性的基石 [BFCL_v3_irrelevance]。

- 缺失工具处理 场景: 考察模型如何优雅地处理所需工具不可用的情况,包括告知用户其局限性以及提供替代方案的能力 [xlam_tool_miss, BFCL_v3_multi_turn_miss_func]。

上下文管理

- 长上下文 场景: 评估模型在长程对话中保持上下文连贯性并理解复杂指令的能力。 这种能力对于处理复杂工作流程和长时间的交互至关重要 [tau_long_context, BFCL_v3_multi_turn_long_context]。

多轮交互

- 基本对话 场景: 测试智能体在多轮对话中进行会话式函数调用和保持上下文的能力。 这种基本能力对于开发交互式应用至关重要 [BFCL_v3_multi_turn_base_single_func_call, toolace_single_func_call]。

- 复杂交互 场景: 结合多重挑战,全面测试智能体在复杂场景下的整体稳健性和问题解决能力 [BFCL_v3_multi_turn_base_multi_func_call, BFCL_v3_multi_turn_composite]。

参数管理

- 缺失参数 场景: 考察模型如何处理信息不完整的情况,以及如何有效地与用户交互以收集必要的参数 [BFCL_v3_multi_turn_miss_param]。

Hugging Face 已将该数据集开源,以促进社区研究和应用发展 - Hugging Face Agent Leaderboard Dataset

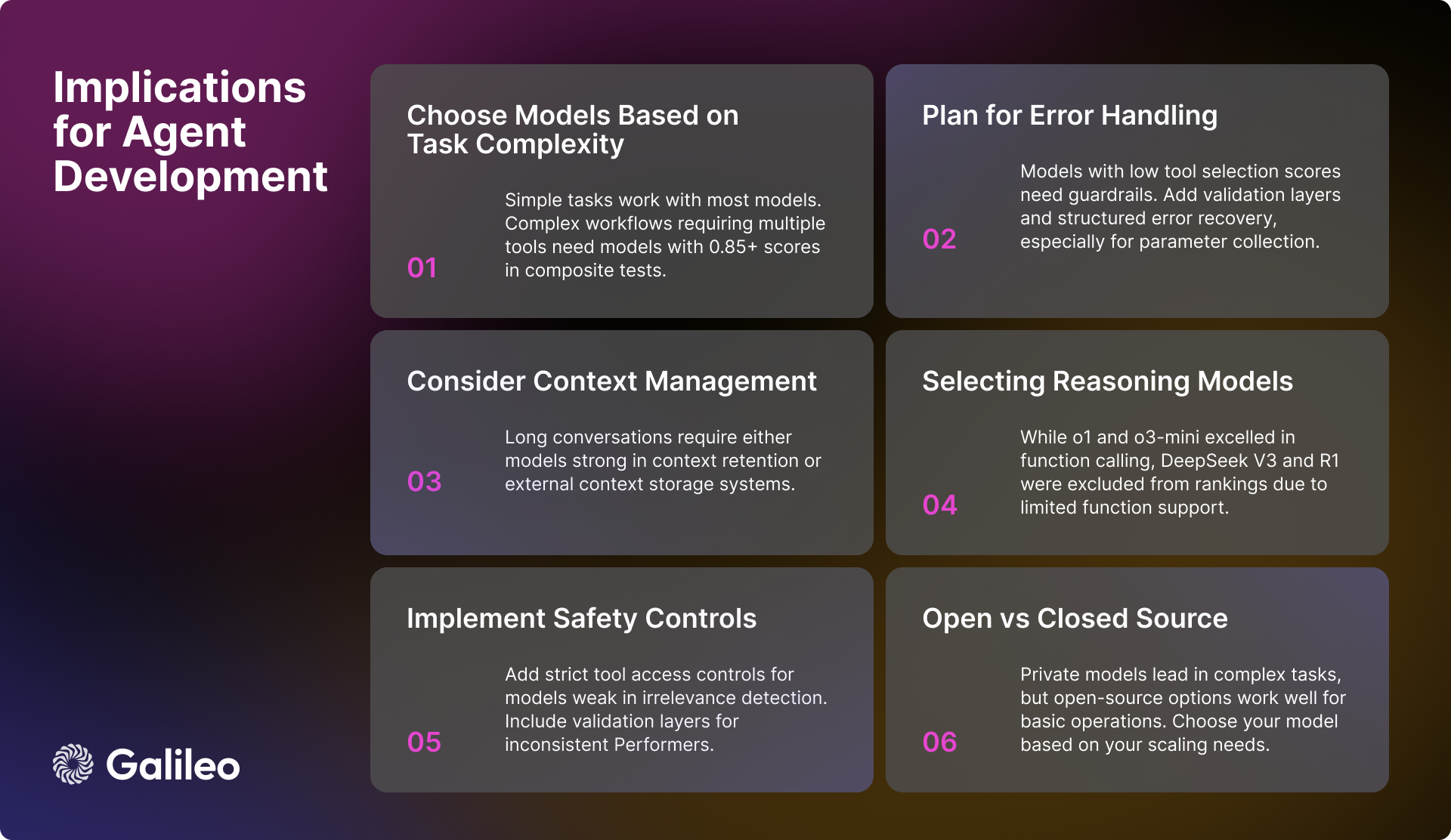

对 AI 工程师的实际意义

Hugging Face 的评估结果为 AI 工程师在开发 AI 智能体时,提供了诸多有价值的启示。 构建稳健且高效的智能体系统,需要综合考虑以下关键因素:

模型选择与性能

对于需要处理复杂工作流程的应用,选择在综合任务中得分高于 0.85 的高性能模型至关重要。 虽然大多数模型都能够胜任基本工具调用任务,但在处理并行操作时,更应关注模型在特定任务上的执行分数,而非仅仅依赖总体性能指标。

上下文和错误管理

对于在长上下文场景中表现欠佳的模型,实施有效的上下文总结策略至关重要。 当选用在不相关性检测或参数处理方面存在短板的模型时,则必须构建强大的错误处理机制。 对于在参数收集方面需要额外支持的模型,可以考虑采用结构化的工作流程,引导用户提供必要的参数信息。

安全性和可靠性

为了确保系统安全可靠,务必实施严格的工具访问控制,特别是对于那些在检测不相关操作方面表现不佳的模型。 对于性能稳定性不足的模型,可以考虑增加额外的验证层,以提升系统的整体可靠性。 此外,构建完善的错误恢复系统也至关重要,尤其对于那些难以处理缺失参数的模型。

优化系统性能

在设计系统工作流程架构时,应充分考虑不同模型在处理并行执行和长上下文场景时的能力差异。 在实施批处理策略时,务必评估模型的工具重用能力,因为这将直接影响系统的整体效率。

AI 模型发展现状

尽管目前专有模型在整体能力上仍占据领先地位,但开源模型的性能正在迅速提升。 在简单的工具交互任务中,各类模型的表现都日趋成熟。 然而,在复杂的多轮交互和长上下文场景中,各类模型依然面临诸多挑战。

模型在不同维度性能上的差异性,凸显了根据特定用例需求选择模型的重要性。 开发者不应仅仅关注模型的通用性能指标,而应深入评估模型在目标应用场景下的实际表现。

Hugging Face 希望这份 Agent 智能体排行榜能够为开发者提供有价值的参考。

模型性能概述

推理模型

在 Hugging Face 的分析中,一个值得关注的现象是推理模型的表现。 尽管 o1 和 o3-mini 在函数调用能力集成方面表现出色,分别取得了 0.876 和 0.847 的高分,但在其他推理模型方面,Hugging Face 遇到了一些挑战。 具体而言,DeepSeek V3 和 Deepseek R1 模型,虽然在通用能力方面表现令人 впечатляющий ,但由于其当前版本对函数调用的支持有限,因此被排除在 Hugging Face 的排行榜之外。

需要强调的是,将 DeepSeek V3 和 Deepseek R1 排除在排行榜之外,并非否定这些模型的卓越性能,而是在充分了解模型已公开的局限性后做出的审慎决定。 在 Deepseek V3 和 Deepseek R1 的官方讨论中,开发者明确指出,这些模型的当前版本尚不支持函数调用功能。 Hugging Face 选择等待未来发布具备原生函数调用支持的版本,而不是尝试设计变通方案或展示可能产生误导的性能指标。

这一案例 подчеркивает 函数调用是一项专业化的功能,并非所有高性能语言模型都默认具备。 即使是那些在推理能力方面表现卓越的模型,如果缺乏针对函数调用的专门设计和训练,也可能无法原生支持结构化函数调用。 因此,针对您的具体用例对模型进行全面评估,方能确保做出最优选择。

精英层性能 (>= 0.9)

Gemini-2.0-flash 以 0.938 的卓越平均分继续领跑排行榜。 该模型在所有评估类别中均展现出卓越的稳定性和一致性,尤其在综合场景 (0.95) 和不相关性检测 (0.98) 方面表现突出。 考虑到其每百万 token 0.15 美元/0.6 美元的定价,Gemini-2.0-flash 在性能与成本效益之间实现了令人信服的平衡。

紧随其后的是 GPT-4o,该模型取得了 0.900 的高分,并在多工具处理 (0.99) 和并行执行 (0.98) 等复杂任务中表现出色。 尽管 GPT-4o 的价格明显更高,为每百万 token 2.5 美元/10 美元,但其卓越的性能依然 оправдывает 其较高的成本。

高性能段 (0.85 至 0.9)

高性能段集中了多款实力强劲的模型。 Gemini-1.5-flash 保持了 0.895 的优异指标,在不相关性检测 (0.98) 和单函数性能 (0.99) 方面尤为突出。 Gemini-1.5-pro 虽然定价较高,为每百万 token 1.25 美元/5 美元,但仍取得了 0.885 的高分,在综合任务 (0.93) 和单工具执行 (0.99) 方面展现出显著优势。

o1 模型虽然价格较高,达到每百万 token 15 美元/60 美元,但仍以 0.876 的分数和行业领先的长上下文处理能力 (0.98) 证明了其市场地位。 新晋模型 o3-mini 表现出 0.847 的竞争力,在单函数调用 (0.975) 和不相关性检测 (0.97) 方面表现出色,并以每百万 token 1.1 美元/4.4 美元的定价,为用户提供了均衡之选。

中等层能力 (0.8 至 0.85)

GPT-4o-mini 保持了 0.832 的高效性能,在并行工具使用 (0.99) 和工具选择方面表现尤为出色。 然而,该模型在长上下文场景 (0.51) 中表现相对逊色。

在开源模型阵营中,mistral-small-2501 以 0.832 的分数领跑,相较于之前的版本,该模型在长上下文处理 (0.92) 和工具选择能力 (0.99) 方面均有显著提升。 Qwen-72b 以 0.817 的分数紧随其后,在不相关性检测 (0.99) 方面能够与私有模型相媲美,并展现出强大的长上下文处理能力 (0.92)。 Mistral-large 在工具选择方面表现出色 (0.97),但在综合任务方面仍面临挑战 (0.76)。

Claude-sonnet 取得了 0.801 的分数,在工具缺失检测 (0.92) 和单函数处理 (0.955) 方面表现突出。

基础层模型 (<0.8)

基础层模型主要包括在特定领域表现良好,但在总体得分方面相对较低的模型。 Claude-haiku 以 0.765 的分数提供了较为均衡的性能,并以每百万 token 0.8 美元/4 美元的定价,展现出极高的成本效益。

开源模型 Llama-70B 展现出 0.774 的潜力,尤其在多工具场景 (0.99) 中表现突出。 而 Mistral-small (0.750)、 Mistral-8b (0.689) 和 Mistral-nemo (0.661) 等较小规模的变体模型,则为用户在基础任务场景下提供了高效的选择。

这些数据集对于构建一个全面评估语言模型工具调用能力的框架至关重要。

评论: Hugging Face 推出的 Agent 智能体排行榜,精准地抓住了当前大语言模型应用的核心痛点——如何高效利用工具。 长期以来,行业关注的焦点多集中于模型自身的能力,然而,模型要真正落地并解决实际问题,工具调用能力才是关键所在。 此排行榜的出现,无疑为开发者提供了极具价值的参考,助力他们为特定应用场景选择最合适的模型。 从评估方法论到数据集构建,再到最终的性能分析,Hugging Face 的报告都展现出严谨细致的专业水准,也体现了其在推动 AI 应用落地方面所做出的积极努力。 尤其值得称赞的是,该排行榜并非仅仅关注模型的绝对性能,更深入地剖析了模型在不同场景下的表现,例如长上下文处理、多工具调用等,这些维度恰恰是实际应用中至关重要的考量因素。 此外,Hugging Face 还慷慨地开源了评估数据集,这将无疑将进一步促进社区在工具调用能力领域的研究和发展。 总而言之,这是一项非常及时且具有重要价值的工作。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...