综合介绍

HiveChat 是一个为中小型团队设计的 AI 聊天机器人,允许管理员一次性配置多种 AI 模型(如 Deepseek、OpenAI、Claude 和 Gemini),方便团队成员使用。它的特色功能包括 LaTeX 和 Markdown 渲染、DeepSeek 推理链显示、图像理解、AI 代理和云数据存储,支持 10 种大型模型提供商。项目采用 Next.js、Tailwindcss 和 PostgreSQL 等技术栈,可本地部署或通过 Vercel 和 Docker 部署。

功能列表

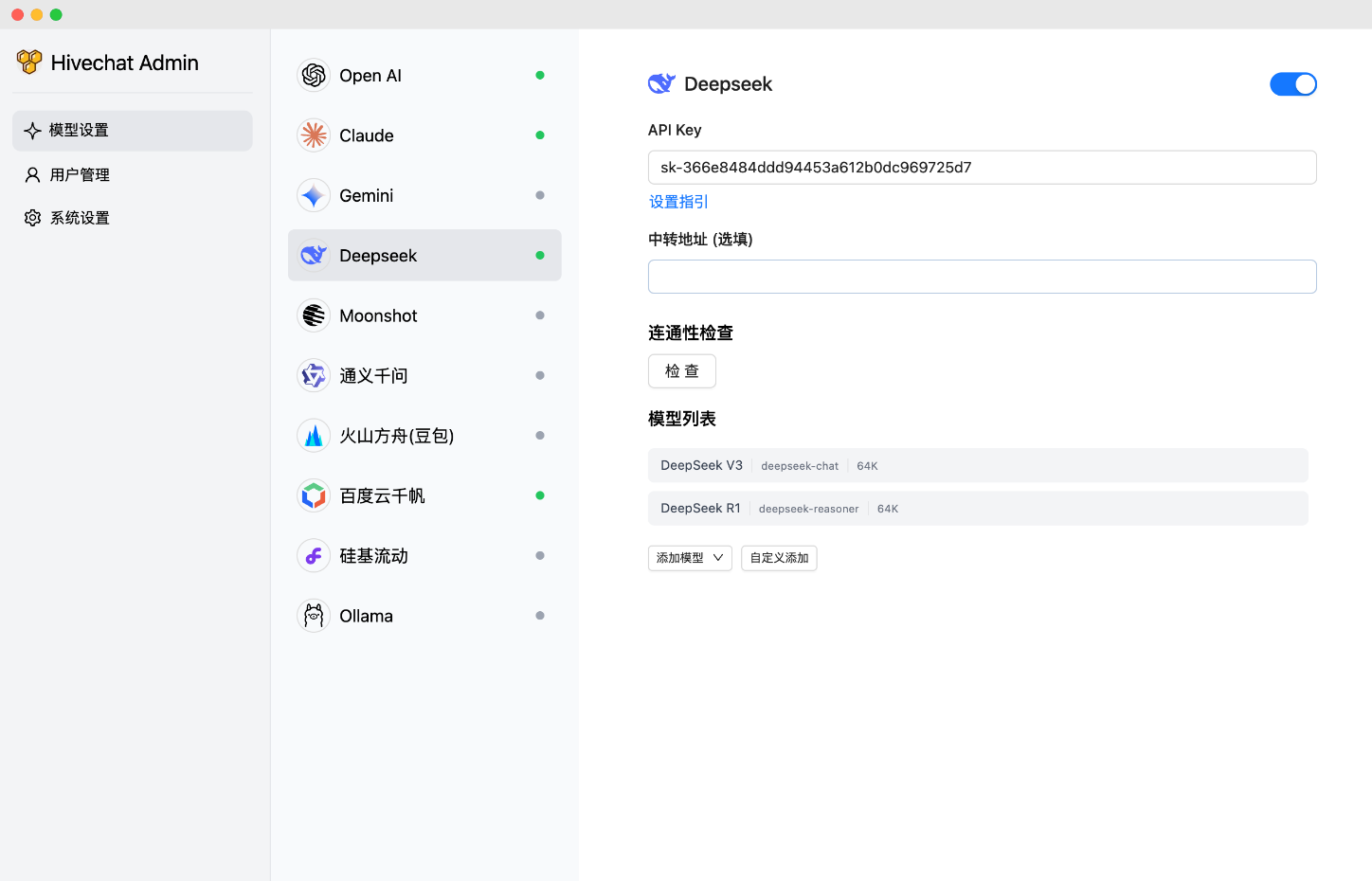

- 支持的 AI 模型:HiveChat 支持包括 Deepseek、OpenAI、Claude、Gemini、Moonshot、火山引擎 Ark、阿里百炼(Qianwen)、百度千帆、Ollama 和 SiliconFlow 在内的 10 种大型模型提供商,覆盖国内外主流选项,适合全球化团队。

- 渲染与显示:支持 LaTeX 和 Markdown 渲染,方便团队处理技术文档;DeepSeek 推理链显示功能帮助用户理解 AI 的推理过程。

- 多媒体支持:具备图像理解功能,适合处理视觉相关任务。

- AI 代理:集成 AI 代理功能,增强自动化能力。

- 数据管理:提供云数据存储,确保团队数据安全和持久化。

使用帮助

技术栈与部署选项

HiveChat 采用现代前端和后端技术栈,包括:

| 技术 | 描述 |

|---|---|

| Next.js | 用于构建服务器端渲染的 React 应用 |

| Tailwindcss | 提供快速的 CSS 框架 |

| Auth.js | 处理用户认证 |

| PostgreSQL | 关系型数据库,支持数据存储 |

| Drizzle ORM | 数据库操作 ORM 工具 |

| Ant Design | UI 组件库,增强用户体验 |

部署选项包括本地部署、Docker 部署和 Vercel 部署:

- 本地部署:用户需克隆 仓库,运行

npm install安装依赖,npm run initdb初始化数据库,npm run dev启动开发环境,npm run build和npm run start用于生产环境。 - Docker 部署:克隆 仓库,运行

docker compose build和docker compose up -d即可启动容器化服务。 - Vercel 部署:通过 Vercel 部署链接 一键部署,需配置 DATABASE_URL、AUTH_SECRET 和 ADMIN_CODE 等环境变量。

部署完成后,管理员需访问 http://localhost:3000/setup(或实际域名/端口)设置管理员账户。

详细使用帮助

为了帮助用户快速上手 HiveChat,以下是详细的安装和使用流程:

安装流程

- 克隆仓库:

- 打开终端,运行以下命令克隆 GitHub 仓库:

git clone https://github.com/HiveNexus/HiveChat.git cd HiveChat

- 打开终端,运行以下命令克隆 GitHub 仓库:

- 选择部署方式:

- 本地部署:

- 确保已安装 Node.js 和 PostgreSQL。

- 运行

npm install安装依赖。 - 配置

.env文件,设置以下环境变量:DATABASE_URL=postgres://postgres:password@localhost/hivechat(需替换为实际数据库连接,示例为本地 PostgreSQL)。AUTH_SECRET:使用openssl rand -base64 32生成一个 32 位随机字符串。ADMIN_CODE:设置管理员授权码,示例为22113344,建议替换为自定义值。NEXTAUTH_URL=http://127.0.0.1:3000(测试环境可保持默认,生产环境需改为正式域名)。

- 运行

npm run initdb初始化数据库。 - 开发环境运行

npm run dev,生产环境运行npm run build后npm run start。

- Docker 部署:

- 确保已安装 Docker 和 Docker Compose。

- 运行

docker compose build构建镜像。 - 运行

docker compose up -d启动容器。 - 配置环境变量同本地部署,需在

docker-compose.yml中指定。

- Vercel 部署:

- 访问 Vercel 部署链接。

- 按照提示配置 DATABASE_URL、AUTH_SECRET 和 ADMIN_CODE。

- 点击部署,等待 Vercel 完成构建。

- 本地部署:

- 管理员初始化:

- 部署完成后,访问 http://localhost:3000/setup(本地部署)或实际域名,输入 ADMIN_CODE 设置管理员账户。

使用方法

- 管理员操作:

- 登录后进入管理员仪表盘,可配置 AI 模型提供商(如 OpenAI API Key 等)。

- 可手动添加用户或启用注册功能,管理所有用户账户。

- 查看团队使用统计,调整模型配置以优化性能。

- 普通用户操作:

- 登录后即可进入聊天界面,支持文本输入和多媒体上传(如图像)。

- 使用 LaTeX 和 Markdown 格式化聊天内容,适合技术讨论。

- 选择不同 AI 模型(如 Deepseek 或 Claude)进行对话,查看 DeepSeek 推理链以理解 AI 决策过程。

- 数据自动存储于云端,确保会话历史可随时查看。

- 特色功能操作:

- 图像理解:上传图片,AI 可分析内容并生成描述,适合产品设计或数据分析团队。

- AI 代理:通过配置,AI 可自动执行特定任务,如生成报告或回复常见问题。

- 云数据存储:所有聊天记录和配置保存在云端,团队成员可跨设备访问。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...